智东西(公众号:zhidxcom)

编 | CJ

谷歌于2018年2月12日以Beta测试的形式开放了一直只是自用的TPU,服务的名称为Cloud TPUs(云端TPUs),是用于云端服务器的芯片,有需要使用的客户需要通过谷歌博客上的链接进行资料填写申请使用,使用费用为6.5美元每TPU每小时。

一、Google博客内容

这篇博客介绍了谷歌推出的Cloud TPUs服务,开放提供用于云端服务器的TPU芯片,客户可通过该服务使用谷歌的TPU,谷歌称使用单个TPU训练不到一天的时间就能让ResNet-50达到ImageNet基准测试的精度,而整个花费将不到200美元。

云端TPU机器学习加速器Beta测试版现已上市

作者:John Berrus(云TPUs产品经理 )和Zak Stone(TensorFlow和云TPUs产品经理)

从今天开始,Cloud TPU在Google云平台(GCP)上以beta版形式推出,以帮助机器学习(ML)专家更快地训练和运行ML模型。

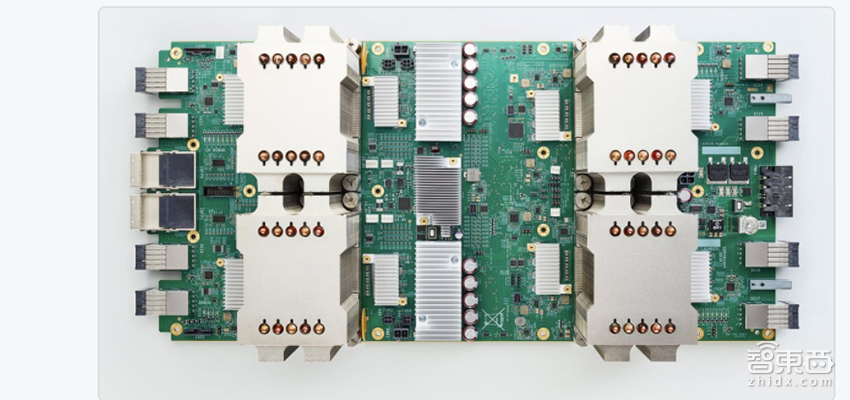

云端TPU是Google设计的一系列硬件加速器,经过优化,可加速和扩展使用TensorFlow编程的特定ML工作负载。每个云端TPU由四个定制ASIC构成,可将高达180 teraflops( 万亿次浮点计算/秒)的浮点性能和64 GB高带宽内存打包到单个主板上。

这些主板可以单独使用,也可以通过快速专用网络连接在一起,形成我们称之为“TPU pod”的多petaflop( 千万亿次浮点计算/秒)ML超级计算机。今年晚些时候,我们将在GCP上提供这些大型超级计算机。

我们设计了云端TPU,针对TensorFlow工作负载提供差异性能,并使ML工程师和研究人员能够更快地迭代。例如:

1、您可以通过您控制并可自定义的Google Compute Engine虚拟机,以互动方式独占访问连接网络的云端TPU,而无需在共享计算群集上等待任务排期。

2、与其等上几天或几周来训练关键业务型ML模型,您可以在一系列云端TPU上花一天训练同一型号的多个变体,并在第二天在生产中部署最精确的训练模型。

3、使用单个云端TPU并遵循本教程,您可以在不到一天的时间内训练ResNet-50以达到ImageNet基准测试挑战的预期精度,所有这些的花费都远低于200美元!

①ML模型训练,轻松搞定

一般来说,为定制ASIC和超级计算机编写程序需要深入专业的专业知识。相比之下,您可以使用高级TensorFlow API编程云端TPU,并且我们已经开源了一套参考高性能云端TPU模型实施,以帮助您立即开始使用:

1、ResNet-50和其他流行的图像分类模型

2、用于机器翻译和语言建模的变压器

3、用于物体检测的RetinaNet

为了节省您的时间和精力,我们不断测试这些模型实现的性能和收敛性,以达到标准数据集上的预期精度。

随着时间的推移,我们将开放源代码模型实现。 大胆的ML专家可以使用我们提供的文档和工具,自行优化其他TensorFlow云端TPU模型。

如果现在开始使用云端TPU,当我们在今年晚些时候推出TPU pods时,您将能够从很大的精确度的改进中受益。正如我们在NIPS 2017上宣布的那样,ResNet-50和Transformer训练时间从的将近一天时间下降到在完整的TPU pod上只需要不到30分钟,无需更改代码。

领先的投资管理公司Two Sigma对Cloud TPU的性能和易用性印象深刻。

“我们决定将我们的深度学习研究集中在云端的原因有很多,但主要是为了获得最新的机器学习基础设施,Google Cloud TPU是支持深度学习的创新且快速发展的技术的一个例子,我们发现将TensorFlow工作负荷移至TPU可大大降低编程新模型的复杂性以及训练它们所需的时间,从而提高了我们的生产力。使用云端TPU代替其他加速器集群,使我们能够专注于构建我们的模型,而不会被集群通信模式的复杂性的管理而分散注意力。”

– Two Sigma首席技术官Alfred Spector

②可扩展的ML平台

云端TPU还简化了计算和管理ML计算资源:

您可以为您的团队提供最先进的ML加速,并根据需求变化动态调整您的容量。

不需要在设计,安装和维护现场ML计算(具有专门的电源,冷却,网络和存储要求)投入大量资金,时间和专业知识,而是可以从大规模,紧密集成的ML基础架构多年来一直在Google上进行了大量优化。

不需要费力让驱动在大量工作站和服务器上保持最新状态。云端TPU已预先配置 – 无需安装驱动程序!

保护所有Google Cloud服务的复杂的安全机制和做法,也同样在保护您。

“自从使用Google Cloud TPU以来,我们对它们的速度印象深刻 – 通常需要几天时间的情况现在可能只需要几小时。深度学习正迅速成为运行自动驾驶汽车的软件的中坚力量。随着更多数据的出现,结果会变得更好,并且每周都有重大的突破。在这个世界上,云端TPU通过整合来自我们车队的最新导航相关数据以及来自研究界的最新算法进展,帮助我们迅速行动。”

– Lyft的自动驾驶5级软件主管Anantha Kancherla

在Google Cloud上,我们希望为客户提供适合每个ML工作负载的最佳云端,并将与云端TPU一起提供各种高性能CPU(包括Intel Skylake)和GPU(包括NVIDIA Tesla V100)。

③Cloud TPUs入门

云端TPUs的数量有限,现在的使用费用为6.50美元/TPU/小时。

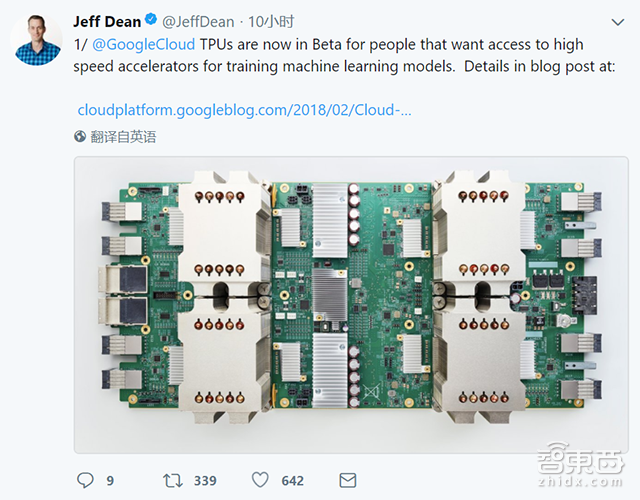

二、Jeff Dean连发十条推特

谷歌大牛Jeff Dean在就此事连发十条推特,不过这些推特内容几乎都是Google博客里的内容,但除此之外,Jeff还转推了一篇Technology的文章,他说这篇文章说的比较全面。文章名字叫:谷歌开放自用AI芯片。该文章称谷歌希望覆盖尽可能多的人,并已经在慢慢改变芯片市场的买卖双方的现状。

文章内容如下:

几年前,谷歌创造了一种新型计算机芯片来帮助其巨大的人工智能系统。这些芯片旨在处理复杂的过程,一些人认为这将是计算机行业未来的关键。

这家互联网巨头周一表示,它将允许其他公司通过其云计算服务购买这些芯片。谷歌希望围绕芯片建立一个新的业务,称为张量处理单元或TPU。

“我们试图尽可能快地覆盖尽可能多的人,”扎克·斯通(Zak Stone)表示,他与谷歌设计这些芯片的小型工程师团队合作。

谷歌的举动突出了现代技术建设和运营方式的几个重大变化。谷歌正在设计专门为人工智能设计芯片的运动,这是一场全球性的推动,包括几十家初创公司以及英特尔,高通和Nvidia等熟悉的公司。

而现在,谷歌,亚马逊和微软等公司不仅仅是大型互联网公司。他们是大型硬件制造商。

作为削减成本和提高数十亿美元数据中心效率的一种方式,谷歌设计了这些庞大设施中的大部分硬件,从计算机服务器到将这些机器连接在一起的网络设备。其他互联网巨头的情况也差不多。

除了TPU芯片,它们位于其数据中心内,该公司为其智能手机设计了一个AI芯片。

目前,Google的新服务专注于教计算机识别物体的方式,称为计算机视觉技术。但随着时间的推移,这款新芯片还将帮助企业建立更广泛的服务,Stone先生说。

在去年年底,希望加快无人驾驶汽车的研发,Lyft开始测试Google的新芯片。

利用这些芯片,Lyft希望加速开发允许无人驾驶汽车识别路牌或行人的系统。对这些系统进行“训练”可能需要数天时间,但是对于新芯片,训练有望缩短到几个小时。

“这里有巨大的潜力,”负责Lyft无人驾驶汽车项目软件的Anantha Kancherla说。

TPU芯片帮助加速了一切,从谷歌助手、安卓手机上的语音指令识别服务到谷歌翻译(在线翻译APP)。

他们也在降低Google对芯片制造商如Nvidia和Intel的依赖。在类似的举措中,它设计了自己的服务器和网络硬件,减少了对戴尔,惠普和思科等硬件制造商的依赖。

这可以降低成本,这在运行大型在线操作时至关重要,Casey Bisson(负责监督三星所拥有的名为Joyent的云计算服务 )表示。有时,构建高效服务的唯一方法是构建自己的硬件。

“在功率预算范围内,在热量预算范围内,在小范围内打包至多的计算能力。”比森先生说。

包括谷歌助理等服务在内的新一波人工智能由“神经网络”驱动,这是一种复杂的算法,可通过分析大量数据自行学习任务。例如,通过分析老客户电话的数据库,神经网络可以学习识别智能手机中使用过的命令。但是这需要非常大的计算能力。

通常情况下,工程师会使用图形处理单元或GPU来训练这些算法,这些芯片原本是专为渲染游戏和其他图形为主的软件的图像而设计的。大多数这些芯片都由Nvidia提供。

在设计自己的A.I.时。芯片方面,谷歌希望超越这些图形处理为主的芯片的可能性,加快自己的A.I.研究进展并吸引更多企业加入到其云服务中。

与此同时,谷歌已经从Nvidia获得了一定的独立性,并有能力与其芯片供应商谈判要求降价。

“谷歌已经变得如此之大,投资芯片是有道理的,”Fred Weber说,他曾担任芯片制造商AMD的首席技术官十年。 “这是他们的筹码。他们可以砍掉中间人。”

这并不意味着谷歌将停止从Nvidia和其他芯片制造商购买芯片。但它正在改变市场。韦伯说: 买卖双方的局势已经发生了变化。

多年以来,Google一直拿自己可能自主设计芯片而不是从英特尔购买这件事开玩笑。

韦伯先生和其他内部人士质疑Google是否会这样做,仅仅是因为C.P.U.是如此复杂,而且设计和维护其中一个芯片将会变得更加困难。但去年秋天在旧金山的一次私人活动中,加州大学伯克利分校的计算机科学教授戴维·帕特森,现在在谷歌从事芯片技术方面的工作,被问到谷歌是否会这么做时,他表示:“这又不是什么特别难的事”。

原文来自:Google Blog