芯东西(公众号:aichip001)

编 | 韦世玮

21世纪的第三个十年已经开启,回望过去急剧在世界穿行的科技洪流,大数据爆发、人工智能(AI)苏醒、5G落地、自动驾驶启程……这些技术不断地刷新着人们对未来的认知,并重新定义科技。

其中有一股浪潮,它虽然在上世纪80年代就已被科学家所提出,但随着近年来技术的演进和成熟,它又获得了巨大的发展前景,使得众多科技界巨头纷纷入局,势要早日瓜分这块“大蛋糕”。

掀开面纱,这股浪潮就是量子计算。

这厢谷歌和IBM还为它“大打出手”,引起一场与“量子霸权”有关的争论;那厢英特尔就宣布研发了首款低温控制芯片,能够可在冰箱中运作并实现多个量子位控制。

实际上,量子计算的魅力远不止于此。

除了科技巨头外,亦有许多创企针对量子计算技术开展大量的研发和实验,或是利用量子算法的特性来开发AI技术。

我国的AI创企品奇实验室(PQ Labs)就是其中的一员。

该公司研发了一项名为“QuantaFlow”的AI推理加速技术,基于量子流算法在神经网络加速计算中所表现出的性能,设计人员在设计AI架构方案时,模拟了量子算法的运行逻辑。

因此,QuantaFlow既不是量子计算机,也不是纯量子算法。他们将其称之为“类量子算法”。

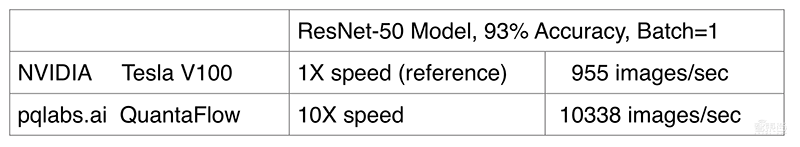

品奇实验室的实测数据表明,在同样运行环境下(ResNet-50, Batch=1, 93% Accuracy),QuantaFlow技术的推理性能达到NVIDIA Tesla V100的10倍。(点击观看品奇实验室QuantaFlow的AI加速技术演示https://v.qq.com/x/page/h3047n9o3pp.html)

在量子计算的神秘力量之下,品奇实验室的QuantaFlow技术又有着怎样的创新与发展?它的诞生,又将为当下的AI领域带来哪些新的思考和意义?

一、潜伏于摩尔定律和AI之下的量子计算

当我们站在AI时代的边缘,回望五十年前计算机技术萌芽之初,科技爱好者能买到最好的设备,是拥有2100个晶体管的Busicom LE-120A“Handy”计算器。

而现在,与“Handy”计算器类似大小的设备,如iPhone 11 Pro Max,则拥有超过85亿个晶体管,是五十年前老前辈的400多万倍。

五十年来,计算机行业沿着摩尔定律“规划”好的路线一直狂奔。直至AI时代,一面是愈发汹涌澎湃的算力需求,另一面则是传统计算架构逐渐停止演进的现状。

人类成功地在越来越小的空间内实现愈发强大的算力,并在经典计算架构逐渐逼近物理极限时,迎来了AI时代。

在AI技术普及之前,行业内甚至出现了“算力过剩”的说法。有意思的是,这“过剩”的算力只不过刚触及到AI技术对算力需求的边缘,却引发了AI基于神经网络技术的爆炸式发展。

正如NVIDIA CEO 黄仁勋曾在去年CES(国际消费电子展)中所提到的“摩尔定律已死”。面对AI对算力的需求,有人认为经典架构还需要榨取最后一点性能,也有人认为要推倒现有的架构,采用量子计算机。而品奇实验室认为两者都不完全正确。

二、何为量子技术和量子计算机?

量子力学的态叠加原理,使得量子信息单元的状态可处于多种可能性的叠加状态,让量子计算天生适合处理大规模的复杂计算。

对经典计算架构来说,其利用了电子会从高电压流向低电压的基本物理特性。与之相似,量子计算的设计也是利用了处于量子态的微粒子的基本物理特性。

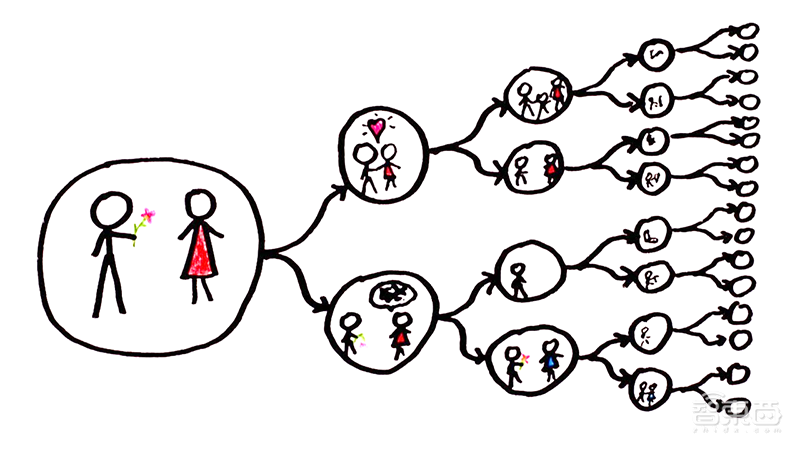

同样的,量子计算也分为输入、计算、输出三个过程。区别在于,经典计算需要严格的设计计算过程,而量子计算的计算过程则是“自然演化”,即设计好输入信息,让量子比特在多个平行宇宙中并行演化,并对演化结果进行观测,进而得到输出数据。

值得一提的是,量子计算的计算过程涉及到两个概念:

1、量子叠加态。一个量子比特(qu-bit)可同时处于多个可能结果的概率叠加状态,即一个量子比特可以同时代表多个数值,进而只需很少的量子比特就可处理非常多的概率叠加结果。而对传统计算来说,它需要穷举运算每一个可能性;

2、并行演化。量子比特的每一个叠加状态,都是在不同的平行宇宙中并行演化,且互不干涉、同时计算。哪怕是对经典计算架构非常复杂的运算,量子计算只需非常少的计算即可实现。

正是由于这些特性,量子计算在处理超大规模的复杂计算问题时,能够拥有传统计算架构无法比拟的性能优势。

然而,要真正实现有用的量子计算机,还存在巨大的技术鸿沟。

例如,谷歌、IBM的“量子门电路”方案,虽然能实现“量子霸权”,但只能跑特定的量子算法,没有QRAM(量子内存/量子随机存储器),量子比特非常不稳定,容易坍塌。

因此,如果要将出错率降到可实用的程度,每个量子比特背后需消耗1000个量子比特来进行算法纠错。但由于物理技术发展的限制,目前人类还没有制造出被广泛认可的通用量子计算机。

值得注意的是,有一种基于量子图灵机设计原理、量子物理的数学特性而设计出的量子算法,已经能够在量子计算的模拟环境中运行起来。

与谷歌、IBM的“量子门电路”设计不同,加拿大量子计算公司D-Wave公司曾提出一个类似量子算法模拟器的方案。

2019年,D-Wave发布了“非主流”的5000个量子比特处理器,远远高于谷歌53个量子比特的量子霸权计算机。

一个来自谷歌的研究小组曾在D-Wave电脑上进行实验,其论文结果显示,在一些专用领域D-Wave的量子算法比传统算法快了1亿倍。

但问题是,D-Wave设备是否能被称为“真正的量子计算机”?

实际上,学术界对此依然存在争议。很多持否定态度的科学家认为,D-Wave并没有利用到“纯物理意义”上的量子,而是用了仿真和量子算法。

但这并不妨碍D-Wave成为第一个能用来解决实际问题的“量子计算机”。

D-Wave在药物分子分类、数独游戏求解、优化酒店广告、图片着色、复杂网络问题、模拟天气模式和海啸等方向都有着广泛的应用场景。

不足的是,D-Wave的产品体积庞大,性价比不高,解决的问题类别依旧有限,在目前阶段妨碍了大规模应用。

三、QuantaFlow:量子流架构与AI的结合

品奇实验室尝试将量子算法的思想精髓引入AI芯片架构中,进而在现有的硅基计算平台上大幅提升并行计算算力。

但如何在现有的硅基计算平台上实现,则是个难题。

品奇实验室通过将类量子算法引入神经网络加速,从而开发了一种名为“QuantaFlow”的AI加速技术,进一步提升了AI推理速度。

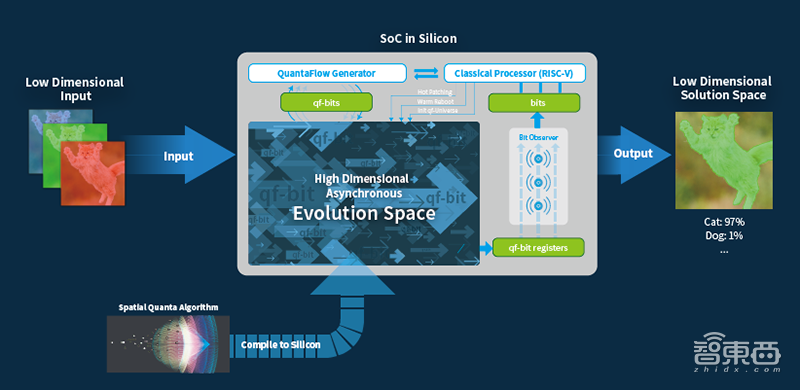

QuantaFlow能够在硅基芯片中模拟出一个量子比特流进行模拟演化的虚拟空间。在此基础上,研发人员设计了基于经典架构的RISC-V处理器,以实现对量子模拟空间的逻辑控制、结果观测等功能。

此外,QuantaFlow可将低维空间中的输入信息映射到高维的量子演化算法空间中,进行大量异步、并行的演化计算,并将结果保存在量子流比特寄存器(qf-bit registers)中,通过比特观察器(Bit Observer)对处于多个时间和空间中的量子流比特,进行多重采样观测。

同时,它还通过热补丁(hot-patching)来动态改变演化空间内量子流的演化路径。当需要对演化空间做更大规模的演化(deformation)变动时,RISC-V则将控制演化空间进行热重启,这一切都可在瞬间内完成。

这使得QuantaFlow架构能够以最快速度演算各种神经网络模型,例如ResNet-50或谷歌最新的EfficientNet等。

保持算法可扩展性是通用人工智能算力的基石。目前大部分AI的ASIC加速器只能优化某一类网络模型,若换成别的网络类别就会力不从心,性能大幅下降。

QuantaFlow将计算中间结果反馈至量子流生成器(QuantaFlow Generator),并进行循环往复,以定制不同的演进计算。直到网络结束获得结果后,再输出到低维解空间,就可用于分类、物体识别、语义分割等AI任务。

量子并行计算加速的一个主要特点,就是计算/演化空间非常大,“解”空间相对非常小,而这也是AI领域需要面对的问题。

实际上,与基于经典图灵机编写的算法相比,QuantaFlow拥有不少优势。

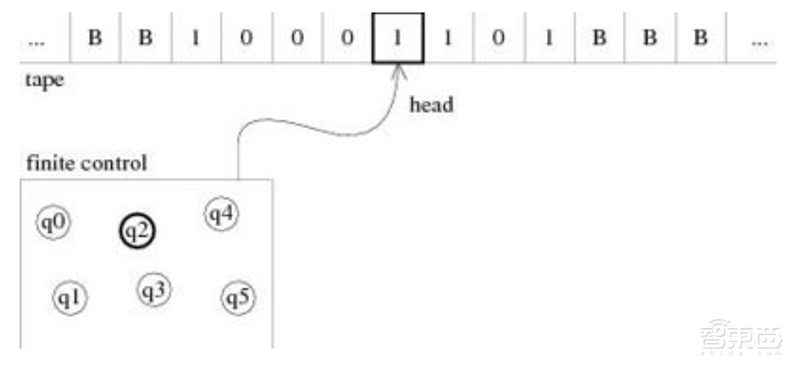

简单来说,经典图灵机能够进行三种基本操作。一是Observe(读取观察头对应位置的内容);二是Modify (改写观察头对应位置的内容);三是Control(将纸带向左,或向右移动)。

经典计算机和经典算法的实现都离不开这个基本模型。

例如,在每个机器的时钟周期,寄存器都要能被CPU所观察(Observe)或修改(Modify),而电子在硅基芯片中A点到B点的移动速度是有限的,计算频率和次数也将受限。

基于这一架构的硅基实现,电子会更早地被纯物理极限所制约。但这并不能靠堆叠CPU核心来解决问题,因为各个核心之间需要通讯、共享资源,以及维持缓存一致性(cache coherence),本质上也受电子移动速度的物理极限影响。

值得一提的是,虽然ResNet(2015)还在大规模使用,但已是比较早期的网络模型。与MobileNet(2017)、EfficientNet(2019)等较新的网络模型相比,QuantaFlow或将实现更好的加速比,而这些数据的神秘面纱也将在不久后为我们揭晓。

结语:量子计算为解决AI算力困境提供新思路

在摩尔定律逐渐放缓的趋势下,随着大数据、AI、自动驾驶等技术的发展,量子计算技术无疑是解决当下AI行业算力困境的一条重要途径。

而品奇实验室通过新颖的类量子算法架构设计,所研发出的QunataFlow AI加速技术,是其迈出在AI加速探索领域的重要一步。与此同时,品奇实验室也会在美国拉斯维加斯正举行的CES 2020上,为大家首次演示这项技术。

实际上,品奇实验室在其他技术层面也有许多创新。例如,对芯片的设计编写、设计空间搜索、仿真、综合和布局等,这些都采用了高级语言加算法来完成。

从另一角度看,当GPU架构因为“访存墙”瓶颈而导致的性能下降,正逐渐无法适应新型神经网络模型的演进。QuantaFlow的出现,或许能为新型网络的发展提供一个新的思考方向和创新路径。

虽然,量子技术的落地商用离我们依然遥远。但在不远的将来,我们也许能看到它以不同的“模样”出现在人们生活的方方面面,而AI也很可能是承载量子技术特性的技术形态。

AI已经走进激烈的落地战阶段,而未来,AI技术又能与量子计算技术擦出怎样的火花?让我们拭目以待。