智东西(公众号:zhidxcom)

编 | 赵佳蕊

导语:美国麻省理工学院计算机科学和人工智能实验室研究人员设计了一个可以把触觉信号转化为视觉信号的的人工智能系统,也可以根据视觉片段预测触觉。

智东西6月17日消息,近日麻省理工学院(MIT)计算机科学和人工智能实验室(CSAIL)的研究人员研发出了一个新的人工智能系统,这个人工智能系统能够通过触觉信息生成视觉信息,也可以根据视觉片段预测触觉。

相关论文将在下周的计算机视觉和模式识别会议上将发表一篇新的论文,这篇论文由CSAIL博士生Yun Zhu Li、MIT教授Russ Tedrake、Antonio Torralba和MIT博士后Jun Yan Zhu共同创作。

一、这个AI可以将视觉信息和触觉信息相互进行转换

该小组的系统使用了GANs(生成对抗网络)把触觉数据拼凑出视觉图像。其中GANs的神经系统被应用在两个部分,包括产生样本的发生器和能够区分产生样本和真实样本的鉴别器的两部分神经网络。

样本的获取来源于一个名为visgel的数据集,visgel拥有超过300万个视觉/触觉数据对,其中包括12000个视频剪辑,剪辑中包含了近200个物体(如工具、织物和家用产品)。

这一人工智能系统首先将识别机器人所接触物体区域的形状和材质,并在参考的数据集中进行比对,最终生成所接触部位的图像信息。

例如:如果给出鞋子上完整的触觉数据,这个模型就可以确定鞋子上最有可能被触摸的位置。

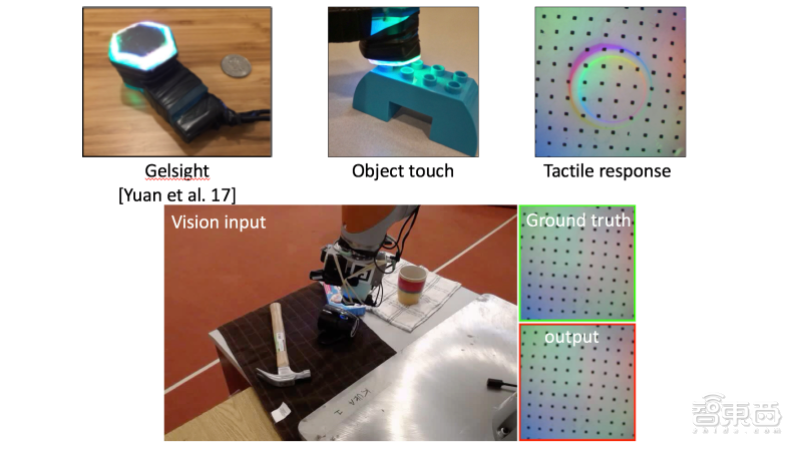

▲运行流程

数据集中参考照片有助于对环境的详细信息进行编码,从而使机器学习模型能够自我改进。在这个研究中,他们在库卡机器人手臂上安装了一个触觉式凝胶视觉传感器,这个传感器由麻省理工学院的另一个小组设计,可以将当前的图像与参考图像进行比较,以确定触摸的位置和比例。

二、这个系统可以帮助机器人进行自我学习

“通过观察这个场景,我们的模型可以想象到触摸到一个平坦的表面或锋利的边缘的感觉。”CSAIL博士生 Yun Zhu Li说。

“在黑暗中进行接触的时候,仅从触觉上,我们的人工智能模型就可以预测与环境的交互作用,把视觉和触觉这两种感觉结合在一起就可以强化机器人的能力,减少我们在处理和抓取物体的任务中可能需要的数据。”

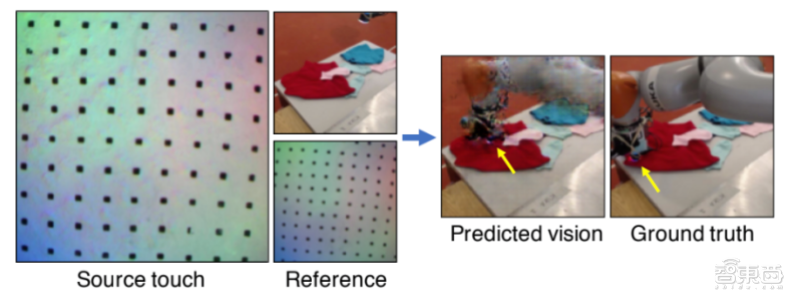

▲模型从触觉生成视觉的过程

研究人员注意到,当前的数据集只有在受控环境中交互的例子,但是其中一些细节,比如物体的颜色和柔软度,仍然难以被系统推断出来。

不过,他们说,他们的方法可以在生产环境中为集成人类机器人无缝衔接地打下基础,尤其是在缺少视觉数据的任务上。比如:当灯熄灭或工人必须盲目地接触容器时。

对于这一项研究,加州大学伯克利分校的博士后研究员安德鲁·欧文斯说:“在视觉和触摸信号之间进行转换方面,这是第一种非常令人信服的方法。像这样的方法对机器人学习很有用。”

他还表示:有些问题对于机器人来说是很难的,比如:你可以问这个机器人“如果我选择通过握住杯子把手提起这个杯子,我的握法会有多好?这是一个非常具有挑战性的问题,因为信号非常不同,这个模型已经能够证明它是非常有效的。”

文章来源:VentureBeat