智东西(公众号:zhidxcom)

文 | Lina

智东西4月25日消息,今天,为期三天的ICLR国际学习表征会议(International Conference on Learning Representations)在法国土伦举行。

可别小看ICLR这个名字拗口的大会,它可是由深度学习三巨头之二——Yann LeCun和Yoshua Bengio共同组织举办的,ICLR虽然只举办了5年,但随着深度学习的日渐火热,这一声名鹊起的学术大会已然成为深度学习领域最重要的会议之一。

这三天里,来自世界各地的机器学习专家大牛集聚一堂,探讨有关表征学习、深度学习等最技术中最为前沿的发展。其研究主旨大概可以总结为一句:如何让算法的应用更广、消耗更少、开源节流。这些技术应用的领域范围也非常广泛,视觉、语音、文字理解、游戏、音乐等等,不一而足。(大会的21个演讲见文内表格)

本文将介绍ICLR的3篇最佳论文、6位学术大牛,21个主题演讲、以及业内人士对于这个会议态度不一的看法,还有赞助商小八卦哟~

一、ICLR的前世今生

(左Yoshua Bengio,右Yann LeCun)

从1999年以来,Yann LeCun和Yoshua Bengio这两位大牛就一同组织过不少学术研讨会,第一届ICLR在2013年美国亚利桑州斯科茨代尔市举办,共有28篇论文入选,今年这一数字飙升到了648篇(490篇Conforence Track公开论文,以及158篇Workshop Track研讨会论文)

主办人之一Yann LeCun是现任Facebook人工智能研究院的院长,兼任美国纽约大学教授,同时还是深度学习重要分支——卷积神经网络(CNN, Convolutional Neural Nets)的发明人之一;此前曾来北京清华大学做过一次《深度学习与AI未来》的主题演讲,智东西也去到了现场(一票难求的清华深度学习课!我们“偷”来了全套干货)。

至于Yoshua Bengio则是加拿大蒙特利尔大学的全职教授,同时也是蒙特利尔学习算法研究所(MILA)的负责人;Google去年年底宣布在蒙特利尔设立一个深度学习和人工智能研究部门,并为包括Yoshua Bengio在内的蒙特利尔学习算法学院8为学究提供了337万美元的研究资金。

二、3篇最佳论文

(人声鼎沸的大会现场)

虽然大会才刚刚拉开帷幕,但是其中三篇最佳论文已经在开幕前由ICLR组委会评选而出。大会举行的三天当中,每天都有一篇最佳论文的演讲。这三篇论文的主题分别为:简化神经编程算法架构、保护训练数据隐私、以及一篇最具争议性的——主题为实际谈论模型复杂性的论文。

这三篇最佳论文分别为:

1、《了解深度学习需要重新思考泛化 (Understanding deep learning requires rethinking generalization)》

本文来自美国麻省理工大学、谷歌、以及加州伯克利大学,第一署名作者为麻省理工大学的Chiyuan Zhang。

概要:基于同样大数据样本的不同算法也能获得相似结论,一个具有足够规模参数的简单浅层网络能够产生完美的有限样本表达性。文章引入非结构化的噪音数据进行测试,证实了图像识别算法模型的可靠性。

2、《基于隐私数据训练的半监督式知识转化深度学习算法 (Semi-supervised Knowledge Transfer for Deep Learning from Private Training Data)》

本文来自宾夕法尼亚州立大学、谷歌、以及OpenAI,第一署名作者为宾夕法尼亚州立大学的Nicolas Papernot。

概要:由于一些机器学习应用(如临床医疗病例)的的训练涉及到敏感数据,而模型可能会无意中泄露用户隐私,文章引入噪音数据和黑盒算法,实现对隐私数据的保护。

3、《通过递归法使神经编程架构更为广泛化 (Making Neural Programming Architectures Generalize via Recursion)》

本文来自加州大学伯克利分校,联合署名作者为:Jonathon Cai, Richard Shin, Dawn Song。

概要:由于通过数据学习的神经网络比较杂乱,本文提出了一种应用于神经网络解译程式的递归算法,包括四项任务:基础运算、冒泡算法、拓扑类、快速排序,将任务细分化,增强数据训练的准确性。

值得一提的是第一篇《了解深度学习需要重新思考泛化》论文,文章一经评选,立刻引发一阵激烈讨论。有人认为这篇论文做了一项十分具有颠覆性的工作,将会启发未来数年里有关深度学习的研究;也有人认为这篇论文被高估了,其中指出泛化对随机标签是个糟糕的问题这个观点“没有什么意思”;不过,大多人也有不少人与智东西持一样的态度,有争议、能够引发大家讨论的文章,才是有意思的文章,毕竟深度学习还是一门发展中的科学,好与坏本身都太主观。

除了三篇最佳论文外,ICLR还别出心裁地设立了最佳评论奖,选出了15位对论文内容的评论及后续讨论最有价值的留言者,每位给予100美元的鼓励。

三、6位主讲大牛与21个演讲

如上文提到的,从大会的整体趋势而言,研究主旨大概可以总结为一句:如何让算法的应用更广、消耗更少、开源节流。而细分到具体论文主题则包括:寻找广义算法、解决大数据处理/图像信息处理的问题、引入数学/统计学优化算法提高效率和容错性/鲁棒性、多任务合作等。

大会邀请了15位论文发布者进行演讲展示,其中就包括了三篇最佳论文。此外还有6位相关领域的大牛进行特邀嘉宾演讲,六位演讲嘉宾包括:

1)Eero Simoncelli,美国纽约大学白银教授(Yann LeCun在纽约大学也是这个称号,Silver Professor),IEEE 国际电子技术与信息科学工程师协会会员。

2)Benjamin Recht,美国加州伯克利大学电子工程和计算机科学学院。

3)Chloé-Agathe Azencott,法国巴黎高等矿业学院计算生物学系,法国巴黎居里研究所及法国国家科研中心研究员。

4)Riccardo Zecchina,意大利博科尼大学理论物理学系,都灵人类基因基金会项目负责人。

5)Regina Barzilay,美国麻省理工大学电气工程及计算机科学系,微软研究员,麻省理工大学自然语言处理研究小组成员。

6)Alex Graves,加拿大多伦多大学计算机科学系。值得一提的是,多伦多大学计算机科学系负责人Geoffrey Hinton正是第三位深度学习巨头,除了教授身份外,Geoffrey Hinton还任谷歌大脑的多伦多分布负责人,同时也是多伦多向量学院的首席科学顾问。曾在2012年的ImageNet比赛中凭借深度学习一举创下计算机图片分辨正确率新高。

(左Geoffrey Hinton,右Yann LeCun)

大会所有演讲的流程如下:

四、赞助商变迁史

好了,学术讲得差不多了,我们说点有趣的——ICLR赞助商的变迁历史,仔细探究会发现非常有趣。细心的人在看到上文演讲流程时会发现,有三部分会议环节中标注着“百度赞助”、“谷歌赞助”和“亚马逊赞助”。ICLR的赞助商分为白金、金、银、铜四个级别,毫不意外地,这三家企业都是白金级别的赞助商,也都是在近期十分看重人工智能、深度学习的企业。尤其是谷歌,从2013年的第一届ICLR开始就开始对其进行赞助。

除了百度、谷歌、亚马逊之外,今年的白金赞助商还有DeepMind、Facebook、英特尔、英伟达、Salesforce。去年的白金赞助商只有4个,今年多达8个,猛增了一倍之多,可见各家企业对深度学习及这场大会的重视程度。值得一提的,国内创企深鉴科技也在赞助商的名单上,其联合创始人韩松有两篇论文入选。

(2017年ICLR赞助商名单)

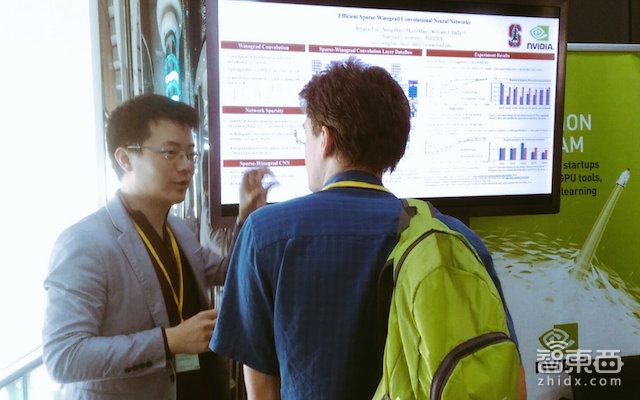

(英伟达在ICLR会上的展台)

五、行业声音

智东西也去问到了AI及深度学习的从业者们,看看他们是怎么看待这场热闹的大会的。

在回答智东西提出的“我们大概什么时候能看到ICLR的新技术的应用落地?”时,身处土伦现场的英伟达大中华区高性能计算及Applied Deep Learning部门技术总监赖俊杰博士表示,这个会议相对来说不是特别重视应用。而他本次来的关注点并非最佳论文,而是更侧重训练加速(Training Acceleration)、量化(Quantification)、剪枝法(Pruning)等领域,尤其是在剪枝法方面,马里兰大学和英伟达研究院都有一些相关技术的新进展。

网友李嫣然则从更学术的角度解读了本次ICLR,她认为纵观本次ICLR 2017论文可以看出,GAN(生成式对抗网络)确实火得不能再火。在这次 ICLR 2017全部GAN 的论文里,主要集中在三个方向:如何提高GAN稳定性,用新角度/框架去理解和建模GAN,以及GAN 与 (semi)-supervised 的结合。而除了GAN外,其实Attention和 Memory这俩已经火了两年的方向也还在发展。

极视角联合创始人罗韵更是直言道,“GAN简直称霸半边天,Generative这个词的出现频率简直。。厉害了word的哥。。。”

不过,行业内也有不同声音存在。曾在百度硅谷研究院工作、现为SLAM创企业Perceptln联合创始人刘少山认为,(关于ICLR热度不断上升这方面)其实是挺好玩儿的一个现象。学术捧得比较高的一个东西,在到底在工程上能不能做,其实未必。在深度学习和SLAM各个方面我们看过很多论文很好,但未必能实现(的项目),很少像AlphaGo这样,实现出来能有用,能应用到具体场景里面。

结语、结结实实火了起来的深度学习

随着2012年神经网络在ImageNet获得重大突破以来,以深度学习为主的人工智能浪潮已经渐渐涌来,在最近一年里更是势头强劲,迅速占领了街头巷尾。无论你赞成还是反对,看好还是唱衰,深度学习都已经来到了你身边,从早年无人知晓的ICLR大会如今人满为患、赞助厂商翻倍、论文如纸片般飞来的现状可见一斑。

深度学习,这个看似玄幻的科技词汇,已经着着实实火了起来。

但也正是由于这股热潮来临,深度学习、机器学习、人工智能这三个概念被一度混淆,深度学习算法作为机器学习算法的一种,隶属于人工智能这个大范畴内。近年来,深度学习在语音、图像的检索分类方面取得突破性进展的同时,它在训练数据过大、训练时间过长、计算功耗太大、难以大范围推广应用等问题上依旧存在局限,并不是解决人工智能的万能之策。

每日一头条

趋势·深度·犀利·干货,最专业的行业解读

深喉爆料、投稿:guoren@zhidx.com