当前,人工智能正处在爆发期。我国在人工智能领域的科学技术研究和产业发展起步稍晚,但在最近十余年的时间里抓住了机遇,进入了快速发展阶段。在这个过程中, 技术突破和创造性高端人才对人工智能的发展起着至关重要的作用。 本周,清华大学AI研究机构AMiner发布了《2019中国人工智能发展报告》,报告遴选 13 个人工智能的重点领域进行重点介绍,包括:机器学习、知识工程、计算机视觉、自然语言处理、语音识别、计算机图形学、多媒体技术、人机交互、机器人、数据库技术、可视化、数据挖掘、信息检索与推荐等。

本期的智能内参,我们推荐清华大学的研究报告《2019中国人工智能发展报告》,对人工智能 13 个领域的人才情况及技术发展等内容进行了挖掘分析。如果想收藏本文的报告(2019中国人工智能发展报告),可以在智东西(公众号:zhidxcom)回复关键词“nc419”获取。

本期内参来源:清华大学AMiner

原标题:

《2019中国人工智能发展报告》

作者: 李涓子 唐 杰

一、机器学习

机器学习已经成为了当今的热门话题,但是从机器学习这个概念诞生到机器学习技术的普遍应用经过了漫长的过程。在机器学习发展的历史长河中,众多优秀的学者为推动机器学习的发展做出了巨大的贡献。

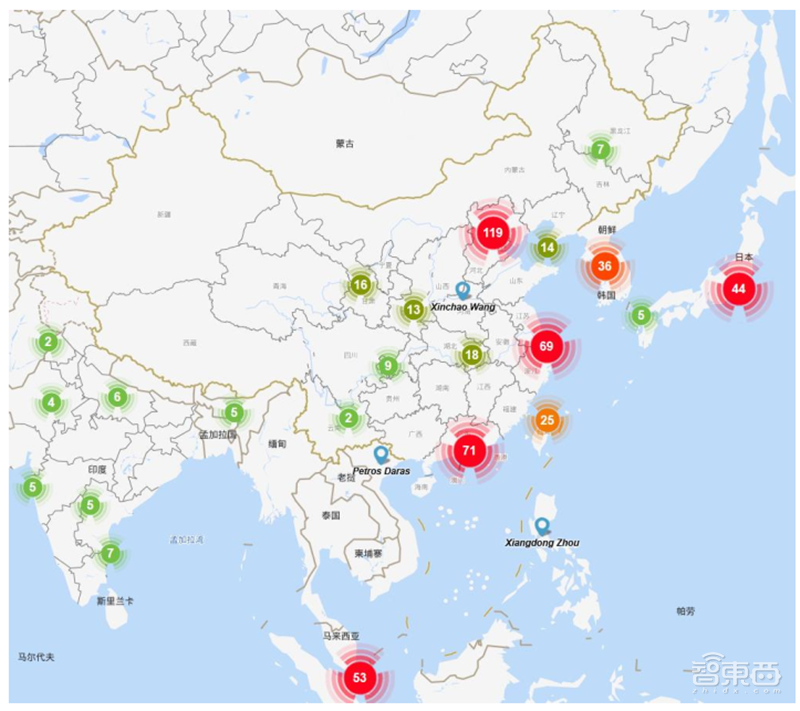

学者地图用于描述特定领域学者的分布情况, 对于进行学者调查、分析各地区竞争力现况尤为重要,下图为机器学习领域全球学者分布情况:

▲机器学习领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量遥遥领先且主要分布在其东西海岸;欧洲中西部也有较多的人才分布;亚洲的人才主要分布于我国东部及日韩地区;其他诸如非洲、南美洲等地区的学者非常稀少;机器学习领域的人才分布与各地区的科技、经济实力情况大体一致。 此外, 在性别比例方面,机器学习领域中男性学者占比 89.8%,女性学者占比 10.2%,男性学者占比远高于女性学者。

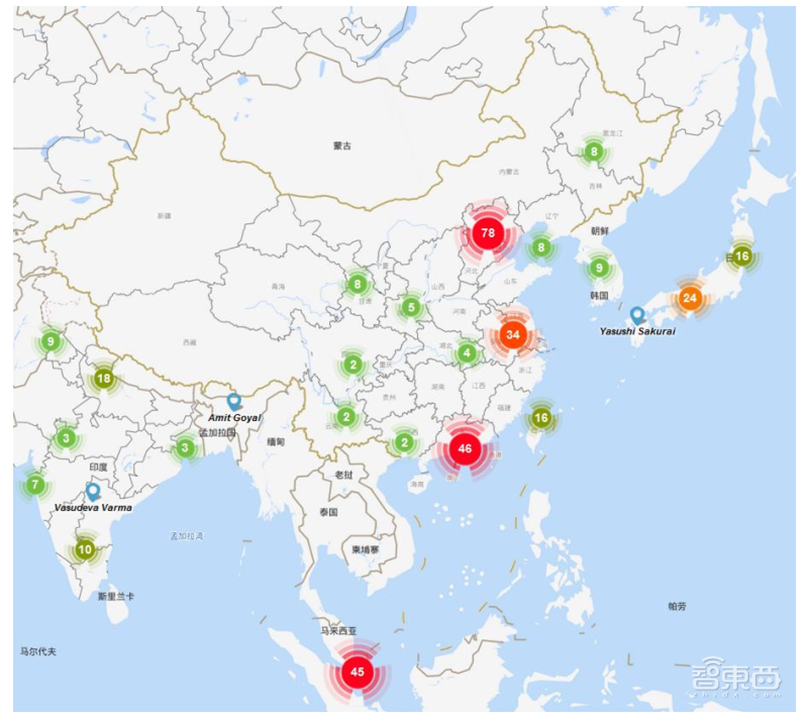

我国专家学者在机器学习领域的分布如上图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏,这种分布与区位因素和经济水平情况不无关系。同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等亚洲国家相比,中国在机器学习领域学者数量较多。

▲ 机器学习领域中国学者分布

对本领域的高水平学术会议论文进行挖掘,解读这些会议在近年的部分代表性工作,会议具体包括:

International Conference on Machine Learning

Conference and Workshop on Neural Information Processing Systems

我们对本领域论文的关键词进行分析,统计出词频 Top20 的关键词,生成本领域研究热点的词云图,如上图所示。其中, 出神经网络(neural networks)、深度学习(deep learning)、强化学习(reinforcement learning)是本领域中最热的关键词。 ICML 和 NeurlPS 是机器学习领域非常具有代表性的会议,限于报告篇幅,我们选取 ICML 和 NeurlPS 近十年若干最佳论文进行解读。

ICML 2019 年最佳论文

论文题目: Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations

中文题目: 挑战无监督分离式表征的常见假设

论文作者: Francesco Locatello, Stefan Bauer, Mario Lucic, Gunnar Rätsch, Sylvain Gelly, Bernhard Schölkopf, Olivier Bachem

论文地址: https://aminer.cn/pub/5c04967517c44a2c74709162/challenging-commonassumptions-in-the-unsupervised-learning-of-disentangled-representations

论文解读: 文章主要从理论和实践两方面对这一领域中的一些基本假设提出了挑战。文章从理论上证明,如果没有对所考虑的学习方法和数据集产生归纳偏置,那么解耦表示的无监督学习基本上是不可能的。文章还采用了完善的无监督解耦学习实验方案,进行了一个超级大规模的实验研究。最后还发布了disentanglement_lib,这是一个用于训练和评估解耦表示的新库。由于复制这个结果需要大量的计算工作论文还发布了超过 10000 个预训练的模型,可以作为未来研究的基线方法。

论 文 题 目 : Rates of Convergence for Sparse Variational Gaussian Process Regression

中文题目: 稀疏变分高斯过程回归的收敛速度

论文作者: David R. Burt, Carl E. Rasmussen, Mark van der Wilk

论文地址: https://www.aminer.cn/pub/5cede106da562983788e64b9/rates-ofconvergence-for-sparse-variational-gaussian-process-regression

论文解读:这篇文章来自英国剑桥大学。自从许多研究人提出了对高斯过程后验的变分近似法后,避免了数据集大小为 N 时 O(N3) 的缩放。它们将计算成本降低到 O(NM2),其中 M ≤ N 是诱导变量的数量。虽然 N 的计算成本似乎是线性的,但算法的真正复杂性取决于 M 如何增加以确保一定的近似质量。论文证明了稀疏 GP 回归变分近似到后验变分近似的 KL 散度的界限,该界限仅依赖于先验核的协方差算子的特征值的衰减。这些边界证明了直观的结果,平滑的核、训练数据集中在一个小区域,允许高质量、非常稀疏的近似。这些边界证明了用M≤N 进行真正稀疏的非参数推理仍然可以提供可靠的边际似然估计和点后验估计。对非共轭概率模型的扩展,是未来研究的一个有前景的方向。

二、计算机视觉

计算机视觉(computer vision),顾名思义,是分析、研究让计算机智能化的达到类似人类的双眼“看”的一门研究科学。即对于客观存在的三维立体化的世界的理解以及识别依靠智能化的计算机去实现。确切地说,计算机视觉技术就是利用了摄像机以及电脑替代人眼使得计算机拥有人类的双眼所具有的分割、分类、识别、跟踪、判别决策等功能。总之,计算机视觉系统就是创建了能够在2D 的平面图像或者 3D 的三维立体图像的数据中,以获取所需要的“信息”的一个完整的人工智能系统。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为计算机视觉领域全球学者分布情况:

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸;亚洲也有较多的人才分布,主要集中在我国东部及日韩地区;欧洲的人才主要分布在欧洲中西部;其他诸如非洲、南美洲等地区的学者非常稀少;计算机视觉领域的人才分布与各地区的科技、经济实力情况大体一致。

▲ 计算机视觉领域全球学者分布

此外,在性别比例方面,计算机视觉中男性学者占比 91.0%,女性学者占比9.0%,男性学者占比远高于女性学者。

计算机视觉学者的 h-index 分布如下图所示,大部分学者的 h-index 分布在中间区域,其中 h-index 在 20-30 区间的人数最多,有 706 人, 占比 34.7%,小于 20 的区间人数最少, 有 81 人。

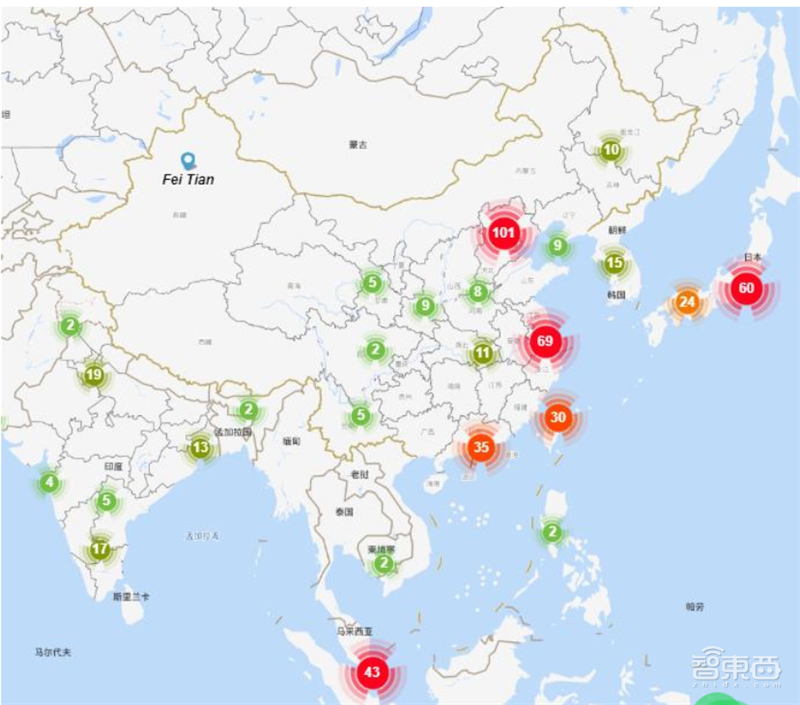

我国专家学者在计算机视觉领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是珠三角和长三角地区,相比之下,内陆地区的人才较为匮乏,这种分布与区位因素和经济水平情况不无关系。同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等亚洲国家相比,中国在计算机视觉领域学者数量相对较多。

▲计算机视觉领域中国学者分布

对本领域的高水平学术会议论文进行挖掘,解读这些会议在 2018-2019年的部分代表性工作。 会议具体包括:

IEEE Conference on Computer Vision and Pattern Recognition

European Conference on Computer Vision

论文题目: Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation

中文题目:具有空洞分离卷积的编码–解码器用于语义图像分割

论文作者: Liang-Chieh Chen, Yukun Zhu, George Papandreou, Florian Schroff,Hartwig Adam

论文出处: Proceedings of the European conference on computer vision (ECCV). 2018:801-818.

论文地址: https://link.springer.com/chapter/10.1007%2F978-3-030-01234-2_49

研究问题:

语义分割是计算机视觉中一项基本且重要的研究内容, 它是为图像中的每个像素分配语义标签。 在深度学习语义分割任务中经常会使用空间金字塔池化和编码–解码器结构。空间金字塔池化可以通过不同分辨率的池化特征捕捉丰富的上下文信息,但网络中具有步进操作的池化或卷积会导致与对象边界有关的详细信息丢失。这可以通过空洞卷积提取更密集的特征图来缓解, 但大大增加了计算资源的消耗。而编码-解码器结构则可以通过逐渐恢复空间信息来捕获更清晰的对象边界。通过组合两种方法的优点,提出新的模型—DeepLabv3+。

近年来,巨量数据的不断涌现与计算能力的快速提升,给以非结构化视觉数据为研究对象的计算机视觉带来了巨大的发展机遇与挑战性难题,计算机视觉也因此成为学术界和工业界公认的前瞻性研究领域,部分研究成果已实际应用,催生出人脸识别、智能视频监控等多个极具显示度的商业化应用。

近两年大多数研究都集中在深度学习、检测和分类以及面部/手势/姿势、 3D传感技术等方面。 随着计算机视觉研究的不断推进,研究人员开始挑战更加困难的计算机视觉问题,例如,图像描述、事件推理、场景理解等。单纯从图像或视频出发很难解决更加复杂的图像理解任务,一个重要的趋势是多学科的融合,例如,融合自然语言处理领域的技术来完成图像描述的任务。

图像描述是一个融合计算机视觉、自然语言处理和机器学习的综合问题,其目标是翻译一幅图片为一段描述文字。目前主流框架为基于递归神经网络的编码器解码器结构其核心思想类似于自然语言机器翻译。但是,由于递归网络不易提取输入图像和文本的空间以及层次化约束关系,层次化的卷积神经网络以及启发自认知模型的注意力机制受到关注。如何进一步从认知等多学科汲取知识,构建多模态多层次的描述模型是当前图像描述问题研究的重点。

事件推理目标是识别复杂视频中的事件类别并对其因果关系进行合理的推理和预测。与一般视频分析相比,其难点在于事件视频更加复杂,更加多样化,而最终目标也更具挑战性。不同于大规模图像识别任务,事件推理任务受限于训练数据的规模,还无法构建端到端的事件推理系统。目前主要使用图像深度网络作为视频的特征提取器,利用多模态特征融合模型,并利用记忆网络的推理能力,实现对事件的识别和推理认知。当前研究起源于视频的识别和检测,其方法并未充分考虑事件数据的复杂和多样性。如何利用视频数据丰富的时空关系以及事件之间的语义相关性,应是今后的关注重点。

场景理解的目的是计算机视觉系统通过分析处理自身所配置的传感器采集的环境感知数据,获得周围场景的几何/拓扑结构、组成要素(人、车及物体等)及其时空变化,并进行语义推理,形成行为决策与运动控制的时间、空间约束。近年来,场景理解已经从一个初期难以实现的目标成为目前几乎所有先进计算机视觉系统正在不断寻求新突破的重要研究方向。 利用社会–长短记忆网络(SocialLSTM)实现多个行人之间的状态联系建模,结合各自运动历史状态,决策出未来时间内的运动走向。此外神经网络压缩方向也是是目前深度学习研究的一个热门的方向,其主要的研究技术有压缩,蒸馏,网络架构搜索,量化等。

综上所述,视觉的发展需要设计新的模型,它们需要能考虑到空间和时间信息;弱监督训练如果能做出好的结果,下一步就是自监督学习;需要高质量的人类检测和视频对象检测数据集;结合文本和声音的跨模态集成;在与世界的交互中学习。

三、 知识工程

1994 年图灵奖获得者、知识工程的建立者费根鲍姆给出知识工程定义—将知识集成到计算机系统从而完成只有特定领域专家才能完成的复杂任务。在大数据时代,知识工程是从大数据中自动或半自动获取知识,建立基于知识的系统,以提供互联网智能知识服务。大数据对智能服务的需求,已经从单纯的搜集获取信息,转变为自动化的知识服务。我们需要利用知识工程为大数据添加语义/知识,使数据产生智慧(Smart Data),完成从数据到信息到知识,最终到智能应用的转变过程,从而实现对大数据的洞察、提供用户关心问题的答案、为决策提供支持、改进用户体验等目标。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为知识工程领域全球学者分布情况:

▲知识工程领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸; 欧洲及亚洲东部也有较多的人才分布;其他诸如非洲、南美洲等地区的学者非常稀少; 知识工程领域的人才分布与各地区的科技、经济实力情况大体一致。

此外, 在性别比例方面,知识工程领域中男性学者占比 89.7%,女性学者占比 10.6%,男性学者占比远高于女性学者。

知识工程领域学者的 h-index 分布如下图所示,大部分学者的 h-index 分布在中低区域,其中 h-index 在 20-30 区间的人数最多,有 783 人, 占比 38.9%,小于 20 区间的人数最少, 有 90 人。

我国专家学者在知识工程领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是珠三角和长三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等亚洲国家相比,中国在知识工程领域学者数量较多。

▲知识工程领域中国学者分布

对本领域的高水平学术会议及期刊论文进行挖掘,解读这些会议和期刊在 2018-2019 年的部分代表性工作。这些会议和期刊包括:

IEEE Transactions on Knowledge and Data Engineering

International Conference on Information and Knowledge Management

论文题目: Convolutional 2D Knowledge Graph Embeddings

中文题目:基于二维卷积的知识图谱嵌入表示学习

论文作者: Tim Dettmers, Pasquale Minervini, Pontus Stenetorp, Sebastian Riedel

论文出处: The Thirty-Second AAAI Conference on Artificial Intelligence (AAAI2018)

论文地址:https://www.aaai.org/ocs/index.php/AAAI/AAAI18/paper/download/17366/15884

研究问题: 知识图谱的链接预测任务是预测节点之间潜在的关系。传统的链接预测方法专注于浅的、快速的模型,因为这样可以扩展到大规模的 KG 中。但是浅层模型学习到的特征比深沉模型少很多,大大限制了模型的性能。解决该问题的方法之一是增加 embedding 的维度,但是会增加模型参数量,不方便扩展到大规模 KG中。此外,部分现有数据集中有测试集泄露问题:训练集中的三元组稍微翻转一下就可以得到测试集三元组,然后使用基于规则的模型就能达到最佳性能。文章通过构造一个简单的翻转来衡量这个问题严重性,并清洗了部分数据来解决该问题。

近两年知识获取、推理和应用研究取得了显著的进展,主要表现在如下几个方面:

1、资源匮乏情况下的知识获取 。知识图谱的构建始终是知识图谱领域的核心问题之一, 近年来除了传统的有监督的实体、关系、 事件知识获取的研究外,也涌现了一批在弱资源情况下的知识获取方法。例如:在集合扩展(实体集扩展)研究中, Learning to Bootstrap for Entity Set Expansion 使用蒙特卡洛树搜索策略的 booststrap 方法有效地提升了实体集扩展方法的稳定性,尤其是在与分类体系相关任务的同时优化上。 HiExpan:Task-Guided Taxonomy Construction by Hierarchical Tree Expansion 提出一个知识分类体系的扩展框架,模型利用弱监督关系抽取模型,从一个小型的上下位关系树出发,抽取扩展的节点并扩展成一个更加丰富的上下位体系。 FewRel 2.0:Towards More Challenging Few-Shot Relation Classification 提出了少次学习任务,通过设计少次学习机制,能够利用从过往数据中学到的泛化知识,结合新类型数据的少量训练样本,实现快速迁移学习。 COMET: Commonsense Transformers forAutomatic Knowledge Graph Construction 提出常识 Transformer 架构,将 GPT-2等语言模型与种子知识图谱相结合,学习其结构和关系,根据图表征形成语言模型,从而生成新的知识并将它们添加到种子图中。

2、 知识图谱的知识补全和可解释推理 。传统的表示学习缺乏可解释性,知识图谱推理越来越受到关注, 其中既有使用强化学习方法寻找路径的方法,也有使用实体邻居和注意力权重做可解释性推理方法。 Multi-Hop Knowledge Graph Reasoning with Reward Shaping 是基于多跳推理的知识库问答方法,基于强化学习扩展在知识图谱的推理路径, 以获得问题的 正 确 答 案 。 Learning Attention-based Embeddings for Relation Prediction in Knowledge Graphs 提出一种基于注意力机制的特征嵌入方法,获取实体邻近范围内的实体和关系特征,引入关系聚类和多跳关系,有效提升了基于多跳推理的知识图谱补全的效果。 Iteratively Learning Embeddings and Rules for Knowledge Graph Reasoning 研究如何迭代地进行知识表示学习和规则学习,提出的 IterE 模型可以利用学习的规则改进稀疏实体的表示学习,进而提升规则学习和链接预测效果。

3、基于知识图谱的推荐和对话问答 。将知识图谱作为辅助信息引入到推荐系统中可以有效地解决传统推荐系统存在的稀疏性和冷启动问题, 近几年吸引大量研究人员在相关工作。 随着图卷积神经网络, 图注意力机制等技术的逐渐兴起, 基于图表示学习的推荐模型达到了更高的表现效果,并为推荐系统的可解释性提供了帮助。 KGAT: Knowledge Graph Attention Network for Recommendation 利用知识图谱中商品之间的关系,训练了一个端到端的含注意力机制的模型,用于提高推荐系统的能力。 AKUPM: Attention-Enhanced Knowledge-Aware User Preference Model for Recommendation 使用注意力模型,利用知识图谱对用户进行建模,显著提升了推荐系统的效果。Reinforcement Knowledge Graph Reasoning for Explainable Recommendation 结合强化学习的框架和知识图谱推理来提供对推荐结果的解释。 在对话问答方面, 以前对话生成的信息源是文本与对话记录, 但如果遇到词表之外的( Out-ofVocabulary) 的词,模型往往难以生成合适的、有信息量的回复,而会产生一些低质量的、模棱两可的回复。 Commonsense Knowledge Aware Conversation Generation with Graph 提出一种基于常识知识图谱的对话模型 CCM 来理解对话,产生信息丰富且合适的回复。

四、自然语言处理

自然语言是指汉语、英语、法语等人们日常使用的语言,是人类社会发展演变而来的语言,而不是人造的语言,它是人类学习生活的重要工具。概括说来,自然语言是指人类社会约定俗成的,区别于如程序设计的语言的人工语言。在整个人类历史上以语言文字形式记载和流传的知识占到知识总量的 80%以上。就计算机应用而言,据统计,用于数学计算的仅占 10%,用于过程控制的不到 5%,其余 85%左右都是用于语言文字的信息处理。

处理包含理解、转化、生成等过程。自然语言处理,是指用计算机对自然语言的形、音、义等信息进行处理,即对字、词、句、篇章的输入、输出、识别、分析、理解、生成等的操作和加工。实现人机间的信息交流,是人工智能、计算机科学和语言学所共同关注的重要问题。自然语言处理的具体表现形式包括机器翻译、文本摘要、文本分类、文本校对、信息抽取、语音合成、语音识别等。可以说,自然语言处理就是要计算机理解自然语言,自然语言处理机制涉及两个流程,包括自然语言理解和自然语言生成。自然语言理解是指计算机能够理解自然语言文本的意义,自然语言生成则是指能以自然语言文本来表达给定的意图。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为自然语言处理领域全球学者分布情况:

▲自然语言处理领域学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸;欧洲也有较多的人才分布,主要集中在欧洲中西部;亚洲的人才主要分布在我国东部及日韩地区;其他诸如非洲、南美洲等地区的学者非常稀少;自然语言处理领域的人才分布与各地区的科技、经济实力情况大体一致。此外, 在性别比例方面,自然语言处理领域中男性学者占比 89.3%,女性学者占比 10.7%,男性学者占比远高于女性学者。

我国专家学者在自然语言处理领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等亚洲国家相比,中国在自然语言处理领域学者数量较多。

▲自然语言处理领域中国学者分布

2019自然语言处理代表性文章是:

论文题目: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

中文题目: BERT: 语言理解的深层双向转换器的预训练

论文作者: Jacob Devlin Ming-Wei Chang Kenton Lee Kristina Toutanova

论文出处: In Proceedings of the 2019 Annual Conference of the North American Chapter of the Association for Computational Linguistics.

论文地址: https://arxiv.org/abs/1810.04805

文章介绍一种新的语言表示模型 BERT(Bidirectional Encoder Representations from Transformers),通过联合上下文信息从未标记文本中预训练深层双向表示形式,只需一个额外的输出层,就可以对预训练模型进行调整,在不需要对特定任务的体系结构进行大量修改的前提下,在多种语言相关任务上获得。

近年来,预训练语言模型在自然语言处理领域有了重要进展。 预训练模型指的是首先在大规模无监督的语料上进行长时间的无监督或者是自监督的预先训练(pre-training),获得通用的语言建模和表示能力。之后在应用到实际任务上时对模型不需要做大的改动,只需要在原有语言表示模型上增加针对特定任务获得输出结果的输出层,并使用任务语料对模型进行少许训练即可,这一步骤被称作微调(fine tuning)。

自 ELMo、 GPT、 BERT 等一系列预训练语言表示模型(Pre-trained Language Representation Model)出现以来,预训练模型在绝大多数自然语言处理任务上都展现出了远远超过传统模型的效果,受到越来越多的关注,是 NLP 领域近年来最大的突破之一,是自然语言处理领域的最重要进展。

BERT(Bidirectional Encoder Representation from Transformer)是 Google AI于 NAACL2019 提出的一个预训练语言模型。 BERT 的创新点是提出了有效的无监督预训练任务,从而使得模型能够从无标注语料中获得通用的语言建模能力。模型的部分细节在前文的论文解读中已经给出,不再赘述。

BERT 之后涌现了许多对其进行扩展的模型, 包括: 跨语言预训练的 XLM 和 UDify, 跨模态预训练的模型, 融合知识图谱的 ERNIE, 将seq2seq 等语言生成任务整合入 BERT 类模型的 MASS, UniLM 等。其中几个重要的进展包括:

(1) XLNet 使用 Transformer-XL 替代了 Transformer 作为基础模型,拥有编码超长序列的能力。 XLNet 提出了一个新的预训练语言任务: Permutation LanguageModeling(排列语言模型),模型将句子内的词语打乱顺序,从而使得预测当前词语时可以利用双向信息。 XLNet 相对 BERT 也使用了更多的语料。

(2) RoBERTa 采用了与 BERT 具有相同的模型结构,同样采用了屏蔽语言模型任务进行预训练,但舍弃了 BERT 中下句预测模型。此外, RoBERTa 采用了更大规模的数据和更鲁棒的优化方法,从而取得了更好的表现。

(3) ALBERT 模型针对 BERT 参数量过大难以训练的问题做了优化,一是对词向量矩阵做分解,二是在层与层之间共享参数。此外, ALBERT 将下句预测模型替换为句序预测任务,即给定一些句子预测它们的排列顺序。

五、 语音识别

语音识别是让机器识别和理解说话人语音信号内容的新兴学科,目的是将语音信号转变为文本字符或者命令的智能技术,利用计算机理解讲话人的语义内容,使其听懂人类的语音,从而判断说话人的意图,是一种非常自然和有效的人机交流方式。它是一门综合学科,与很多学科紧密相连,比如语言学、信号处理、计算机科学、心理和生理学等。

语音识别首先要对采集的语音信号进行预处理,然后利用相关的语音信号处理方法计算语音的声学参数,提取相应的特征参数,最后根据提取的特征参数进行语音识别。总体上,语音识别包含两个阶段:第一个阶段是学习和训练,即提取语音库中语音样本的特征参数作为训练数据,合理设置模型参数的初始值,对模型各个参数进行重估,使识别系统具有最佳的识别效果;第二个阶段就是识别,将待识别语音信号的特征根据一定的准则与训练好的模板库进行比较,最后通过一定的识别算法得出识别结果。显然识别结果的好坏与模板库是否准确、模型参数的好坏以及特征参数的选择都有直接的关系。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为语音识别领域全球学者分布情况:

▲语音识别领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸;亚洲也有较多的人才分布,主要在我国东部及日韩地区;欧洲的人才主要集中在欧洲中西部;其他诸如非洲、南美洲等地区的学者非常稀少;语音识别领域的人才分布与各地区的科技、经济实力情况大体一致。

我国专家学者在语音识别领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等亚洲国家相比,中国在语音识别领域学者数量较多且有一定的优势。

▲ 语音识别领域中国学者分布

2019代表论文:

论文题目: X-Vectors: Robust DNN Embeddings for Speaker Recognition

中文题目: X 向量:用于说话人识别的鲁棒 DNN 嵌入

论文作者: David Snyder, Daniel Garcia-Romero, Gregory Sell, Daniel Povey and Sanjeev Khudanpur. X-Vectors: Robust DNN Embeddings for Speaker Recognition.

论文出处: 2018 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP)

论文地址: https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=8461375

研究问题: 捕捉说话者特征是语音识别领域具有重大意义的研究内容。 大多数说话人识别系统都是基于 i-vectors 来实现的。 标准的基于 i-vectors 的方法由通用背景模型(UBM)和大型投影矩阵 T 组成,该模型以无监督方式来学习。在早期的系统中,神经网络经训练后,被用来分离说话者,从网络中提取帧级表示, 并将其用作高斯说话者模型的特征。近年来, 使用深度神经网络(DNN)捕获说话者特征是当前非常活跃的研究领域。 DNN 嵌入性能也随着训练数据量的增加而高度扩展。

随着人工智能的迅速发展,语音识别的技术越来越成为国内外研究机构的焦点。人们致力于使机器能够听懂人类的话语指令,并希望通过语音实现对机器的控制。作为一项人机交互的关键技术,语音识别在过去的几十年里取得了飞速的发展,在研究和探索过程中针对语音识别的各部流程进行了各种各样的尝试和改造,以期发现更好的方法来完成语音识别流程中的各个步骤,以此来促进在不同环境下语音识别的效率和准确率。研究人员从最简单的非常小词汇量的阅读式的语音识别问题开始,逐渐转向越来越复杂的问题。

近年来智能语音进入了快速增长期,语音识别作为语音领域的重要分支获得了广泛的关注,如何提高声学建模能力和如何进行端到端的联合优化是语音识别领域中的重要课题。

随着人工智能的迅速发展,语音识别的技术越来越成为国内外研究机构的焦点。人们致力于使机器能够听懂人类的话语指令,并希望通过语音实现对机器的控制。作为一项人机交互的关键技术,语音识别在过去的几十年里取得了飞速的发展,在研究和探索过程中针对语音识别的各部流程进行了各种各样的尝试和改造,以期发现更好的方法来完成语音识别流程中的各个步骤,以此来促进在不同环境下语音识别的效率和准确率。研究人员从最简单的非常小词汇量的阅读式的语音识别问题开始,逐渐转向越来越复杂的问题。

近年来智能语音进入了快速增长期,语音识别作为语音领域的重要分支获得了广泛的关注,如何提高声学建模能力和如何进行端到端的联合优化是语音识别领域中的重要课题。

语音识别经历了从 2012 年最开始的 DNN 的引入时的 Hybrid HMM 结构,再到 2015 年开始吸引大家研究兴趣的 CTC 算法,而后到 2018 年的 Attention 相关结构的研究热点。 Attention 相关算法在语音识别或者说话人识别研究的文章中出现频率极高。从最开始 Attention,到 Listen-Attend-Spell,再到 Self-Attention(或者 Transformer),在不同的文章被作者多次介绍和分析,频繁出现在了相关文章的 Introduction 环节中。在 Attention 结构下,依然还有很多内容需要研究者们进一步地探索:例如在一些情况下 Hybrid 结构依然能够得到 State-of-the-art 的结果,以及语音数据库规模和 Attention 模型性能之间的关系。

在近两年的研究中, 端到端语音识别仍然是 ASR( Automatic SpeechRecognition)研究的一大热点,正如上文提到的,基于 Attention 机制的识别系统已经成为了语音技术研究主流。同时,随着端到端语音识别框架日益完善,研究者们对端到端模型的训练和设计更加的关注。 远场语音识别(far-field ASR),模型结构(ASR network architecture),模型训练(model training for ASR),跨语种或者多语种语音识别(cross-lingual and multi-lingual ASR)以及一些端到端语音识别(end-to-end ASR)成为研究热点。

在语音合成方面,高音质语音生成算法及 Voice conversion 是近两年研究者关注的两大热点, Voice Conversion 方向的研究重点主要集中在基于 GAN 的方法上。 在语言模型方面(Language Model)的研究热点主要包括 NLP 模型的迁移,低频单词的表示,以及深层 Transformer 等。

在说话人识别方面,说话人信息,特别是说话人识别及切分,正被越来越多的研究者所重视。 目前 Attention 在说话人方面更类似一种 Time Pooling,比Average Pooling 及 Stats Pooling 更能捕捉对说话人信息更重要的信息,从而带来性能提升。说话人识别技术经历深度学习带来的性能飞跃后,在模型结构、损失函数等方面的探讨已经较为成熟,以 TDNN、 ResNet 加上 LMCL、 ArcFace 的主流模型开始不断刷新各数据集的性能上限。模型以外的因素逐渐成为制约说话人系统的瓶颈。说话人技术目前也逐渐暴露出与人脸识别同样的易受攻击的问题。因此, ASVspoof 这样的 Challenge 从 2015 年起就开始关注声纹反作弊问题。相信随着此类研究的不断深入,结合声纹系统的性能提升,声纹将有望变成我们的“声音身份证”。

六、 计算机图形学

国际标准化组织 ISO 将计算机图形学定义为:计算机图形学是一门研究通过计算机将数据转换成图形,并在专门显示设备上显示的原理方法和技术的学科。它是建立在传统的图形学理论、应用数学及计算机科学基础上的一门边缘学科。这里的图形是指三维图形的处理。简单来讲,它的主要研究内容是研究如何在计算机中表示图形,以及利用计算机进行图形的计算处理和显示的相关原理和算法。

在计算机图形学的开创之初,他主要解决的问题是在计算机中表示三维结合图形以及如何利用计算机进行图形的生成处理和显示的相关原理和算法,目的是产生令人赏心悦目的真实感图像,这仅仅是狭义的计算机图形学。随着近些年的发展,计算机图形学的内容已经远远不止这些,广义的计算机图形学研究内容非常广泛,包括图形硬件、图形标准、图形交互技术、栅格图形生成算法、曲线曲面造型、实体造型、真实版图形的计算、显示算法、科学计算可视化、计算机动画、虚拟现实、自然景物仿真等等。

计算机图形学的总体框架可以包括以下几个部分:数学和算法基础、建模、渲染以及人机交互技术。计算机图形学需要一些基本的数学算法,例如向量和几何的变化、几何建模式的三维空间变化、三维到二维的图形变换等等。建模是进行图形描述和计算,由于在多维空间中有各种组合模型,有一些是解析式表达的简单形体,也有一些隐函数表达的复杂曲线,因此需要进行复杂的建模工作。渲染也叫绘制,指的是模型的视觉实现过程,例如对光照纹理等理论和算法进行处理,其中也需要大量的计算。交互技术可以说是图形学交互的重要工具,是计算机图形学的重要应用。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为计算机图形学全球学者分布情况:

▲计算机图形学领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。 从该地图可以看出,美国的人才数量优势明显; 欧洲也有较多的人才分布,主要在欧洲中西部; 亚洲的人才主要集中在我国东部及日韩地区;其他诸如非洲、南美洲等地区的学者非常稀少; 计算机图形学的人才分布与各地区的科技、经济实力情况大体一致。

我国专家学者在计算机图形领域的分布如上图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏,这种分布与区位因素和经济水平情况不无关系。同时,通过观察中国周边国家的学者数量情况,特别是与日韩等地相比,中国在计算机图形领域学者数量略多但差距较小。

▲计算机图形学领域中国学者分布

2019优秀计算机图形学论文:

论 文 题 目 : A Style-based Generator Architecture for Generative Adversarial Networks

中文题目:基于样式的生成式对抗网络生成器架构

论文作者: Tero Karras, Samuli Laine, Timo Aila.

论文出处: The IEEE Conference on Computer Vision and Pattern Recognition- CVPR 2019

论文地址:http://openaccess.thecvf.com/content_CVPR_2019/papers/Karras_A_StyleBased_Generator_Architecture_for_Generative_Adversarial_Networks_CVPR_2019_paper.pdf

研究问题: 本文针对自动的无监督的习得图像的高层属性(譬如人脸对应的身份信息以及拍摄姿态)以及对于生成的每幅图像产生一些特定的随机化的变换(譬如脸部瑕疵以及头发的细节),生成较为直观且可控的合成结果进行了研究。通过借鉴风格迁移的思想,提出了一种新的对抗网络中的生成器架构。该架构不仅在传统的分布距离的度量上优势明显,并且较好地将控制图像变化的隐变量分离出来进行独立建模。

随着数字化技术和互联网的发展,计算机图形学在许多领域都已经得到了广泛的应用,如遥感图像分析、多媒体通信、医疗诊断、机器人视觉等。当前计算机图形学的研究逐渐向多学科交叉融合方向发展,即有与认知计算、计算器学习、人机交互的融合,也有与大数据分析、可视化的融合;不仅针对三维数字模型, 而且涵盖了图像视频, 与计算机视觉深度交叉。计算机图形学的快速发展,一个潜在的趋势是不再有明确清晰的主题,更多的体现出方法和技术的创新。

针对近两年计算机图形学重要期刊会议的相关论文,对该领域内容热点研究内容和前沿技术方法进行了综合分析。目前,热点研究内容主要集中在自监督学习(Self-Supervised Learning)、全景分割(Panoptic Segmentation) 、网络结构搜索( Neural Architecture Search) 和生成式对抗网络( Generative AdversarialNetworks) 等方面。

自监督学习研究早期主要集中在代理任务的设计和选取上,怎样的代理任务才能最好地提取出有益于下游任务的特征以及为何这些代理任务能够有效,这些是理论层面上自监督学习仍需要解决的问题。随着大量围绕着实例判别代理任务的相关工作的提出,有一些工作将其中的核心思想进行展开提出了所谓对比学习的概念。通过将原来两个图片实例特征间的对比延伸到任意两个模态间特征的对比,使得模型学习不同模态间一致的特征表达并用最大化互信息作为新的衡量准则。

在已有的工作中,比较典型的代理任务有将图片分块然后预测不同分块间的相对位置或者将分块打乱后重排得到原图,以及基于图片的上下文信息进行补全和图片不同颜色通道间的相互预测等。目前在图像与图形学领域,取得性能突破的方法主要仍局限在监督学习的框架之下,随着无标记数据的不断爆增和模型性能进一步提升的需求,无监督学习将会越来越受到学术界和工业界的重视。而作为目前无监督学习中的一支,自监督学习因其良好的特征判别能力和对大规模数据扩展能力,也将受到更广泛的关注。

全景分割作为一个统一的任务在 2018 年被提出,它的目标是为图像中的所有像素点都分配一个语义类别和一个实例编号,从另一个角度来说,全景分割算法需要预测出图像中每一个像素点的所属类别和所属实例。在全景分割任务的基础上,近期的进展主要体现在三个方面:(1)从图像整体的角度考虑全景分割,共享网络主干(backbone)形成设计整体网络结构;(2)考虑图像中不同元素之间的交互,建模物体与语义概念之间的关系;(3)提出可学习模块,解决预测结果层面的冲突。接下来,我们将分别介绍有代表性的工作。全景分割作为一个最近被提出的视觉任务,受到了很大的关注,目前方法也在探讨的过程中,具有很大的发展潜力。

目前深度学习的方法在各类图像与图形分析任务中取得了非常大的成功,伴随这一成功而来的是对网络结构设计要求的不断提高。自动化网络设计自然而然地成为了自动化机器学习的下一个目标。早期的相关工作证明了使用强化学习算法可以发现好的网络架构,但是这些方法在计算过程中需要消耗大量计算资源,因此后续的工作都集中在如何减少计算负担上。搜索空间的设计也是一项重要研究热点,同时,研究人员又拓宽了神经结构搜索的视野,将多种优化目标考虑在内,而不仅仅是减少搜索时间和提高网络精度。具有代表性的工作如尝试限制模型参数的数量或类似的方法,以有效地部署在移动设备上。在此基础上,还有一些工作将网络结构搜索技术扩展到搜索深度网络相关组件上。

在图像合成方面,近期最引人关注的工作就是生成对抗网络,生成对抗网络由一个生成网络 G 和一个判别网络 D 组成。生成网络 G 和判别网络 D 在训练阶段使用对抗的方式进行学习,生成网络 G 的目标是生成尽可能真实的图片使得判别网络认为这是一张真实的图片;而判别网络 D 的任务则是判别合成的图像是真实的还是生成的。在这种两者对抗的学习过程中,生成 G 学会如何生成真实的图片。目前在生成对抗网络研究中,条件生成对抗网络、损失函数的改进、模型结构的改进及训练方法的改进是主要研究方向。

七、 多媒体技术

“多媒体”一词译自英文“Multimedia”,而该词又是由 multiple 和 media 复合而成,核心词是媒体。媒体(medium)在计算机领域有两种含义:一是指存储信息的实体,如磁盘、光盘、磁带、半导体存储器等,中文常译为媒质;二是指传递信息的载体,如数字、文字、声音、图形和图像等,中文译作媒介,多媒体技术中的媒体是指后者。其实,“媒体”的概念范围是相当广泛的。“媒体”有下列五大类:(1)感觉媒体(Perception medium)指的是能使人产生直接感觉的媒体。如声音、动画、文本等;(2)表示媒体(Representation medium)指的是为了传送感觉媒体而人为研究出来的媒体。诸如语言编码、电报码、条形码等等;(3)显示媒体(Presentation medium)指的是用于通信中使电信号和感觉媒体之间产生转换用的媒体。如键盘、鼠标器、打印机等;(4)存储媒体(Storage medium)指的是于存放某种媒体的媒体。如纸张、磁带、磁盘、光盘等;(5)传输媒体(Transmission medium)指的是用于传输某些媒体的媒体。常用的有如电话线、电缆、光纤等。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为多媒体领域全球学者分布情况。

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸;亚洲东部也有较多的人才分布;欧洲的人才主要集中在欧洲中西部;其他诸如非洲、南美洲等地区的学者非常稀少;多媒体领域的人才分布与各地区的科技、经济实力情况大体一致。

▲多媒体领域全球学者分布

我国专家学者在多媒体领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况, 特别是与日韩、东南亚等亚洲国家相比,中国在多媒体领域学者数量较多且有一定的优势。

▲多媒体领域中国学者分布

2019优秀论文:

论文题目: Beyond Narrative Description: Generating Poetry from Images by MultiAdversarial Training

中文题目:超越叙事描述:通过多重对抗训练,从意象中生成诗歌

论文作者: Bei Liu, Jianlong Fu, Makoto P. Kato, Masatoshi Yoshikawa

论文出处: 26th ACM International Conference on Multimedia – ACMMM’18

论文地址: https://arxiv.org/pdf/1804.08473v4.pdf

研究问题:本文主要研究了从图像自动生成诗歌的方法。这项任务涉及多个挑战,包括从图像中发现诗意线索(例如,从绿色中获得希望),以及生成满足图像相关性和语言水平的诗意的诗歌。

近年来,随着数字化技术的发展,多媒体技术突飞猛进,音视频技术是当前最活跃、发展最迅速的高新技术领域之一。多媒体分析以文本、图像、声音、视频等多种不同类型媒体的数据为研究对象,主要的研究目的一方面是使计算机具备人类的多媒体(如视、听)理解能力,另一方面是从多媒体数据中挖掘信息和知识、帮助人类更好地理解世界。

多媒体技术研究领域包括多媒体信息处理、多媒体数据压缩编码、多媒体内容分析与检索技术、多媒体交互与集成、多媒体通信与网络、多媒体内容安全、多媒体系统与虚拟现实等。在近几年的研究中,多媒体技术呈现出与计算机体系结构、计算机网络、人机交互、信息安全、社会网络等多学科交叉融合的发展趋势。

近两年多媒体领域研究热点主要集中在大规模图像视频分析、社会媒体研究、多模态人机交互、计算视觉、计算图像、实时视频流化等方面。

由于多媒体数据往往是多种信息的传递媒介(例如一段视频中往往会同时使得文字信息、视觉信息和听觉信息得到传播),多模态学习已逐渐发展为多媒体内容分析与理解的主要手段。

在计算图像方面,大规模数据集的构建仍是一个热点研究方向,尤其语义对象的像素级标注需求越来越强烈,能够人机交互标注的过程中不断学习的协同标注方法得到了广泛关注。

无监督学习是多媒体数据分析的长远目标。目前很多领域拥有大量的数据,但是这些数据都是没有经过标记的。因此除了基本的数据勘探和异常检测场景,这些数据基本无法使用。近期在使用未标记的数据来改进(标记数据)监督学习过程方面已经取得了许多进展。

此外自动机器学习(AutoML)和元学习(Meta Learning)的最新研究成果及其在多媒体上的应用也逐渐增多。

在图像压缩处理方面,也有一些研究工作将深度学习用于图像或视频压缩后处理,并得到了一定的效果。然而,现有工作的一个主要问题是用于后处理的深度网络较为复杂,计算速度慢,不满足实际应用的需求。如何在处理效果和处理速度之间取得一个折中,是压缩后处理的一个主要挑战。

图神经网络(Graph Neural Network, GNN)在多媒体领域的应用是近两年的热点研究方向,应用场景包括:个性化推荐,如基于多模态图卷积网络(MMGCN)的多模态推荐方法;短视频推荐,如使用基于图的顺序网络进行建模;多视频摘要,如采用图卷积网络衡量每个视频的重要性和相关性;基于文本的行人搜索,如使用深度对抗图注意力卷积网络(A-GANet) 利用文本和视觉场景图学习联合特征空间;视频关系监测,如使用转移图神经网络(DoT-GNN) 解决图像外观变化的问题。

随着 Mask-RCNN 与 RetinaNet 的发展,物体检测研究日趋成熟,但即便如此,就应用而言,当前的技术依然存在诸多缺陷,为此,针对现代目标检测的基本框架(backbone、 head、 scale、 batchsize 与 post-processing),神经网络架构搜索(NAS)以及细粒度图像分析(FGIA)等 3 个方面的潜在难题成为主要研究内容,尤其是后两者,将成为未来视觉物体检测的两个重要研究维度。

八、 人机交互技术

人机交互(Human-Computer Interaction, HCI), 是人与计算机之间为完成某项任务所进行的信息交换过程, 是一门研究系统与用户之间的交互关系的学问。系统可以是各种各样的机器,也可以是计算机化的系统和软件。人机交互界面通常是指用户的可见部分,用户通过人机交互界面与系统交流, 并进行操作。人机交互技术是计算机用户界面设计中的重要内容之一, 与认知学、人机工程学、心理学等学科领域有密切的联系。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为人机交互领域全球学者分布情况:

▲人机交互领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸; 欧洲也有较多的人才分布; 亚洲的人才主要集中在日韩地区;其他诸如非洲、南美洲等地区的学者非常稀少; 人机交互领域的人才分布与各地区的科技、经济实力情况大体一致。

我国专家学者在人机交互领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩等地相比,中国在人机交互领域学者数量较少。

▲人机交互领域中国学者分布

优秀论文:

论文题目: Guidelines for human-AI interaction

中文题目: 人工智能交互指南

论文作者: Saleema Amershi, Dan Weld, Mihaela Vorvoreanu, Adam Fourney, Besmira Nushi, Penny Collisson, Jina Suh, Shamsi Iqbal, Paul N. Bennett, Kori Inkpen, Jaime Teevan, Ruth Kikin-Gil, and Eric Horvitz

论文出处: ACM CHI Conference on Human Factors in Computing Systems 2019 (CHI 2019)

论文地址: https://doi.org/10.1145/3290605.3300233

研究问题: 人工智能(AI)领域的快速发展给用户界面和交互设计带来了新的机遇和挑战。虽然人机交互届对人和 AI 交互的原则原理已经进行了 20 多年的探讨,我们仍需要更多的研究和创新来解决人工智能新技术及其面向人类的应用不断涌现而带来的新科学及社会问题。作者提出了 18 条具有通用性的、可适用于多种应用场景的、针对人和 AI 交互的设计指导,指出现有知识的空缺及未来的探索方向。 这份指南不仅为 AI 设计师提供了具体、可操作的建议,还旨在推动用户体验和工程开发从业者就设计决策的相关问题展开讨论,推动这一领域研究的研究方法:

文章提出了 18 条人工智能交互设计指导,并进行多轮的实例评估来验证其有效性,包括通过一个用户实验,邀请 48 位设计师以这些设计指导为工具来测试 20 项广泛使用的有 AI 技术支持的用户产品。

最近的十年,是人机交互向自然交互蓬勃发展的十年。毋庸置疑,计算机是世纪最伟大的发明,其作用从科学计算工具迅速发展为信息处理和信息交互工具,起引领作用的则是人机交互技术的变革,即以鼠标发明为标志的图形用户界面(Graphical User Interface, GUI)的产生,一改规范命令与计算机交互的命令行界面模式(Command Line Interface, CLI),GUI 提供了普通人与计算机便捷交互的工具和方法,让计算机从实验室走进办公室、走入家庭,十多年前,触屏技术成为产品技术, GUI 中的鼠标被人的天然指点(pointing)工具——手指所取代,计算机又变身出手机,成为更多人方便使用的随身掌上工具。

更少依赖操控工具,发展学习和使用成本更小的自然交互技术,一直是人机交互研究的价值追求,最

近十年,随着感知和计算技术的进步,自然交互技术创新层出不穷,并能迅速成为新型产品技术, 《麻省理工科技评论》总结和评论人机交互领域的突破技术(breakthroughs),为人机交互技术、未来终端技术的发展建立了一个高端的技术论坛,影响深远。我把这些突破技术分为 3 大类:支持自然动作的感知技术,面向穿戴的新型终端和基于语音识别的对话交互。

人体动作蕴含丰富的语义,动作交互技术一方面需要感知技术的进步,另一方面需要发现或设计有明确交互语义的动作(gesture,姿态,由于人手的灵巧性,手势成为主要的交互动作,通常叫做手势),如今,二维表面上,多指触摸动作在触屏上已普遍可用,三维空间中,嵌入了深度摄像头的手持和固定设备,能比较准确识别人的姿态和动作,做出响应。不同于人脸识别等目标明确的视觉识别任务,动作交互不仅要求视觉识别的准确度,更需要研究基于交互任务的动作表达的自然性与一致性,难以发现和突破,所以,除了动作语义很直白的动作游戏(body game),三维动作交互尚缺少普遍认知和接受的交互动作语义。而无论二维还是三维,手势的不可见性,是动作交互的主要难题。

穿戴(wearable)取代手持(handheld)曾是前几年的一个革命口号,目前看,市场上的确出现了一定规模的新产品,但穿戴仍是补充的地位。穿戴设备中,手环设备基本只有健康和活动检测功能,智能手表可以算做创新终端,但作为缩小版的手机,由于交互界面的缩小和操作方式的限制(通常是小界面上双手参与操作),其承载功能也较手机缩减很多。 VR/ AR(虚拟现实/增强现实)的一个理想载体是头戴式设备,最近几年,多款智能眼镜产品面世,较之前笨重的头盔轻便了许多,逼真的虚拟场景和准确的现实对象识别信息都可以清晰呈现在眼前,并在特定领域开拓着增强体验的应用;然而,智能眼镜尚缺少与其三维真实显示匹配的准确的自然输入技术,以及从眼手绑定在手机上转变到眼手分离的眼镜设备上时,尚未建立起相应的交互模式。

自然语言对话式交互得益于大数据和智能技术的进步,多语言的自然语音识别技术在用户终端上都达到了很高的可用水平,并且,语音识别超越文本输入方式,成为智能软件助理的使能技术,近两年,更是有基于语音接口的家居产品如雨后春笋般出现, VUI (Voice User Interface,语音用户界面)已经成为交互术语。然而, VUI 的局限也是显而易见的,相对并行模式的视觉通道,串行模式的语音通道的带宽显然窄的多,出声的使用方式在很多场合是不合适的,但作为一种可用的自然交互技术,有效提升了用户体验。

人机交互作为终端产品的引领技术的作用已经是产业界的普遍认识,欣喜看到很多种自然交互技术和新型交互终端面世,但 GUI 仍是交互的主导模式。计算无所不在,交互自然高效是发展趋势,人机交互的研究和开发空间很大,需要综合地探索自然交互技术的科学原理,建立明确的优化目标,结合智能技术,发展高可用的自然交互技术。

九、 机器人

机器人广义上包括一切模拟人类行为或思想以及模拟其他生物的机械(如机器狗,机器猫等)。狭义上对机器人的定义还有很多分类法及争议,有些电脑程序甚至也被称为机器人(例如爬虫机器人)。联合国标准化组织采纳了美国机器人协会给机器人下的定义: “一种可编程和多功能的操作机;或是为了执行不同的任务而具有可用电脑改变和可编程动作的专门系统。一般由执行机构、驱动装置、检测装置和控制系统和复杂机械等组成” 。 机器人是综合了机械、电子、计算机、传感器、控制技术、人工智能、仿生学等多种学科的复杂智能机械。

目前,智能机器人已成为世界各国的研究热点之一,成为衡量一国工业化水平的重要标志。机器人是自动执行工作的机器装置,因此,它既可以接受人类指挥,又可以运行预先编排的程序,也可以根据以人工智能技术制定的原则纲领行动。在当代工业中,机器人指能自动执行任务的人造机器装置,用以取代或协助人类工作,一般会是机电装置,由计算机程序或电子电路控制。机器人的范围很广,可以是自主或是半自主的,从本田技研工业的 ASIMO 或是 TOSY 的 TOPIO等拟人机器人到工业机器人,也包括多台一起动作的群机器人,甚至是纳米机器人。借由模仿逼真的外观及自动化的动作,理想中的高仿真机器人是高级整合控制论、机械电子、计算机与人工智能、材料学和仿生学的产物。机器人可以作一些重复性高或是危险,人类不愿意从事的工作,也可以做一些因为尺寸限制,人类无法作的工作,甚至是像外太空或是深海中,不适人类生存的环境。机器人在越来越多方面可以取代人类,或是在外貌、行为或认知,甚至情感上取代人类。

机器人技术最早应用于工业领域,但随着机器人技术的发展和各行业需求的提升,在计算机技术、网络技术、 MEMS 技术等新技术发展的推动下,近年来,机器人技术正从传统的工业制造领域向医疗服务、教育娱乐、勘探勘测、生物工程、救灾救援等领域迅速扩展,适应不同领域需求的机器人系统被深入研究和开发。过去几十年,机器人技术的研究与应用,大大推动了人类的工业化和现代化进程,并逐步形成了机器人的产业链,使机器人的应用范围也日趋广泛。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为机器人领域全球学者分布情况:

▲机器人领域全球学者分布

我国专家学者在机器人领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是珠三角和长三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩等地相比,中国在机器人领域学者数量较少。

▲机器人领域中国学者分布

优秀论文:

论文题目: Robotic Pick-and-Place of Novel Objects in Clutter with Multi-Affordance Grasping and Cross-Domain Image Matching

中文题目:通过多 affordance 抓取和跨域图像匹配完成杂乱环境下对新物体的捡放操作

论文作者: Andy Zeng, Shuran Song, Kuan-Ting Yu, Elliott Donlon, Francois R. Hogan, Maria Bauza, Daolin Ma, Orion Taylor, Melody Liu, Eudald Romo, Nima Fazeli, Ferran Alet, Nikhil Chavan Dafle, Rachel Holladay, Isabella Morona, Prem Qu Nair, Druck Green, Ian Taylor, Weber Liu, Thomas Funkhouser, Alberto Rodriguez

论文出处: IEEE International Conference on Robotics and Automation, 2018

论文地址: https://ieeexplore.ieee.org/abstract/document/8461044

研究问题: 人类可以在仅掌握少量先验知识的前提下识别和抓取陌生目标物,这一能力一直是机器人研究的灵感来源,也是很多实际应用的核心。为此,提出一种能在杂乱环境下对新目标物进行识别和捡放操作的机器人系统,整个系统可直接用于新目标物(在测试过程中首次出现),而无需额外的数据收集或重新训练。

机器人学习 。 在 AI 兴起的时代,机器人拥有了一种新型的学习方式:深度强化学习。这一新方式借助通用化的神经网络表示,处理复杂的传感器输入,来让机器人从自己的经验活动中直接学习行为。相比传统方式,它解放了工程设计人员们的双手,不再需要程序员们手动设计机器人每一个动作的每一项精确参数。但是,现有的强化学习算法都还不能够适用于有复杂系统的机器人,不足以支撑机器人在短时间内就学习到行为,另外在安全性上也难以保障。

针对这种困境, 2019 年初,谷歌 AI 与 UC 伯克利大学合作研发了一种新的强化学习算法: SAC(Soft ActorCritic)。 SAC 非常适应真实世界中的机器人技能学习,可以在几个小时内学会解决真实世界的机器人问题,而且它的一套超参数能够在多种不同的环境中工作,效率十分之高。 SAC 的开发基于最大熵强化学习这个框架。此框架尝试让预期回报最大化,同时让策略的熵最大化。一般而言,熵更高的策略具有更高的随机性。从直觉上看,这意味着,最大熵强化学习能取得高回报策略中具有最高随机性的那个策略。 SAC 学习一个随机策略,这个策略会把状态映射到动作,也映射到一个能够估计当前策略目标价值的 Q 函数,这个 Q 函数还能通过逼近动态编程来优化它们。 SAC 通过这样的方式,来让经过熵强化的回报最大化。此过程中,目标会被看作一个绝对真的方法,来导出更好的强化学习算法,它们有足够高的样本效率,且表现稳定,完全可以应用到真实世界的机器人学习中去。

机器人应用 。 2019 年 6 月,亚马逊在 MARS 人工智能大会上最新发布的仓库机器人Pegasus,该机器人已正式加入亚马逊 Kiva 机器人行列。 Pegasus 是一种新型包裹分拣机器人,外观上看, Pegasus 机器人十分类似亚马逊既有的 Kiva 机器人, 外观还是橙色不变, 2 英尺高, 3 英尺宽,约相当于一个手提包的大小。 Pegasus 机器人更像是对原有 Kiva 机器人的改良版,在原有机器人底座上增加了一个载货平台+皮带传送带对各个包裹进行分类和移动,有助于最大限度地减少包裹损坏并缩短交货时间。 Pegasus 机器人可以自主将右侧盒子放在正确的位置。仓库作业人员将包裹扫描完放到 Pegasus 机器人上, Pegasus 机器人载着包裹到指定地点。

机器人配备的摄像机可以感知任何意外障碍。到了指定地点,机器人载货平台上的传送带将包装从机器人上移开,然后包裹沿着滑槽向下移动,准备送出。机器人在大约 2 分钟内完成整个包裹运送过程。据亚马逊介绍, Pegasus 机器人具有与 Kiva 机器人驱动器相同的容量。 Pegasus 机器人目前已经在在丹佛分拣中心上线的六个多月,行驶约 200 万英里,经测试,它能将当前系统的包裹分拣错误率大幅降低 50%。本次 MARS 人工智能大会上,除了推出 Pegasus 机器人,亚马逊还发布了一种大型模组化运输机器人 Xanthus。依据上方安装的模组,执行多种不同的任务 Xanthus 拥有透过改变上方配备,胜任不同任务的能力。相较过 去使用的系统, Xanthus 不仅用途更为广泛,体积也只有前辈的 1/3,成本甚至直接砍半。

机器人平台 。 如何将机器人技术落地、实践商业化一直是备受关注的问题。波士顿动力的策略是要希望其成为平台公司,通过授权或开源方式, 使其技术能被广为被使用。2018 年这个传言似乎得到了证实,在《连线》杂志举办的峰会上,波士顿动力创始人暨首席执行官 Marc Raibert 指出,他们的定位是成为平台公司,让生态圈包括第三方伙伴、客户,一起来找到技术真正适合使用的地方。 Marc Raibert 表示波士顿动力在开发机器人时是以“平台”的概念来出发,客户可以增加硬件,例如手臂及其他组件,“当然,我们也可以针对单一领域打造一个有特殊应用的机器人方案,但我们不知道哪一个领域合适,所以我们从平台的角度出发,希望生态圈帮我们一起来找到技术真正可落地之处”、“我们要打造的是‘通用用途的平台’(general purpose platform),让第三方伙伴、客户、波士顿动力自己的应用开发团队,可以一同来设计产品以符合定制化需求。

十、 数据库技术

数据库是按一定的结构和规则组织起来的相关数据的集合, 是综合各用户数据形成的数据集合,是存放数据的仓库(我国数据库的发展现状与趋势—陈黎)。随着计算机技术与网络通信技术的快速发展,数据库技术已经成为当今信息社会中对大量数据进行组织与管理的重要技术手段,是网络信息化管理系统的基础。目前,新一代数据库系统不仅保持和继承了传统数据库系统的各项功能,支持知识管理、数据管理和对象管理,而且还对其它应用系统开放,在网络上支持标准网络协议,具有良好的可连接性、可移植性、可互操作性和可扩展性。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为数据库领域全球学者分布情况:

▲数据库领域全球学者分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。从该地图可以看出,美国的人才数量优势明显且主要分布在其东西海岸;欧洲也有较多的人才分布;亚洲的人才主要集中在我国东部;其他诸如非洲、南美洲等地区的学者非常稀少;数据库领域的人才分布与各地区的科技、经济实力情况大体一致。

我国专家学者在数据库领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是珠三角和长三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等地相比,中国在数据库领域学者数量较多但差距不大。

▲数据库领域中国学者分布

优秀论文:

论文题目: Self-Driving Database Management Systems

中文题目: 自动驾驶的数据库管理系统

论文作者: Andrew Pavlo, Gustavo Angulo, Joy Arulraj and, Haibin Lin, Jiexi Lin, Lin Ma, et al.

论文出处: 7th Biennial Conference on Innovative Data Systems Research (CIDR) – CIDR 2017

论文地址: https://www.pdl.cmu.edu/PDL-FTP/Database/p42-pavlo-cidr17.pdf

研究问题: 在过去的二十年中,研究人员和数据库系统供应商都尝试开发了各式辅助工具以在数据库系统的调优和物理设计等各个方面协助数据库管理员( Database Administrator, DBA)。但是,大多数的工作还是不足够完善的,因为它们仍然需要 DBA 对数据库的任何更改做出最终决定,并且是在问题发生后解决问题的反应性措施。尤其是随着云数据库的发展,不需要人工干预的 DBMS 就成为了一个迫切的需求,于是能“自动驾驶”的数据库管理系统(Database Management System, DBMS)便成为了必然的选择。真正地能“自动驾驶”的数据库管理系统所需要的是一种为自治操作而设计的新体系结构。与早期的各种 DBMS 不同的是,该类系统的所有方面都由集成的计划组件控制,该组件不仅可以针对当前工作负载(Workload)优化系统,而且还能预测未来的工作负载的变化趋势,以便系统可以相应地进行准备。这样, DBMS 可以支持所有以前的调优技术,而无需人工确定正确的方式和适当的时间来部署它们。

步入大数据时代,面对 PB 乃至 EB 级海量数据、复杂多变的应用场景、异构的硬件架构和层次不齐的用户使用水平,传统的数据管理技术难以满足新时代的需求。例如,一个云数据库系统通常具有百万级别的数据库实例,每一个数据库实例通常都有各自的应用场景、不同用户的使用水平往往也有着比较大的差别,数据库中传统的启发式算法在这些场景中难以取得较好的效果,而有经验的数据库管理员也难以直接干预和优化数量如此之多的数据库实例。

近年来,以机器学习为代表的人工智能技术因其强大的学习和适应能力,在多个领域都大放异彩。同样的,在数据管理领域,传统机器学习和深度学习等技术也有着巨大的潜力和广阔的应用前景。例如,数据库系统所积累的海量历史查询记录可以为基于学习的数据库智能优化技术提供数据支撑。一方面,我们可以构建包含查询、视图或数据库状态的有标签数据,比如,在视图选择问题中,这个标签是指每个候选视图是否被选中。

另一方面,在缺乏标签数据的时候,我们可以利用(深度)强化学习技术探索性地(从选择结果的反馈中学习)选择最优的候选视图。此外,人工智能技术让自治数据库的自动决策管理、自动调优和自动组装等需求成为可能。在以深度学习为代表的人工智能技术的加持下,让数据库朝着更加智能的方向发展,数据管理技术也随之智能化。近些年涌现的自治数据库和人工智能原生数据库(如 SageDB, XuanyuanDB),通过融合人工智能技术到数据库系统的各个模块(优化器、执行器和存储引擎等)和数据管理的生命周期,可以大幅度提升数据库各方面的性能,为下一代数据库和人工智能技术的发展指明了一个方向。

在另外一方面,数据管理技术也能以基础设施的身份来支持人工智能的发展。目前的人工智能在落地过程中还面临着一些挑战性。例如,人工智能算法训练效率较低,现有人工智能系统缺少执行优化技术(如大规模缓存、数据分块分区、索引等),不仅会导致大量的计算、存储资源浪费,而且会提高程序异常的发生率(如内存溢出、进程阻塞等),严重影响单个任务的执行效率。其次,人工智能技术往往依赖高质量的训练数据,现实中的训练数据往往是包含很多缺失值、异常值和别名等类型的错误,这些错误通常会影响训练效率,对模型的质量造成干扰。面向人工智能的数据管理技术可以为解决上述挑战做出贡献。

十一、 可视化技术

可视化技术是把各种不同类型的数据转化为可视的表示形式,并获得对数据更深层次认识的过程。可视化将复杂的信息以图像的形式呈现出来,让这些信息更容易、快速地被人理解,因此,它也是一种放大人类感知的图形化表示方法。

可视化技术充分利用计算机图形学、图像处理、用户界面、人机交互等技术,以人们惯于接受的表格、图形、图像等形式,并辅以信息处理技术(例如: 数据挖掘、机器学习等)将复杂的客观事物进行图形化展现,使其便于人们的记忆和理解。可视化为人类与计算机这两个信息处理系统之间提供了一个接口,对于信息的处理和表达方式有其独有的优势,其特点可总结为可视性、交互性和多维性。

目前,数据可视化针对不同的数据类型及研究方向,可以进一步划分为科学数据可视化、信息可视化,以及可视分析学三个子领域。这三个领域既紧密相关又分别专注于不同类型的数据及可视化问题。具体而言,科学可视化是针对科学数据的可视化展现技术。科学数据,例如,医疗过程中由 CT 扫描生成的影像数据、风洞实验而产生的流体数据、以及分子的化学结构等,是对物理世界的客观描述,往往是通过科学仪器而测量得到的数据。

这类数据的可视化主要关注于如何以清晰直观的方式展现数据所刻画的真实物理状态。因此,科学可视化往往呈现的是三维场景下的时空信息。信息可视化注重于如何以图形的方式直观展现抽象数据,它涉及到了对人类图形认知系统的研究。在这里,抽象数据(例如: 图形数据、多维度数据、文本数据等)往往是对各应用领域所产生数据的高层次概括,记录的是抽象化的信息。针对这样的数据,信息可视化着眼于多维度信息的可视编码技术,即如何以低维度(2D) 的图形符号来直观展现并揭示抽象数据中所隐藏的潜在规律与模式;可视分析学是多领域技术结合的产物,旨在结合并利用信息可视化、人机交互、以及数据挖掘领域的相关技术,将人的判断与反馈作为数据分析中重要的一环,从而达到精准数据分析、推理及判断的目的。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为可视化领域全球学者分布情况:

▲ 可视化领域全球学者分布

我国专家学者在可视化领域的分布如下图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏, 这种分布与区位因素和经济水平情况不无关系。 同时,通过观察中国周边国家的学者数量情况,特别是与日韩等地相比,中国在可视化领域学者数量较多但差距较小 。

▲可视化领域中国学者分布

优秀论文:

论文题目: Visual Exploration of Big Spatio-Temporal Urban Data: A Study of NewYork City Taxi Trips

中文题目:城市大时空数据的可视化研究:纽约市出租车出行研究

论文作者: Nivan Ferreira, Jorge Poco, Huy T. Vo, Juliana Freire, Cláudio T. Silva

论文出处: IEEE Transactions on Visualization and Computer Graphics, 2013

论文地址: https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=6634127&tag=1

研究问题: 出租车数据是城市中极具价值的信息,收集并利用好出租车的数据可以有效的帮助决策者和社会学家理解城市的状况并做出正确的决策。但高效的探索出租车数据其实是一个充满挑战的事情。出租车数据十分复杂且庞大,包含了时间和空间上的信息,很难快速查询并进行比较。在采访城市规划和交通专家后,该文作者了解到,他们目前没有合适的工具来完成分析。一些简单的工具和语言只能分析一些小规模的数据,能分析的数据比较片面;而复杂一些的工具,虽然可以对大数据进行分析,则需要掌握高级的数据查询语言,对分析人员而言很困难。所以该文提出了一种支持在起点–终点(OD)数据上进行复杂时空可视化查询的模型。

可视化语法及工具 。 随着大数据时代的到来,可视化已经成为一个必不可少的工具。现有的可视化软件及工具,可用于设计可视化应用程序和构建可视化分析系统,有助于可视化的广泛使用。为了减少制作可视化的技术负担,一些可视化工具提供了声明性语法,其中包括了 Vega-Lite 和 P5。声明性语法可以将可视化设计与执行细节分离,这使分析人员可以专注于特定于应用程序的设计决策。同时 Vega-Lite 和 P5都提供了易于使用的编程接口。

Vega-Lite 是一套能够快速构建交互式可视化的高阶语法,它是基于 Vega 和 D3 等底层可视化语法的上层封装。相比于其它比较底层可视化语法, Vega-Lite 可以通过几行 JSON 配置代码即可完成一些通用的图表创建,而相反地,想要用 D3 等去构建一个基础的统计图表则可能需要编写多行代码,如果涉及到交互的话代码量更是会大大增加。 P5 是一个基于 Web的可视化工具包,它能集成了 GPU 计算与渐进式处理,并且提供了带有声明性语法的 API,可用于指定渐进式数据转换和可视化操作,从而帮助分析人员构建融合了高性能计算和渐进式分析工作流的可视化系统。

可视化与故事叙述 。 故事叙述是可视化研究的一个重要且新兴的方向。 与传统的、 强调数据分析的可视化思路不同,故事叙述强调数据的传达与沟通, 强调数据与人(且通常是普通人)的连结。在此思路下, 研究者们致力于探究: 何种数据呈现与讲述技巧,可以使数据具备吸引力、 记忆度;数据故事的创作流程是怎样的,存在哪些需求和痛点;以及如何自动生成数据故事等等。 用讲故事的方式来呈现可视化,本质上是体现了一种人本导向,即以人的需求出发,提取和分析数据,并以对人友好的方式,将数据中的信息传达出去。随着我们的社会越来越依赖数据赋能,更好地构建数据与人的关系,将成为一条必经之路。叙述可视化的应用,不仅在于那些以“叙述”为主业的领域,如新闻媒体、广告宣传,更在于需要用数据来影响人、说服人、打动人的各行各业。对于研究者来说,相关的研究方向则包括可视化设计、人机交互、认知与感知、智能生成与推荐等等。

可视化的自动生成 。 数据可视化领域中大多数的可视化生成系统往往是基于数据的交互式探索,也包括商业领域的知名的可视化工具 Tableau 和 PowerBI。而近些年来,为了避免繁杂的数据分析步骤并提升用户效率,可视化的自动生成逐渐成为行业领域中的研究热点。一系列基于规则和机器学习的推荐方法层出不穷,在自动生成可视化的最新研究中,研究者希望在保证准确表现数据的同时,也能将视觉设计的因素考虑在内,确保可视化的美观性和数据的表现力。

例如, DataShot 和 Text-toViz,分别从数据和自然语言两个角度去自动生成富有设计感的数据可视化,前者直接从表格数据生成信息简报,后者根据用户的自然语言输入生成对应的信息图。制作一个有效且美观的数据可视化往往需要跨专业领域的技能,尤其是需要同时具备数据分析能力和平面设计能力,而这对于一个没有专业训练的普通用户来说是比较困难的。 DataShot 和 Text-to-Viz 等前沿的技术研究均通过自动化的方法从数据洞察和设计美学两个方面帮助用户生成可视化,降低用户制作可视化的门槛,并有效提高生产效率。

可解释性深度学习 。 LSTMVis 是一个递归神经网络的可视化分析工具,它着重于对 RNNs 中的隐藏特征进行可视化分析。 LSTMVis 结合了一个基于时间序列的选择界面和一个交互式的匹配工具来搜索大型数据集中相似的隐藏状态模式。系统的主要功能是理解模型中动态变化的隐藏状态。该系统允许用户选择一个假设的输入范围来关注局部的改变,将这些状态改变与大型数据集中类似的模式进行匹配,并将这些选择出来的模式进行对齐分析。

RNNs 在序列建模方面有着重要的作用,但是模型中的隐藏层含义很难被解释清楚。对于一个完成训练的 RNN 模型,分析人员并不清楚这个模型是如何理解序列中不同节点之间的关系的。 LSTMVis 能够帮助用户交互式地探索 RNN 模型复杂的网络结构,并将模型中抽象表示的隐藏层信息与人类可理解的原始输入进行关联。

随着 21 世纪大数据的兴起和发展,大数据可视化广泛应用于各个领域,本节重点介绍其中的社交媒体可视化、医疗信息可视化和体育数据可视化。 社交媒体,比如最近几年非常流行的 Twitter、 Facebook、微博。它们可以作为强大的在线交流平台,允许数百万用户在任何时间、任何地点产生、传播、共享或交换信息。这些信息通常包括多种多媒体内容,如文本、图像和视频。在社交媒体上传播的大量多媒体数据,涵盖了全球范围内大规模和实时发生的社会动态信息, 这种现象为社交媒体可视化提供了很多机会。

社交媒体技术层面上的可视化,主要包括: 基于关键字方法的可视化, 基于主题方法的可视化和多元方法的可视化。 现有的研究大多集中于集体行为的可视化,这类研究的主题包括: 信息扩散的可视化,社会竞争与合作的可视化,人的流动性的可视化。

社交媒体数据的可视化分析正在迅速发展,每年都有大量的新方法出现。然而,该领域仍处于起步阶段,面临许多挑战和悬而未决的问题。许多挑战不能仅 结合的多学科研究,将带来处理和理解社交媒体数据会有更强大、更可行的方法和技术。

十二、 数据挖掘

数据挖掘(Data Mining),是指从大量的数据中自动搜索隐藏于其中的有着特殊关系性的数据和信息,并将其转化为计算机可处理的结构化表示,是知识发现的一个关键步骤。数据挖掘的广义观点:从数据库中抽取隐含的、以前未知的、具有潜在应用价值的模型或规则等有用知识的复杂过程,是一类深层次的数据分析方法。数据挖掘是一门综合的技术,涉及统计学、数据库技术和人工智能技术的综合,它的最重要的价值在于用数据挖掘技术改善预测模型。

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为数据挖掘领域全球学者分布情况:

▲数据挖掘领域全球人才部分

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。从该地图可以看出,美国的人才数量遥遥领先且主要分布于其东西海岸;欧洲、亚洲也有较多的人才分布;其他诸如非洲、南美洲等地区的学者非常稀少;可视化领域的人才分布与各地区的科技、经济实力情况大体一致。

我国专家学者在数据挖掘领域的分布如上图所示。通过下图我们可以发现,京津地区在本领域的人才数量最多,其次是珠三角和长三角地区,相比之下,内陆地区的人才较为匮乏,这种分布与区位因素和经济水平情况不无关系。同时,通过观察中国周边国家的学者数量情况,特别是与日本、东南亚等亚洲国家相比,中国在数据挖掘领域学者数量较多且有一定的优势。

▲数据挖掘领域中国学者分布

优秀论文: 论文题目: Graph Convolutional Neural Networks for Web-Scale Recommender Systems

中文题目:图卷积神经网络应用于网络规模推荐系统

论文作者: Rex Ying, Ruining He, Kaifeng Chen, Pong Eksombatchai, William L. Hamilton, and Jure Leskovec.

论文出处: In Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (KDD ’18) .

论文地址: https://dl.acm.org/citation.cfm?doid=3219819.3219890

研究问题: 图结构数据作为深层神经网络最新研究成果应用于推荐系统基准的最新的指标,传统的深度学习网络主要针对图片,语音等欧氏空间内规则型数据,但是现实中存在很多不是欧氏数据, 它们的结构不规则,难以用卷积神经网络对其进行结构信息的聚合,故将其扩展到有数十亿用户的网络级推荐系统是一个巨大的挑战。

近几年,我们已经迎来了大数据时代,各大互联网企业每天都在产生数以亿计的数据。各类数据往往都隐含着一些有价值的信息, 如果人们手动地进行数据分析,往往需要耗费大量的时间。同时,大量未经处理的数据可能会被人们所忽视。数据挖掘就是想自动地从大规模的数据中挖掘出有意义的知识或者模式。这里,我们将数据挖掘领域近期的主要发展归为两大类:复杂数据挖掘、分布式数据挖掘。

复杂数据包括序列数据、图数据等。在序列数据挖掘中,基于注意力(Attention)机制的 Transformer 模型表现出了巨大的潜力,在机器翻译等任务上取得了非常好的效果。随后, BERT 模型使用双向 Transformer 通过预训练方式在各种自然语言处理的任务上都达到了当时最好的结果。在图数据挖掘研究中,网络表示学习仍然是近年来非常热门的话题。从 DeepWalk 算法开始,基于随机游走的算法在无监督的表示学习任务中表现良好。 NetMF 算法将几种基于随机游走的算法统一写成了矩阵分解的形式,给网络表示学习算法提供了理论基础。图卷积神经网络是另一种处理图数据的有效方法,借鉴了图谱论中的图卷积并使用图的拉普拉斯矩阵,在半监督的节点分类任务和图分类任务中都表现出很好的效果。除此之外,异构网络的表示与挖掘也逐渐被大家所关注。

分布式数据挖掘已成为数据挖掘领域非常有前途的方向。随着数据挖掘计算成本的增加和数据隐私保护的问题,分布式数据挖掘开始备受关注。分布式数据挖掘利用分布式站点的资源来降低计算成本并增强数据保密性。由于分布式数据挖掘采用了不同的计算方式,传统的数据挖掘技术很难直接应用于分布式数据挖掘。目前,数据安全与数据隐私开始被大家所关注。 2018 年 5 月,通用数据保护条例(GDPR)在欧盟正式生效, 这也使得基于隐私保护的分布式数据挖掘方法逐渐被研究者所重视。

数据挖掘已经被广泛地应用于各类实际问题,包括金融数据分析、推荐系统等。数据挖掘相关研究需要结合实际问题,注重与机器学习、统计学科等的交叉,从大数据中挖掘出有价值的信息。

十三、 信息检索与推荐

R.Baeza-Yates 教授在其著作《现代信息检索中 》中指出 ,信息检索(Information Retrieval, IR)是计算机科学的一大领域,主要研究如何为用户访问他们感兴趣的信息提供各种便利的手段,即:信息检索涉及对文档、网页、联机目录、结构化和半结构化记录及多媒体对象等信息的表示、存储、组织和访问,信息的表示和组织必须便于用户访问他们感兴趣的信息。

在范围上,信息检索的发展已经远超出了其早期目标,即对文档进行索引并从中寻找有用的文档。如今,信息检索的研究包括用户建模、 Web 搜索、 文本分析、 系统构架、 用户界面、 数据可视化、 过滤和语言处理等技术。

信息检索的主要环节包括信息内容分析与编码、组成有序的信息集合以及用户提问处理和检索输出。其中信息提问与信息集合的匹配、选择是整个环节中的重要部分。当用户向系统输入查询时,信息检索过程开始,接着用户查询与数据库信息进行匹配。返回的结果可能是匹配或不匹配查询,而且结果通常被排名。大多数信息检索系统对数据库中的每个对象与查询匹配的程度计算数值分数,并根据此值进行排名,然后向用户显示排名靠前的对象。

推荐系统(Recommendation System, RS)是指信息过滤技术,从海量项目(项目是推荐系统所推荐内容的统称,包括商品、新闻、微博、音乐等产品及服务)中找到用户感兴趣的部分并将其推荐给用户,这在用户没有明确需求或者项目数量过于巨大、凌乱时,能很好地为用户服务,解决信息过载问题。

一般推荐系统模型流程通常由 3 个重要的模块组成:用户特征收集模块,用户行为建模与分析模块,推荐与排序模块。推荐系统通过用户特征收集模块收集用户的历史行为,并使用用户行为建模和分析模块构建合适的数学模型分析用户偏好,计算项目相似度等,最后通过推荐与排序模块计算用户感兴趣的项目,并将项目排序后推荐给用户。

信息的检索与推荐都是用户获取信息的手段,无论是在互联网上,还是在线下的生活场景里,这两种方式都大量并存,两者之间的关系是互补的:搜索引擎需要用户主动提供准确的关键词来寻找信息,因此不能解决用户的很多其他需求,比如当用户无法找到准确描述自己需求的关键词时,搜索引擎就无能为力了。和搜索引擎一样,推荐系统也是一种帮助用户快速发现有用信息的工具。

与搜索引擎不同的是,推荐系统不需要用户提供明确的需求,而是通过分析用户的历史行为给用户的兴趣建模,从而主动给用户推荐能够满足他们兴趣和需求的信息。因此,从某种意义上说,推荐系统和搜索引擎对于用户来说是两个互补的工具。搜索引擎满足了用户有明确目的时的主动查找需求,而推荐系统能够在用户没有明确目的的时候帮助他们发现感兴趣的新内容。在实际生活中也有很多运用。

同时,信息的检索与推荐也有着一定的区别,可以分为以下几个方面: 首先是主动与被动的不同。搜索是一个非常主动的行动,用户的需求也十分明确,在搜索引擎提供的结果里,用户也能通过浏览和点击来明确的判断是否满足了用户需求。然而,推荐系统接受信息是被动的,需求也都是模糊而不明确的。

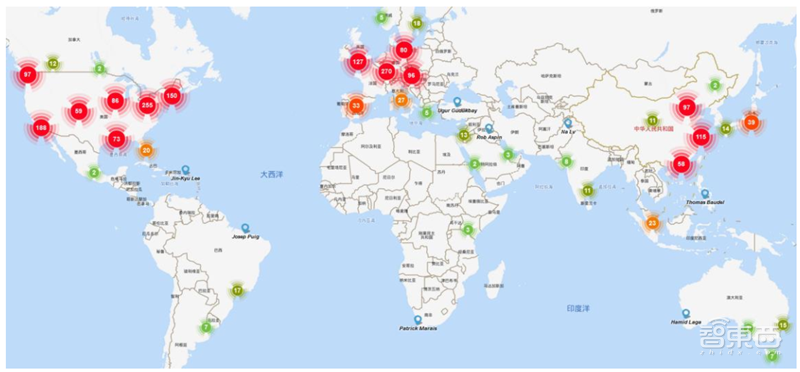

学者地图用于描述特定领域学者的分布情况,对于进行学者调查、分析各地区竞争力现况尤为重要,下图为信息检索与推荐领域全球学者分布情况:

▲信息检索与推荐领域全球人才分布

地图根据学者当前就职机构地理位置进行绘制,其中颜色越深表示学者越集中。从该地图可以看出,美国的人才数量优势明显且主要分布于其东西海岸;欧洲、亚洲也有较多的人才分布;其他诸如非洲、南美洲等地区的学者非常稀少;信息检索与推荐领域的人才分布与各地区的科技、经济实力情况大体一致。 此外,在性别比例方面,信息检索与推荐领域中男性学者占比 90.6%,女性学者占比9.4%,男性学者占比远高于女性学者。

▲信息检索与推荐领域中国学者分布

我国专家学者在信息检索与推荐领域的分布如上图所示,从中可以发现京津地区在本领域的人才数量最多,其次是长三角和珠三角地区,相比之下,内陆地区的人才较为匮乏,这种分布与区位因素和经济水平情况不无关系。同时,通过观察中国周边国家的学者数量情况,特别是与日韩、东南亚等地相比,中国在信息检索与推荐领域学者数量较多且优势较大。

优秀论文:

论文题目: Adversarial Personalized Ranking for Recommendation

中文题目:对抗式个性化推荐排名

论文作者: Xiangnan He, Zhankui He, Xiaoyu Du anTat-Seng Chua.

论 文 出 处 : The 41st International ACM SIGIR Conference on Research & Development in Information Retrieval – SIGIR ’18

论文地址: https://arxiv.org/pdf/1808.03908.pdf

研究问题: 贝叶斯个性化排名(Bayesian Personalized Ranking, BPR)是一种成对学习的排序方法,用于优化个性化排序的推荐模型。它以内隐反馈学习为目标,假定观察到的交互比未观察到的交互排在更高的位置。矩阵因子分解( MatrixFactorization, MF)是最基本也是最有效的推荐模型。 MF 将每个用户和项表示为嵌入向量,通过嵌入向量之间的内积来估计用户对某一项的偏好程度。在信息检索领域,贝叶斯个性化排名训练的矩阵分解模型(MF-BPR)学习一个与训练数据相适应的复杂函数,不能很好地泛化,且其鲁棒性较差,易受参数的对抗性扰动。因此本文提出了一种新的个性化排名训练方法-对抗的个性化排名(Adversarial Personalized Ranking, APR)。

随着互联网中数字信息数量的增长,商品、书籍、新文章、歌、电影、研究文件等日常基础性事物,其数量和种类填满了多个数据仓库和数据库。蕴含着智能推荐系统和强大的搜索引擎的在线商店、在线音乐、在线视频和图片库等已成为人们快速寻找信息的主要方式。此类系统的流行程度和有用性在于它们能够便捷地显示几乎无限的物品信息。比如, Amazon、 Netflix 等推荐系统尝试了解用户兴趣,并向用户推荐他们感兴趣的商品。尽管这些系统由于使用场景而各不相同,但其寻找用户感兴趣商品的核心机制都是用户兴趣与商品匹配的机制。

为了提高信息检索与推荐系统中算法模型的准确性和可解释性,研究人员近年来主要关注无偏的在线排序学习模型,以及利用知识信息增强推荐系统的表现和可解释性等方面的研究。其中,无偏的在线排序学习模型是指自动利用大规模用户点击数据训练搜索结果的排序模型。用户点击数据是现代搜索引擎的重要数据来源,具有成本低廉,并且对以用户为中心的检索应用程序(如搜索排名) 特别有用等优点。

为了充分利用用户点击数据开发一个无偏的学习排名系统,研究人员试图消除用户偏见对排名模型训练的影响。近年来,一种基于反事实学习和图形模型的无偏学习排名框架引起了人们的广泛关注。该框架侧重于使用反事实学习直接训练带有偏倚点击数据的排名模型。这个无偏的学习排名框架对待点击偏差作为一个反事实的影响和去偏用户反馈加权每点击与他们的反向倾向加权。它使用倾向性模型来量化点击的偏差,并没有明确地估计查询文档与培训数据的相关性。研究人员从理论上证明,在正确的偏差估计下,在该框架下使用点击数据训练的排序模型将收敛于使用真实相关信号训练的排序模型。

信息检索与推荐系统可以为用户推荐其感兴趣的内容并给出个性化的建议。而现在的推荐系统大都着眼于被推荐对象的序列建模,而忽略了它们细粒度的特征。为了解决以上问题,研究人员提出了多任务可解释推荐模型( Multi-Task Explainable Recommendation, MTER)和知识增强的序列推荐模型(Knowledgeenhanced Sequential Recommender, KSP)。其中, MTER 模型是一个用于可解释推荐任务的多任务学习方法,通过联合张量分解将用户、产品、特征和观点短语映射到同一向量空间,来从用户评论中提取产品细粒度的个性化特征。 KSR 模型提出了利用结合知识库的记忆网络来增强推荐系统的特征捕获能力与解释性,解决序列化推荐系统不具有解释性,且无法获取用户细粒度特征的不足。 MTER 和KSR 模型通过对推荐结果的解释,分析被推荐对象的特征,可以让用户可以对使用哪些推荐结果做出更明智,更准确的决策,从而提高他们的满意度。

近年来,信息检索与推荐领域比较流行的开源平台主要包括基于深度学习的检索模型(MatchZoo)、基于 tensorflow 的 learning to rank 模型(TF-Ranking)和 microsoft recommenders。其中, MatchZoo 是由中国科学院计算技术研究所网络数据科学与技术重点实验室近期发布的深度文本匹配开源项目。 MatchZoo 是一个 Python 环境下基于 TensorFlow 开发的开源文本匹配工具,使用了 Keras 中的神经网络层,并有数据预处理,模型构建,训练与评测三大模块组成, 旨在让大家更加直观地了解深度文本匹配模型的设计、更加便利地比较不同模型的性能差异、更加快捷地开发新型的深度匹配模型。

MatchZoo 提供了基准数据集(TRECMQ 系列数据、 WiKiQA 数据等)进行开发与测试,整合了当前最流行的深度文本匹配的方法(包括 DRMM, MatchPyramid, DUET, MVLSTM, aNMM, ARC-I,ARC-II, DSSM, CDSSM 等算法的统一实现),旨在为信息检索、数据挖掘、自然语言处理、机器学习等领域内的研究与开发人员提供便利, 可以应用到的任务场景包括文本检索,自动问答,复述问题,对话系统等等。

TF-Ranking 是一个可扩展的基于 tensorflow 的用于排序的库,由 google 于2018 年提出。 TF-Ranking 提供了一个统一的框架,其中包括一套最先进的学习排序算法,并支持成对或列表损失函数、多项评分、排序度量优化和无偏学习排序。 TF-Ranking 速度很快并且易于使用,可以创建高质量的排序模型。 统一的框架使机器学习的研究人员、实践者和爱好者能够在一个库中评估和选择一系列不同的排序模型。

此外,这个开源库不仅提供了合理的默认模型,还可以让用户能够开发自己的定制模型,且提供了灵活的 API,用户可以在其中定义和插入自己定制的损失函数、评分函数和指标。 Microsoft Recommenders 是微软云计算和人工智能开发团队与微软亚洲研究院团队深度合作,基于多年来各类大型企业级客户的项目经验以及最新学术研究成果,搭建的完整推荐系统的最新实操技巧开源项目。该项目有效解决了定制和搭建企业级推荐系统中的几个难点,包括如何将学术研究成果或开源社区提供的范例适用于企业级应用、如何集成信息检索与推荐领域的学习指导资源俩协助从业人员深入理解并实际搭建完整推荐系统、如何选择最优算法以应对具体应用场景等。

为了协助信息检索与推荐领域的算法模型的训练和优化,微软公司提供了一个大规模支持机器阅读理解和问答系统等多种领域研究的数据集,简称 MSMACRO。该数据集从必应(bing)的搜索查询记录中取样,每个问题都有人工生成的答案和完全人工重写的答案。此外,数据集包含从通过 bing 检索的 web文档中提取的百万个密码,这些密码提供了管理自然语言答案所需的信息。

使用这个数据集,本文提出三个不同层次的难度不同的任务: (i) 根据一组上下文段落预测一个问题是否可以回答,然后像人类一样提取和合成答案(ii) 基于根据问题和段落语境信息可以被理解的上下文段落,来生成格式良好的答案(如果可能) , 最后(iii) 根据给定的一个问题,对检索得到的段落进行排序。数据集的大小和问题来自真实用户搜索查询的事实,该数据集的规模和真实世界的性质使它对基准测试机器阅读理解和问答模型具有吸引力。

智东西认为,从清华大学该报告可以看出,现阶段人工智能人才总的来看美国的人才数量遥遥领先,我国人才数量在大部分领域领跑第二梯队,但与位居首位的美国相比,中国高影响力学者数量明显不足,顶尖学者相对匮乏,中美之间还存在较大的赶超空间。当前,人工智能已经成为引领新一轮科技革命和产业变革的战略性技术,我国在人工智能领域的科学技术研究和产业发展,起步稍晚于以美国为代表的发达国家,但是,在最近十余年的人工智能爆发发展期我国抓住了机遇,进入了快速发展阶段。在这个阶段,能够推动技术突破和创造性应用的高端人才对人工智能的发展起着至关重要的作用。

权威数据·专业解读 读懂智能行业必看的报告在智东西回复“智能内参”查看全部报告