智东西(公众号:zhidxcom)

作者 | 心缘

编辑 | 漠影

“刷脸”时代,安全何在?

此前据央视调查,在某些网络交易平台上,只花2元就能买到千张人脸照片,5000多张人脸照片标价还不到10块钱。今年9月,广西南宁的十几名业主在不知情的情况下,被一位置业顾问以刷脸卖房的方式骗走了逾千万元。

从手机号码、身份证号、地址等文字信息,到指纹、人脸等生物信息,再到线上搜索、消费、驾驶路线等行踪的数据信息,当人们越来越多的数据被采集,当AI算法与生活的联系更加紧密,人们愈发担忧数据泄露与算法被攻击所引发的安全风险。

如今飞速发展的人工智能(AI)应用中,依赖海量数据、不具有确定性的深度学习算法仍是主旋律。在上周三的2020第三代人工智能产业论坛上,清华大学人工智能研究院院长、中国科学院院士张钹教授的一番言辞发人深省。他提到全球前40个AI独角兽的估值大约分布在70-500亿区间,但销量均基本不到估值的10%,也就是没有找到市场,问题出在什么地方?张钹院士认为,这里存在着算法与数据的不安全性。

纵然技术无罪,损失谁来买单?引发新一轮安全忧虑的AI,也可以成为破解安全难题的良药。

一、数据隐私、算法攻防、道德伦理……AI安全问题关山难越

在金融、医疗、公共安全等AI应用场景中,需要用到的数据往往涉及个人隐私信息,而数据的简单明文传输和利用很可能导致隐私泄露,以至造成严重后果。仅是在2020年,就发生过多起因个人信息泄露造成的诈骗案。

除了数据安全外,算法安全问题也不容小觑。

由于AI的决策逻辑和链路天然存在大量不确定性,如果不能很好地量化这种不确定性、提供可理解的决策逻辑和依据,一旦AI决策任务出错,可能引起巨大风险,乃至威胁生命安全。

要让每个决策具备极高的可靠性,更进一步是算法攻防安全。

算法普遍存在的“对抗样本”特征,导致AI系统存在被恶意攻击的风险。基于对抗样本技术,黑客可绕过整个网络和系统安全防御机制,仅通过简单伪装,就从AI算法引起的新漏洞让应用出错。

比如戴上一副“对抗样本”眼镜,就能破解手机或智能门锁的人脸识别解锁,或是伪装成他人完成银行和政务系统的身份认证,窃取财产。

穿着“对抗样本”T恤,亦可逃开监控,在目标检测算法下宛如来去自如、不被知晓的“隐形人”。

此外,AI的一些应用场景还涉及道德伦理问题。比如用深度伪造技术制作的“换脸”视频,已经被一些不法分子用到黑产;再比如AI信贷风控模型中存在对于特定地区通过率较低的“幸存者偏差”,人脸识别的种族歧视等一系列算法公平性问题,以及技术滥用引发金融欺诈,甚至是政治宣传引导舆论等等。

当恶性AI安全事件频现,如何平衡AI发展与安全保护?面对公众和企业日益关注的数据隐私保护、金融反欺诈、检测防御算法漏洞、精准甄别AI伪造素材等难题,一家名为瑞莱智慧RealAI的初创公司提出了一系列保障AI落地安全性的有效方法。

二、用AI防火墙、编译器解锁AI安全难题

瑞莱智慧RealAI孵化自清华人工智能研究院,深耕安全、可靠、可信、可扩展的第三代人工智能,已经推出涉及隐私保护、AI“防火墙”、深度伪造检测工具等多类涉及AI安全的平台产品。

在瑞莱智慧RealAI CEO田天看来,当在应用中碰到技术难题,与其见一个解决一个,不如见一个问题就看到一类问题,并通过底层技术框架、平台的突破,助力产业的升级。

经过两年多的发展,RealAI第一次公开展示其基于第三代人工智能技术手段的AI原生基础设施蓝图,覆盖算法可靠、数据安全、应用可控三个方面的安全难题。

1、提高算法可解释性的机器学习建模平台

针对金融等场景迫切需要更加可解释的建模任务的需求,RealAI去年推出RealBox可解释机器学习建模平台,目前已在多家金融机构实际使用,并通过了中国人工智能产业发展联盟的首批可信AI认证。

基于可靠可解释的AI平台和算法,可以使得智慧理财产品风险可控,提高资产配置和利用效率。

2、增强算法安全的商用AI杀毒软件和防火墙

面对算法可靠问题,RealAI开发了业内首个商用人工智能安全平台RealSafe。

这一平台相当于是针对AI算法的杀毒软件和防火墙,能对AI安全性进行全面的标准化检测和增强,已检测发现了一系列市场上主流AI产品的安全隐患,并提供了多种相应的防御升级措施。整个检测过程全界面化操作,用户无需具备专业的模型安全算法知识和编程开发经验。

大幅升级后的RealSafe2.0版本,将可评测的应用场景从人脸识别模型拓展到了目标检测、图像分类模型;在检测抗对抗样本攻击的安全性基础上,新增针对图像分类模型的后门漏洞自动化检测等功能;并提供了对抗样本去噪方法、对抗样本检测方法、对抗训练方法等安全性提升方案。

在AI安全平台的保护下,企业可提供更加安全、受保护的刷脸支付系统,从而使得刷脸门禁、刷脸门锁等产品更为安全可用。目前,RealSafe平台已在工信部重大建设项目以及某电网公司落地应用,未来将集成更多安全风险的检测能力。

3、解决数据安全问题的隐私保护AI编译器

面对数据安全问题,尤其为解决AI应用过程中的数据孤岛难题,RealAI最新推出业内首个编译级的隐私保护机器学习平台——RealSecure隐私保护机器学习平台(RSC)。

该平台结合了人工智能、密码学、分布式系统三大领域的技术突破,其核心模块“联邦AI编译器”能够自动将普通机器学习算法程序转换为分布式、隐私安全程序,大幅降低隐私安全的AI商业应用门槛。

得益于底层编译级的能力,该平台通过实现“算子盘”和“数据流图”两大功能,具备三大性能优势:

(1)训练速度实现30倍以上提升:在加密算法方面应用全同态技术,打破半同态技术功能与性能上的桎梏,性能提升2-3个数量级;在AI算法优化方面,收敛速度更快,迭代次数少。

(2)白盒可验证的安全性:以首创数据流图形式,将所有中间计算过程安全透明的展现给用户,内部算子执行完全公开,实现安全透明的隐私保护通讯协议。

(3)易用性:摆脱重复改写的繁琐工作,处理方式由“雕版印刷”转变为“活字印刷”。

这使得金融等场景在合规、隐私保护的前提下,可实现基于多方数据联合建模,从而显著提高智能风控、反欺诈、小微普惠、精准营销、AI医疗等智慧决策应用的效果。

4、精准判断AI深度伪造内容的检测工具

面对应用可控问题,RealAI推出DeepReal深度伪造检测工具和一体机,能高效精准地判断视频、图片等内容素材是否是经过AI伪造生成的,避免相应舆情。DeepReal入选了国家工信安全中心人工智能优秀产品,基于其核心技术,RealAI获得了GeekPwn2020年深度伪造检测项目冠军。

这一深伪检测能力,可以帮助公共安全部门,提高对各个渠道虚假内容的管控能力,防范相应传播风险。

三、针对不同行业的差异化智能方案

在商业模式上,RealAI将其AI基础能力与对行业业务的理解、对产业智能化升级方法论的认识做结合,打造了针对不同行业的智能化产品和解决方案。

例如在金融风控场景中,数据有偏问题是一个突出问题,传统建模过程中用到的数据都是经过层层筛选、最终跑过整个借贷业务流程的“好”样本,以及他们的贷后表现标签。而如何评估没有贷后表现的拒绝客群、挖掘其中的优质客户一向是行业难题。RealAI采用自研半监督回捞模型,大幅提高对拒绝客群质量的识别能力,实现捞回客群与原风控放款客群风险一致下,帮助金融机构零成本提升10%的资产规模。

在理财场景中,需要对资产未来的流动性做出判断,以提高资产配置效率。RealAI使用贝叶斯深度学习,大幅度提高流动性预测的精度,同时降低了不确定性,避免重大预测失误,从而助力实现理财产品的动态管理模式,为基金创造了更多的可用投资资金,提高基金竞争力。

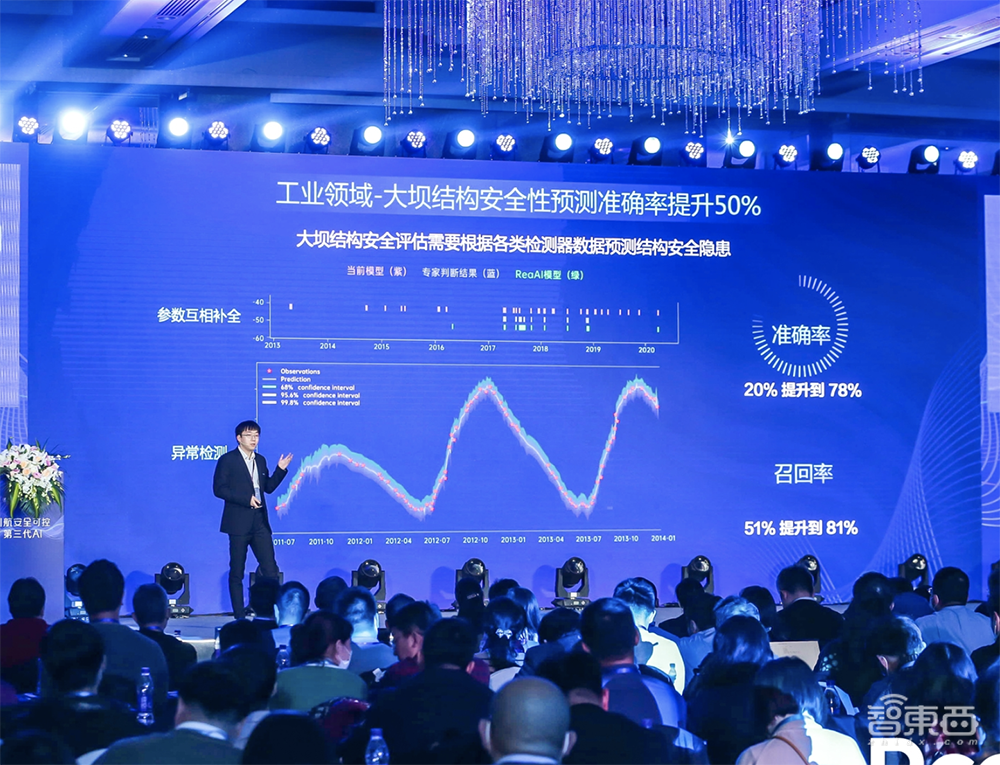

在传统基建场景中,大坝结构安全性预测需要根据各类检测器数据,来预测结构安全隐患。由于数据中噪声大,存在缺失,RealAI通过生成式模型解决数据缺失问题,参数相互补全与异常检测等,可大幅提高预测准确率。

在刷脸支付场景中,人脸识别技术往往受到对抗样本等攻击行为的威胁,RealAI用AI对抗攻击算法全面发掘人脸模型漏洞,并提供相应的防御提升方案,从而帮助提供更安全的刷脸支付系统。

瑞莱智慧RealAI CEO田天透露道,RealAI的下一步,将从研究、平台和产业赋能三方面持续发力,基于第三代人工智能技术打造AI原生基础设施,并提供针对行业的智能化产品和解决方案,加速安全、可信、可靠的产业智能化升级。

四、为什么需要迈向第三代人工智能?

如何打破现阶段AI技术的局限,兼顾人们对数据安全和算法可靠的诉求?如何从基础研究层面补齐算法短板,发展出安全、可靠、可信的AI?这是许多AI产学界学者专家,正着力寻找的答案。

今年9月,清华大学人工智能研究院院长、中国科学院院士张钹教授在《纪念《中国科学》创刊 70 周年专刊》上发表署名文章,首次全面阐述第三代人工智能的理念。

在2020第三代人工智能产业论坛中,张钹院士再次详细解读了对于第三代人工智能的观点。他认为,数据安全性主要涉及两点,一是知识产权保护,二是隐私问题;算法安全性是传统信息处理中不突出的,是人工智能特有的。

为什么算法不安全?本质性问题有三点。

第一,向量是信息的展现形式,但如果应用到涉及语义的场景,向量跟语义空间映射是多对一。

第二,语义空间不是距离空间,是离散的层次空间,而向量是一个连续的空间,两者根本对不上。比方说马和石头在语义上的相似性很低,但到了特征空间,两个词就可能距离很近,非常容易受到干扰的攻击,致使算法推广能力很差,应用场景受到很大的限制。

第三,缺少语义的基于条件概率建模的“黑箱”学习方法,对噪声攻击的安全性很差。传统信息处理噪声攻击,只能降低质量、清晰度,现在攻击算法可以让机器把一张马的照片看成一块石头。如果算法不安全、不鲁棒,则难以实际应用。

这三条导致当前AI算法存在推广能力差、很脆弱、易受噪声干扰、会犯严重错误等缺点。要解决这些问题,则需建立鲁棒和可解释的AI理论,发展安全、可信、可依赖、可扩展的AI技术,提升创新应用,也就是迈向第三代人工智能。

第三代人工智能的基本思路是将第一代人工智能的知识驱动和第二代人工智能的数据驱动结合,充分利用知识、数据、算法和算力这不可或缺的4个要素。张钹院士认为,从目前我国发展情况来看,我们更要强调知识。

如感兴趣关于第三代人工智能的更多技术思路,推荐阅读《迈向第三代人工智能》全文。

文章链接:http://scis.scichina.com/cn/2020/SSI-2020-0204.pdf

五、人工智能安全框架(2020年)蓝皮书解读

在工业和信息化部网络安全管理局的指导下,中国信息通信研究院联合瑞莱智慧、百度、腾讯、360、中科院、新工所等等多家机构,聚焦当前AI基础设施及设计研发阶段面临的安全风险,撰写了《人工智能安全框架(2020年)》蓝皮书。

据中国信通院安全所信息安全研究部主任魏薇介绍,这本蓝皮书的主要创新体现在三方面:一是针对AI风险视图缺失问题,描绘了AI全生命周期的风险地图;二是针对AI安全框架全球缺失的情况,提出了AI安全框架;三是针对AI安全技术实施缺乏指导的问题,撰写了AI安全技术蓝皮书。

该蓝皮书主要包括四个部分,第一部分介绍了AI的安全风险和技术现状,第二部分提出了AI安全框架,第三部分对详细解读如何实施AI安全技术,第四部分挑选三个重点领域介绍了AI重点应用的安全防护实践。

蓝皮书从六个方面提出AI安全目标,包括应用合法合规、功能可靠可控、数据安全可信、决策公平公正、行为可以解释、事件可以追溯等。

魏薇说,在AI安全的这些技术热点当中,联邦学习、差分隐私机器学习和深度伪造,这几个技术相对来说商用步伐最快,现在已经有工业及产业级的产品,并且在部分领域开展一些试点应用。对抗样本攻击和防御、模型和解释性等,目前主要处于学术研究转为商用应用的探索期,是全球包括麻省理工等知名高校以及微软谷歌等科技巨头竞相布局的一个重点方向。

总体而言,魏薇认为AI安全技术较多处于研究实验试用阶段,针对AI应用的成熟安全产品和服务体系目前相对较少,产学界都还在探索,希望在AI安全技术领域能有更多突破和贡献。

结语:AI产业正寻求新发展思路

在瑞莱智慧RealAI CEO田天看来,继承自互联网时代的经验,当前AI基础设施建设的重心集中在数据中心、算力平台上,主要解决AI“温饱”问题,为AI提供基础运算环境。但随着数据积累受场景限制、现有算力逼近极限,由大数据、大算力等外部驱动力带来的AI产业“第一增长曲线”开始放缓。

而实现算法可靠、数据安全、应用可控这三项能力的AI原生基础设施,将有助于驱动AI产业的“第二增长曲线”,在保证相同的数据、算力条件下,打开AI产业化全新市场空间。他提到,RealAI的目标就是补全AI原生基础设施体系。

如今AI安全的重要性日益激增,在官方报告中也被越来越多提及,我们期待看到通过更多产学研界的开放式协作,探索更多有效的AI安全技术方向,为AI产业进一步拓展良性发展与落地空间。