芯东西(公众号:aichip001)

作者 | 高歌

编辑 | 心缘

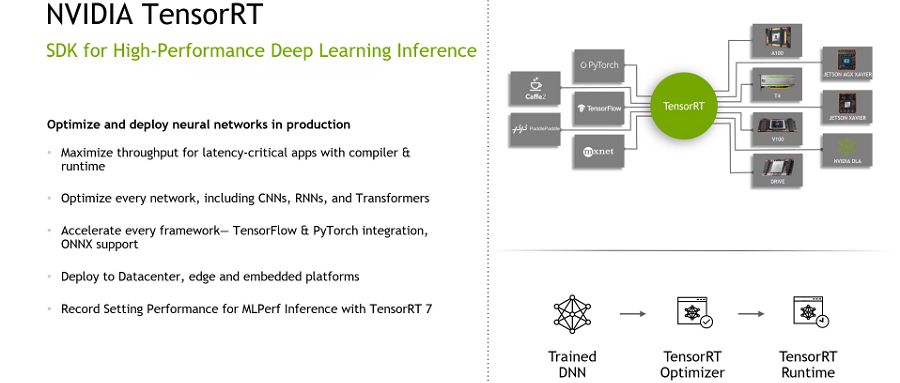

芯东西7月20日报道,今天,英伟达发布了其TensorRT的8.0版本。TensorRT可以看作是再NVIDIA各种GPU硬件平台下运行的一个深度学习推理框架,其核心是一个C++库。

开发者可以将其他框架训练好的模型转化为TensorRT格式,并通过TensorRT推理引擎提升该模型的运行速度。芯东西等媒体和英伟达AI软件部的产品管理总监Kari Briski、产品营销主管Siddharth Sharma就TensorRT 8的技术细节、应用落地等进行了深入地探讨。

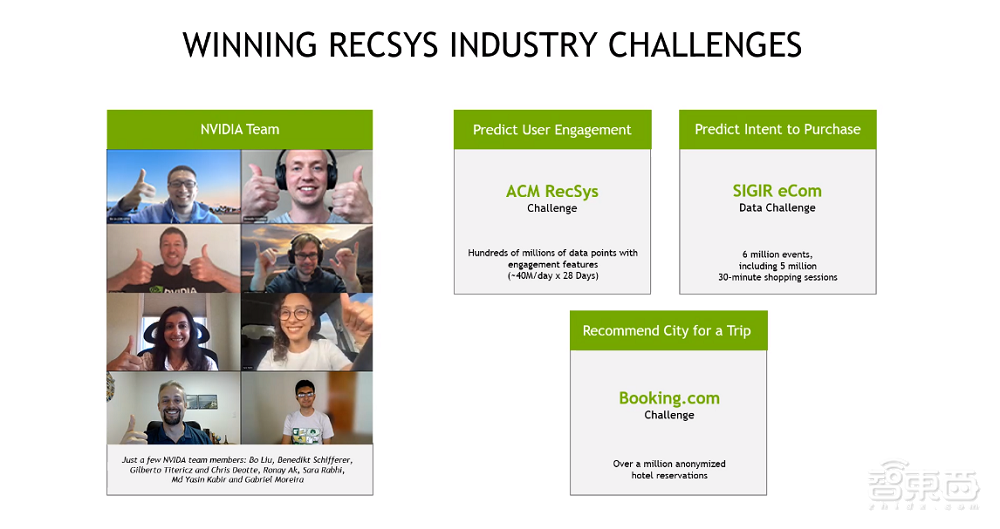

此外,Kari Briski和Siddharth Sharma也分享了英伟达团队在推荐系统竞赛中所取得的成绩。

一、运行速度和精准度提升1倍,推理延迟仅有1毫秒

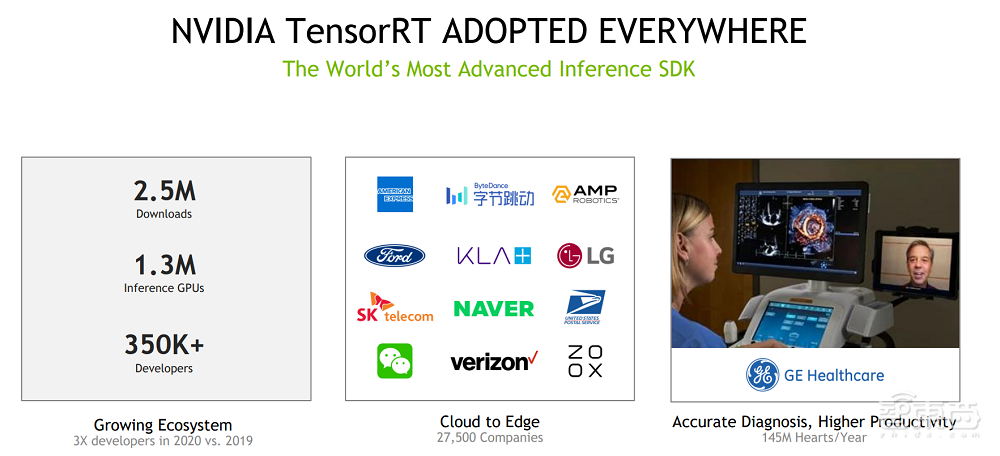

Kari Briski首先回顾了英伟达TensorRT的推出背景和成绩。她说,AI模型正在以指数级的速度增长,很多公司不得不缩减模型大小以追求响应速度。而英伟达2016年推出的TensorRT可以帮助这些企业扩大其模型规模,提升精度。5年来,已经有超过35万名开发者下载了250万次TensorRT。TensorRT 7也帮助英伟达创造了多项基准测试记录。

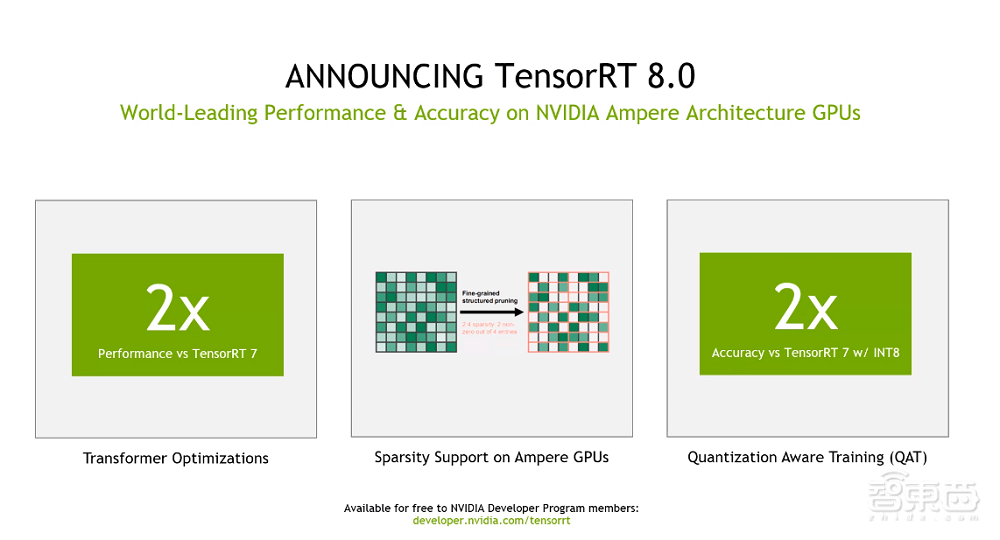

而相比7.0版本,TensorRT 8的运行速度和精准度都提升了1倍。此外,TensorRT 8还有2项较为关键的特性,提升了其AI推理性能。

第一个是稀疏性(Sparsity)技术,该技术能够提升英伟达Ampere架构GPU性能,可以在保持推理精度的同时,降低模型中的部分权重。这意味着模型所需的带宽和内存也会更小。

第二个是量化感知训练(Quantization Aware Training)。这使开发者能够利用训练好的模型,以INT8精度进行推理,既保证精度,也减少了计算和存储成本。

▲英伟达TensorRT 8提升的性能

▲英伟达TensorRT 8提升的性能

当前,开源AI公司Hugging Face和医疗方案解决商GE医疗正在应用TensorRT。

Hugging Face产品总监Jeff Boudier称,通过采用TensorRT 8,Hugging Face在BERT(预训练的语言表征模型)上的推理延迟仅有1.2毫秒。

GE医疗心血管超声首席工程师Erik Steen也谈道,当前临床医生需要花费宝贵的时间来选择和评估超声图像。TensorRT则凭借其实时推理能力,提高了GE医疗的视图检测算法性能,能够加快临床医生的工作效率。

▲英伟达TensorRT的应用

▲英伟达TensorRT的应用

二、连获3项冠军,7分钟即可完成CPU近24小时工作

除了TensorRT 8的具体细节,Kari Briski和Siddharth Sharma也分享了英伟达推荐系统团队在RecSys推荐系统数据科学竞赛中所获得的成绩。推荐系统作为计算机科学较新的分支,能够帮助互联网用户找到自己想看、想玩、想买的内容。

在本次ACM RecSys挑战赛中,Twitter会在28天内向参与者提供数百万个数据点,要求他们预测用户会点赞或转发哪些推文。规则要求选手的模型上限为20千兆字节,必须基于云端CPU的单一内核运行,且时间不能超过24小时。

英伟达的7人团队则第二次获得了这一比赛的冠军。

英伟达参赛成员之一的Gilberto Titericz认为,其推理模型需要去适应CPU核心是本次比赛的难点之一,对英伟达的团队来说“就好像回到了远古时代”。事实上,在比赛后,该团队在单个NVIDIA A100 Tensor Core GPU上运行了比赛模型,CPU花费将近24小时的工作,英伟达A100 GPU仅用了7分钟就完成运行。

此前5个月中,英伟达还参与了Booking.com挑战赛和SIGIR电子商务数据挑战赛。前者要求选手使用匿名数据点预测欧洲度假者最终选择前往的城市,后者则提供了3700万个数据点要求选手预测消费者会购买哪些产品。

这2项比赛吸引了阿里巴巴、沃尔玛等企业参与,而英伟达最终获得了2项比赛的冠军。

▲英伟达推荐系统团队

▲英伟达推荐系统团队

结语:TensorRT可有效提升英伟达GPU推理表现

TensorRT作为英伟达GPU的推理库,5年中更新了7个版本。本次,英伟达推出的TensorRT 8相比上一版本再次有较大幅度的性能提升,侧面体现出了英伟达对推理领域的重视。

另外,TensorRT也支持Python调用,可在数据中心、嵌入式和汽车等平台中应用。TensorRT可以提升视频流传输、语音识别、推荐和自然语言处理等工作的推理延迟,满足了许多实时服务、自动和嵌入式应用的要求。