智东西(公众号:zhidxcom)

作者 | ZeR0

编辑 | 漠影

大规模中文语言模型,又迎来了新玩家。

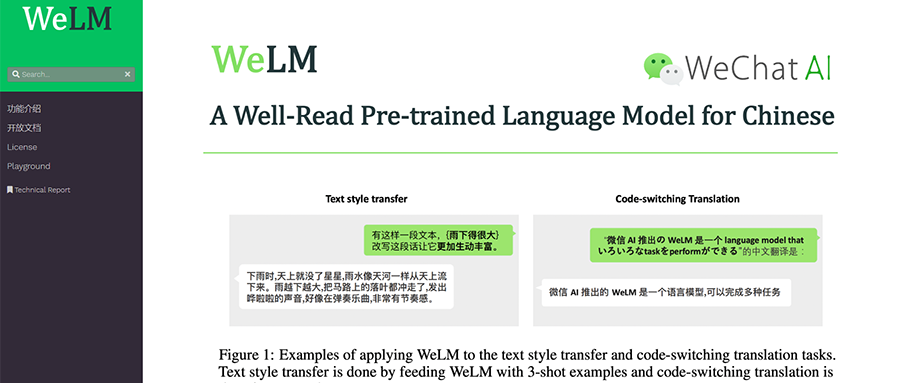

近日,微信AI推出百亿级参数规模的自研NLP大规模语言模型WeLM,能在零样本及少样本的情境下完成对话-采访、阅读理解、翻译、改写、续写、多语言阅读理解等NLP(自然语言处理)任务,具备记忆能力、自我纠正和检查能力。

目前,WeLM已部署应用于微信视频号的部分场景中,未来在进一步优化后还将应用于更多微信应用场景。

一、极强知识储备,在14项中文NLP任务中表现超同类

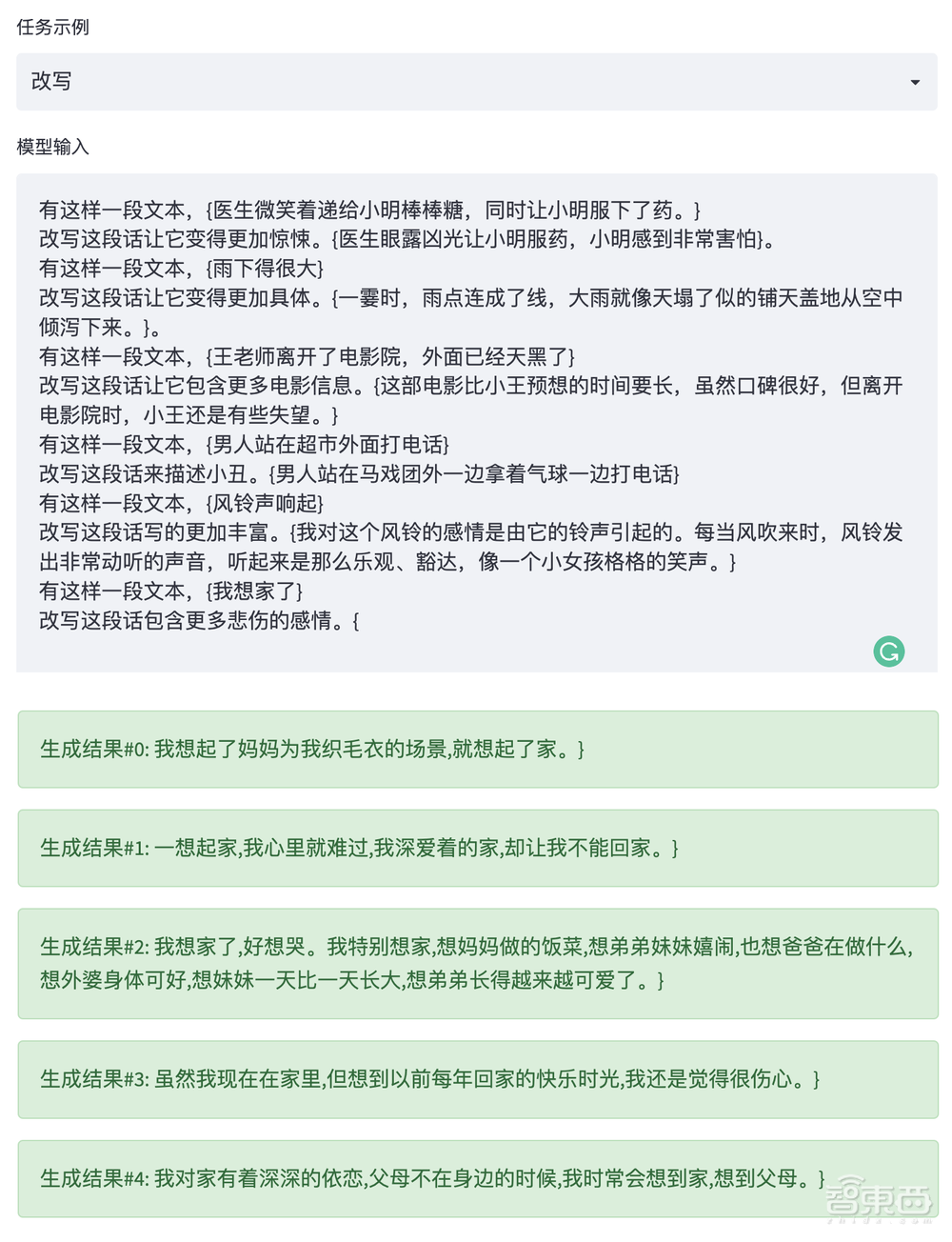

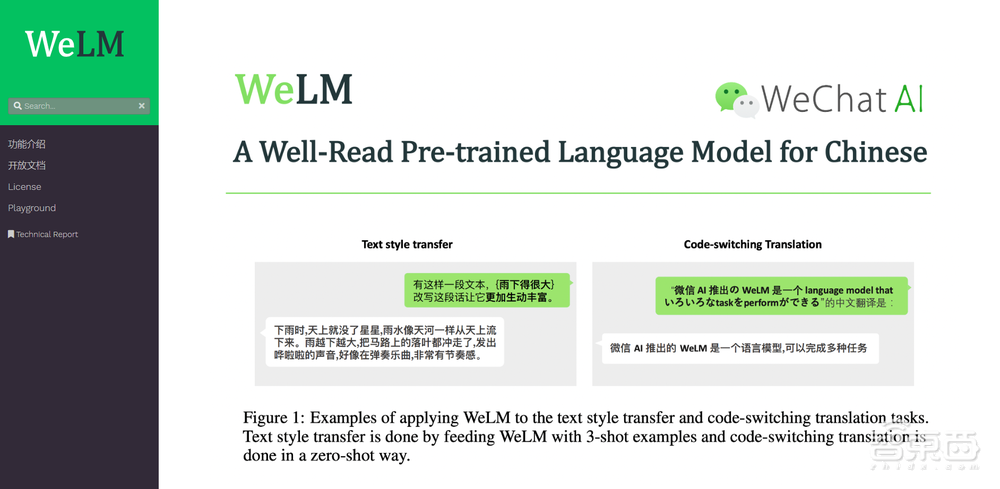

WeLM可在零样本及少样本的情境下,完成多类NLP任务。以文本风格转换(改写)为例,尽管用户给出的5个例子和最后需要生成的例子并没有重合的风格转换类型,但WeLM拥有出色的举一反三能力,通过学习少量的文本转换例子,即可达到对任意类型的文本转换。

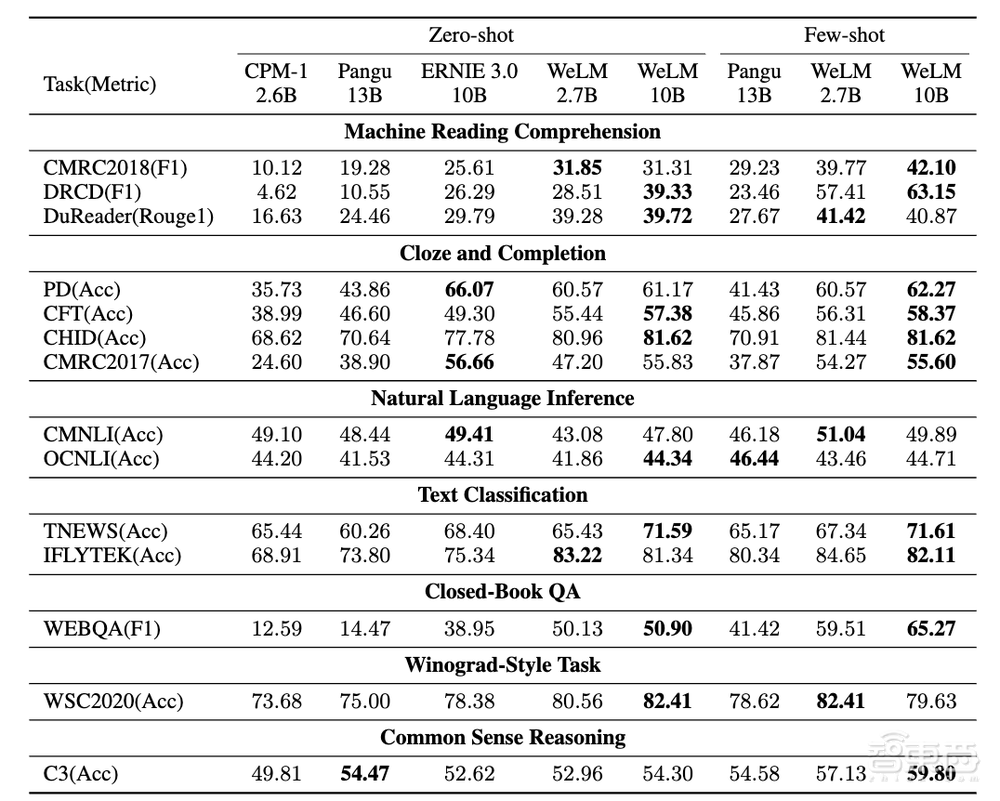

该模型还具有尺寸合理的优势,在与业界同级别的CPM、华为Pangu和百度Ernie3.0的对比测试中,WeLM表现出极强的知识储备。

在14项中文NLP任务上,WeLM的整体表现超出了所有同大小的模型,甚至能够匹配比它大25倍的模型。同时,在强大的中文理解和生成能力外,WeLM还有出色的多语言理解能力,用户的输入可以在跨多语言(中日英)丝滑切换。

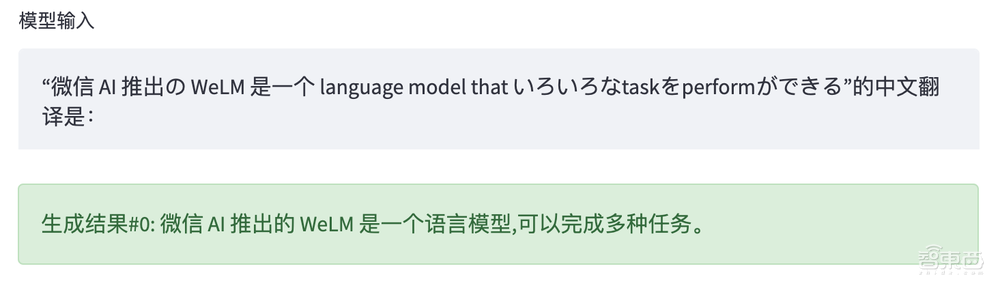

从“微信AI推出のWeLM是一个language model thatいろいろなtaskをperformができる”这句混合中日英三国语言文本的翻译结果来看,WeLM的翻译相较Google翻译更为精准。

在进一步微调后,WeLM可以拥有更好的零样本学习能力,根据场景拥有更好的表现。

二、自回归模型路线,全量数据10TB

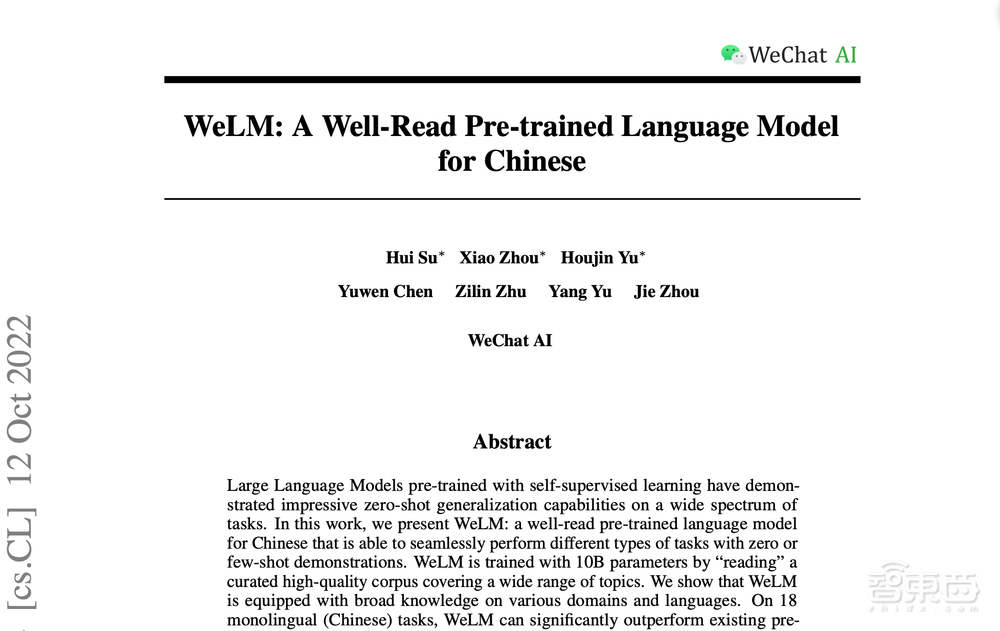

WeLM的相关技术论文《WeLM: A Well-Read Pre-trained Language Model for Chinese》已发布于论文预印本网站arXiv。

论文链接:https://arxiv.org/abs/2209.10372

据介绍,在纯Encoder(Bert)、纯Decoder(GPT) 以及Encoder-Decode(T5) 结构等主流NLP模型路径的选择上,WeLM和GPT3、Google PaLM一样,选择了自回归模型的路线。

同时,考虑到不同的用户对于模型效果和推理延迟会有考量或者取舍(trade-off),微信AI的WeLM训练了1.3B、2.7B以及10B三个版本的模型,满足不同用户的调用需求。

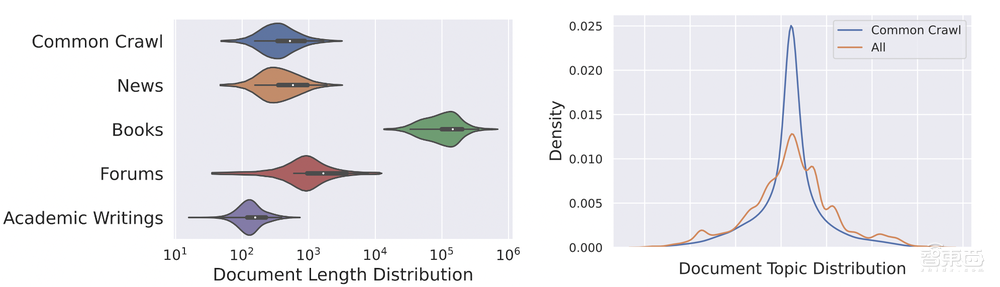

同时,在训练数据上,微信AI团队希望构建一个足够丰富、足够干净、足够公平的数据集,为此研究团队从Common Crawl下载了近两年的中文网页数据,和大量的书籍、新闻。

为了增强专业能力,微信AI团队还在数据集补充了知识密集的论坛数据和一些学术论文,搜集完成后的全量数据10TB,其中包含了750G的英文数据,并保留了部分日韩文。

随后,通过规则过滤和额外训练的二分类fasttext模型,以及对测评相关数据的去除,数据集最终处理完的数据量为262B tokens。

为了更好的平衡各个数据源的比重,微信AI团队也对数据进行不同比重的采样,最终,整体数据集的Topic分布相比Common Crawl更加平滑。

结语:落地且实用才是硬道理

为了推动WeLM落地应用,微信AI团队还发布了一个供用户体验的交互式网页PlayGround,并开放了用于访问WeLM的API接口。用户可通过调整配置以实现更贴近的文本生成效果。

体验申请API接口:https://welm.weixin.qq.com/docs/

除了通过交互式网页PlayGround进行体验外,想开发者也可以通过https://welm.weixin.qq.com/docs/api/填写问卷获得WeLM的API Token并调用相应接口,将WeLM部署在自己的应用上。

未来,微信AI还将针对WeLM进行进一步的微调优化,进一步提升其在新任务上的泛化效果,并吸取更多开发者、用户的意见和建议,将该模型早日打磨成为真正能落地且实用的工具。