智东西(公众号:zhidxcom)

作者 | ZeR0

编辑 | 漠影

智东西4月17日报道,随着大语言模型研究日渐火热,庞大的参数规模带动计算量一路飙涨,对网络带宽提出更高要求。加速大语言模型训练和推理背后的网络基础设施也日益受到关注。

突破网络通信限制,不仅有助于提高大模型计算性能和效率,也有助于降低能耗和电力成本。近日,NVIDIA网络技术专家崔岩、NVIDIA网络市场总监孟庆与智东西等媒体进行深入交流,分享其全栈智能网络技术如何为大模型提供支撑。

孟庆谈道,在AI快速发展的过程中,后进入市场的参与者如果想要赶超已进入市场的参与者,有两种方式,一是按照已成功的范例来投入资源,二是投入同样的资源但要跑得更快,跑得更快必然需要提高效率,而提高效率就需要DPU。

OpenAI便是采用DPU节约时间成本的一大例证。微软前段时间发布的博客文章明确写道,OpenAI采用的硬件包括NVIDIA BlueField-2 DPU及其智能网卡InfiniBand 200G网络。这个被实践检验过的样本已经被很多公司参考。

一、用于两套高性能网络平台,BlueField-3 DPU今年开始大规模投放

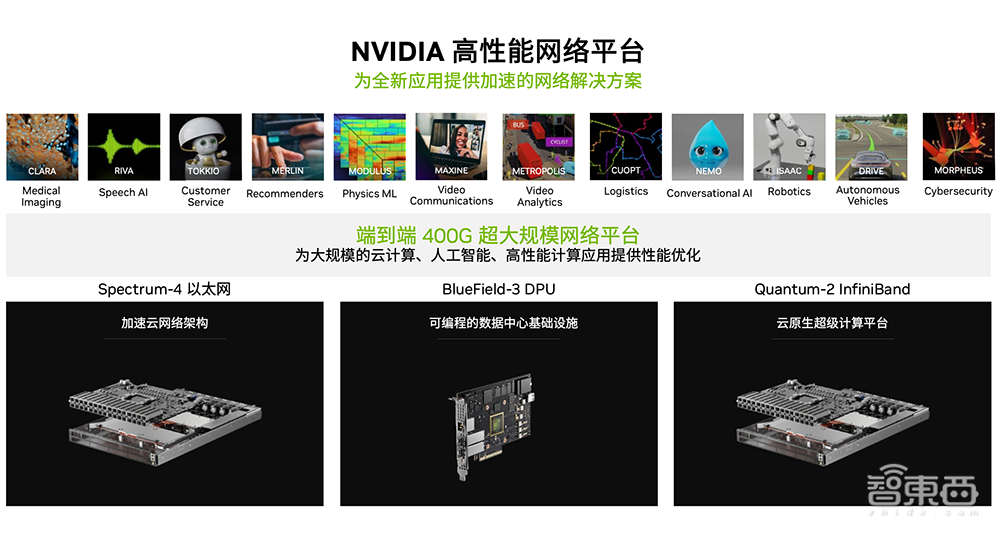

面向全新应用,NVIDIA提供两套高性能网络平台,分别是Quantum-2 InfiniBand网络平台和Spectrum-4以太网网络平台,都是端到端400G高带宽高性能网络架构。BlueField-3 DPU是这两大网络平台里的共有组件,同时用到InfiniBand网络和以太网网络。

在前不久举行的NVIDIA GTC大会上,NVIDIA宣布BlueField-3 DPU全面投产。NVIDIA从今年开始向市场大规模投放BlueField-3 DPU产品。

NVIDIA BlueField-3 DPU会有以下的突破:

1、400G连接:2倍网络带宽、2倍网络管道线(Pipeline)、4倍主机带宽。

2、可编程计算:4倍Arm计算能力、5倍内存带宽、新增数据路径加速器。

3、零信任安全:4倍IPsec加密加速、2倍TLS加密加速、新增MACsec加密加速及平台认证。

4、弹性存储:2倍存储IO性能(IOPs)、2倍存储加密性能、新增NVMe over TCP加速。

现在的数据存储以分布式存储为主。BlueField-3 DPU可以通过虚拟存储设备的方式,让主机侧感知不到它的数据是来自于本地、还是远程,并为主机侧提供弹性存储资源。而且,数据的存储也是加密的,能够满足客户不同形态的存储类型同时保证数据的安全性。

二、四大优势,四大用例

NVIDIA BlueField-3 DPU有四个方面的优势:

1、加速性能:硬件设计架构能够满足软件定义网络、存储、安全上的卸载,提供更快、更高的性能,运行最苛刻的工作负载。

2、云规模效率:把BlueField-3 DPU应用到架构里,能够为业务应用释放x86的核心,让CPU更多去承载业务应用,而不是再去做这些基础设施的操作,从而实现前所未有的规模和更高的效率水平。

3、强大的零信任安全:在不影响性能的情况下,确保全面的数据中心安全。比如在云环境里有多租户同时共享一个数据中心的基础设施,它能够满足租户之间的安全性,实现有效隔离。它也可以把主机分为业务应用域和网络基础设施域,如果应用业务域遭黑客攻击,不会通过基础设施域在数据中心内部的进行横向攻击。

4、完全可编程的基础设施:NVIDIA DOCA软件框架提供一致的开发和运行应用程序,并保持最高性能,使得开发者或企业具备开发能力,可基于BlueField-3 DPU做自己基础设施方面的应用程序或提供相应的服务。

以下四个用例可以辅助理解BlueField-3 DPU的这些优势。

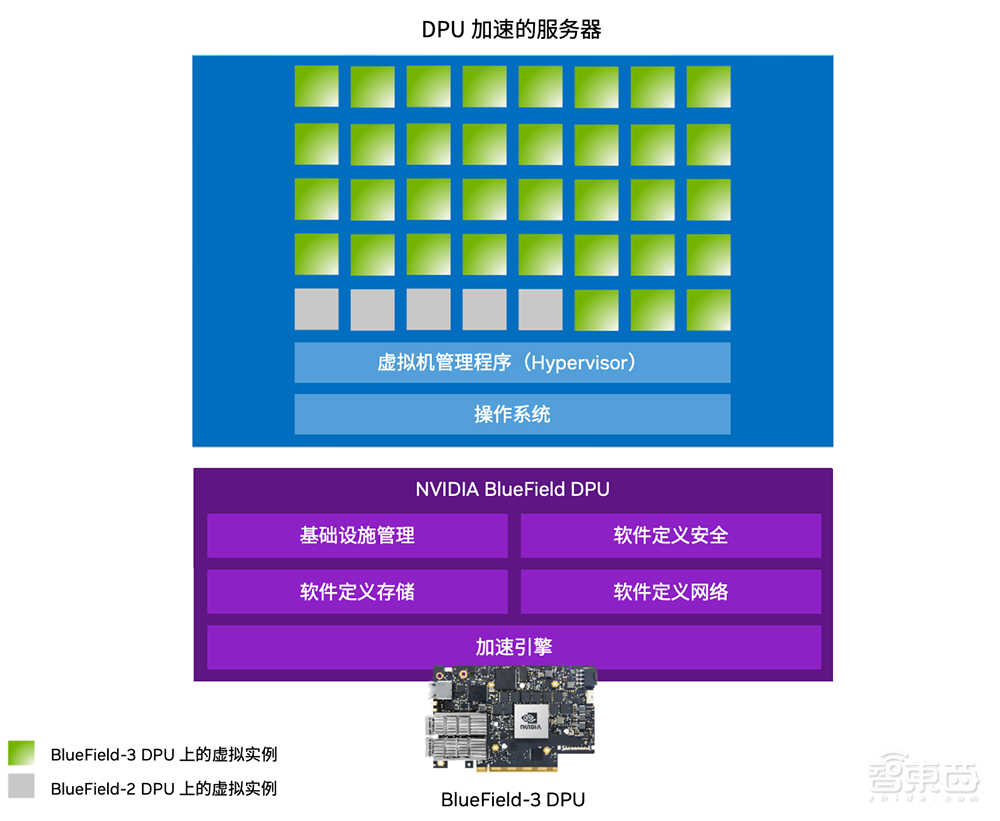

1、加速云计算。未来AI模型训练和推理的大部分算力会依托于云计算,BlueField-3 DPU能够做相应云计算的基础设施的支撑。BlueField-3 DPU可支持4096个虚拟实例,是上一代每个节点虚拟实例数量的4-8倍。这带来的好处是可以更多承载业务应用,因为每个虚机都可以单独租用。对于云计算的服务商来讲,这也是额外的收入,增加了投资回报。

2、安全云计算。在安全多租户云环境提供隔离数据中心控制平面,租户工作负载在主机上运行,基础设施工作负载在BlueField-3 DPU上运行,实现租户之间的隔离以及业务应用域和基础设施域之间的隔离,并提供了零信任安全部署的平台,所以更好保证整个数据中心的安全性。

3、加速企业计算。NVIDIA与VMware合作,目前会在戴尔的PowerEdge服务器上采用BlueField-3 DPU来运行VMware vSphere 8,每秒最多可增加50%的Redis键值存储事物处理,使得VMware网络实现零CPU核心占用。

4、可持续云计算。数据中心电能消耗及需求都在不的增长,怎么来让云计算保持可持续性?应用BlueField-3 DPU后,它本身的性能很强,能够提升服务器主机整体的性能;把所有基础设施工作负载卸载到BlueField-3 DPU上,释放出来的CPU算力资源可以用于业务应用,相当于在服务器没增加的情况下,能够支撑更多的业务,或者在做同一个业务时所需的服务器数量更少。

除了释放CPU核心以外,BlueField-3 DPU还可以节省整个服务器电能的消耗。一个服务器在空载状态、没有加任何负载的情况下,耗电量是334瓦,如果在CPU上运行IPSec工作负载,耗电量会大幅提高至728瓦。如果把IPSec工作负载卸载到DPU,不用CPU来做,则只需481瓦。

所以综合来看,BlueField-3 DPU能够节省服务器的采购数量,减少数据中心的耗电,并减少配电、冷却、机柜空间等成本,对数据中心整体硬性限制有一些本质上的改善。

三、DOCA:为DPU硬件迭代提供软件兼容性

没有软件的芯片就像昂贵的沙子,毫无用处。NVIDIA DOCA是用于BlueField DPU的软件开发框架,全称是Data-Center-infrastructure-On-A-Chip Architecture。

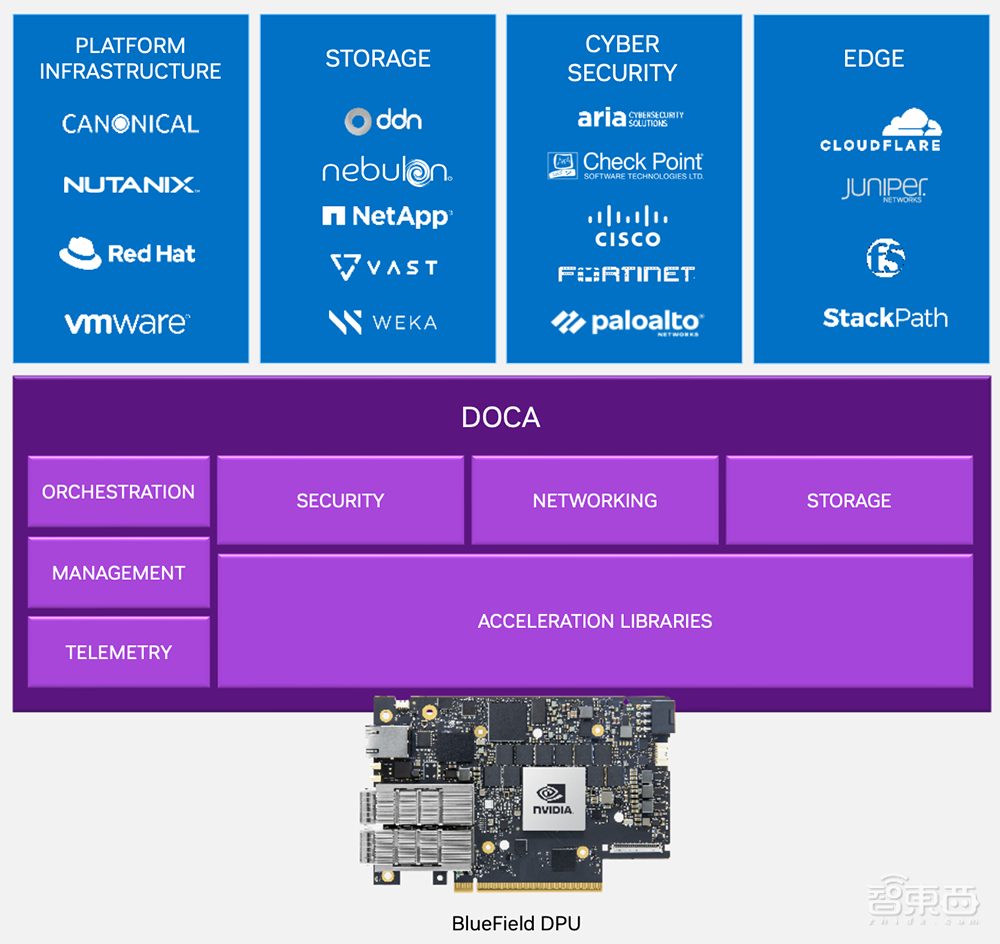

DOCA之于DPU正如CUDA之于GPU。DOCA 软件框架可以兼容以前和之后的BlueField系列DPU。DOCA提供卸载、加速和隔离基础设施操作,支持超大规模、企业、超级计算和超融合基础设施。一些大型云服务商、做超融合计算的公司都在学习和使用DOCA编程。

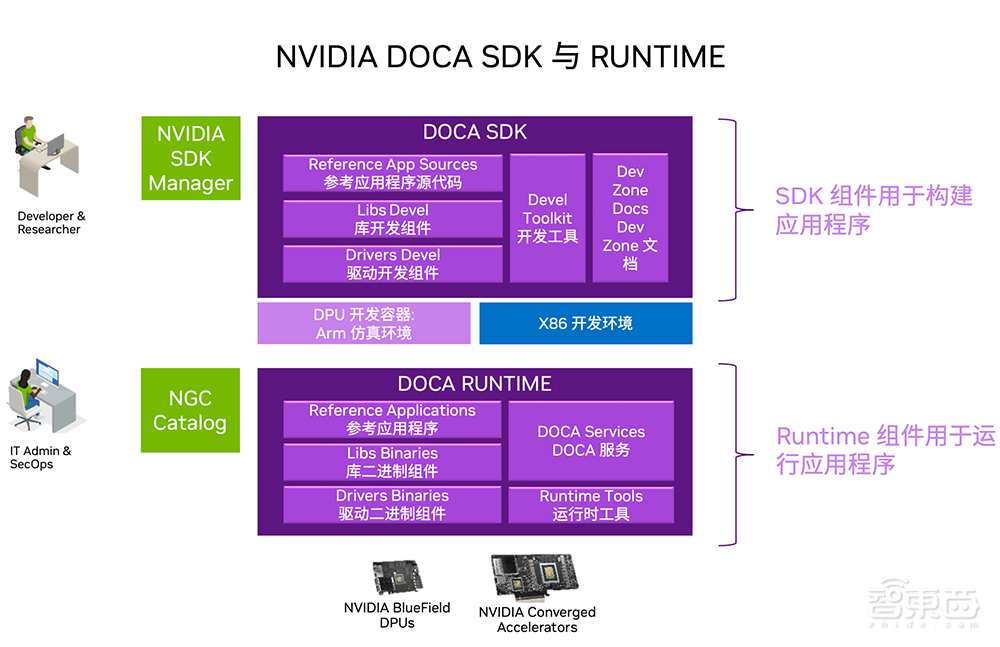

DOCA是非常成体系的,有SDK和RUNTIME运行时两部分。

SDK主要服务于开发者,提供库和驱动、编排和遥测API、开发工具,包括在x86笔记本电脑上模拟DPU构建在Arm的开发环境,还提供开发者文档和参考应用程序等,可通过NVIDIA SDK Manager或手动方式进行安装。

运行时(RUNTIME)服务于管理员角色,有基本的DOCA服务、库和驱动、用户指南、应用程序样例等,有一些工具可以帮助IT管理员或运维人员部署,安装方法包括x86/Arm DOCA运行时repo安装文件、BFB映像部署、Linux包管理器。

NVIDIA GPU云(NGC)可以简化部署,支持一键式部署到服务器中,而且通过虚拟化、迁移等手段可在x86、Arm等不同硬件环境中进行迁移。

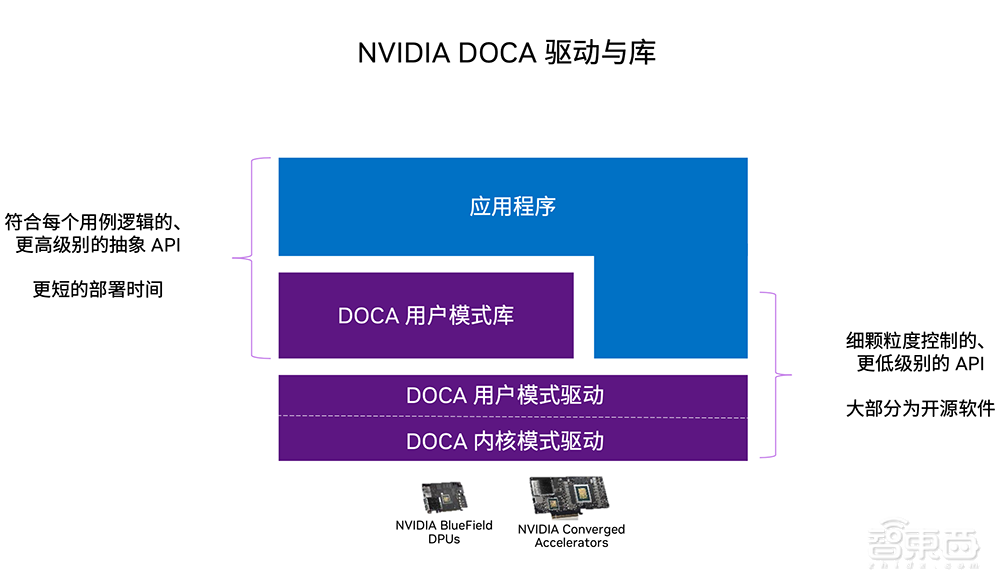

DOCA驱动与库提供不同的API和不同层级开发接口,来满足不同需求。最底层提供的是内核模式驱动,非常资深的开发者可以在内核模式驱动上“搭积木建房子”;用户模型驱动会提供基础功能,允许开发者去调用和编写程序。

例如,国内知名云计算服务商UCloud(优刻得)采用DPU应用于其裸金属服务器租用,它可以将资源分配的软件跑在DPU上,这样客户能够100%租这台机器的计算资源、内存资源,没有隐形消耗(数据中心税)。

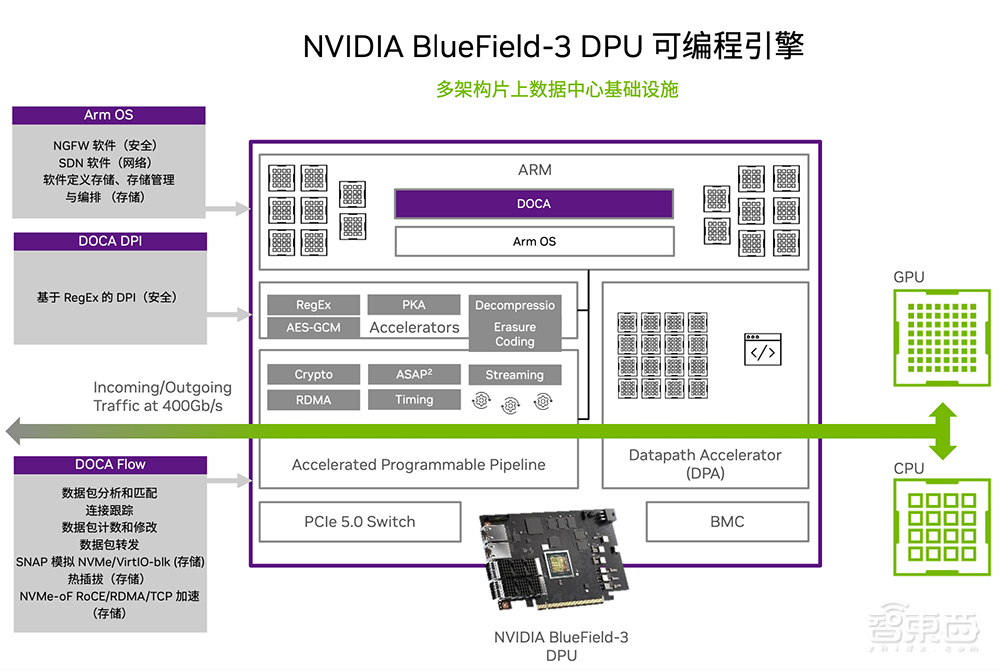

DOCA 2.0伴随着BlueField-3 DPU正式发布。NVIDIA BlueField-3 DPU提供了三种异构的可编程引擎,包括Arm、加速可编程管道线和数据路径加速器(DPA),用DOCA的软件框架把它统一起来。因此开发者不用在意底层异构硬件的如何实现。

比如BlueField-2 DPU上的智能网卡芯片用的是ConnectX-6,而BlueField-3 DPU用的是ConnectX-7。在ConnectX-7上实现的程序编程,可以无缝直接应用在BlueField-3 DPU上,调用同样的核心代码而无需更改。

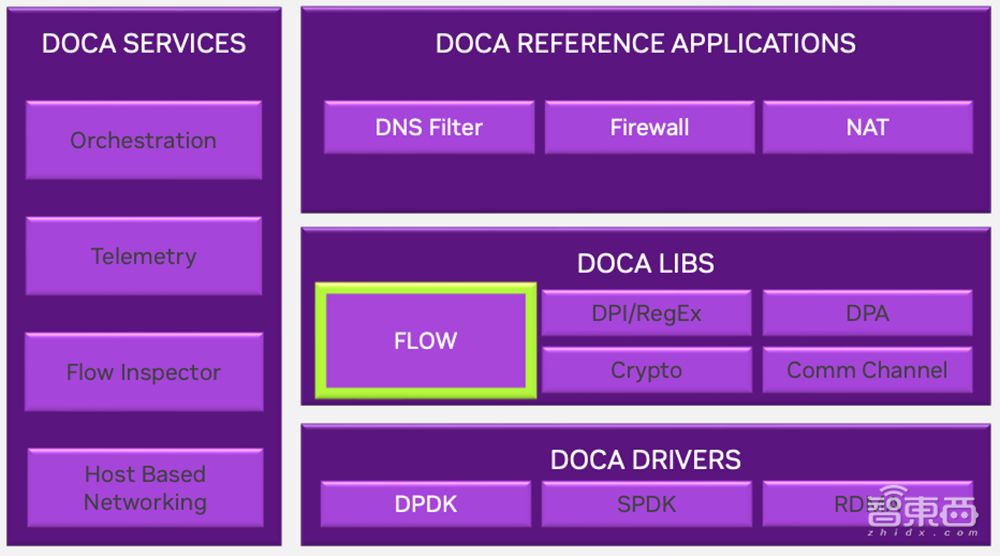

此外,DOCA 2.0新增了对数据路径加速器(DPA)的编程功能,DPA是采用RISC-V架构的处理器,主要用来加速网络流量和处理数据包。

总得来看,DOCA 2.0有几个新的重要功能:

1、统一的软件框架。同时支持上一代DPU和最新的BlueField-3 DPU,新增DPA等功能。

2、软件生态变得丰富。很多软硬件合作伙伴都兼容并支持新一代DPU,包括Oracle OCI的云基础设施、微软Azure等。

DPA有几大特性:1、BlueField-3 DPU中引入了DPA计算子系统;2、DPA针对设备仿真、IO密集型应用、高插入率、网络流处理、客户协议、集体和DMA操作进行了优化;3、通过DOCA FlexIO SDK、DOCA DPA SDK、支持这些SDK的工具链和示例及宣传资料等方式实现客户可编程性;4、提供利用DPA开发的交钥匙应用程序。

DOCA 2.0 FLOW库是对开发者非常有用的特性,可以把对数据包处理的方式抽象出来,之后调用时,不管是做软件定义网络、网关还是做几百万次查询插入式操作,都非常有意义。

库就像是一个字典,调用时不用管具体操作是怎么完成的,对开发者来说,用简单方式就能实现这么多的功能,所以它可以快速写代码、部署,缩短业务上线时间。其目标网络应用有路由器、下一代防火器(NGFW)、负载均衡器(Load Balancer)、用户平面功能(UPF)等,都是基于NVIDIA提供的DOCA FLOW通道。

Regex是处理网络流量的重要算法,是数学里正则表达式的计算。NVIDIA在BlueField-3 DPU中改进了Regex硬件引擎。通过增强综合性能,新增的双向搜索能力可以让它更快找到匹配项,从而提高规则性能,并能够编译比BF2目前支持的更多规则。这对于网络海量并发时非常重要。

DOCA 2.0还为BlueField-3 DPU带来了新的SNAP基础设施SNAP v4。很多AI企业有上百TB的数据集,做远程调用会非常看重这个核心。用DPU卸载SNAP v4的功能可以释放带宽和调用时间,大幅提升效率。NVIDIA之后会将SNAP v4放在公共NGC上发布,也是一键部署。

DOCA 2.0 BlueMan是一款易部署的遥测可视化工具。管理员可以通过它提供的图形界面去查看自己所有的主机情况,包括健康、性能、网络流量是否存在问题以及风险预警等。

四、56%的DOCA开发者来自中国社区

目前NVIDIA DOCA开发者社区提供相关DOCA API文档及资源,从而指导开发者怎么基于BlueField系列DPU进行部署和编程。

其全球开发者已经超过4700人。DOCA中国社区是2021年7月份发布的,2021年末时中国占了全球开发者42%,到2023年1月已经有56%的开发者来自中国社区。这些来自中国的开发者,有的来自互联网大厂、有的来自创业公司,也有的来自高校。

NVIDIA在推进DOCA中国社区发展时考虑到一个问题,基于BlueField系列DPU的DOCA 软件开发与基于GPU的CUDA开发不一样,开发者可以采用笔记本电脑或台式机就可以搭建GPU开发环境,但开发者自己搭建DPU开发环境是不太容易的事情。

为此,NVIDIA授权设立了DPU & DOCA卓越中心,与三家合作伙伴(丽台、信弘、联泰集群)一起,向中国开发者提供免费的DOCA开发环境。

DOCA开发者需要成功注册NVIDIA DOCA开发者体验计划,才能申请免费开发环境。申请人需要提前48小时以个人名义通过向NVIDIA授权合作伙伴发送申请,提交申请的详细信息,且信息准确无误,获得授权合作伙伴审核批准后可获得2小时-6小时免费的DOCA开发环境。

结语:加速大模型普及需要更好的网络基础设施

无论是愈发热门的大模型,还是已经走向落地普及的传统中小型模型,都需要更好的网络基础设施来突破吞吐量和性能瓶颈。

就像人们在日常生活中永远不会嫌网络太快,数据中心的效率提升也永无止境。将数据效率提升,就意味着租用面积变少、动用的空调等设备变少、消耗的电力变少,或者用同样电能时执行计算任务的效率大大提高。

如NVIDIA创始人兼CEO黄仁勋所言,AI正迎来“iPhone时刻”,在更强大的计算基础设施与网络基础设施配合下,生成式AI能力将逐渐深入各行各业,慢慢改变很多工作、生产和生活的方式。