智东西(公众号:zhidxcom)

作者 | 云鹏

编辑 | 云鹏

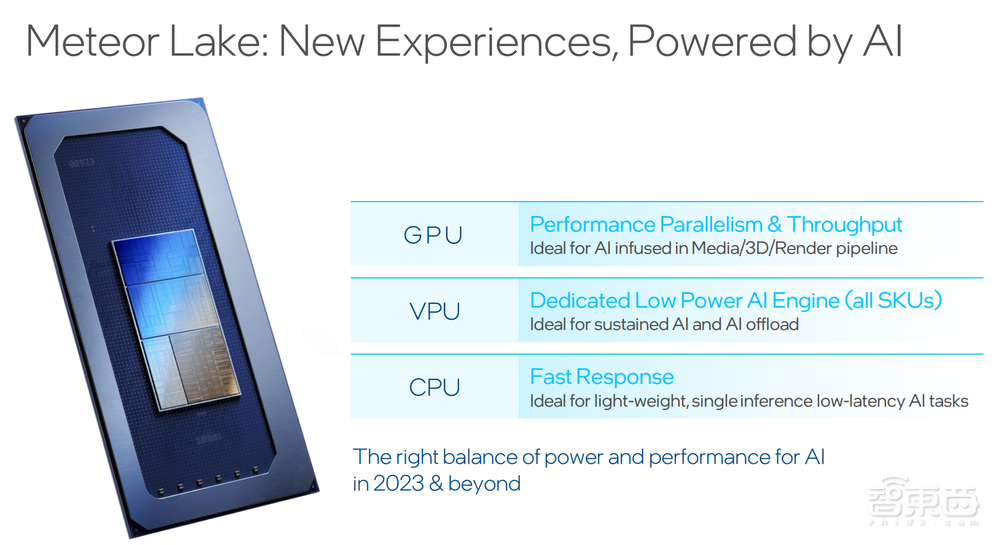

智东西5月30日报道,今天英特尔在一场小范围沟通会上透露了其在AI与PC结合领域的最新产品及技术布局。在下一代Meteor Lake平台上,英特尔会采用独立的VPU处理单元,实现“CPU+GPU+VPU”的AI加速处理模式。

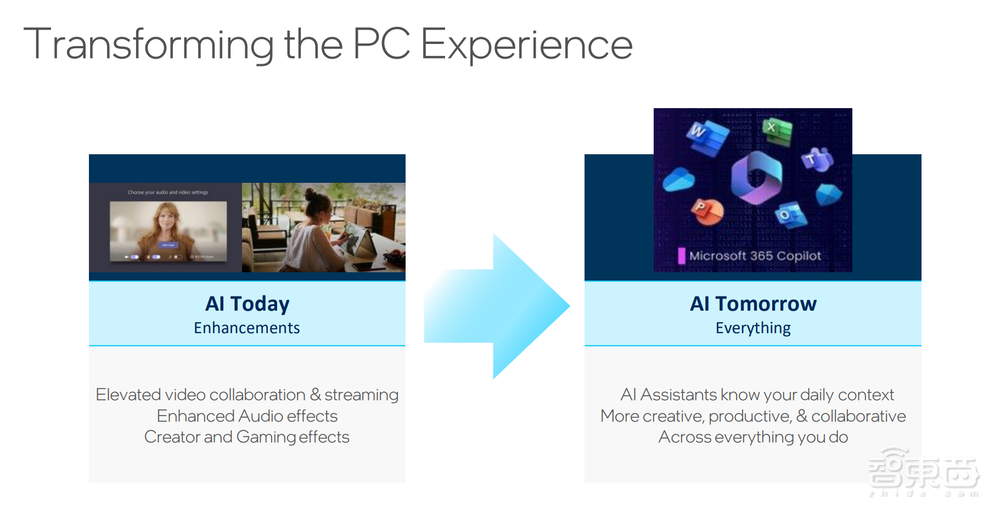

目前,AI在端侧、在PC侧带来的用户体验改善是非常明显的,AI在各种使用场景中开始渗透,比如背景模糊、美颜、美化声音等,现在生成式AI让人和PC用自然语言进行交互成为一个非常自然的方式,AI让用户以非常自然的方式来做到以前很难想象的一些事情。

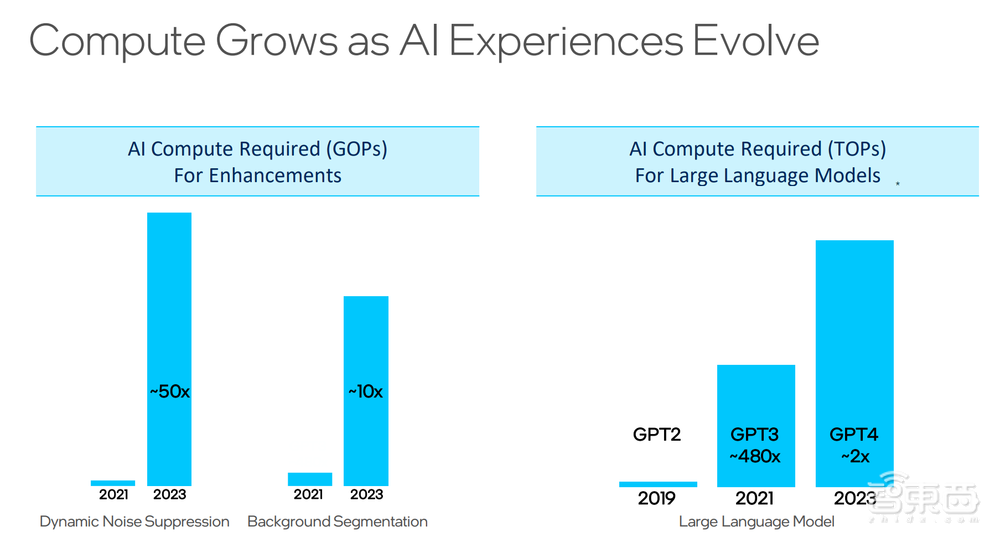

同时,AI技术的进步、处理复杂度的提升也带来了算力需求的大幅上涨,比如噪音抑制处理与两年前相比复杂度有50倍提升,生成式AI模型对算力的需求又上了新的台阶,GPT-4的业内预测参数量是万亿级。这些对硬件厂商提出了新的挑战。

此前英特尔在产品上做了指令集级别的对AI的支持,以加速AI负载运算。此次英特尔在Meteor Lake中引入VPU,专门针对AI负荷加入一些IP。另外,英特尔在软件方面推出了对应的软件工具。

在英特尔看来,AI使用场景复杂,需求不统一,针对这一特点,英特尔选择用不同架构来处理。

VPU是专门为AI设计的一套架构,可以更高效地做矩阵运算,对稀疏化的处理更擅长。VPU的特点是功耗低,需要长时间运行的AI负载,用VPU来解决更高效且省电。

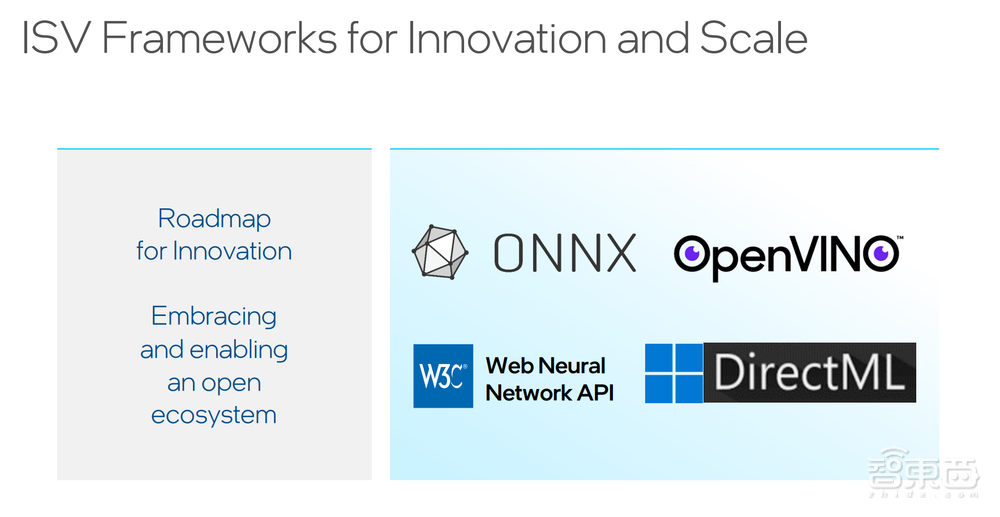

在软件上,英特尔通过OpenVINO来部署在各个不同的硬件上的AI网络模型。OpenVINO对CPU、GPU、VPU底层不同架构之间的异构计算差异进行封装,提供统一软件接口。

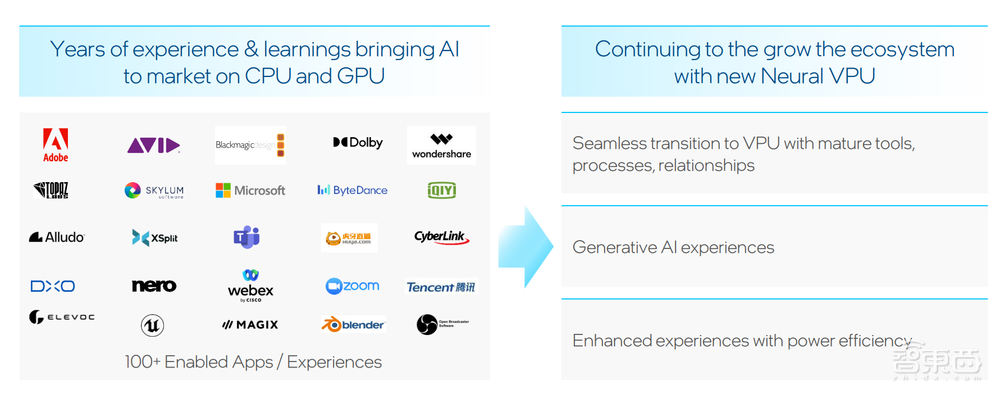

根据英特尔数据,目前英特尔有超过70%的ISV在用AI在改造自己的业务,与英特尔在AI方面进行合作的ISV厂商数量超过100家。

目前英特尔已经与Adobe、Blender、Audacity、OBS、GIMP等厂商或平台开展合作,应用VPU相关技术。比如当下火爆的生成式AI应用Stable Diffusion,就可以通过英特尔“CPU+GPU+VPU”的方式运行,功耗更低,效果达到可用状态。

在现场演示视频中,借助英特尔CPU+集成显卡+VPU,Stable Diffusion可以在20秒左右生成一张图像,其中VPU承担了VNET模块的运行。

▲现场演示视频

结语:PC卷入生成式AI,VPU成英特尔解决算力瓶颈新思路

在生成式AI浪潮下,PC作为用户生产力的核心硬件产品之一,必然会深受AI技术的影响,如何在端侧解决AI应用带来的算力瓶颈,提供更好的用户体验也是各路芯片厂商需要解决的问题。

英特尔此次通过VPU架构针对性解决AI负载,提升系统整体运行AI任务的效率,并进一步控制功耗,不失为一种值得借鉴的思路。后续VPU将如何加速生成式AI在PC端的落地,也值得进一步关注。