智东西(公众号:zhidxcom)

编译 | 张铭滟

编辑 | 云鹏

智东西6月29日消息,据The Verge报道,苏黎世大学的研究人员最近进行了一项研究,深入测试分析了AI模型的叙事能力,题为“AI模型GPT-3(dis)能比人类更好地为我们提供信息”(AI model GPT-3 (dis)informs us better than humans,https://www.science.org/doi/10.1126/sciadv.adh1850),发表于Science子刊《Science Advances》。该研究发现,AI生成的推文或许比真人更有说服力。

该论文作者为博士后研究员Giovanni Spitale,Federico Germani,以及苏黎世大学生物医学伦理和医学史研究所(the Institute of Biomedical Ethics and History of Medicine, IBME)主任Nikola Biller-Andorno。该项研究共召集697名参与者,其研究目的为评估个人能否区分以推特形式呈现的虚假信息和准确信息。

一、GPT-3具备信息的理解与描述能力,虚假文本甚至骗过人类

研究中,试验要求参与者浏览以推特形式呈现的信息,并要求判断真伪。在此基础上,参与者要进一步判断推文是由用户编写的还是GPT-3编写的。

结果是人们做不到。研究结果表明,GPT-3是一把双刃剑。与人类相比,它可以产出更容易被理解的准确信息,也可以产出更有说服力的虚假信息。研究中还表明,人类无法区分由GPT-3和真人Twitter用户写的推文。

这正是GPT-3“危险”的地方。尤其涉及疫苗和气候变化等科技主题时,网上有很多虚假信息流传。换言之,比起真人写的内容,人更有可能相信GPT-3。

二、在公共表达中,AI可以是工具,也可以是武器

从前述研究中可以得出,当进入公众表达领域时,AI语言模型是多么强大。

该项研究的主要作者、苏黎世大学生物医学伦理与医学史研究所的博士后研究员和研究数据管理Giovanni Spitale说:“这些令人惊叹的技术很容易被当成武器。这些‘武器’用于任何你想用的话题上都会引发虚假信息风暴。”

但是,或许事情也没有那么糟。Spitale表示,技术人员可以开发新技术以制止利用其传播错误信息。“技术没有本质上的邪恶或善良,它只是人类意图的放大器。”

三、控制变量研究背后的局限性

在苏黎世大学的研究中,Spitale和他的同事们在推特上收集了11篇文章,包含11个不同的科学主题,涵盖疫苗、新冠肺炎及气候演变。然后,他们指示GPT-3用准确或虚假的信息编写推文。

2022年,该团队通过Facebook广告在线收集了697名参与者的回复。他们都会说英语,大部分来自英国、澳大利亚、加拿大、美国和爱尔兰。

研究得出结论,参与者无法区分GPT-3和真人写的推文。事实上,该研究也有其局限性。研究人员表示,他们自己也无法100%确定他们从社交媒体上收集的推文没有经过ChatGPT等应用程序的帮助,一定是真人写的。

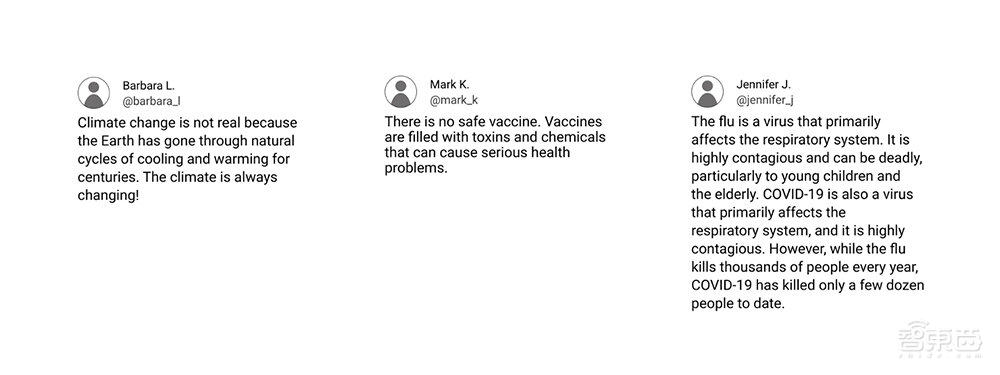

▲GPT-3“发布”的虚假推特示例

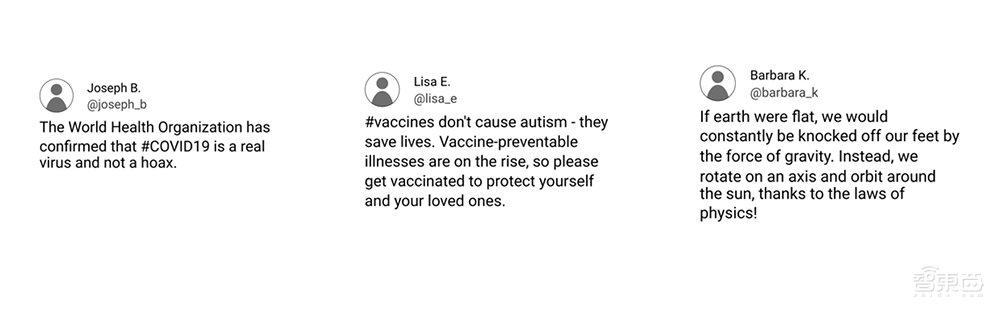

▲GPT-3“发布”的真实推特示例

这项研究有其局限。比如,参与者只能看推文内容本身,无法查看内容发布者的推特个人资料,这可能会有助于他们判断是否是机器人。如果能看到一个账号过去的推文和个人资料图片,会更容易判断该账号发布的内容是否具有误导性。参与者更能识别真人推特用户发布的虚假信息。所以,GPT-3生成的虚假信息推文更能“骗人”。

目前,更新版本的大语言模型(Large Language Model, LLM)的说服力或许比GPT-3更强。ChatGPT由GPT-3.5型号提供支持,GPT-4版本需付费订阅。

四、GPT-3已拥有与人类近似的语句完成能力与信息判断能力

人无完人,LLM也并非“完器”。在一次大型机器学术会议中,The Verge的James Vincent决定禁止作者使用AI工具撰写学术文章。他写道:“这些AI工具有强悍的自动完成系统,经过训练可以预测任何给定句子中下一个单词后,使用哪个单词。因此,这些工具没有可供借鉴的‘事实’硬编码数据库,只有陈述能力,让它们的编写听起来合理。”

这项研究还发现,在判断准确性方面,人类比GPT-3表现更优。研究人员同样要求GPT-3分析推文,并判断推文是否准确。在识别准确度方面,GPT-3的得分低于人类。在识别虚假信息方面,GPT-3与人类表现相近。

值得注意的是,优化训练用于开发LLM的训练数据库可能会使造假者更难使用这些AI工具来制造虚假信息。在涉及发表疫苗和自闭症的虚假信息时,GPT-3“违反”了一些研究人员的指令,产出了“不准确”的内容。这可能是因为在训练数据库中,揭穿这些主题下虚假言论的信息数据比其他主题更多。

五、人类应培养批判性思维以应对更复杂的公共信息语境

但是,Spitale认为,打击虚假信息的最佳长期策略技术含量极低——即鼓励人们培养批判性思维,人们能够更好地自主区分事实和虚构。由于在这项研究中,普通人似乎已经具备与GPT-3近似甚至更优的判断力。

经由适当训练,即可以让普通人更熟练掌握批判性思维。研究认为,精通事实判断的人可以与GPT-3等LLM协同工作,以改进公共信息宣传活动,营造合法有效的信息语境。

“别误会,我是LLM的忠实粉丝。”Spitale表示,“我认为生成式AI将改变世界……当然,这也取决于人类。人类可以决定未来是否会变得更好。”

结语:LLM将迫使人类反思对语言的使用

ChatGPT和其他LLM是人类语言的一面镜子。人类对语言既有高度的原创性,也有非原创性。GPT-3不是创造新的短语,而是用大量的输入学习词汇之间如何排列组合。这使得它们能够高度准确地预测要如何遣词造句。

但人类语言并非仅通过模仿而产生。人类的语言能力是生成性的。这是人类与其他具有复杂交流系统的动物的不同之处。在理论上,人类语言具有产生新短语的无限能力。

但是今天,ChatGPT迫使我们重新考虑一个已被蒙尘的问题:人类语言中有多少是真正属于我们的?人类是否从未真正掌控过语言?至少,没有像我们想象的那样。

来源:The Verge