智东西(公众号:zhidxcom)

作者 | 三北

编辑 | 漠影

AI大模型正在倒逼国内数字基础设施产业加速跃迁。

随着“百模大战”打响,近日,ICT龙头华为继推出了盘古大模型3.0、昇腾AI云服务等产品后,又进一步推出了面向大模型的全新AI存储产品。

存储的重要性不言而喻,它与算力、网络并列为“数据中心三大件”,为大模型生产提供数据底座,支持大模型中的信息快速、无延迟地读写。

如果将大模型比作孩子,那么数据就是菜肴。孩子只有吃得好,才能长得高,数据存储正是烹饪这些菜肴的大厨,是大模型成长的“第一道关口”。

华为此次面向基础、行业大模型及细分场景模型,推出了OceanStor A310深度学习数据湖存储和FusionCube A3000训/推超融合一体机两款新品。据称,其在密度、容量等性能指标上高于业界60%,能大大提高大模型生产中的数据处理效率,以便高效快速地将“菜肴”喂给正在茁壮成长的大模型。

数据“存得下、用得好”在小模型时期已经是企业标配需求。那么相比于小模型时代,大模型场景下的存储需求发生了什么重要改变?华为推出的AI存储新品是基于什么考虑?数据存储又将如何影响我国大模型产业的发展进程?

通过对话华为数据存储产品线总裁周跃峰、华为分布式存储领域副总裁韩振兴等专家,本文对此进行了深入探讨。

一、数据资产升值,存好数据成“炼模”第一关

众所周知,算法、算力和数据是AI的核心三要素。

今天看中国乃至全球AI发展,大模型软件算法已有众多部署,比如清华大学与智谱AI联合推出的ChatGLM、中科院自动化所推出的紫东.太初、科大讯飞推出的星火认知大模型等;在算力方面,我们也看到英伟达之外,华为昇腾、寒武纪等新秀飞速发展;而当我们把视线投向数据,则发现了一大“凹陷”地带。

多位大模型公司专业人士称,国内大模型与GPT-4仍有一定距离,背后的一大原因是英文类大模型在训练时,所调用的记录资料远多于中文。国内大模型缺乏海量和高价值的数据,已成为限制大模型产业发展的一大桎梏。

根据投资机构ARK Invest预算,到2030年,产业有望训练出比GPT-3多57倍参数、多720倍Token的AI模型,成本将从今天的170亿美元降至60万美元。随着计算价格降低,数据将成为大模型生产的主要限制因素。

面对数据桎梏问题,不少企业已经开始进行前瞻性布局。华为分布式存储领域副总裁韩振兴告诉智东西等媒体,国内已有十几家大模型客户、厂商与华为展开合作,比如前文提到的科大讯飞、中科院等,还有一些海外客户,都纷纷关注到了大模型场景下数据存储的升级需求。

华为数据存储产品线总裁周跃峰说,“大模型时代,数据决定AI智能的高度。作为数据的载体,数据存储成为AI大模型的关键基础设施。”他谈道,过去几年,国内大力建设了很多算力中心,而随着大模型推进,各地的存力中心也开始加紧建设。与此同时,大模型的训练需要快速的数据采集和加载,因此也呼唤产业打造出更高性能的存储产品。

中金公司研究部计算机行业首席分析师、副总经理于钟海在近期的一次演讲中也谈道,数据应该成为企业AI战略的核心。随着头部大模型企业投入,大模型算法本身的接入成本将不断变低,行业大模型成为行业发展的趋势。企业私有数据,蕴含不可湮灭的价值;数据壁垒,也成为竞争对手无法完整复制的策略。

可以看到在大模型时代,数据资产正在升值。数据存储作为大模型生产中的“第一关”,重要性将随着时间推移更加凸显。

二、迈过四道坎,攻克大模型的“饥饿状态”

相比于小模型训练,大模型的显著特征是“大”。

这决定了小模型的数据处理与大模型存在区别。从产业实际来看,在小模型兴起时,很多企业会用一些服务器的本地磁盘来存储数据,用以加载到显存里做训练。但随着大模型兴起,服务器本地磁盘难以带动海量数据,如果继续扩充此类存储设施,则有可能出现问题。

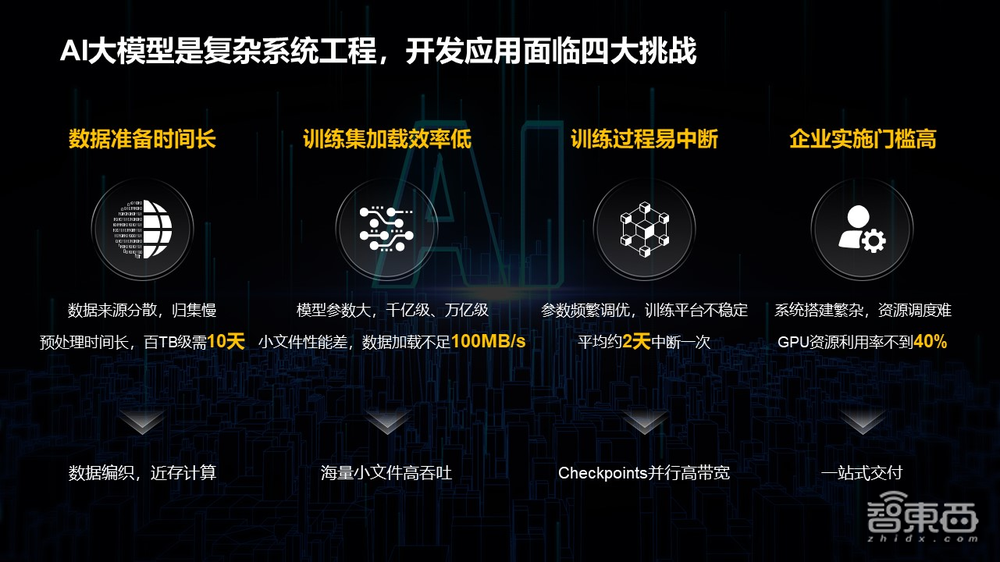

这就要提到模型生产面临的第一重挑战:在大模型的数据准备环节,数据准备和预处理过程复杂,耗时长。

由于数据来源分散、归集慢,且预处理百TB数据大概需要10天左右,从而影响了整个系统的高效运转。这就需要在数据存储环节快速进行数据归集和预处理,以此缓解算力“饥饿”问题。

同时,企业不仅需要把数据喂给大模型,还需要让数据存储和训练计算打配合。

这里就指向了大模型训练中的第二重挑战:在大模型的训练环节,数据集的加载效率往往难以满足需求。当下大模型已达到百亿到万亿参数,多模态大模型以海量文本、图片为训练集,需要我们将大量小文件传送到训练器。而小文件的读取速度是一个业界难题,就像传输一个G的电影远比传输多个1k的小文件快一样,当前海量小文件的加载速度不足100MB/s,这就限制了整个系统的效率。

还有第三重挑战,那就是在AI大模型训练中,训练中断后的断点恢复面临难处。由于大模型参数需要频繁调优,训练出现中断是高频事件,需要高效地恢复训练过程。尤其在训练复杂的模型结构时,如果数据加载不顺畅、易出错则会增加巨大的工作开销。

此外,还有第四重挑战,那就是在大模型实施部署环节,大模型落地门槛往往较高。对于绝大多数企业而言,使用大模型需要专业的知识储备、人才储备和专业系统实施能力,且企业传统的IT系统会为每个应用预留一定的GPU资源,单个应用独占GPU,资源利用率通常不到40%,这些问题对企业来说也比较棘手。

总的来说,在大模型生产中的数据采集、数据预处理、模型训练、模型推理任一环节,如果数据存储跟不上计算的节奏,都可能造成大模型的“饥饿”。只有解决上述关键难题,才能解决大模型的“饥饿”状态。

纵观当下全国数据中心布局,算力相对充足,但缺乏相应的存力。如果算力过多、存力过少,就会导致数据在归集、预处理、训练、推理的流程中耗时过多,算力就会被闲置等待,从而造成资源浪费,更影响大模型生产的质量。“存算比”成为更加需要科学考量的关键指标。

三、面向多种大模型场景,华为打造数据“加速包”和“保护舱”

解决瓶颈问题,需要产业头部玩家牵头。

作为全球领先的高端存储设备公司,华为在两三年前预判到AI大趋势,提前筹备两款AI存储产品。据称,这两款产品在密度、容量等性能指标上高于业界60%,并通过灵活的扩展性,帮助大模型客户更好地预置和部署大模型。

首先来看看第一款产品,OceanStor A310深度学习数据湖存储。

正如前文提到,面对大模型时代的数据采集、处理等各环节的问题,过去将数据归集、预处理、训练、推理分别建在不同的数据中心的方式可能不再高效。大模型会加速存储在各个环节的融合,形成类似数据湖的存储。

OceanStor A310是面向基础、行业大模型场景,涵盖从数据归集、预处理到模型训练、推理应用的AI全流程深度学习数据湖存储。据悉,OceanStor A310是当前全球性能密度最高的一款存储,支持96闪存盘,带宽可达400GB/s,IOPS达到1200万,可线性扩展至4096节点,实现多协议无损互通。其内置的全局文件系统GFS可实现跨地域智能数据编织,简化数据归集流程,并支持近存计算,以实现近数据预处理,减少数据搬移,预处理效率提升30%。

此外,OceanStor A310不仅可用于AI大模型,它的同源数据的处理能力在客户做超算和大数据应用时同样适用。当未来客户系统需要升级融合成AI大模型的时候,数据也无需再迁移,该产品有很好的未来演进能力。

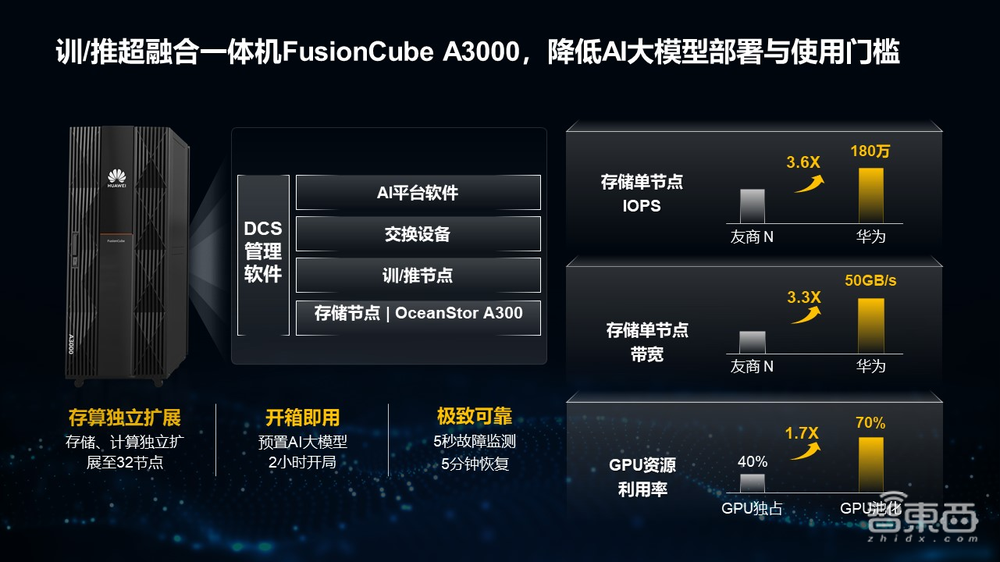

再来看看第二款产品,FusionCube A3000训/推超融合一体机。

正如前文提到,很多企业在搭建AI时,如何降低这一系统化工程的落地门槛?答案是超融合。

FusionCube A3000训/推超融合一体机集成了高性能存储节点、训推节点、网络交换设备、AI平台软件。据悉,这一新品面向百亿级模型应用,客户可以一站式部署,开箱即用,能大幅降低AI大模型的前期使用、部署门槛与投入。

FusionCube A3000 还支持两种商业模式,为客户提供更多样的配置选择。第一种昇腾一站式方案是华为集成了自研的OceanStor A300高性能存储节点、网络、昇腾计算与管理运维软件,为客户提供全国产化的昇腾一站式方案。第二种是第三方GPU一站式方案,其底座是华为OceanStor A300高性能存储节点,其余GPU服务器、交换机、AI平台软件向伙伴开放,为大模型伙伴提供拎包入住的部署体验,实现一站式交付。

FusionCube A3000已与多家战略伙伴进行合作试用与联合创新,今后将持续赋能更多中小企业、研究所和高校的AI大模型训练推理。

除了让大模型“吃得饱”,我们不得不提数据安全的问题,这也是几乎所有大模型厂商极其关注的问题。

就像我们关注钱的安全,首先就是希望钱包和家里的保险箱安全,数据存储的安全与之类似。

华为苏黎士研究所数据存储首席科学家张霁谈道:“数据存储是我们数据安全的第一道防线。”在AI大模型的第一个阶段,将数据安全地归集是十分具有挑战性的。为此华为正在研究一种数据方舱技术,将数据在流转的过程中把相关凭证、隐私、权限等信息跟数据放在一起进行流转。这些数据到达数据归集地后,都在数据方舱中安全的执行和保护,从而做到数据安全。

只有数据能够安全流转,AI大模型未来才可以得到长久、持续的发展。

总的来说,面向多种大模型场景,华为正在打造数据的“加速包”和“保护舱”,并带领数据存储行业建立大模型时代下的新标准。

结语:大模型推动数据资产升值,存好数据成“炼模”必备

随着大模型推进,存好数据成“炼模”必备,数据存储出现了新的趋势。大模型的训练需要快速地采集和加载数据,因此也需要更高性能的存储产品。与此同时,大模型会加速存储在各个环节的融合,提升整个系统的效率。

过往几年,国内建设了很多的算力中心。而随着大模型的加速狂飙,我们有望看到更多省份开始建设大量存力中心,存力产业将与算力产业一同实现新的迭代升级。