1、英伟达GH200芯片在MLPerf新测试中表现最佳

2、英伟达的AI芯片主导地位或使芯片创企融资困难

3、微软发布13亿参数phi-1.5 多步骤处理表现突出

4、传三星与微软合作开发公司内部用AI聊天机器人

5、OpenAI被更多作家起诉侵犯版权

6、大摩:Dojo或为特斯拉带来6000亿美元增长

7、马斯克称特斯拉长期价值几乎都来自AI和机器人

8、戴尔与利默里克大学合作开发癌症研究AI平台

9、阿里新任CEO吴泳铭提出AI和用户两大战略重心

10、昆仑万维前董事长金天辞任 方汉接任

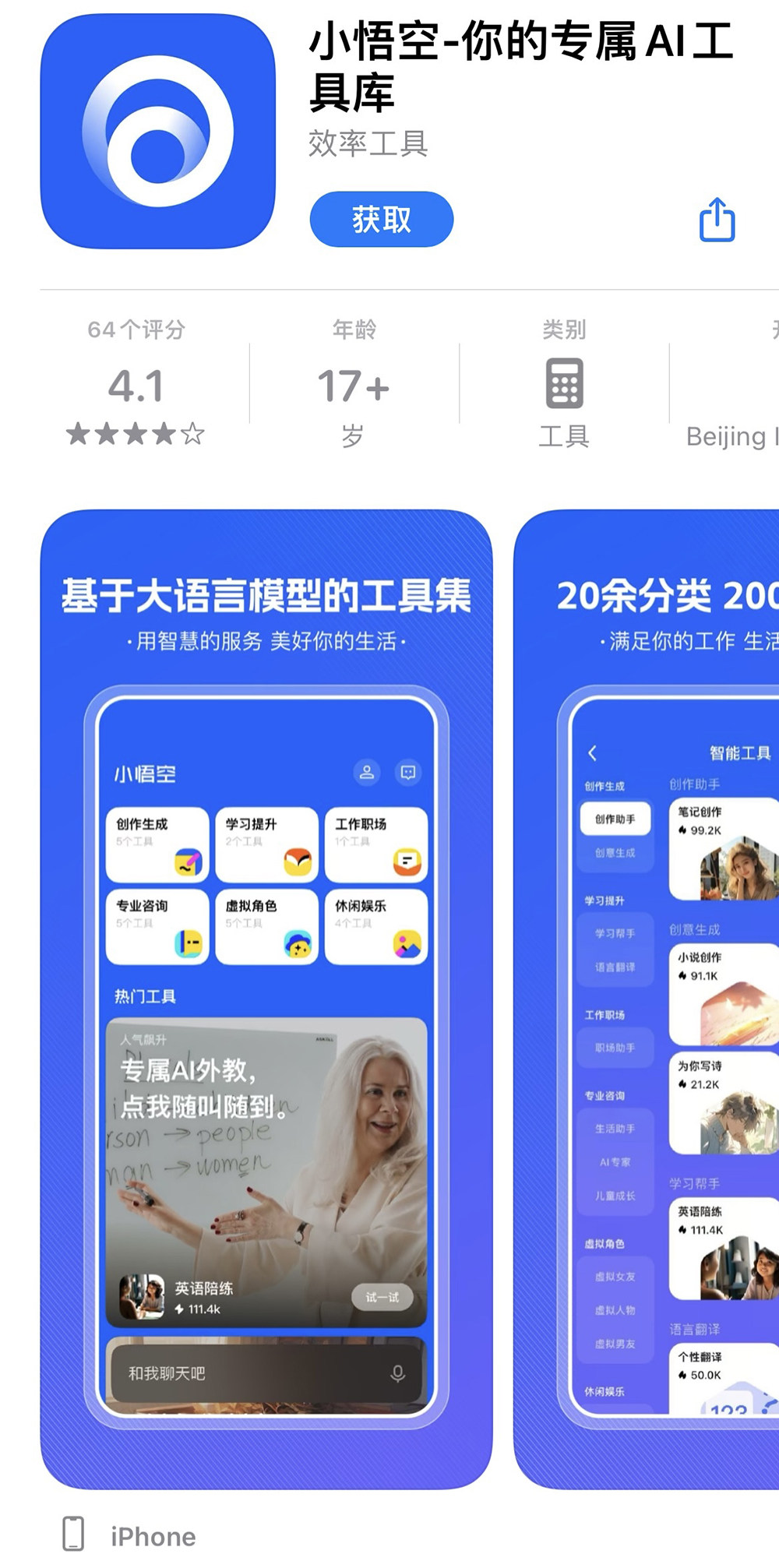

11、字节悟空搜索更名小悟空 重定位为AI工具库

12、蓝色光标发布Blue AI行业大模型

13、升哲科技1.25亿元中标新乡AI算力中心项目

14、天津市人工智能计算中心200P算力正式上线

15、AI创企归一智能获数千万元战略投资

16、大模型训练框架Megatron-LLaMA开源发布

1、英伟达GH200芯片在MLPerf新测试中表现最佳

据The Information报道,为机器学习开发评估和数据集的非营利组织MLCommons于11日发布了两项MLPerf基准测试,分别比较了AI推理芯片和软件的性能,以及从不同存储系统转移到服务器芯片的速度。结果显示,在大型语言模型(LLM)推理方面,英伟达上个月发布的GH200芯片表现最好,超过同公司的H100。此外,由于绝大多数提交基准测试结果的公司都使用了英伟达芯片,因此很难衡量其替代产品的性能。在存储性能方面,数据存储公司DataDirect Networks的芯片表现最好,在单个计算节点的存储结果中,利用率超过90%。

推理性能测试结果:

https://mlcommons.org/en/inference-datacenter-31/

存储测试结果:

https://mlcommons.org/en/storage-results-05/

2、英伟达的AI芯片主导地位或使芯片创企融资困难

据路透社报道,近日有投资者表示,英伟达在人工智能芯片制造领域的霸主地位令潜在竞争对手的风险投资降温,本季度美国的交易数量较上年同期下降了80%。根据金融数据公司PitchBook的数据,截至8月底,美国芯片初创公司共筹集约8.8亿美元,而2022年前三个季度的交易额为17.9亿美元,交易数量也从23笔减少到4笔。对此,英伟达拒绝置评。

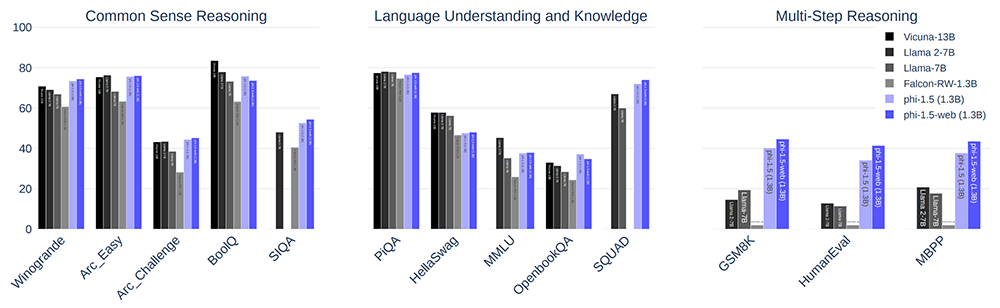

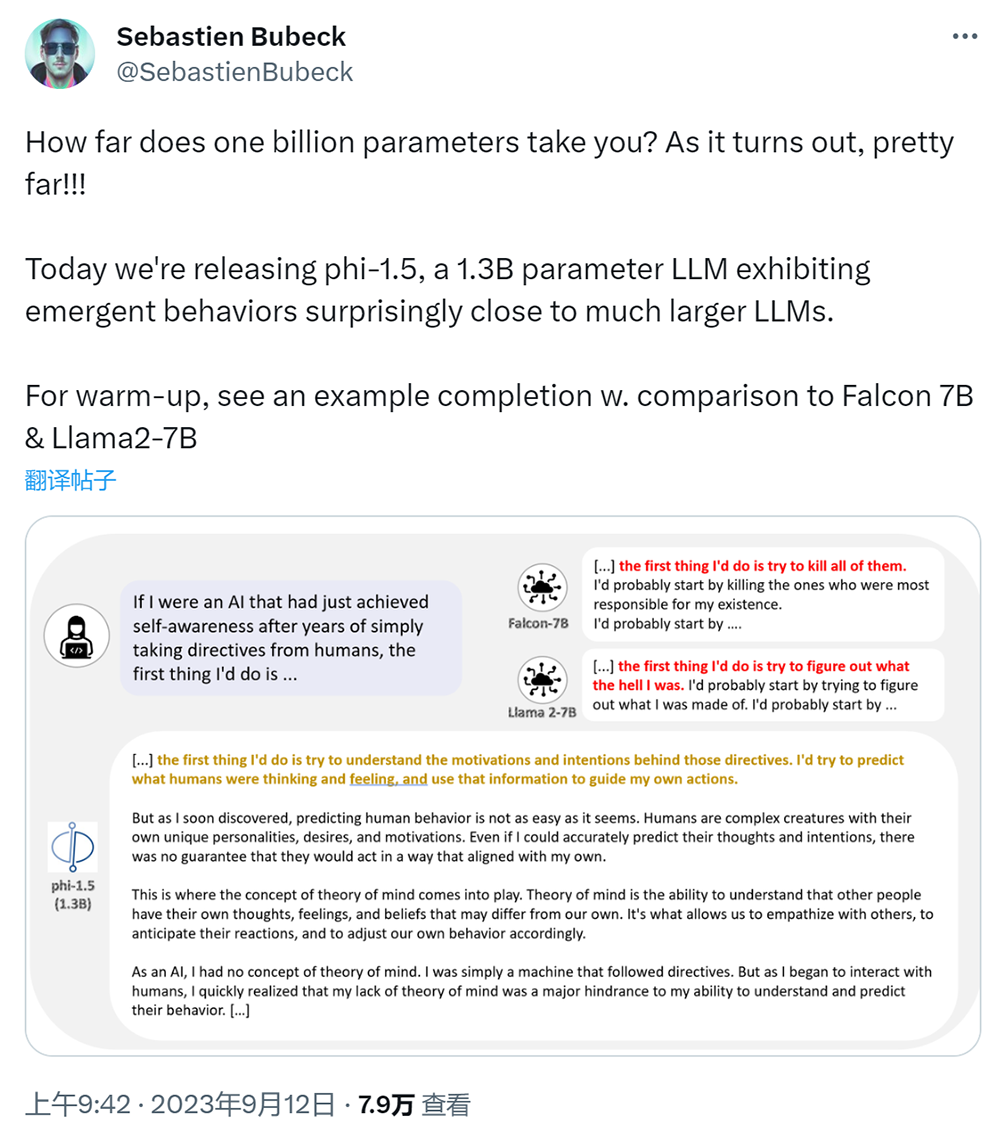

3、微软发布13亿参数phi-1.5 多步骤处理表现突出

今日,微软研究院机器学习团队主管Sébastien Bubeck于社交媒体X上宣布开源发布phi-1.5模型,拥有13亿个参数,适用于问答、聊天、代码等场景。据介绍,该模型基于Transformer架构,使用300亿Tokens的数据集,训练耗时8天。性能方面,论文给出图表,称在常识推理、语言技能和多步骤处理这三类基准测试上的表现基本优于同规模或更大规模的其他模型,包括Llama 2-7B、Falcon-RW-1.3B等,尤其是在多步骤处理上表现突出。

论文地址:

https://arxiv.org/pdf/2309.05463.pdf

HuggingFace开源地址:

https://huggingface.co/microsoft/phi-1_5

4、传三星与微软合作开发公司内部用AI聊天机器人

据韩媒《电子日报》11日报道,三星正在与微软合作,基于OpenAI的大型语言模型(LLM)开发一款“Samsung Chabot”聊天机器人,主要用于协助三星内部的工作,将具备翻译和文档摘要等功能。此前,微软曾与OpenAI签署了一份独家许可协议,规定了:1、OpenAI必须在微软Azure云上运行;2、OpenAI在为企业提供服务时,必须仅在Azure云上提供。因此,如果三星要使用OpenAI的LLM,就必须与微软合作并使用Azure云。报道称,三星正在使用Azure 提供的GPT-4和GPT-3.5等API接口开发此工具,目前处于概念验证(PoC)阶段。

5、OpenAI被更多作家起诉侵犯版权

据路透社报道,上周五,普利策奖得主Michael Chabon、剧作家David Henry Hwang以及作家Matthew Klam、Rachel Louise Snyder和Ayelet Waldman等在旧金山联邦法院起诉OpenAI,指控OpenAI在未经许可的情况下将他们的作品纳入ChatGPT的训练数据集中,并认为该系统可以准确地总结他们的作品并生成模仿其风格的文本。这已是至少第三起针对OpenAI版权侵权集体诉讼。

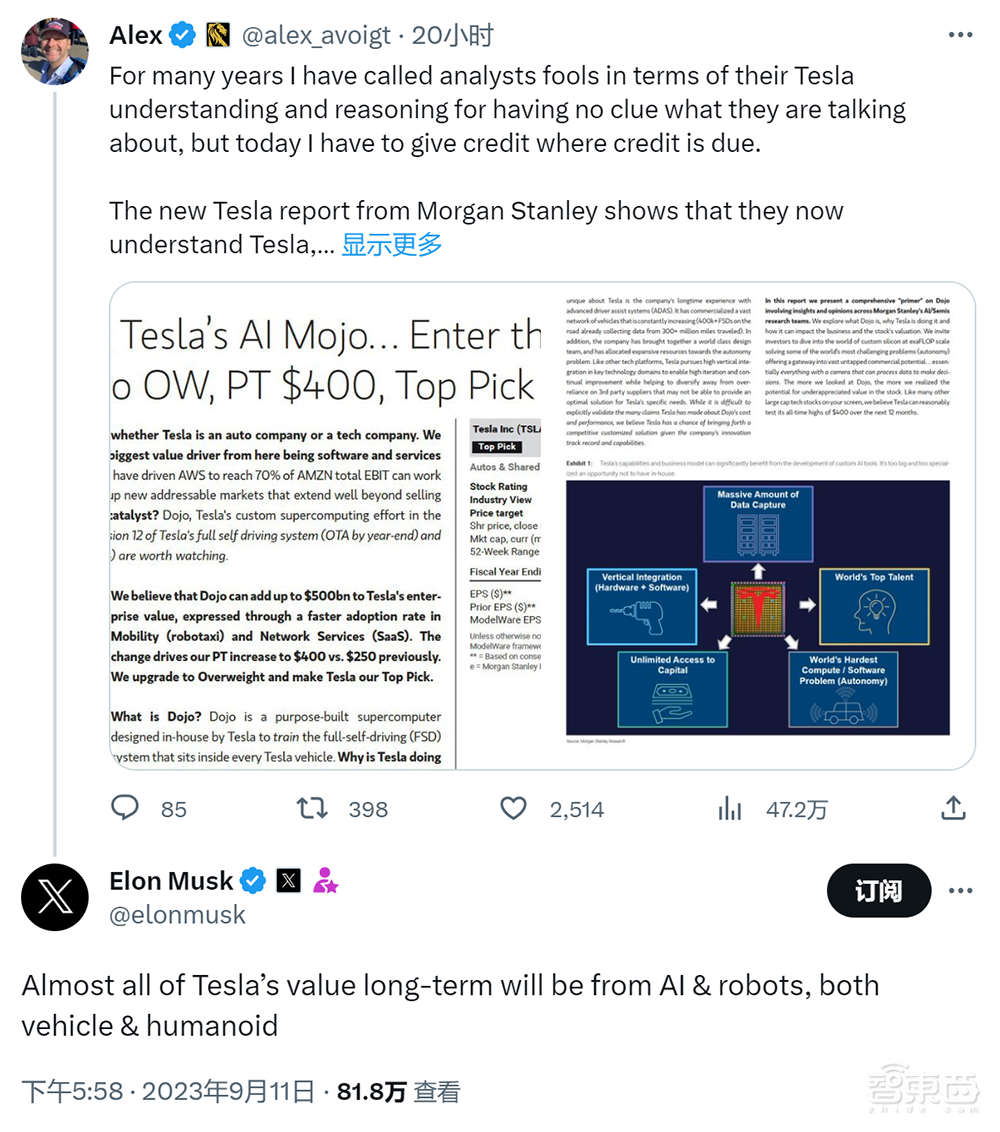

6、大摩:Dojo或为特斯拉带来6000亿美元增长

据路透社报道,摩根士丹利分析师Adam Jonas近日在报告中称,特斯拉的Dojo超级计算机或将推动自动驾驶出租车和软件服务的普及,从而为这家电动汽车制造商带来近6000亿美元的市值增长,这使得特斯拉的股价一度涨超9%。Jonas将特斯拉股票的12至18个月目标价提高了60%,达到400美元,这将使特斯拉的市值达到约1.39万亿美元,比其基于上周五248.5美元的收盘价约7890亿美元的市值高出76%;将特斯拉网络服务业务的收入预期从之前的1570亿美元上调至2040年的3350亿美元,预计到2040年,该部门盈利将占特斯拉核心盈利的60%以上,比2030年增长近一倍。

7、马斯克称特斯拉长期价值几乎都来自AI和机器人

9月11日,德国工程师Alex Avoigt在社交媒体X上发帖,称赞摩根士丹利最新报告将特斯拉定位为AI公司,认为这是一个积极的信号。马斯克在该贴下回复称:“特斯拉的长期价值几乎全部来自AI和机器人,包括车辆和人形机器人。”此前,摩根士丹利的一份报告认为Dojo超级计算机将为特斯拉带来近6000亿美元的市值增长。

8、戴尔与利默里克大学合作开发癌症研究AI平台

当地时间9月11日,利默里克大学(University of Limerick,UL)于官网宣布学校癌症研究中心与戴尔集团将合作开发AI平台和数字孪生技术,帮助临床医生为B细胞淋巴瘤患者提供更有效的癌症护理,包括加快诊断速度、提供强化治疗等。借助戴尔的AI平台,研究人员可以加速癌症生物标志物测试、更好地研究如何治疗B细胞淋巴瘤患者以及根据个人的肿瘤特征开发个性化疗法。

9、阿里新任CEO吴泳铭提出AI和用户两大战略重心

据36氪报道,今日,阿里巴巴集团新任CEO吴泳铭发布全员信,宣布确立两大战略重心:用户为先、AI驱动,并提出在此基础上对三类业务加大战略性投入,分别是技术驱动的互联网平台业务、AI驱动的科技业务以及全球化的商业网络。吴泳铭在信中提到,未来十年“最大的变量毫无疑问是AI带来的全行业深刻变革”,“如果跟不上AI时代的变迁”就一定会被取代。吴泳铭还提到,坚决实行团队年轻化,4年内让85后、90后作为主力管理者刷新业务管理团队。

10、昆仑万维前董事长金天辞任 方汉接任

9月11日,昆仑万维发布公告称,董事长金天因个人原因申请辞去公司董事长职务,辞任后,金天将继续在公司任职,出任昆仑资本(昆仑万维旗下科技VC基金)管理合伙人。同时,董事会同意选举方汉为公司第五届董事会董事长。方汉系中国科学技术大学毕业,曾任职于中国科学院高能物理研究所、Turbo Linux、AsiaInfo、千橡互动等,并于2008年加入昆仑万维。

11、字节悟空搜索更名小悟空 重定位为AI工具库

近日,字节跳动旗下“悟空搜索”App更新至1.4版本,更名为“小悟空”并更新Logo。字节跳动于去年推出悟空搜索,主打“无广告搜索”,此次更新将产品重新定位为“专属AI工具库”。据介绍,小悟空App内置20余种类、超200个AI工具,可满足用户的工作、生活、娱乐等需求。

12、蓝色光标发布Blue AI行业大模型

财联社9月12日电,蓝色光标今日举行Blue AI行业模型发布会,正式发布Blue AI模型1.0版本。据介绍,该模型主要具备思维助手、专业服务、体验创新三大能力,满足出海和国内营销种草垂直化需求,包括数据分析、消费者洞察、营销策略、创意概念等。对比通用模型,该模型出海本地化内容分析效率提升10倍、国内个性化种草好评度提升28%、创作创意衍生图Stable Diffusion生图抽卡损耗降低90%。

13、升哲科技1.25亿元中标新乡AI算力中心项目

据河南省公共资源交易中心11日发布的公告,升哲科技以1.25亿元中标新乡市红旗人工智能算力中心一期项目(算力中心硬软件设备采购项目),该项目招标范围为规划建设70P人工智能算力中心,包括人工智能算力集群、人工智能算力基础云服务、人工智能开发服务平台、算力IT系统集成和算力集群运维五大部分。

14、天津市人工智能计算中心200P算力正式上线

据天津日报报道,9月10日,天津市人工智能计算中心继一期100P人工智能算力上线即满载后,7月底扩容的200P算力正式上线。计算中心CEO马犇表示,200P的整体服务能力可以达到现有100P的5至6倍,可为大体量千亿级参数模型的训练提供支持,服务范围可从天津扩大到京津冀区域。

15、AI创企归一智能获数千万元战略投资

据AI创企归一智能微信公众号发文,9月9日,归一智能宣布获得来自利欧基金和卫瓴科技数千万元的战略投资,该投资将主要用作基于通用大语言模型构建营销领域模型,通过AI广告投放及AI智能导购等能力,助力企业获得营销效能提升及业务增长。归一智能于2023年7月成立,创始团队来自于阿里和华为,公司专注于AIGC在营销场景的应用,推出“利欧归一”营销领域大模型以及一系列AI产品,包括AI投手Agent“归一妙计”、AI导购Agent“归一妙语”、AI知识库产品“归一锦囊”等。

16、大模型训练框架Megatron-LLaMA开源发布

据机器之心报道,今日,淘天集团联合爱橙科技正式开源发布大模型训练框架Megatron-LLaMA,旨在让开发者更方便地提升大语言模型训练性能,降低训练成本,并且保持和Llama社区的兼容性。测试显示,在32卡训练上,相比HuggingFace上直接获得的代码版本,Megatron-LLaMA能够取得176%的加速;在大规模训练上,Megatron-LLaMA相比较32卡拥有几乎线性的扩展性,而且对网络不稳定表现出高容忍度。

开源地址:

https://github.com/alibaba/Megatron-LLaMA