智猩猩定位硬科技讲解与服务平台,提供公开课、在线研讨会、讲座、峰会等线上线下产品。

「AI新青年讲座」由智猩猩出品,致力于邀请青年学者,主讲他们在生成式AI、LLM、计算机视觉、机器学习等人工智能领域的最新重要研究成果。

AI新青年是加速人工智能前沿研究的新生力量。AI新青年的视频讲解和直播答疑,将可以帮助大家增进对人工智能前沿研究的理解,相应领域的专业知识也能够得以积累加深。同时,通过与AI新青年的直接交流,大家在AI学习和应用AI的过程中遇到的问题,也能够尽快解决。

「AI新青年讲座」现已完结233讲;有兴趣分享学术成果的朋友,可以与智猩猩教研产品团队进行邮件(class@zhidx.com)联系。

大语言模型在自然语言处理领域的卓越表现已引起广泛瞩目,然而其对计算资源和硬件设施的高要求成为了广泛应用的一大挑战。

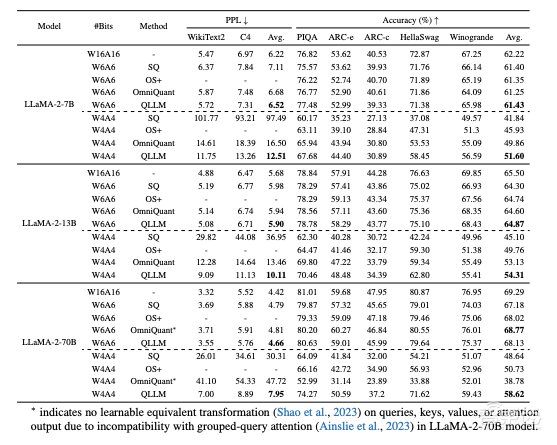

针对这一难题,来自莫纳什大学、北航、商汤的研究者创新性地提出了一种名为 QLLM 的高效、精准的低比特量化方法。QLLM 通过引入自适应通道重组机制,巧妙地将离群值所携带的能量重新分布至其他通道,有效缓解了这些极端值对量化动态范围的影响。

此外,为补偿量化过程中的性能损失,研究者设计了一种仅涉及学习少量低秩权重的低成本微调方法。大量实验表明,QLLM 不仅在性能上显著优于现有量化方法,而且在训练效率上实现了大幅提升。QLLM 现已被 ICLR 2024 收录为 Poster。

2月26日晚7点,「AI新青年讲座」第234讲邀请到 QLLM 一作、莫纳什大学 ZIP Lab 在读博士刘璟参与,主讲《大语言模型的高效低比特量化》。

讲者

刘璟,莫纳什大学ZIPLab在读博士;师从庄博涵和蔡剑飞教授,主要研究方向为 Efficient AI,在 NeurIPS、ICLR、CVPR、ICCV、ECCV、AAAI、TPAMI 等顶级会议和期刊上发表多篇论文,Google Scholar 引用1200+。

第234讲

主 题

《大语言模型的高效低比特量化》

提 纲

1、大语言模型低比特量化难点

2、精确且高效的后训练量化方法 QLLM

3、低成本微调方法

4、在 LLaMA-1/2 上的量化性能评估

直 播 信 息

直播时间:2月26日19:00

直播地点:智东西公开课知识店铺

成果

论文标题:《QLLM: Accurate and Efficient Low-Bitwidth Quantization for Large Language Models》

论文地址:https://arxiv.org/pdf/2310.08041.pdf

开源代码:https://github.com/ModelTC/QLLM