「智猩猩机器人新青年讲座」由AI与硬科技知识分享社区「智猩猩」于今年全新企划,旨在邀请全球知名高校、顶尖研究机构以及优秀企业的青年学者,主讲在具身智能、强化学习、多智能体系统、建模仿真等机器人关键前沿技术上的研究成果和开发实践。

目前讲座已完结两讲,错过直播的朋友,可以点击文章底部“阅读原文”观看回放!

近年来,以DeepMind的Gato为代表的智能体以及以GPT-4V、LLaVA等为代表的多模态大语言模型在自然语言处理、视觉理解、机器人等任务上取得了显著的成果。

但是这类模型普遍基于二维图片文本数据训练得到,无法理解人类所处的三维物理世界,并缺乏与三维世界的交互能力。而想要实现通用人工智能,必须要构建一个能够理解人类生活的物理世界,并能够自主实现大量任务,具有情感和价值判断的智能体。为解决当前问题,北京通用人工智能研究院联合北京大学、卡内基梅隆大学和清华大学的研究人员提出了首个精通3D任务的具身智能体LEO。

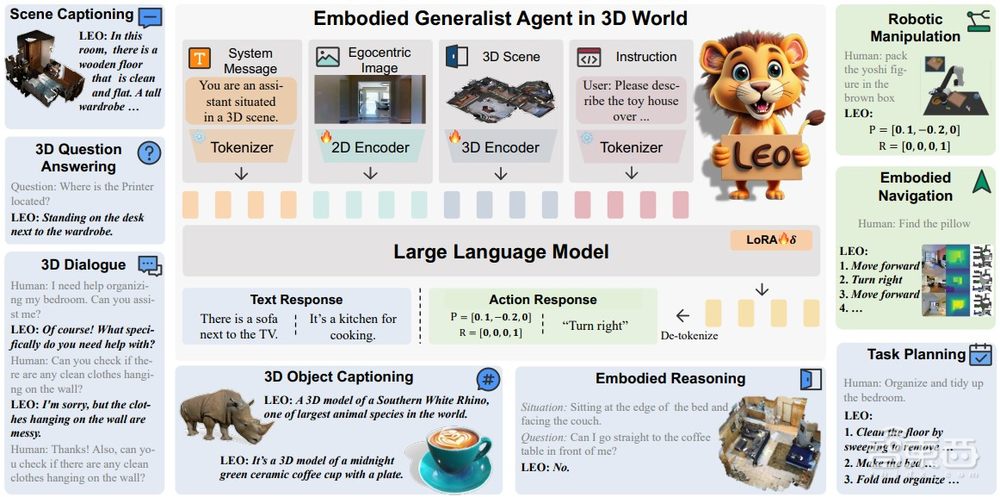

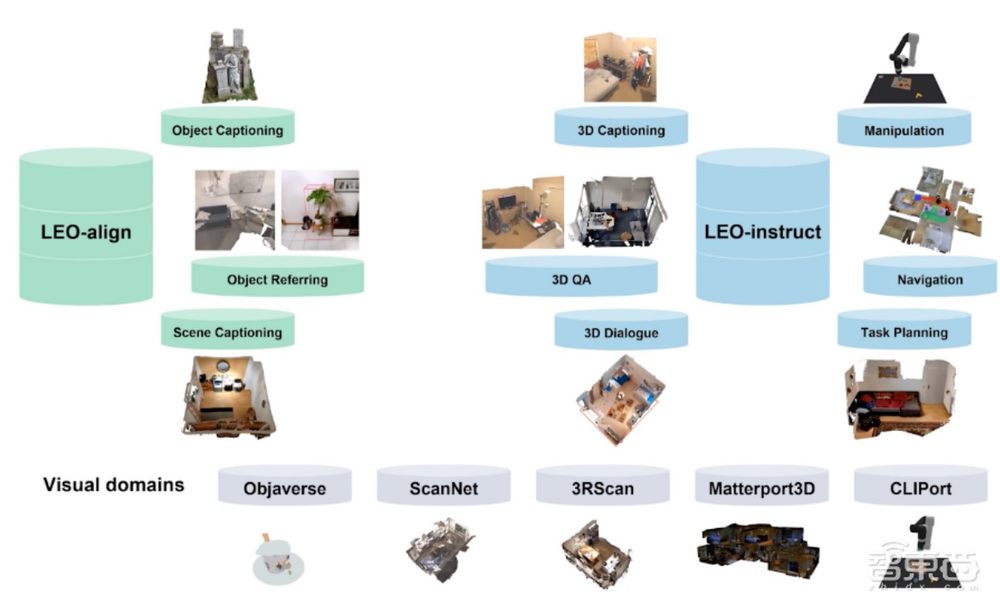

具身智能体LEO以大语言模型为基础,具备强大的三维场景感知能力及优秀的视觉-语言-动作(VLA)能力,能够完成包括问答(3D QA)、描述(3D captioning)、具身推理(embodied reasoning)、具身导航(embodied navigation)、机器人操作(robotic manipulation)在内的多种任务。

此外,该团队还提出了生成高质量三维视觉语言数据的方法,构建了视觉-语言-动作(vision-language-action)指令微调的大规模数据集,用来支撑智能体的学习。

3月26日晚7点,智猩猩邀请到论文一作、北京大学在读博士、北京通用人工智能研究院实习研究员黄江勇参与「智猩猩机器人新青年讲座」第3讲,主讲《三维世界中的具身通用智能体LEO》。

讲者

黄江勇,北京大学在读博士

北京大学智能学院博士生,北京通用人工智能研究院实习研究员。师从黄思远博士和朱松纯教授。研究方向主要包括通用视觉、多模态学习、具身智能、视觉机器人。

个人主页: https://huangjy-pku.github.io

第3讲

主 题

《三维世界中的具身通用智能体LEO》

提 纲

1、研究动机及背景

2、具身通用智能体LEO

3、视觉-语言-动作的综合指令微调数据集

4、实验结果及demo展示

直 播 信 息

直播时间:3月26日19:00

直播地点:智猩猩知识店铺

成果

论文标题

《AN EMBODIED GENERALIST AGENT IN 3D WORLD》

论文链接

https://arxiv.org/abs/2311.12871

项目主页

https://embodied-generalist.github.io

代码链接

https://github.com/embodied-generalist/embodied-generalist

报名方式

对本次讲座感兴趣朋友,可以扫描下方二维码,添加小助手莓莓进行报名。已添加过莓莓的老朋友,可以给莓莓私信,发送“机器人讲座03”进行报名沟通。对于通过报名的朋友,莓莓将在直播当天为大家发送直播地址。

同时,针对本次讲座,也组建了学习群,直播开始前,将会邀请通过入群审核的相关朋友入群,进行学习和讨论。