芯东西(公众号:aichip001)

作者 | Zero

编辑 | 漠影

芯东西4月15日报道,国际半导体设计与软件平台公司Arm于4月9日宣布推出其迄今性能最高且能效最佳的Ethos NPU产品——Arm Ethos-U85神经网络处理器(NPU),以及全新物联网参考设计平台Arm Corstone-320。

Arm Ethos-U85 NPU性能提升4倍,可为边缘侧和端侧设备上采用Transformer架构的现有和未来工作负载提供支持,适用于工厂自动化和商用或智能家居摄像头等高性能边缘AI应用。

Corstone-320集成了前沿的嵌入式IP和虚拟硬件,可加速语音、音频和视觉系统的部署,例如实时图像分类和目标识别,或在智能音箱上启用具有自然语言翻译功能的语音助手。

Arm物联网事业部业务拓展副总裁马健(Chloe Ma)在技术媒体沟通会上分享说,两款新品满足了边缘AI用例对更高性能计算的需求,为最新的AI模型、框架提供了原生支持,并沿用Arm软件与AI开发者已经熟知的工具链,具有投资复用、上手容易等优势。

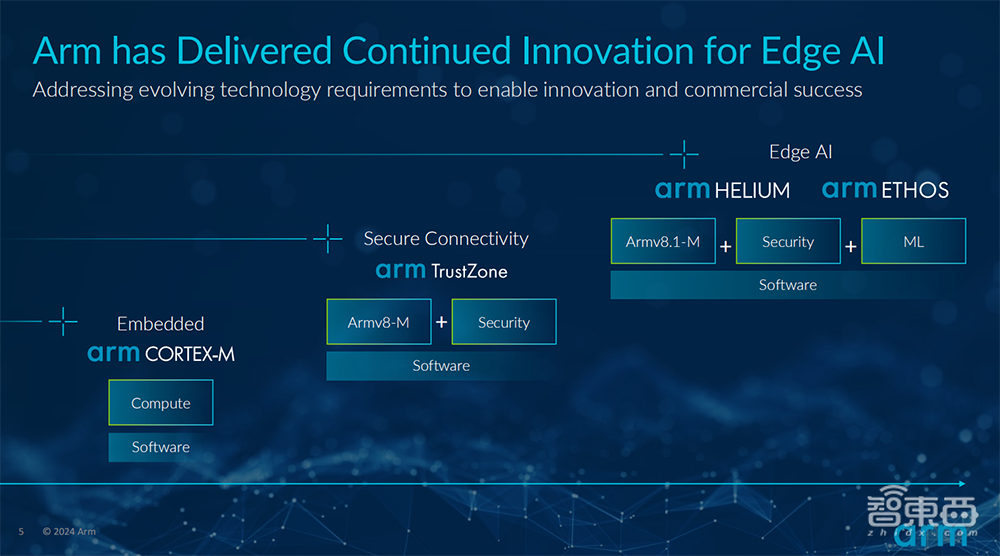

目前,全球约有90%的AI都运行在基于Arm架构的CPU上,这些持续投入使Arm成为全球最普遍的AI计算平台之一。

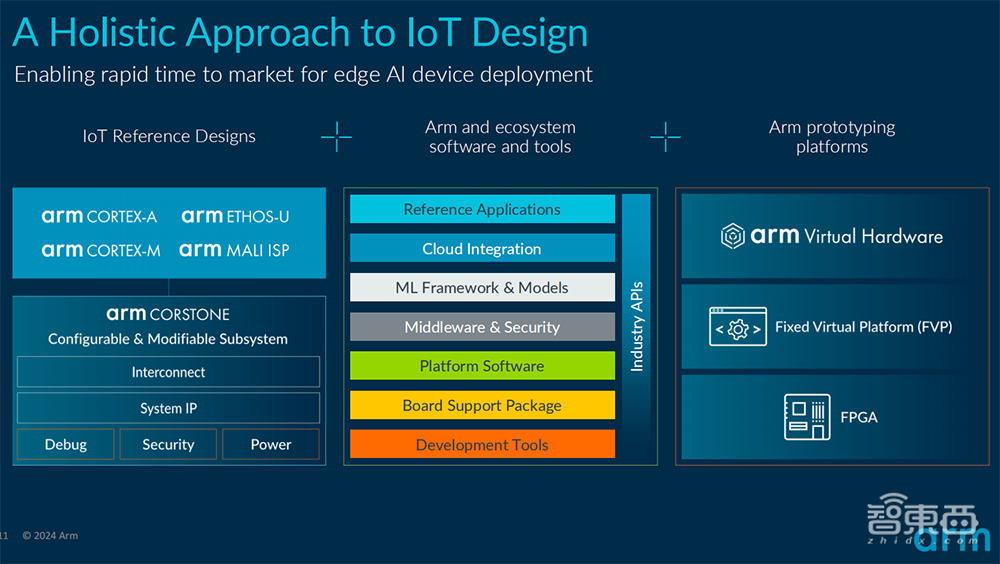

随着边缘AI的持续扩展,物联网生态链上下游的芯片与系统供应商、算法软件开发者与集成商们越来越汇聚于Arm计算平台。在马健看来,只有Arm计算平台才能提供AI从云到端、现代敏捷开发和部署流程中所需的特性和功能,实现基于量产验证的一致架构,并采用统一工具链的AI转型。

一、Ethos-U85 NPU:提供高能效边缘推理能力,性能提升4倍

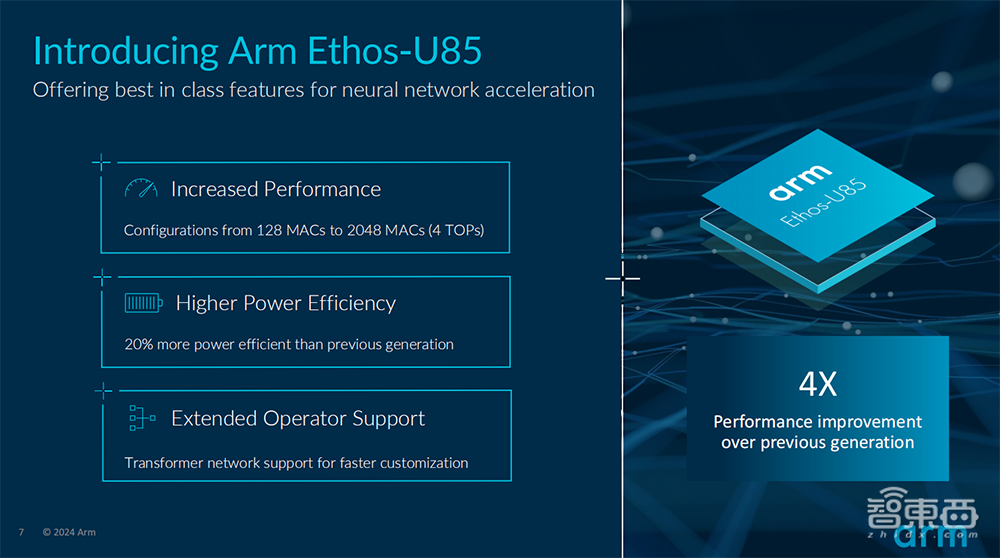

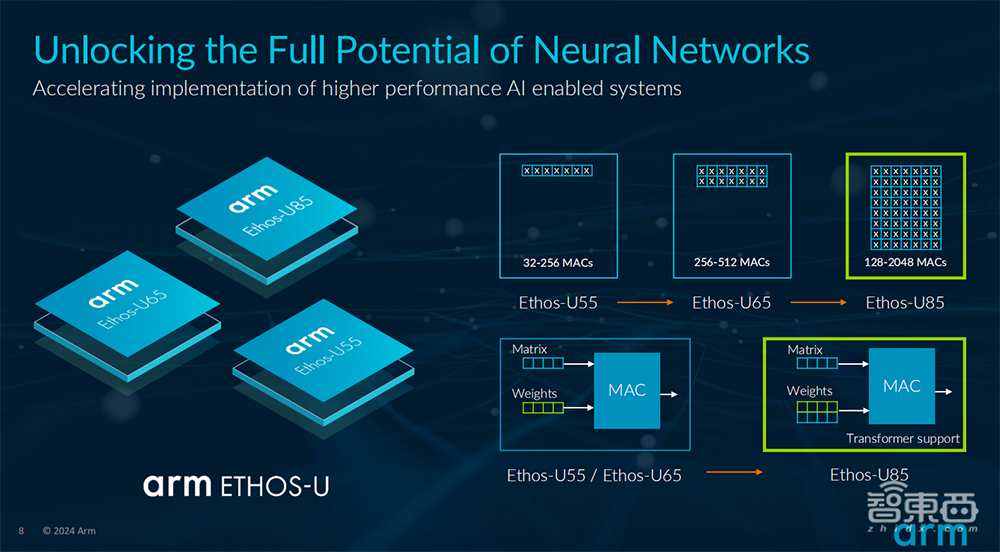

Arm Ethos-U85 NPU是Arm Ethos-U产品线中第三代面向边缘AI的NPU产品,也是迄今为止性能和能效最强的Ethos NPU。

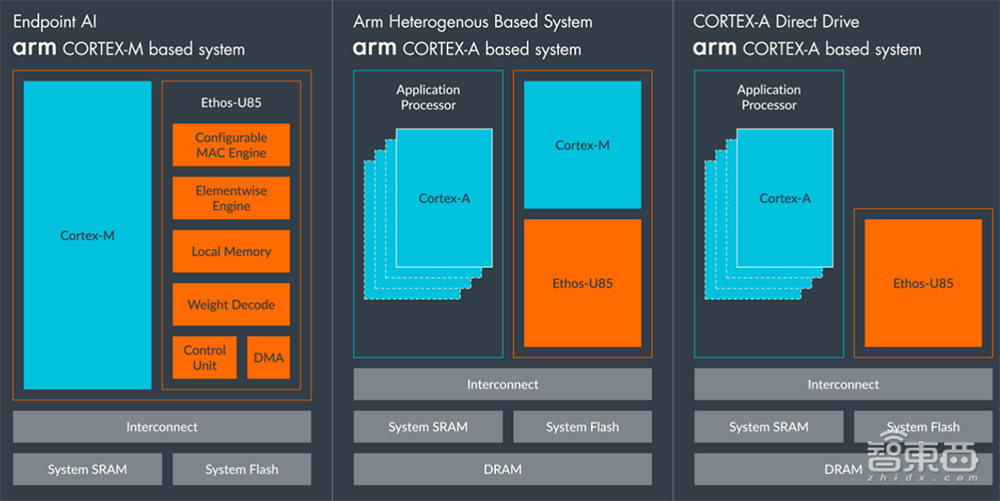

与上一代产品相比,Ethos-U85性能提升4倍,能效提高20%,可在主流网络上实现高达85%的利用率,专为搭配基于Cortex-M或Cortex-A的系统一同运行而设计,并容忍高DRAM延迟。

Ethos-U85内部SRAM为29~267KB,多达6个 128位AXI5接口。该NPU单周期支持从128到2048个MAC单元的配置,在1GHz时,算力可支持从256GOPS到4TOPS。

它支持元素级算子链化。通过链化将元素级运算与先前的运算相结合,使SRAM不必先写入再读取中间张量,由此可凭借NPU和内存之间数据传输量的减少,提高NPU的效率。

相比于Ethos-U65,链化是Ethos-U85在效率提升上的新功能之一,其他还有快速的权重编码器、优化的MAC阵列能效、提升的元素效率。

精度方面,它支持int8权重和int8或int16激活,硬件原生支持2/4稀疏性,使吞吐量翻倍。

Ethos-U85支持与上一代Ethos-U系列产品相同的软件工具链, 即使用TFLmicro运行时,以实现无缝的开发者体验,并支持TensorFlow Lite和PyTorch等AI框架,未来预计将支持面向边缘设备的PyTorch运行时ExecuTorch。

该NPU可用于与Ethos-U55和Ethos-U65相同的系统配置流程,并支持从基于Cortex-A的系统直接驱动Ethos-U85的功能。

除了Ethos-U55和Ethos-U65目前支持的算子,通过支持TRANSPOSE、GATHER、MATMUL、RESIZE BILINEAR、ARGMAX等运算,Ethos-U85涵盖了对Transformer模型和DeeplabV3语义分割网络的原生硬件支持。

Ethos-U85不仅提供卷积神经网络(CNN)所需的权重矩阵乘的运算,还支持Transformer架构网络的一个基本组成部分——矩阵相乘,有助于优化大模型边缘落地微调的时间、提升模型泛化。

在视觉和生成式AI用例中,Transformer架构对于理解视频、填充图像的缺失部分或分析来自多个摄像头的数据以进行图像分类和目标检测等任务非常有效。

Ethos-U85支持的算子将在NPU上进行加速,对于特殊算子不支持的情况,部分算子将调用CMSIS-NN库实现在Cortex-M系统上进行加速。如在tinyLlama的用例中,该模型算子可完全映射到Ethos-U85,没有算子回退到CPU。

迄今Arm Ethos NPU系列产品已有逾20家授权许可合作伙伴,Alif Semiconductor和英飞凌是全新Arm Ethos-U85 NPU的早期采用者。

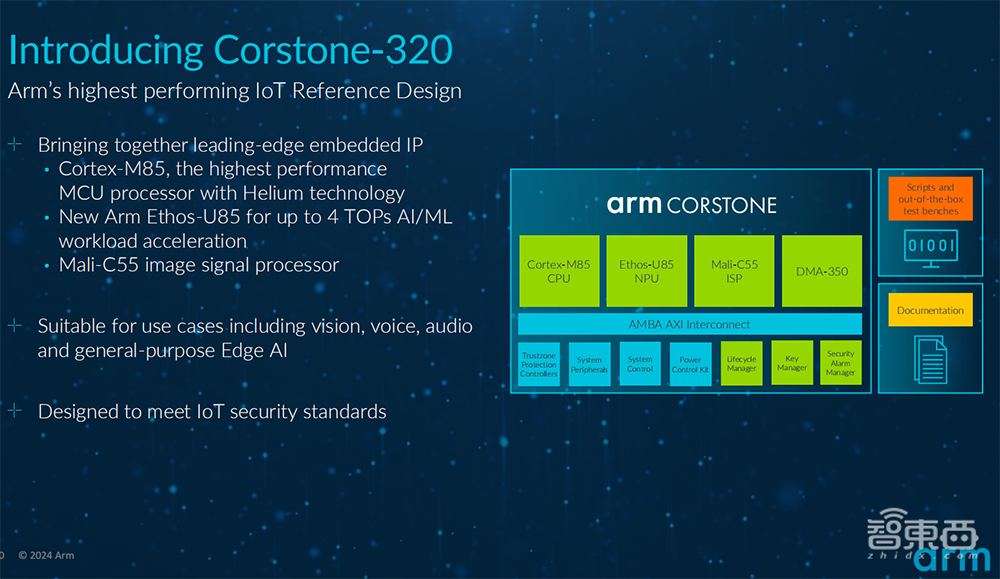

二、Corstone-320:全新物联网参考设计平台,加速语音、音频和视觉系统部署

Arm Corstone-320物联网参考设计平台集成了Arm最高性能的Cortex-M CPU——Cortex-M85、Mali-C55 ISP和全新Ethos-U85 NPU,并提供软件、工具和支持,包括Arm虚拟硬件。

Mali-C55集成了高分辨率图像处理能力(可支持4800万像素的图像分辨率)、能效、可配置性及高图像质量,适用于广泛的物联网视觉应用。

同时高度可配置的直接内存访问控制器DMA-350可实现高效的数据移动,从而提高系统性能和能效,并支持Arm TrustZone技术。

Cortex-M85还集成了指针验证和分支目标识别 (PACBTI) 安全技术,可抵御返回导向编程 (ROP)和跳转导向编程 (JOP) 的安全漏洞攻击。

总的来说,Corstone-320带来了以下优势:

1)提高性能和能效:通过提升计算吞吐量,为各种物联网设备和用例提供合适的算力;提高可持续性,以及延长电池续航时间。

2)改善内存带宽:对数据宽度和内存通道等内存带宽方面进行改善,从而为像素流提供全系统范围的互连带宽。

3)一系列电源模式:包括睡眠模式、待机模式和电源岛。

4)降低设计成本,并缩短工程时间:通过“开箱即用的”Corstone-320,设计人员和工程师能够立即启动SoC设计。

5)更多的安全功能:包括启动时和运行时的安全机制,都集成至系统中。

6)可观察性:内置了所有组件的全面调试和跟踪功能。

7)改进的灵活性:设计针对不同的细分市场、设备和用例中进行定制。

8)一系列的软件支持:包括大量开源软件等一系列的软件支持,可降低总体成本和复杂性。

其软硬件结合特性将使开发者能够在物理芯片就绪前便启动软件开发工作,从而加速推进产品进程,为日益复杂的边缘AI设备缩短上市时间。

Corstone-320套件还涵盖了技术参考手册、配置和渲染脚本以及验证报告,以便ASIC开发者能根据特定市场的需求构建SoC,或在开始定制设计前使用此套件探索Arm的计算设计概念。

三、大模型落地边缘侧,有哪些趋势与挑战?

大模型和生成式AI正走向边缘和终端,通过量化、剪枝和聚类技术来缩减模型。大小模型云边端结合成为未来AI产品的重要发展趋势。

马健谈道,相较于此前的AI技术,大模型和生成式AI最大的优势是泛化能力及对多模态的支持,另外大模型和多模态的优势是微调时间,用较少的新样本进行模型的重新训练和微调,使这些模型很快适应之前没有看到过的新环境。

她期待未来通过大模型和多模态,物联网碎片化问题能得到更好的改进,AI会从一个单一功能到多功能甚至是向通用AI演进,这样的演进方式也非常适合搭载Arm推出的通用处理器。

谈到在边缘部署大模型的挑战,马健主要提及三点:

第一,模型的成熟度。很多模型厂家聚焦在大模型的训练上,他们越来越多地开始关注边缘 AI,但这需要一个过程。边缘AI要通过模型量化与聚类等技术把大模型缩小,变成相对小的模型,才更适于在边缘设备上的部署。

第二,边缘AI平台的开发。过去很多边缘AI加速器只支持卷积神经网络 (CNN) ,而Arm Ethos-U85可实现对Transformer模型原生支持。

第三,整个生态链的支持,以及对大模型量化并在边缘部署的工具链的支持。

她谈道,Arm已经为挑战物联网与大模型、多模态AI结合的性能与效率极限做好准备,边缘AI的广泛部署已趋向成熟,此次Arm全新推出的Corstone-320和Ethos-U85能够释放大模型和多模态AI在边缘部署的巨大潜力。

结语:Arm正在IP、参考设计和软件标准上持续投入

在带来机遇的同时,边缘AI带来了一些新的挑战,包括在计算能力与能效之间找到合适的平衡、保护数据安全和隐私、制定软件定义和适于软件移植的标准等等。

Arm高级副总裁兼物联网事业部总经理Paul Williamson认为,随着边缘AI的部署规模持续扩大,芯片创新者必须应对日趋复杂的系统和软件、不断激增的AI性能需求,以及加速产品上市进程的压力。与此同时,软件开发者需要更加一致、简化的开发体验,并能更轻松地与新型的AI框架和库实现集成。

为了帮助整个边缘AI生态应对这些挑战,Arm正在IP、参考设计和软件标准上持续投入,尤其是在软件和工具链方面加强投资,与一系列软件算法与工具伙伴合作,以确保为边缘AI系统开发者提供其所需的工具和支持。