智东西(公众号:zhidxcom)

作者 | GenAICon 2024

智东西5月6日报道,2024中国生成式AI大会于4月18-19日在北京举行,在大会第二天的主会场AIGC应用专场上,天图万境创始人图拉古以《我们的AIGC,AIGC的我们》为题发表演讲。

天图万境是中国视听行业尝试用AI工具做文本扩写、图像生成、数字人合成制作的先行者,比一些国际顶流AI工具的问世时间更早。图拉古说,天图万境迄今已拥有中国视听领域最专业的垂直AI大模型集群,并在今年与华为联合推出Sora Opera,能给各式视频配音。

图拉古在演讲中相当敢说,金句频出,分享了自己创业路上“血淋淋的经验和教训”,或者调侃创业者“不要起太早,容易看不到曙光,因为资本看不懂”,称“追风的人没法飞起来”;或者吐槽自媒体用“炸裂”、“吊打”、“惊艳”等词汇是瞎说,直言短期内搞不定通用大模型,预测“大部分AI大模型创业公司在5年内死去”。

在他看来,AI应该是能够给人们带来温暖、弥合世界的创作工具,而不是取代人类工作的“内卷武器”。因此AI不能离开应用谈技术,而是要建立到应用端的完整产业链。天图万境从AI文本创作,到视频生成,再到服务用户的应用端,打造了全产业链技术解决方案,且都早于国际巨头发布了对应产品,目前正在快速迭代中。

其声音生成工具Sora Opera,可以自动感知、智能识别视频画面中的物理逻辑,精准配出风格多变的音乐音效,为视频增加声音的魅力。还有声音克隆工具SoundMax,不走传统TTS路线,而是将输入的人声转换成其他声线。这样的AI工具,不会让配音演员失业,而是让他们在演绎不同角色时插上飞翔的创意翅膀。

以下为图拉古的演讲实录:

首先介绍一下我自己,我是图拉古,是一个“帽子”搜集大师,我有很多帽子,最喜欢前三个帽子,天图万境的创始人、中国导演、科研从业者。

我还有一个属性,我是跨行业的从业者,而且在一线,我是以导演的身份拍摄了很多国际大片,也拍了很多国内的片子。我从事计算机编程和AI,自己写代码。

第三个,我自己做电路设计,做电路绘画,做生产。我是一个沉浸式爱好者,经常玩各种剧本杀、密室逃脱。原来AI需要视听行业的人参与进来,但是视听行业的人又不知道该怎么开发,我碰巧介于这之间,我的优势逐渐凸显出来。

我分享的主题是:AIGC的我们,我们的AIGC。

一、比MidJourney更早探路图像生成,但起太早容易看不到曙光

先说“AIGC的我们”。

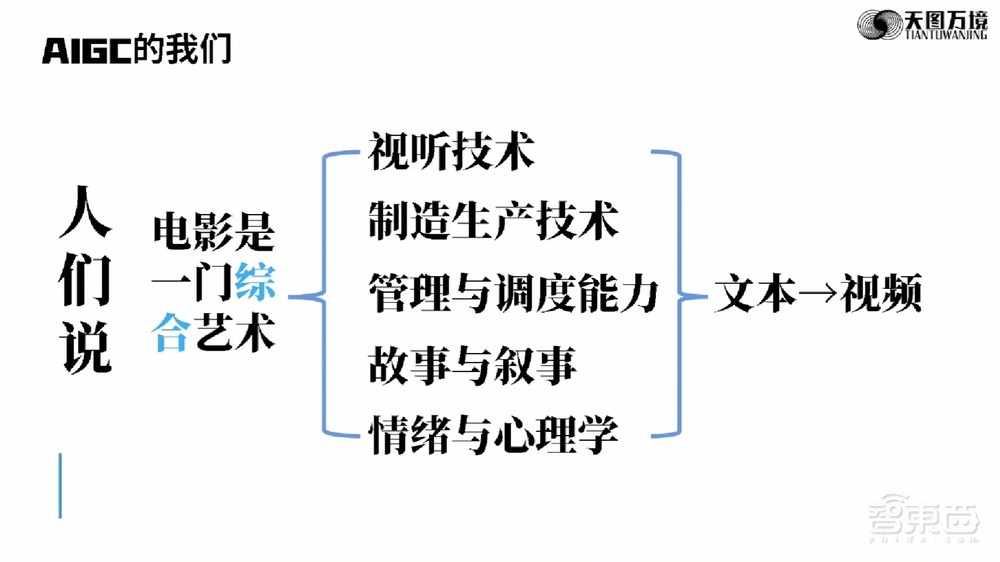

有人说电影是一门综合性艺术,它从视听技术到制造生产技术,再到调度与管理能力,到故事与叙事,最主要的是情绪和心理学都很重要,本质上讲,是从文本到视频这一件事。

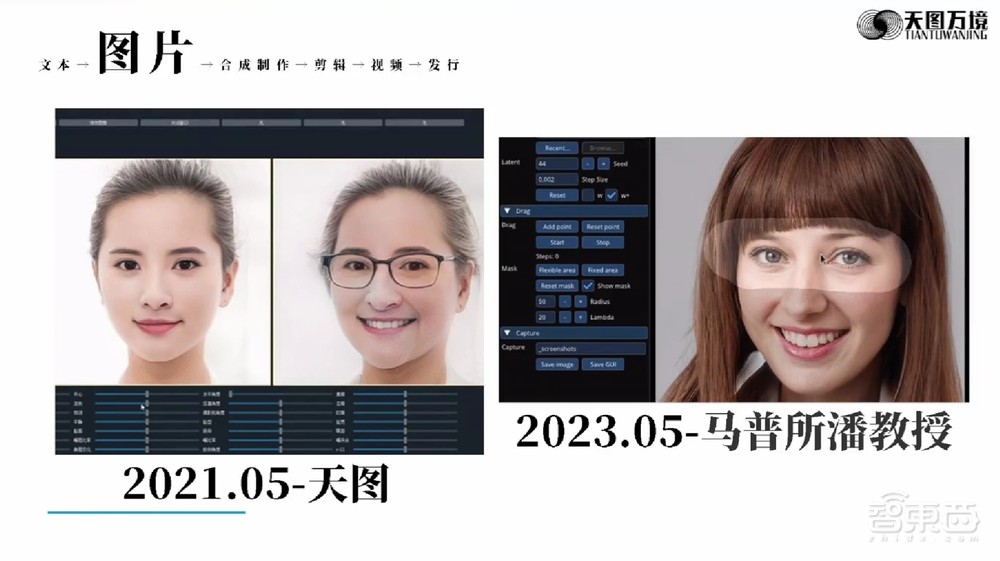

从文本到视频在今天的时代很简单,文本到视频、文本到图片,再到合成、剪辑、视频发行,其中文本就是剧本,我们现在熟悉的软件都可以做。

到今天为止,AI时代,文本生成有GPT,图片有Stable Diffusion、Midjourney,合成有Wonder studio,剪辑Meta似乎在做,视频Sora,发行还是老牌发行,世界的格局没有变化,因为赚钱的地方没有发生变化。

前面都是技术在迭代,下一个时代将会产生产业的迭代,发行怎么变?这些年我们在这些领域做了什么工作?以及为什么说现在做AIGC的同行们都是“弟弟”。

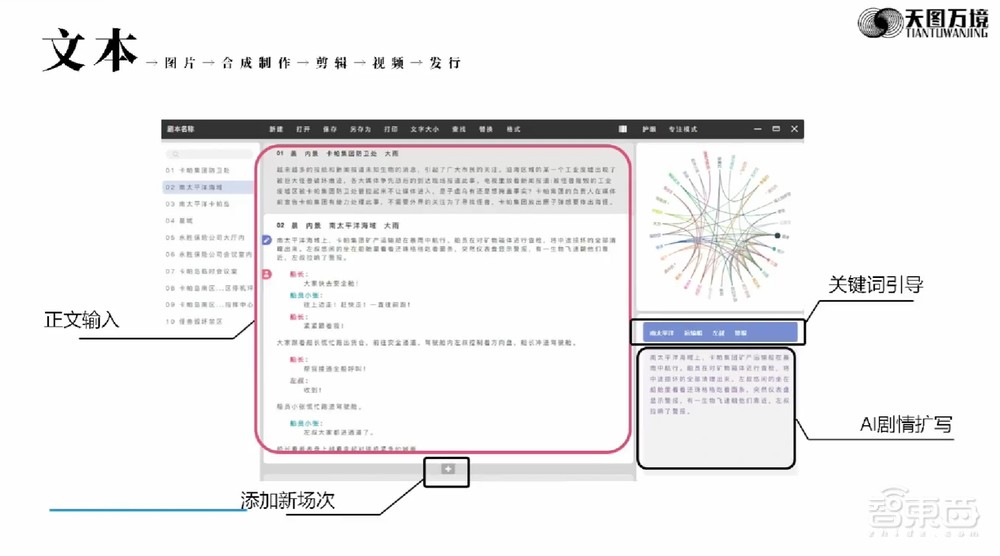

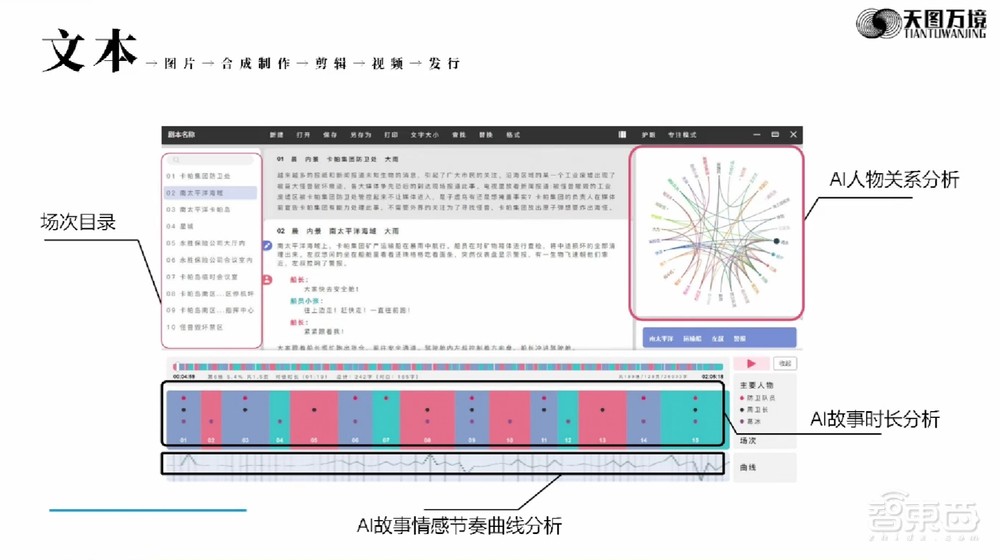

第一个,文本。看这张图,在输入文字的位置添加新故事,加引导词,输入三个引导词就可以自动生成一段故事,这是最早的AI扩写。

下面是用来整理语义分析的,分析人物关系的,分析时长的,再下面是分析故事和情感节奏的,这只能用AI做,不然就会把“皇上急的像热锅上的蚂蚁”,认为是一种动物而不是一种情绪。这是最早的文字生成。什么时候?2021年9月份。谁在做这件事?只有我们在做。

第二个,图片。这个大家都很熟悉了,放一个原始图像,就可以看到实时可编辑的图像,下方是参数拖拽区。左侧是2021年5月份我们发布的产品,右侧是2023年马普所潘教授发布的,当时震惊整个娱乐圈。

上面是选择模型、风格的区域,选择输入风格,输入一张图片,按照图片风格生成图片。

这里是输入汉字的图像实时生成,这在今天来看每个人都极其熟悉,甚至嗤之以鼻。但把时间往回倒一倒,Stable Diffusion是2022年7月份,Midjourney是2022年3月份,天图是2021年9月份。

我们以前做事不会在互联网上留足迹,碰巧这件事情留下了足迹。右图是跟联想ThinkPad做的现场为期七天的实机演示。

第三个,合成制作。通过4张图片重建一个我的数字人,通过一段视频重建整个3D场景。我们还发布首条支持NeRF渲染的循环引擎管线,这是在2022年9月份。右侧的大家也很熟悉,Luma AI,当时全世界都很震惊,时间是2022年11月份,而我们在2022年9月份就发布了可以商用的产品。

还有人体稳定跟踪,大家都很熟悉,还可以把镜头中的人物完美地擦掉,这两者结合到一起,是Wonder studio,它是2023年3月份,天图是2022年11月份。

这个案例非常明显,做这么多,我们也没有做PR,没有被大家记住。我们有很深的感触:不要起太早,容易看不到曙光,因为资本看不懂。

二、“他们看不懂,看不明白,也不愿意学习”

有一个很知名的专家问我,你连一个传感器都没有,怎么叫感知?我现在可以告诉他,这就叫感知,感知是通过智能来判别这个世界的。这是我得到的第一个经验,在创业的时候不要起太早,因为看不到曙光。

第二个,他们看不懂,看不明白,并且也不愿意学习。“他们”不止指资本,也指创作身边的每一个人,他们只能跟着潮流顺着大势而为。我想说一句话:“追风的人是没法飞起来的,因为风筝是逆风飞翔的。”我们要准确判断下一个点在哪里,从现在开始往下一个点走。

第三个经验,投资绝大部分是FOM(afraid of missing),到今天为止,他们对这件事情看起来也是迷迷糊糊的,你去问投资机构,什么叫AIGC?他们只能说一个网上能查到的词,没有经过仔细思考,没有经过认真对产业调研的人很难明白AIGC的明天在哪里,这就是血淋淋的经验和教训。

三、自媒体用“炸裂”“吊打”是瞎说,大部分AI大模型公司在5年内死去

下面说说我们在积累经验之后又做了什么事,现在逐渐被大家关注起来了。

资本眼中的AI大模型:以前100个人干活儿,通过AI自动化3个人干活儿,生成了各种各样的利润,裁员、财源。

一个公司疯狂PR以后,被资本投了以后,创始人自己套壳,自己训练,结果一用自己的产品,这个东西不能用!这怎么办?疯狂地找,终于找到一个落地场景,然后跟媒体说,在这个场景我们可以做这件事,然后无限放大。

自媒体用的什么词?“炸裂”、“吊打”、“惊艳”,这些词能在这儿用吗?这是瞎说。实际是什么样的?这就是它们的实际情况,这是不可避免的问题,因为马车在创造初期也不能一下子跑十公里,这是时代发展的必然结局。

我们现在的AI非常激进,仿佛进入了丰富且多元的生态,但如果我们用一用这些产品会发现,你的生气指数会上涨。但是我们需要用发展的眼光去看待这件事情,十年以后的AI是什么样?它一定是非常丰富且充满了自动化的过程。

我们还讲过一句话,今天的各种企业在这个行业的PR中,仿佛要使用AI这种技术把整个人都替代掉,让整个社会都工业化,其实换句话说,他们在制造“枪”然后来杀掉彼此。

AI的初心应该是像《血战钢锯岭》一样,我不带枪,但是可以缝合这个世界,希望未来有更多做技术的人可以用这些技术来缝合这个世界,让每个人、每个个体都能够从中享受到AI带来的快乐,这很重要。

人类的目光总是是很短浅的,他们想一口吃个胖子,所以在讲大模型,大模型意味着一个轮船可以海上跑、天上飞、地道里面钻,这叫大模型。但到头来解决问题的还是专用模型,轮船只能在海上,飞机在天上,有一天我们希望有两栖东西产生,但是现在这个时间点还不能拥有,此时此刻我们的生产力、物力、算法跟不上,需要等一等。

大部分AI大模型创业公司会在5年内死去,我看到这个行业的人没有技术壁垒,也找不到应用场景,解决不了真的问题,而且没有钱继续烧。此时此刻我把这个话放在这儿,再过5年后你们翻回来找这句话,如果发现这句话是错的,请在评论下面骂我。

我们不应该只谈大模型而放弃专用模型,不能只练大脑不练肌肉。

四、打造视听领域垂直AI大模型集群,联手华为推出视频配音工具Sora Opera

AI大模型在各行各业都有使用,我们应该怎么发展?还是以我们的视听行业为例,我们最早在布局这个产业的时候,别人说我们是骗子,因为他们不懂什么叫模型。

到今天为止,我们已经拥有中国视听领域里面最专业的垂直AI大模型集群,本来是垂直AI模型集群,但我的合伙人说你把“大”加上吧,不然别人听不懂,所以我们叫AI大模型集群,会在北京国际电影节发布。

先讲我们做了什么。Sora Opera,用了半年多了,今年跟华为联合推出。什么是Sora Opera?它本来不叫这个名字,Sora出来之后,一些人建议说最好跟Sora有关,我们就起这个名字Sora Opera,它可以给所有生成式视频,所有手机拍的视频进行配音。

我们先来看图片上这个小怪物,再来看猛犸象。在展示更多之前,我想说一下,人们仿佛在按照计算机的逻辑适应计算机,比如你想需要一段好的文字或者视频,必须要输入适应计算机的提示词,这其实是反着发展的。有没有一种途径可以让人不去输入Prompt,直接点上传下载?可以,我们的Sora Opera去除所有的Prompt,这意味着你的模型必须识别图片类的信息。

我们来听第一个、听第二个。每一个故事都是压着节奏,手碰花,花会响,不碰花,花不会响,我们按照时间一致性来理解这个事情,让这个模型具备视听领域里面的智能。它可以识别很多个电视里面的内容,并且杂乱生成。它可以识别火车声音从远到近的效果,还有跳舞的小动物、自然环境。

未来哪里能用到?各家手机都在宣传,“我家手机可以一键成片”,如果那个成片没有音效,相当于这个世界没有声音,只有视觉是不够的。未来的所有领域都可以使用这样的技术。

再说一个,SoundMax。声音是人类获得信息34%的主要因素。这个功能主要用来配音,用我的声音模拟各种各样的声音,我们不走TTS的路线,TTS是输入文字变成声音,我们需要有人在后面来模拟千行百业的人。

我们先听第一个人叫白小姐,第二个人的声音是说书人,这两个人都是我用手机录的,现在我们听听经过AI处理之后的两个人。我们希望未来AI技术诞生以后让每个个体都是超级个体,让创作去中心化。

五、未来AI视听的机会在哪儿?

最后再简单说一说发行,未来的机会在哪里?

我们知道此时此刻是经济下行,1905年到1914年美国的变化恰如此时此刻这个时代所经历的变化。工具创新以Sora们为例,会出现一个结果,过度电子化,因为生产内容极其容易,网上线上本来就不缺内容,又因为过度容易的生产工具导致内容泛滥,就会出现过度电子化。

那么新业态在哪里?新工具诞生了,怎么没有新业态?新业态可以这么理解,首先冲击两个不好的地方,第一是流媒体平台,本来流媒体平台就是有丰富的内容,现在又冲过来一堆动态PPT,人们非常焦急,甚至会花时间去甄别哪个真哪个假。

第二个,电影院,每个用户都有机会表达自我,关注我发了朋友圈谁给我点赞,电影院的叙事方式已经不太适合当下的观众。

第三个,游戏平台,做游戏会越来越容易,容易的不是编程,容易的是设计,美术越来越容易,编程方面也会推进,所以AI会对它们有冲击。

我简单总结了一下,一切非真人互动和非真实体验的企业和产业都会受到这波冲击。

新机会在哪里?第一个是XR产业,第二个是线下娱乐产业,未来巨大的机会在这个地方,我做了一个总结叫沉浸式产业。

这个产业有几个属性:第一,高科技加持。这个产业必须有科技,不然这个产业没法变革。第二,强社交属性。经济下行,人们心理压力会大,人们必须回归到线下,并且见到真实的可确定性。第三,条件十分便宜,便宜到你喝一杯咖啡的价格就可以玩一个小时、两个小时。

第四,模式可复制,全国各地可复制才能挣钱。第五,内容更新快,每天有两个新的内容可以玩。最后,成本低,内容快就代表着成本低,而这一切全部是AI和今天的电子工业给我们带来的机会,没有这两个产业的出现就没有这样的机会。

我认为,未来AI视听的机会在线下,而不在线上。至少今天的传统互联网应该是没什么机会了,不信可以看看,他们能做的就是投资,他们想真正研发出一款使用的产品太难了。

在线下可能会有哪些?今天不在这儿卖关子了,希望大家快来成为我的朋友,我们一起讨论线下在哪里。

以上是图拉古演讲内容的完整整理。