智东西(公众号:zhidxcom)

作者 | ZeR0

编辑 | 漠影

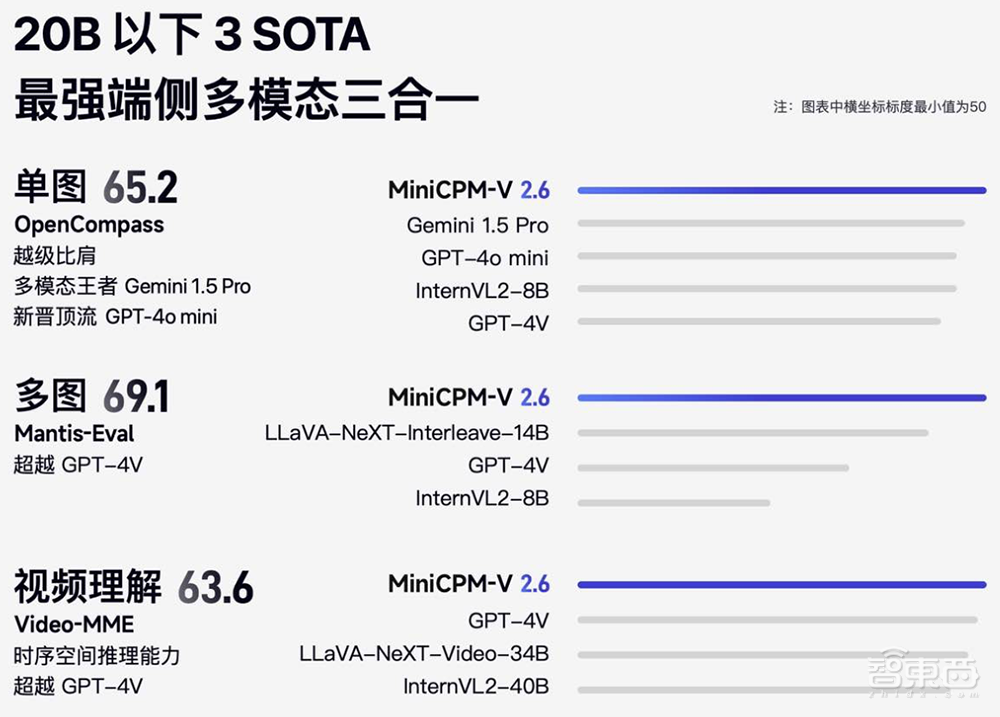

智东西8月6日报道,今日,面壁“小钢炮”MiniCPM-V 2.6模型重磅上新,以8B参数,取得20B以下参数的单图、多图、视频理解3 SOTA成绩,首次在端侧实现单图、多图、视频理解等多模态核心能力全面超越GPT-4V,单图理解越级比肩Gemini 1.5 Pro和GPT-4o mini。

模型经int4量化后端侧6G内存可用,端侧推理速度高达18tokens/s,比上代模型快33%。发布即支持llama.cpp、ollama、vllm推理,且支持多种语言。

实时视频理解、多图联合理解、多图ICL视觉类比学习、多图OCR等功能首次被搬上端侧多模态模型,使得模型能够更加充分地发挥端侧AI传感器富集、贴近用户的优势,能边拍视频边理解摄像头捕捉的文字,能从多张小票照片快速识别票额并算出总账,还能读懂单张或多张梗图。

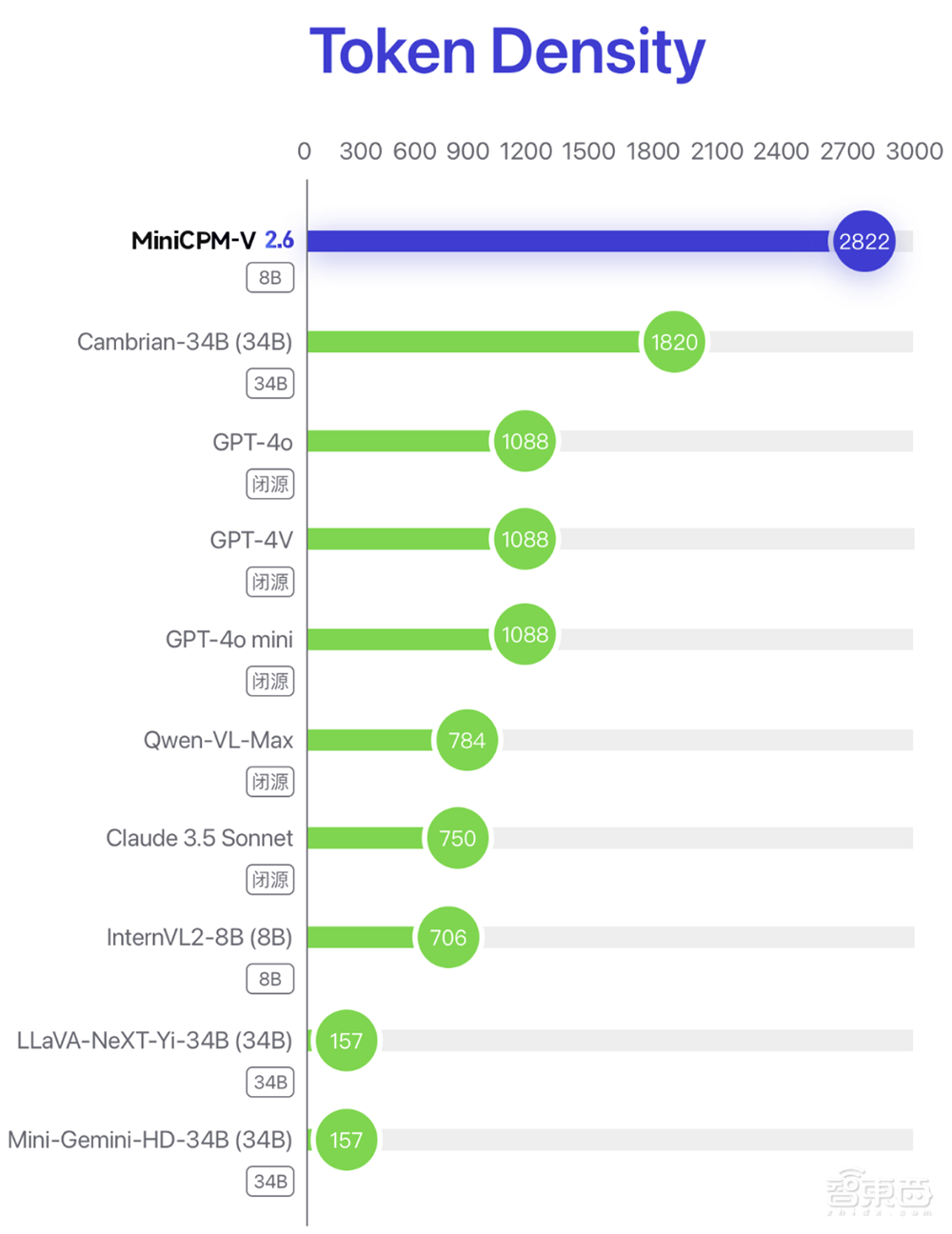

MiniCPM-V 2.6的单token编码像素密度(token density)达到GPT-4o的两倍,这得益于视觉token相比上一代下降30% ,比同类模型低75%。

GitHub地址:https://github.com/OpenBMB/MiniCPM-V

HuggingFace地址:https://huggingface.co/openbmb/MiniCPM-V-2_6

llama.cpp、ollama、vllm部署教程地址:https://modelbest.feishu.cn/docx/Duptdntfro2Clfx2DzuczHxAnhc

MiniCPM系列开源地址:https://github.com/OpenBMB/MiniCPM

一、单图、多图、视频理解SOTA,端侧多模态比肩GPT-4V水平

新一代MiniCPM-V 2.6以仅8B的参数量取得了媲美GPT-4V的综合性能, 单图、多图、视频理解三项多模态核心能力全面超越GPT-4V,且均实现20B参数以下模型性能SOTA。

在知识压缩率方面,MiniCPM-V 2.6取得了两倍于GPT-4o的最高多模态大模型像素密度(Token Density)。 Token Density = 编码像素数量 / 视觉token数量,是指单个token承载的像素密度,即图像信息密度,直接决定多模态模型实际的运行效率,数值越大,模型运行效率越高。

▲闭源模型的Token Density由API收费方式估算得到,结果显示MiniCPM-V 2.6是所有多模态模型中Token Density最高的

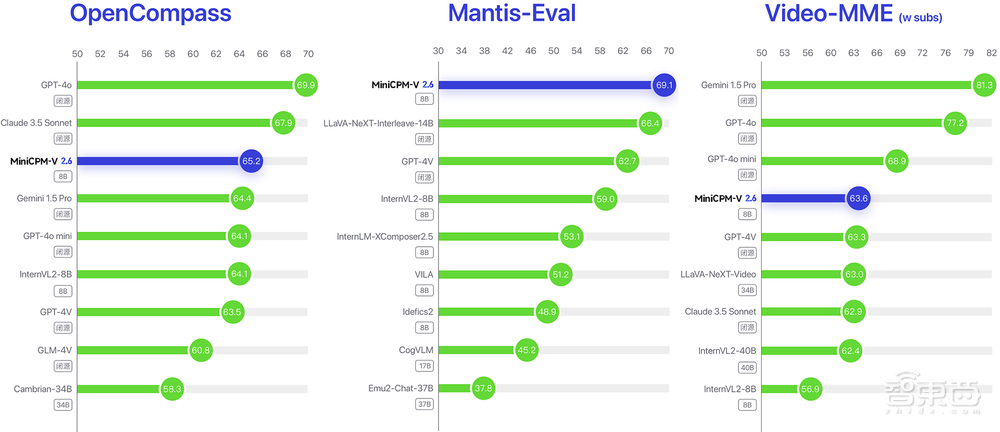

1)单图:在综合评测权威平台OpenCompass上,单图理解能力越级超越Gemini 1.5 Pro和GPT-4o mini。

2)多图:在多图评测权威平台Mantis-Eval榜单上,MiniCPM-V 2.6多图联合理解能力实现开源模型SOTA ,且超越GPT-4V。

3)视频:在视频评测权威平台Video-MME榜单上,MiniCPM-V 2.6的视频理解能力达到端侧SOTA,超越GPT-4V。

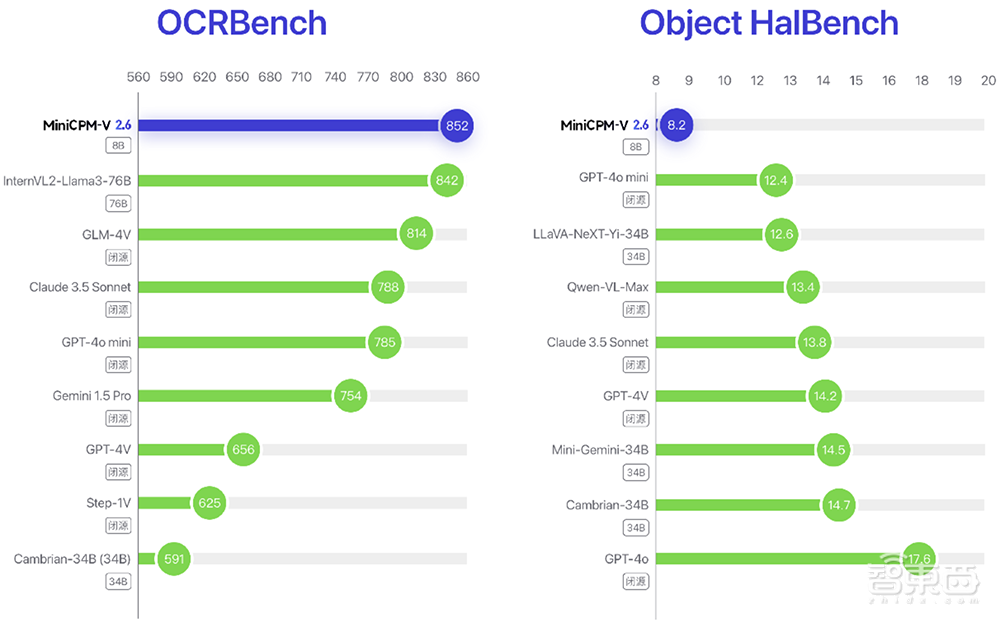

此外,在OCRBench上,MiniCPM-V 2.6 OCR性能实现开源+闭源模型SOTA,延续并加强了小钢炮系列最强端侧OCR能力的传统优势。

在幻觉评测榜单Object HalBench上,MiniCPM-V 2.6的幻觉水平(幻觉率越低越好)优于GPT-4o、GPT-4V、Claude 3.5 Sonnet等众多商用模型。

二、实时视频理解首次上端,快速汇总视频里的密集文字信息

手机、PC、AR、机器人、智能座驾等端侧设备自带的摄像头,具有天然的多模态输入能力,因此相比云端,端侧视频理解自带优势,离用户更近,链路更短,效率更高,同时具有更强的隐私安全。

而MiniCPM-V 2.6让实时视频理解功能第一次运行在端侧,实时拍摄即可精准识别出摄像头捕捉到场景中的文字。

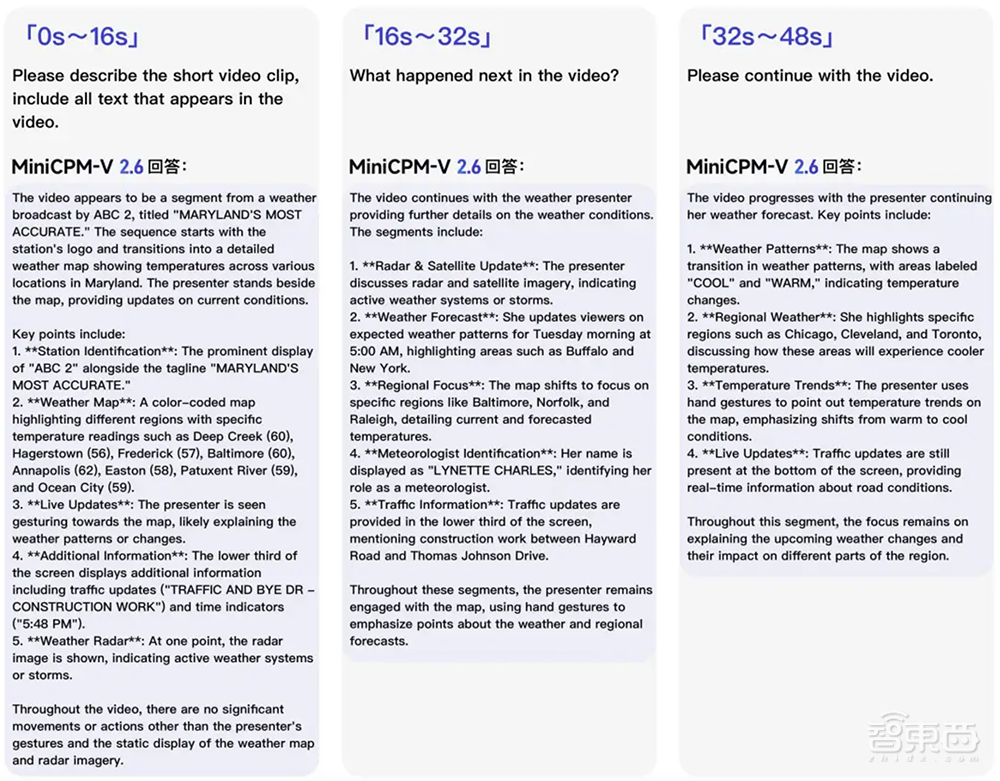

该模型也能快速总结长视频中的重点信息。比如其视频OCR功能,可以在没听到任何语音的情况下,识别出48秒天气预报视频画面里的密集文字,给出不同视频段落中不同城市的详细天气描述。

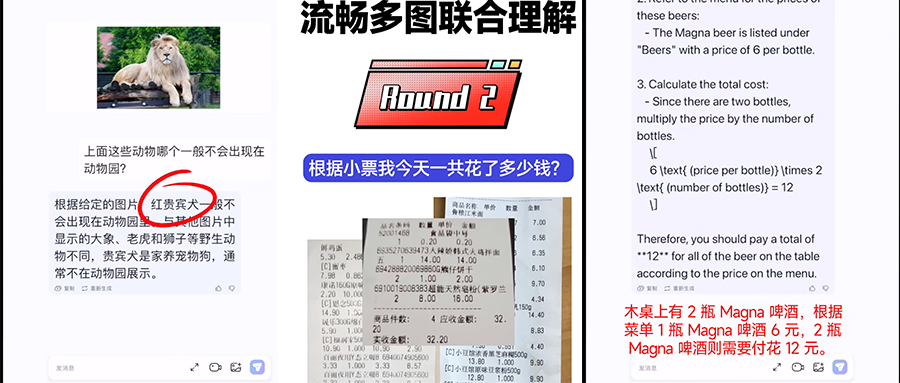

三、多图联合理解首次上端,能算小票,会读梗图

最新发布的MiniCPM-V 2.6首次将多图联合理解、多图ICL(上下文少样本学习)功能集成在端侧模型,可实现流畅的多图多轮理解。

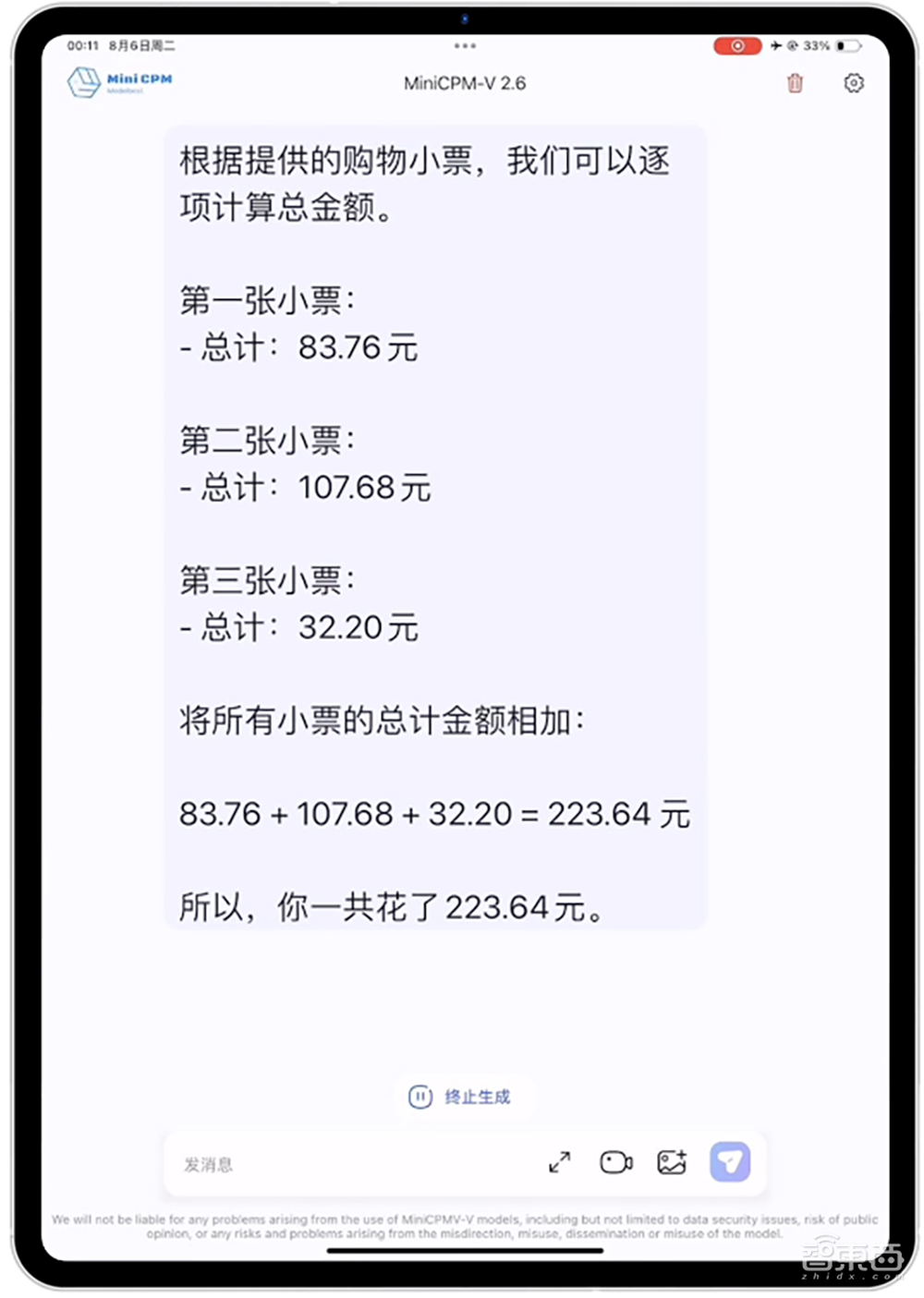

比如遇到日常记账或报销的事,把多张小票拍照,然后交给MiniCPM-V 2.6。基于强大的OCR能力 + CoT(思维链),它不仅能识别出每张小票的金额,还能把总账算出来。

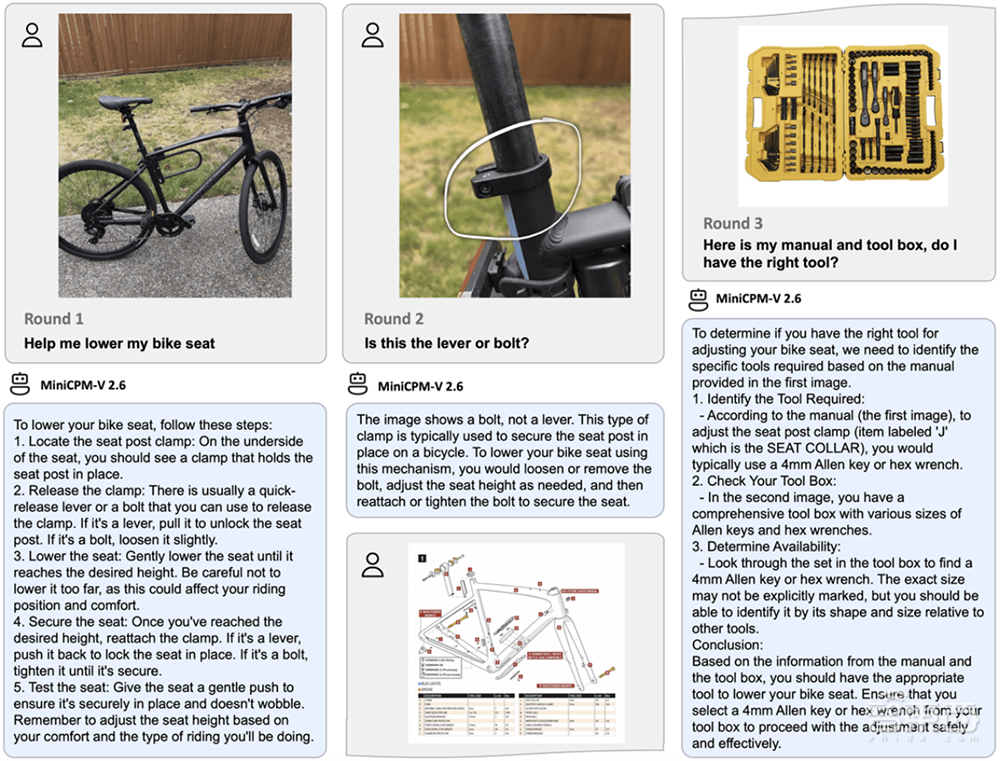

端侧多模态复杂推理能力也被刷新。比如遇到这道GPT-4V官方演示经典命题:调整自行车车座。这个问题对人来说很简单,对模型却很难,非常考验多模态模型的复杂推理能力和对物理常识的掌握能力。

MiniCPM-V 2.6通过和模型进行多图多轮对话,能清晰告知完成调低自行车车座的每一个详细步骤,还能根据说明书和工具箱帮你找到合适的工具。

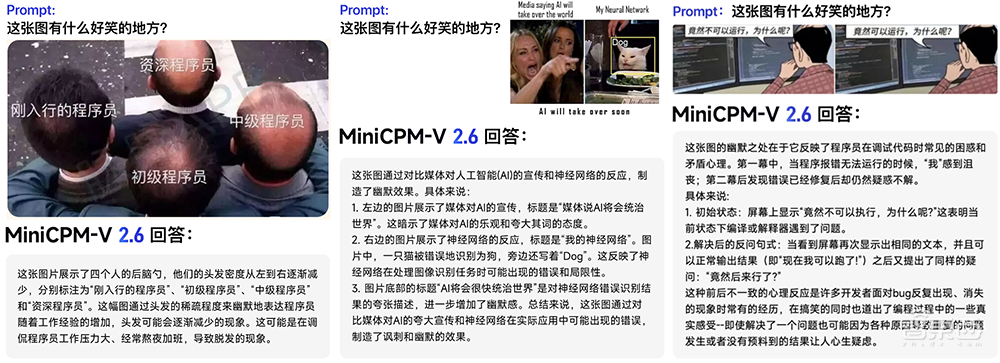

MiniCPM-V 2.6的多图复杂推理能力也很出色,不仅能联合识别多张图片的表面信息,还能“读懂”梗图背后的槽点。

比如让模型解释下面两张图背后的小故事,MiniCPM-V 2.6能将多图联合理解和OCR能力结合,通过OCR精准识别到两张图片上的文字:“WFH Employees 8:59 AM”和 “WFH Employees 9:00 AM”,推理出“WFH”居家办公状态,然后结合两张图片的视觉信息联合推理出“工作在家时,8:59还在床上睡觉,9点立马出现在视频会议上”的居家办公的“抓狂”状态。

单图也不在话下。MiniCPM-V 2.6能轻松“读懂”梗图中很多未明显露出的潜台词。

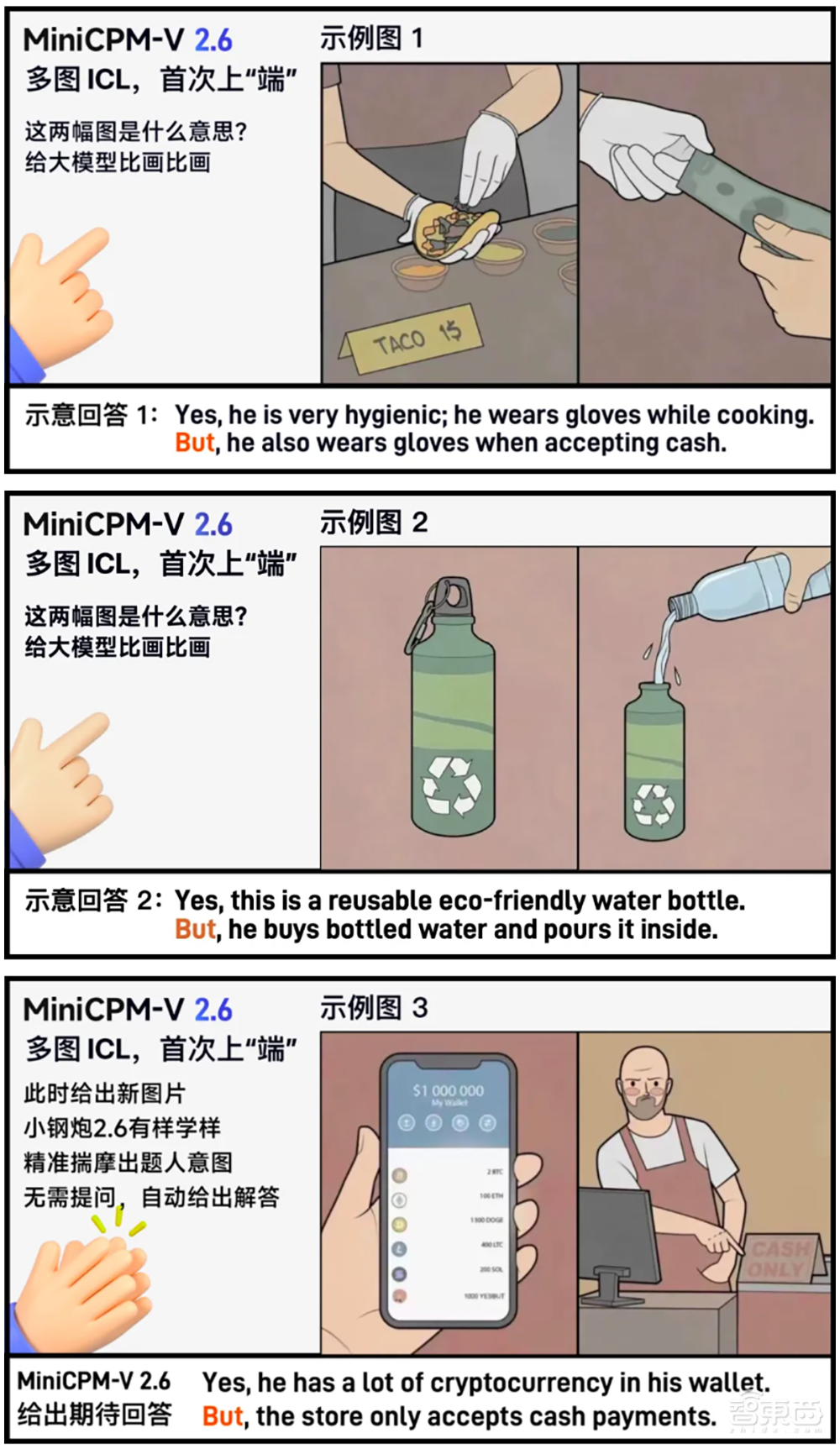

四、多图ICL首次上“端”!大模型学会揣测模仿

很多场景单用语言说不清楚,需要视觉信息来辅助理解。这时多图ICL(In context learning)上下文少样本学习功能就很有必要,能让模型无需微调,即可快速适配到特定领域和任务,显著提高模型的输出稳定性。

例如,给出两组神转折画面,并对画面中的“梗”给出示意文字描述:一个戴着手套、重视卫生的厨师,下一秒却用戴手套的手直接去拿实际有些肮脏的纸币;一个看似热衷环保的人,却把塑料瓶装水打开装进环保水壶……

MiniCPM-V 2.6能自动从前面两组图文关系,揣摩出题人的意图,并自动学会“答题模版”,给出相似的“神转折”答案: 一个人手握大量加密数字货币,可你猜怎么着,他出门购物,可是商店却只收现金。

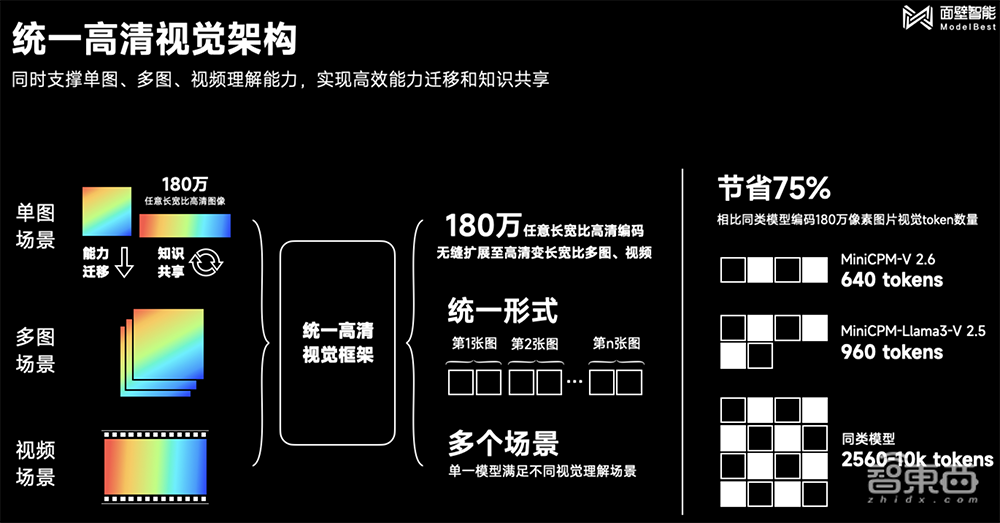

五、统一高清视觉架构,实现高效能力迁移与知识共享

MiniCPM-V 2.6的单图、多图、视频理解等核心能力全面对标GPT-4V,除了Qwen2-7B基座模型的性能加持外,要归功于采用了统一高清视觉架构。

它将MiniCPM-V单图场景的“180万高清图像解析”进行能力迁移和知识共享,无缝拓展至多图场景和视频场景,并将这三种视觉理解场景统一形式化为图文交替的语义建模问题,共享底层视觉表示机制,实现相比同类型模型,视觉token数量节省超过75%。

在OCR信息提取的基础上,MiniCPM-V 2.6还能进一步对表格信息进行类似CoT(思维链)的复杂推理。

比如让模型计算2008年奥运会获得金牌数最多的3个国家一共获得了多少枚金牌,CoT的过程是:先利用OCR能力识别并提取出奖牌榜中金牌数量的前三名国家,再将前三名国家的金牌总数相加。

还有8.2%的超低幻觉率,以及增强的复杂推理能力和通用域多图联合理解能力,得益于面壁RLAIF-V高效对齐技术。

在多模态复杂推理能力对齐方面,MiniCPM-V 2.6通过复杂题目的CoT解答数据,构造高效对齐种子数据,并通过模型自迭代完成数据净化和知识学习。

在多图联合理解方面,MiniCPM-V 2.6从通用域自然网页中结合文本线索挖掘多图关联语义,实现多图联合理解数据的高效构造。

结语:下载量超过百万,端侧模型屡创标杆

在端侧最强多模态的道路上,小钢炮MiniCPM-V系列已成为国内端侧模型典范之一,自24年2月1日首次开创端侧部署多模态先河以来,短短半年间接连完成了端侧模型从单一、到全面对标GPT-4V的突破。小钢炮系列的下载量已逾百万。

MiniCPM端侧模型系列是面壁长期以来“大模型科学化”路线的实践,一方面通过科学提升训练方法与数据质量,不断提升大模型“知识密度”,得到同等参数,性能更强、成本更低的高效模型;另一方面,钻研OCR、多图与视频理解等核心多模态能力创新技术,持续突破端侧的能耗与内存极限。