芯东西(公众号:aichip001)

编辑 | GACS 2024

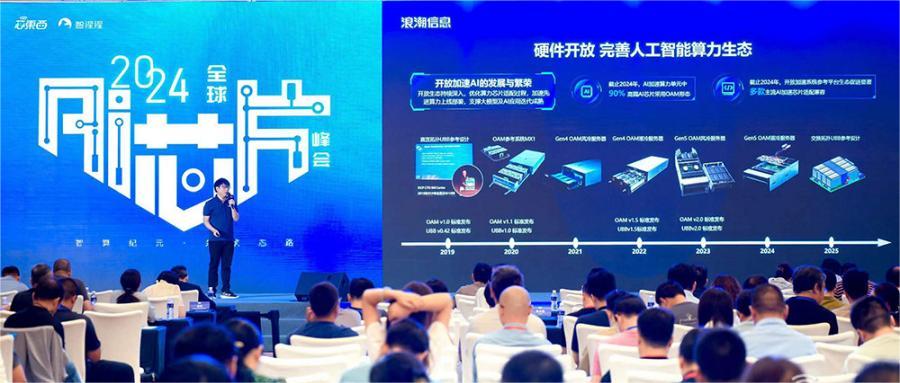

2024全球AI芯片峰会(GACS 2024)于9月6日~7日在北京举行,大会由智一科技旗下芯片行业媒体芯东西和硬科技知识分享社区智猩猩发起举办。在9月6日的主会场数据中心AI芯片专场上,浪潮信息开放加速计算产品负责人Stephen Feng以《多元开放系统激发生成式AI创新活力》为题发表演讲。

Stephen Feng分享道,大模型发展和AIGC应用的创新离不开开源模型和硬件开放。且随着大模型参数规模增加,生成式AI的发展面临四大挑战:集群扩展性不足、芯片功耗高、集群部署难、系统可靠性低四大挑战。

针对生成式AI面临的几大挑战,Stephen Feng提出了他的解决思路,即:

1、单机维度考虑更大的超节点互联,集群维度采用更强、更开放的网络交换机,解决集群扩展性不足。

2、整机维度做到极致的能效设计,提前布局液冷,解决芯片功耗高的问题。

3、进行算力的统一池化管理加快硬件部署,通过端到端的开发平台实现应用的快速部署。

4、建立标准监控管理规范,加速先进算力的上线部署,实现GPU快速迭代和部署;具备自适应分布式训练系统实现故障时的快速定位和断点续训。

▲浪潮信息开放加速计算产品负责人Stephen Feng

▲浪潮信息开放加速计算产品负责人Stephen Feng

以下是Stephen Feng演讲内容的完整整理:

一、开源模型成创新动力,硬件开放推动完善AI算力生态

激发创新活力的核心就是开源开放。

我们首先来回顾大模型的发展历程,在过去的几年间不管是基于上层的应用还是底层技术的进步,开源模型的能力可以与闭源模型能力相媲美。

在今年Meta发布了Llama 3,是一个405B的大模型,而它的能力达到了世界领先的水平。在国内,像通义千问、百川和浪潮信息的“源2.0-M32”也是开源模型。

在去年全球发布的大模型中,2/3以上的大模型都是开源模型,而且80%以上的大模型都选择了开源的框架做相应的开发。开源模型的总下载量已经超过3亿次,并且已经衍生了超过3万多个新模型。

综上所述,开源模型成为创新的动力。

除了大模型,在硬件层面,硬件开放也是完善AI算力生态非常重要的特征。在应用的发展可以看到,大模型的发展也为AI芯片产业带来了多样化的需求特征。在最初,高端AI芯片存在硬件接口、互联规范不统一等问题,导致其在整机适配兼容时容易出现很多问题,投入非常大。

2019年浪潮信息在OCP峰会上展示了全球第一块UBB,由此拉开了OAM整体序幕;2020年,我们发布了第一款参考系统MX1,基于此系统,推动相应的上游芯片厂商在大模型芯片上的开发和落地;2021年和2022年,基于OAM1.0规范做了基于Gen4液冷和风冷服务器。在此服务器上推动完善整个OAM的产品生态。在去年,所发布的《开放加速规范AI服务器设计指南》,给新兴的AI芯片创新提供坚实的系统平台支撑,加速多元算力产业发展。

去年基于Gen4 1.5的规范发布了全新Gen5 OAM服务器,并在这个产品上跟业界20多款高端AI芯片得到相关的适配。明年我们会基于OAM2.0继续发布相关的参考设计,持续引领高端AI芯片的设计以及其与我们的整机系统兼容。

整体来看,OAM的开放标准在硬件层面正加速推动硬件设计与先进算力的部署。这一标准可以帮助AI芯片大幅缩短OAM加速卡研发和系统适配周期,节省超过6个月以上的研发时间与上千万的投入成本,有效缩短硬件开发和产业赋能周期。

从以上两个角度来看,不管在模型的开源,还是硬件的开放上,大模型的发展和AIGC的应用,其整体的迭代离不开开源和开放。今天重点基于开放来分享这个主题。

二、大模型参数量和所需算力大幅增加,生成式AI发展面临四大挑战

回顾大模型的发展历程,深度学习大模型起源于二十世纪八九十年代,最初大模型整体的发展速度以及迭代速度是较慢的。

2017年Google发布了一篇文章《Attention Is All You Need》,提出了Transformer架构。Transformer架构发展之后,加速了大模型迭代的速度。尤其在2022年ChatGPT发布,把大模型应用推上顶峰。国内外大模型层出不穷,Sora大模型再次出现,又让多模态大模型得到了激烈讨论。

大模型从简单的深度学习模型到现在大语言模型或者多模态大模型,还有今年火热的混合专家模型。最近几年因为大模型的迭代速度在飞速提升。我们观察到,当前大模型的参数量和所需算力的增长速度已经远远超过了摩尔定律的发展速度。

大模型未来的发展趋势:参数量更大,往混合专家、长训练模型以及多模态大模型去发展,并行训练会引入新的范式。

传统的大语言模型就是Tensor并行、数据并行和流水线并行,到混合专家模型之后引入了专家并行,长训练模型引入序列并行。引入新的并行模式,像专家并行和序列并行,所需要的通信量会大幅度增加。

在大模型训练过程中,对于通信速度要求是比较高的。引入新的训练范式之后,对整机的需求是什么?一方面需要更大的GPU Domain,不能局限于单机8卡的整机系统,需要更大GPU Domain满足大模型发展所需要互联的速度。另外,需要更大的互联带宽,大模型的发展遵循Scaling Law,参数量大幅度增加,所需要的算力也在大幅度增加。此前训练一个模型需要的可能是百卡、千卡集群就可以了。

而当前以及未来大模型的发展,需要的集群即是万卡起步甚至十万卡的level。

再到服务端也就是推理侧。我们总结来看的话,大模型在推理的过程中首先会有first token,整体是一个算力敏感型,再往后的token都是一些显存敏感型。随着模型的参数量大幅度增加,像Llama 3总体的参数量达到4050亿,未来的推理其实从单卡推理向多卡推理演进,还有向量数据库等推理模型新范式,所引发的对CPU、互联、整体的显存带宽都有了更高的挑战。

基于上述特征,总结未来生成式AI发展所面临的巨大挑战。

大模型的发展在遵循Scaling Law,模型的参数量、训练的时长和训练的数据集都在持续增加。未来训练一个全新的基础大模型,万卡已经成为新起点,对于整机的扩展性提出新的要求。

另外,AI芯片功耗在大幅度提升,从两年前的400W到现在的700W,明年更会达到1200W。短短三年间,GPU芯片的功耗已经提升了三倍左右。一些新的产品形态,像英伟达推出的Oberon架构单机功耗超过120kW。因为芯片算力的提升以及单机柜功耗的提升,会给整体基础设施带来新的变革。在单机维度上需要解掉这么多GPU功耗的散热,投入是非常大的。

另外,未来数据中心基础设施的建设上,我们也要考虑一些新的部署模式,如何快速部署单机柜还能满足这么大功率十分重要。

基于GPU发展的功耗提升现状下,总结未来大模型的发展,到最后都是能源的争夺。我们如何在单机维度、集群维度能够实现更高、更优的能耗是十分重要的。

集群部署难。在大模型集群的部署上除了硬件上包含CPU、GPU、网络、存储等设备,还涉及上层软件和硬件设备的问题。我们如何快速地将这些基础设施进行部署,再到业务层将这些相关的算力能够转化成应用,这是十分重要的。

Llama 3在60多天的训练过程中,故障400多次,平均1天有7次的故障。80%的故障都是发生在硬件的故障,60%是GPU的故障,剩下是软件适配的故障。如何在模型的训练当中保证它的可靠性、稳定性,是大模型能够迅速迭代的一个重要因素。

三、考虑更大Domain解决集群扩展性不足,监控管理标准化提高模型稳定性

基于以上的挑战之下,可以有以应用为导向,以系统为核心的应用之道,具体为以下四个方面:

1、针对集群扩展性不足,我们在单机维度要考虑更大的超节点互联,要做到超级互联方案去实现千卡集群的Scale-up。在集群维度还要考虑采用更强的网络交换机去做到更多的万卡甚至十万卡的GPU Scale-out。

在单机维度,我们会推出创新的OAM互联方案来满足万亿模型通信需求。一方面会推出基于OAM2.0的多机互联方案标准,相比此前直联的拓扑OAM,P2P带宽提升7倍左右,实现更大OAM的Domain,支持八千张以上的加速卡超级互联。我们也会基于交换拓扑推出OAM的超节点互联方案,是一个完全解耦的整机柜形态;并基于此拓扑形成OAM整机柜标准,解决扩展性不足并加速OAM的算力迭代。

在集群层面,浪潮信息推出X400超级AI以太网交换机,也是完全开放的产品。专门为AI大模型设计,是国内首款基于Spectrum-4打造的产品,最高吞吐达到51.2T,超级AI以太网交换机与传统的以太网交换机最大的不同就是采用交换机和智能网卡整体的调度解决方案,在交换机上实现对网络包细粒度的路由调度,在网卡侧提供保序服务,实现交换机和网卡更加紧密耦合的配合。基于此方案,我们能够实现16K计算节点,10万+以上的加速卡互联,满足GPU之间的互联通信需求。同时,带宽的利用率高达95%以上。

2、针对计算芯片,一方面在整机维度做到极致的能效设计,把整机的能效做到最优,把性能发挥到极致。另外,提前布局液冷,浪潮信息一直是ALL IN液冷的策略,单机柜成本非常高,整机柜交付的模式,基于开放、快速交付的液冷整机柜交付形态去满足计算芯片功耗高带来的挑战。

针对GPU功耗的飞速发展,在单机维度采用极限的设计,去实现极致的效能。我们在面向全球最大的AI服务器用户的工程实践当中总结了设计方案,不断突破单机算力密度和单机的性能。NVLink服务器我们已经做了四代,OAM服务器已经做了三代的产品,整体服务器上通过全链路仿真、分区的散热调控去实现了极致的散热和最佳的性能。在保障产品极致性能的同时,把整体的能效发挥到最优。

另外一方面,首创像风扇的智能听音诊断技术,通过相关的智能诊断去保障大模型训练过程中总体的功耗和噪音的极致优化。在液冷方面,刚才提到我们ALL IN液冷战略,很早布局液冷,包含冷板式散热、浸没式等液冷方面的技术。

在基础设施层面,通过开放液冷技术标准推动液冷加速普及。一方面制定相关的液冷技术标准,推动液冷的加速普及。打造标准接口的液冷组件,满足单机的Scale-up。基于以往的数据风冷机房改造,通过风液式CDU,实现一天零改造快速落地和部署。基于冷链的架构革新推出单机柜120千瓦的整机柜形态,满足未来更大的超节点互联方案,实现快速落地部署。基础设施维度,通过开放的生态,建立预制化可扩展、可生长的数据中心交付形态,来加快算力的部署。

3、在整机维度,把GPU的监控管理标准化加速迭代。并在训练过程中基于自适应的分布式训练系统,保障训练的稳定。

稳定性是高效完成大模型发展的必备条件。

一方面我们对整体的监控管理标准化,从OAM的固件管理规范,定义了管理的标准,包括从数据的更新频率、异常数据处理,还有等级的数据处理机制以及整机预告警、分区分层诊断机制,我们都去定义了相应的标准,加速不同GPU芯片在整机系统的兼容。另外,我们基于OpenBMC开放了管理平台,原生架构兼容了像AI服务器、通用服务器、专业服务器、存储服务器等多元异构的计算平台。通过模块化的解耦实现Arm、x86、CPU等以及GPU、ASIC等加速卡的兼容,能够实现快速迭代。

另一方面,在模型训练过程中,如何在监控层面,有效应对训练中出现的故障等突发情况?我们通过AIStation人工智能开发平台,构建自适应分布式训练系统。一方面可以实现多租户资源的管理,去提高集群资源的利用率和降低集群管理的复杂度。另外一方面,当出现断点的时候,能够通过在训练池中快速地拉通备机,实现快速恢复训练和训练的自愈,保障大模型在训练过程中长时间、高效的稳定运行。通过AIStation能够将故障的处理时间缩短90%以上。

4、最后,在模型的部署落地上,通过“元脑企智”EPAI加速大模型业务部署和应用创新,为企业AI大模型的落地应用提供高可用,以及安全端到端的开发平台,提供相应的像数据准备、知识检索、模型微调和训练,以及应用框架的系列工具支持调度多元算力和多模算法,帮助企业高效地部署生成式AI应用。

综上所述,浪潮信息始终坚持以应用为导向,以系统为核心,通过开源开放的系统激发生成式AI创新活力。在硬件开放方面,通过建立OAM(开放加速模块)规范,加速先进算力的上线部署,支撑大模型及AI应用的迭代加速。在软件开放方面,通过大模型开发平台“元脑企智”EPAI,为企业打造全流程应用开发支撑平台;通过AIStation人工智能开发平台,提供稳定的保障系统,实现从模型开发、训练、部署、测试、发布、服务的全流程一站式高效交付。我们始终秉承开放包容的生态,加速生成式AI的快速发展。