时尚图像编辑旨在根据给定的指令修改人物的外观。现有的方法通常需要辅助工具,如分割器和关键点提取器,缺乏灵活且统一的框架。此外,这些方法在能够处理的服装种类上也有局限性,因为大多数数据集只集中于干净背景下的人物形象,且只包含如上衣、裤子和连衣裙等通用服饰。这使其在现实场景中的适用性受到限制。

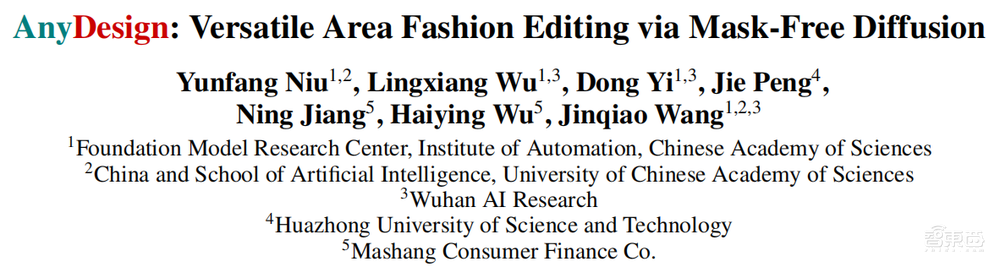

对于以上问题,来自中国科学院自动化研究所的在读博士牛蕴方与武汉人工智能研究院等研究人员共同扩展了一个现有的人体生成数据集,并且提出了一种基于扩散模型的时尚编辑方法AnyDesign,实现了实现了无需掩码的服装编辑功能。相关论文为《AnyDesign: Versatile Area Fashion Editing via Mask-Free Diffusion》。

AnyDesign是一个灵活高效的时尚图像编辑框架。用户无需手动创建掩码,只需输入一张人物图像以及相应的文本或图像格式的提示,通过无掩码的扩散模型,即可实现时尚图像编辑。

首先,扩展了一个现有的人体生成数据集,以包括更广泛的服饰种类和更复杂的背景。扩展后的数据集包含穿着多种服饰的人物形象,如上衣、裤子、连衣裙、裙子、头饰、围巾、鞋子、袜子和包包。

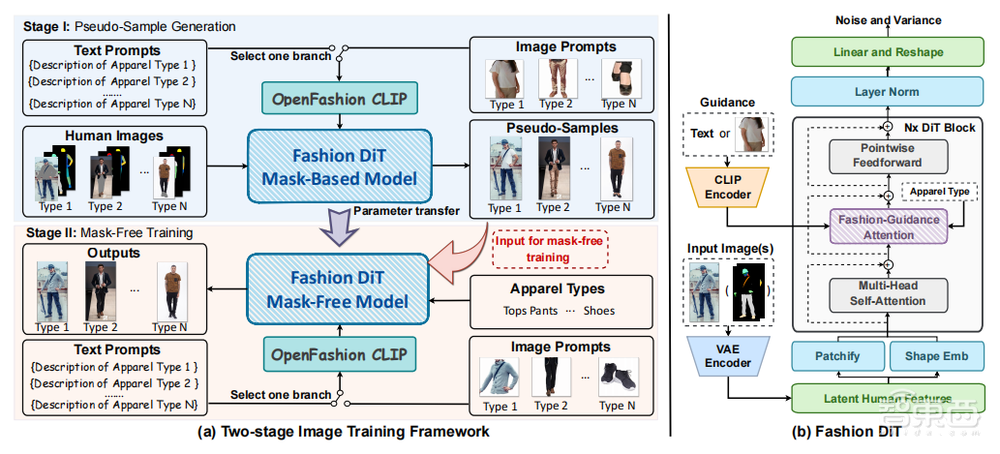

AnyDesign采用了一个两阶段的图像训练框架。第一阶段,使用基于掩码的扩散模型生成伪样本。扩散模型利用未配对的文本提示或图像提示,在原始图像上生成相应的服装区域掩码、修改图像中的服装部分,从而生成伪样本。第二阶段,利用第一阶段生成的伪样本训练无掩码模型。它直接对图像中的服装区域进行修改,以生成符合用户的输入提示的高质量时尚编辑图像。

在图像的去噪过程中,提出Fashion DiT,通过创新的FGA(Fashion-Guidance Attention,时尚引导注意力)模块融合明确的服饰类型和通过CLIP编码的服饰特征,使AnyDesign能够自动识别目标区域,指导其对图像中的服装区域进行精确编辑。

实验表明,AnyDesign拥有高质量的时尚编辑效果,并且在性能上优于其他先进的文本引导时尚编辑方法。

9月29日晚7点,智猩猩邀请到论文一作、中国科学院自动化研究所在读博士牛蕴方参与「智猩猩AI新青年讲座」252讲,主讲《利用无掩码扩散技术实现多功能时尚编辑》。

讲者

牛蕴方

中科院自动化所在读博士

师从王金桥研究员,参与多模态大模型“紫东太初”研制。主要研究兴趣为图像生成与编辑、人物服饰编辑、虚拟试穿等。代表工作有PFDM: Parser-Free Virtual Try-On via Diffusion Model、AnyDesign: Versatile Area Fashion Editing via Mask-Free Diffusion等。

主题

利用无掩码扩散技术实现多功能时尚编辑

提纲

1、AIGC时尚设计与人物服饰编辑研究进展与挑战

2、针对多种类型的服饰编辑数据集扩展方法

3、基于Fashion DiT的无掩码图像编辑模型

4、实验结果分析、讨论与总结展望

直播信息

直播时间:9月29日19:00

成果

论文标题

《AnyDesign: Versatile Area Fashion Editing via Mask-Free Diffusion》

论文链接

https://arxiv.org/abs/2408.11553

开源代码

https://github.com/nyf8/AnyDesign

入群方式

有讲座直播观看需求的朋友,可以添加小助手“米娅”进行报名。已添加过“米娅”的老朋友,可以给“米娅”私信,发送“ANY252”进行报名。对于通过报名的朋友,之后将邀请入群进行观看和交流。