智东西(公众号:zhidxcom)

作者 | 李水青 程茜

编辑 | 漠影

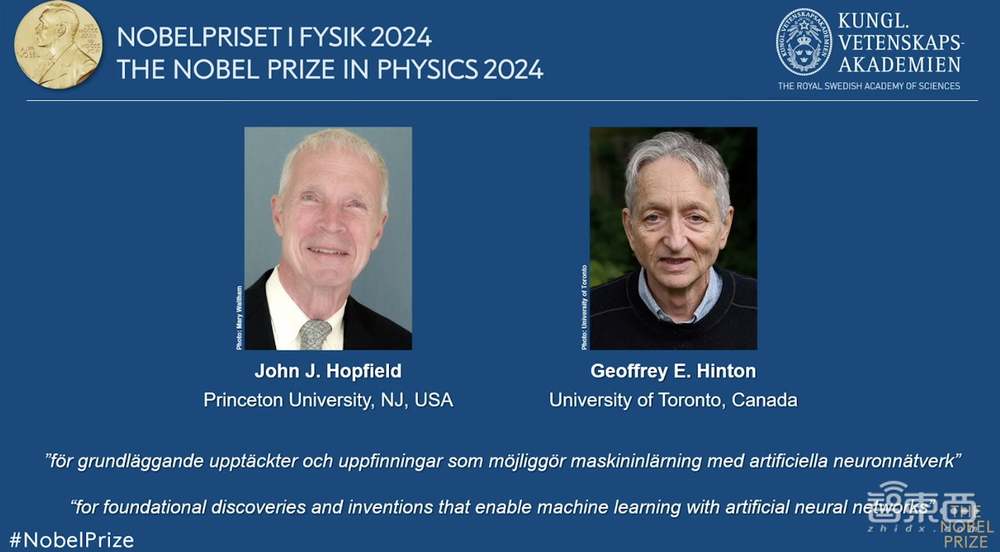

智东西10月8日消息,今日,瑞典皇家科学院宣布,将2024年诺贝尔物理学奖授予约翰·霍普菲尔德(John J. Hopfield)和杰弗里·辛顿(Geoffrey E. Hinton),以表彰他们推动利用人工神经网络进行机器学习的基础性发现和发明。

▲瑞典皇家科学院公告截图

其中,出生于1933年、现年91岁的Hopfield是美国著名的物理学家、生物学家和神经科学家。他发明了一种具有联想记忆功能的神经网络模型,可以存储和重建图像及其他类型的数据,对人工智能和神经网络发展具有奠基作用。

▲约翰·霍普菲尔德(John J. Hopfield)

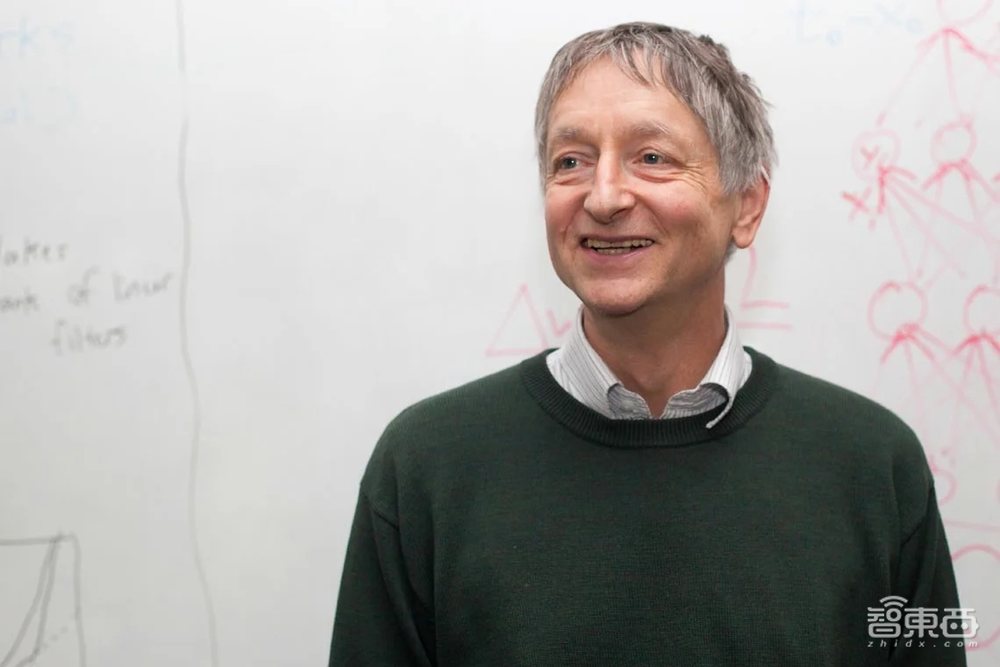

出生于1947年、现年77岁的Hinton是图灵奖得主、“深度学习之父”,他在Hopfield研究基础上,发明了一种可以自主查找数据属性的方法,从而执行识别图片中特定元素等任务。他凭借玻尔兹曼机以及反向传播算法、分布式表示等研究被业内誉为“AI先驱”。

▲杰弗里·辛顿(Geoffrey E. Hinton)

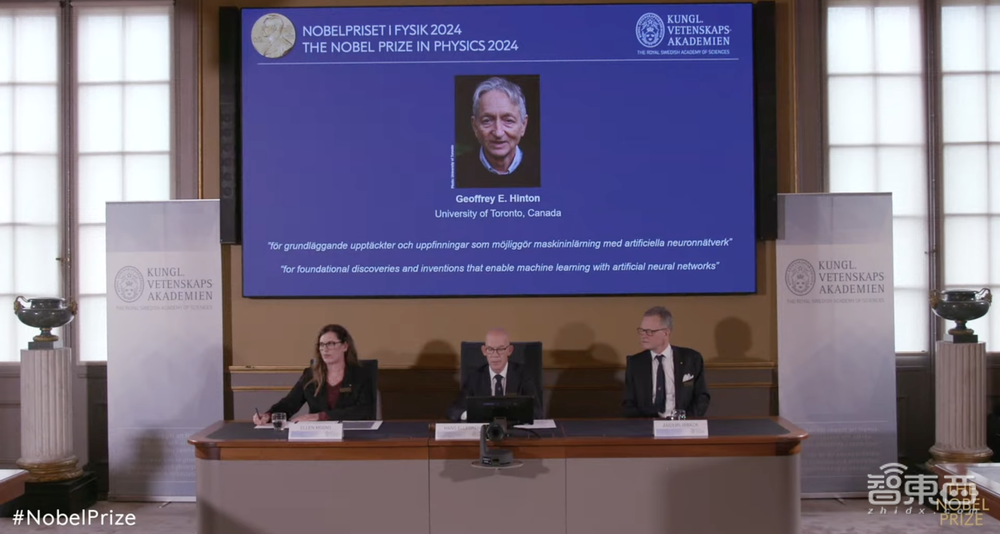

Hinton今日在诺贝尔物理学奖颁布时线上接受媒体采访,被问及现在的感受时说:“我大吃一惊,不知道会发生这种事。”

▲Hinton在诺贝尔物理学奖颁布时线上接受媒体采访

“获奖者的工作已经产生了巨大的效益。在物理学领域,我们将人工神经网络应用于广泛的领域,例如开发具有特定属性的新材料等。”诺贝尔物理学奖委员会主席Ellen Moons说。

一、John J. Hopfield:用物理学训练人工神经网络,42年前论文为AI奠基

根据瑞典皇家科学院公告,Hopfield的主要贡献如下:

“John J. Hopfield发明了一种使用保存和重现模式方法的网络——霍普菲尔德网络(Hopfield Network)。

我们可以将节点想象成像素。霍普菲尔德网络利用物理学来描述材料由于原子自旋而产生的特性,这种特性使每个原子都成为一个微小的磁铁。整个网络的描述方式相当于物理学中自旋系统的能量,并通过寻找节点之间连接的值来进行训练,以便保存的图像具有较低的能量。

当霍普菲尔德网络被输入扭曲或不完整的图像时,它会有条不紊地处理节点并更新它们的值,从而降低网络的能量。

因此,网络逐步找到与输入的不完美图像最相似的保存图像。”

出生于1933年、现年91岁的Hopfield是美国著名的物理学家、生物学家和神经科学家,1958年获得美国纽约州伊萨卡康奈尔大学博士学位,现任美国新泽西州普林斯顿大学教授。

他曾在贝尔实验室做过技术人员,1982年发表了 “Neural networks and physical systems with emergent collective computational abilities”(《具有涌现集体计算能力的神经网络和物理系统》)论文,是他被引用次数最多的论文,1986年参与创立了加州理工学院的计算与神经系统博士项目。

Hopfield提出的霍普菲尔德网络是一种具有联想记忆功能的神经网络模型,在当时使得遭受质疑而陷入停滞的神经网络重新成为AI重要研究方向,为后续神经网络的蓬勃发展奠基。

二、Geoffrey E. Hinton:“深度学习之父”,将深度学习推向主流

根据瑞典皇家科学院公告,Hinton的主要贡献如下:

“Hinton以霍普菲尔德网络为基础,发明了一个采用不同方法的新网络:玻尔兹曼机(the Boltzmann machine)。

它是一种基于统计物理学的网络,可以学习识别给定类型数据中的特征元素。

Hinton使用了统计物理学的工具,通过输入机器运行时很可能出现的示例来训练机器。玻尔兹曼机可用于对图像进行分类,或创建训练模式类型的新示例。Hinton在此基础上继续发展,帮助开启了机器学习的爆炸式发展。”

出生于1947年、现年77岁的AI先驱Hinton是一位英裔计算机科学家,1978年在英国爱丁堡大学获得博士学位,现任加拿大多伦多大学教授。

2012年,Hinton联合其学生构建了一个神经网络,可以分析数千张照片,并自学识别花、狗和汽车等常见物体。Hinton与学生研发的神经网络在当年ImageNet大规模视觉识别挑战赛中以巨大优势夺冠,从而将深度学习推向主流。

2018年,Hinton与Yoshua Bengio(约书亚·本吉奥)和Yann LeCun(杨立昆)一起获得了2018年图灵奖,自此,他们三人经常被合称为“深度学习之父”。

▲三人并称“深度学习之父”

Hinton当下非常关注AI未来的巨大不确定性,并强调负责任监管AI的重要性。他在谷歌工作了十年,由于担心AI的风险而于去年5月离职,辞去谷歌副总裁和工程研究员职务。

三、融合物理学背景,为机器学习革命奠定基础

Hopfield和Hinton从1980年代开始的工作,为2010年左右开始的机器学习革命奠定了基础。

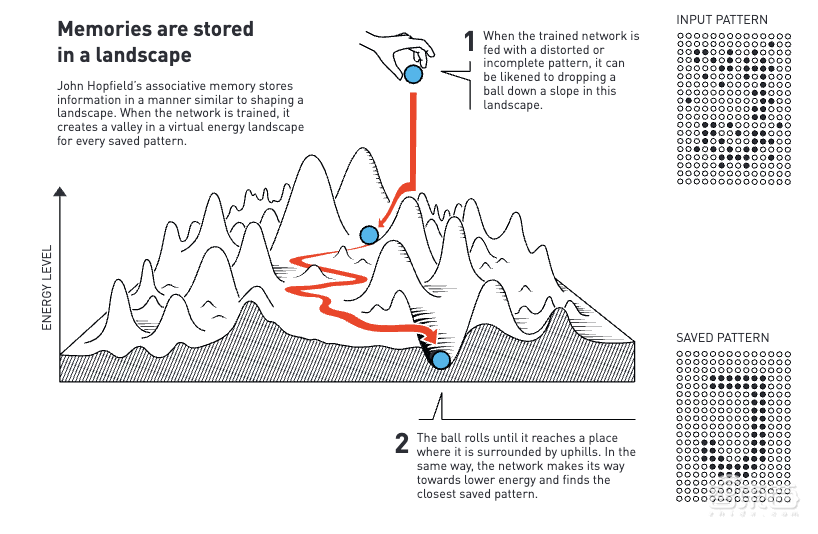

1982年,Hopfield发明了联想记忆,这类似于人们在相似单词中搜索不常使用单词的过程。他构建的网络可以基于存储信息重新创建模式,当为网络提供的是不完整或略微扭曲的模式时,这一网络可以找到最相似的存储模式。

当时,Hopfield利用了他的物理学背景来探索分子生物学的理论问题,在南加州帕萨迪纳加州理工学院,他找到了构建具有许多小组件协同工作系统的灵感。受益于了解磁性材料的物理学原理,他能够使用描述自旋相互影响时材料的物理学特性,来构建具有节点和连接的示例网络。

他构建的网络具有以不同强度连接在一起的节点,每个节点都可以存储一个单独的值,在第一项工作中该值可以是0或1,就像黑白图片中的像素一样。这一方法很特殊,其网络可以同时保存多张图片并且进行区分。

同时,如下图所示,霍普菲尔德网络可用于重新创建包含噪声或已部分擦除的数据。

这之后,Hopfield和其他人继续开发这一网络如何运作的相关细节,包括可以存储任何值的节点不仅仅是0或1。

但存储图像是一回事,想要解释它所描绘的内容是另一回事。

Hinton在美国匹兹堡卡内基梅隆大学工作时,就和同事一起利用统计物理学的思想对霍普菲尔德网络进行扩展,并构建新的东西。

1990年代,许多研究人员对人工神经网络失去了兴趣,但Hinton仍没有放弃,并开启了这一研究领域的新一轮爆发式增长。2006年,他和同事开发了一种预训练网络的方法,该方法将一系列玻尔兹曼机分层,一个在另一个上面。这种预训练为网络中的连接提供了一个更好的起点,从而优化了其训练以识别图片中的元素。

Hopfield和Hinton开发的开创性方法和概念是有助于塑造人工神经网络领域。此外,Hinton在这项工作中发挥了主导作用将方法扩展到深度和密集的ANN。

当下机器学习的发展是基于大量数据以及计算能力的巨大提高而实现的。1982年,Hopfield发布关于联想记忆的文章,就为这一发展提供了支持。他使用了具有30个节点的网络,如果所有节点都相互连接,就有435个连接。与今天的大型语言模型进行比较,这些模型被构建为可以包含超过1万亿个参数(100 万万个)的网络。

许多研究人员现在正在研发机器学习的相关应用,但哪一个方法更可行还有待观察,同时围绕这项技术的开发和使用的道德问题也存在广泛的讨论。不过,由于物理学为机器学习的发展提供了工具,因此看到物理学作为一个研究领域如何从人工神经网络中受益是很有趣的。

同时,机器学习长期以来一直被用于诺贝尔物理学奖中熟悉的领域,包括使用机器学习来筛选和处理发现希格斯粒子所需的大量数据、减少测量碰撞黑洞引力波的噪声、寻找系外行星等。

结语:神经网络基础研究,助AI爆发式发展

今年的两位诺贝尔物理学奖得主,利用物理学工具开发出的方法,为当今强大的机器学习奠定了基础。

他们从1980年代开始就对人工神经网络进行了重要的研究。AI领域基础研究在当下节点上获得国际重量级的诺贝尔奖,体现了AI的巨大效益和对人类发展的深刻影响日益显著。