芯东西(公众号:aichip001)

作者 | ZeR0

编辑 | 漠影

芯东西12月2日报道,近日,英特尔技术专家与芯东西等媒体进行交流,深入解读了英特尔至强6性能核处理器中MRDIMM内存技术的进步与工程挑战。

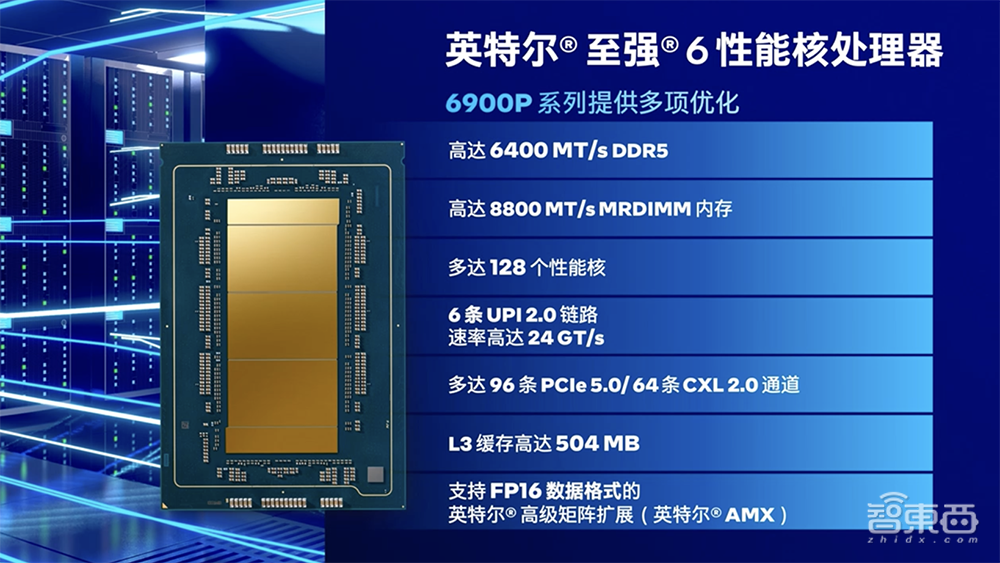

英特尔至强6性能核处理器是英特尔针对高性能计算、AI等计算密集型工作负载在今年9月推出的新一代处理器,最高配备128个性能核,从PCIe通道、L3缓存等一系列做了很多扩展。新型内存技术MRDIMM(Memory Buffered DIMM)是其中的一大亮点。

随着企业对高性能内存的需求日益增加,MRDIMM技术通过提高内存带宽和降低延迟,能够显著提升数据中心的整体能效,同时其兼容DDR5标准,便于在现有系统中进行升级和部署,使其成为未来数据中心内存技术的重要发展方向。

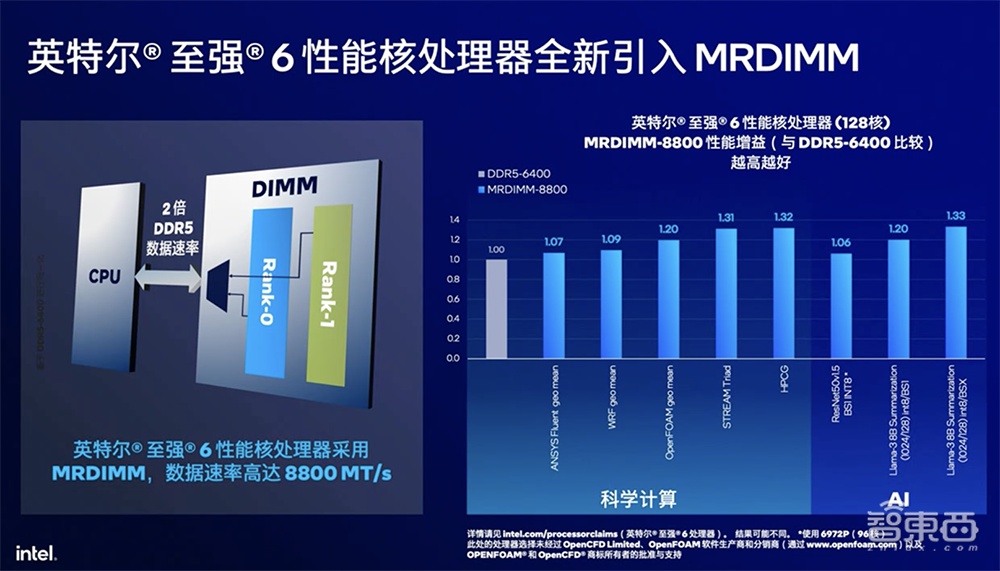

在至强6上,MRDIMM可实现最高8800MT/s的数据传输速率,比标准DDR5 RDIMM的6400MT/s足足高出近40%。相比第五代至强处理器,至强6性能核内存带宽提升多达2.3倍。

即插即用的MRDIMM已纳入JEDEC标准。按照当前路线图,MRDIMM预计在未来在8800MT/s的基础上翻倍,容量也会随着介质本身的演进而增加。

一、显著优化内存带宽,与现有生态相融

MRDIMM针对内存数据库、科学计算、AI等内存带宽敏感型应用表现出色,能够为数据中心“锦上添花”。

对于企业级应用而言,选择合适的内存技术至关重要。引入MRDIMM技术能为企业级应用带来提升数据库性能、优化虚拟化环境、加速AI和大数据应用等优势。

面向内存数据库等关键应用场景,MRDIMM技术可显著提高数据处理效率。在虚拟化环境中,该技术能够为每个虚拟机提供更高的内存带宽和更低的延迟,从而提升整体性能。

据英特尔技术专家分享,MRDIMM从原型设计到如今正式发布已有很多年,之所以在至强6这一代支持MRDIMM,首先是基于对性能和收益的平衡,而且兼容DDR5,与现有生态相融。

MRDIMM的规格可以与英特尔至强6性能核处理器的性能相匹配。

相较于提高内存容量,MRDIMM更关注提高内存带宽、降低延迟。与DDR5最高端的6400MT/s、主流的4400MT/s或4800MT/s相比,MRDIMM在带宽、延时上都会有显著优化。

MRDIMM的8800MT/s理论上相比6400MT/s提升37.5%,在某些应用优化比较好的情况下已经达到33%的性能提升,非常接近于理论带宽的提升值。

易用性方面,MRDIMM通过采用与常规RDIMM相同的连接器和外形规格,使小型多路复用芯片也可适配之前模块上的空余位,因此无需对主板做任何更改。

MRDIMM还具备与RDIMM相同的纠错及可靠性、可用性和可维护性(RAS)功能,可保持数据的完整性。

数据中心客户在订购新服务器时选择MRDIMM,或将机架服务器中的RDIMM换成MRDIMM,无需更改任何代码。

二、一次传输128字节,优化内存带宽敏感型应用

处理器在核数提升的同时,单个核心对于内存的要求也在提升,在科学计算或AI的场景下会产生更高的内存带宽需求,这时MRDIMM会起到关键的作用。

通常情况下,传统RDIMM(Registered DIMM)内存模块会有1或2个Rank(阵列),以实现性能和容量的平衡。在有2个Rank的情况下,普通DRAM会进行分开访问,一个读写的Cycle,只有一个阵列是活跃的,另外一个阵列则会闲置。

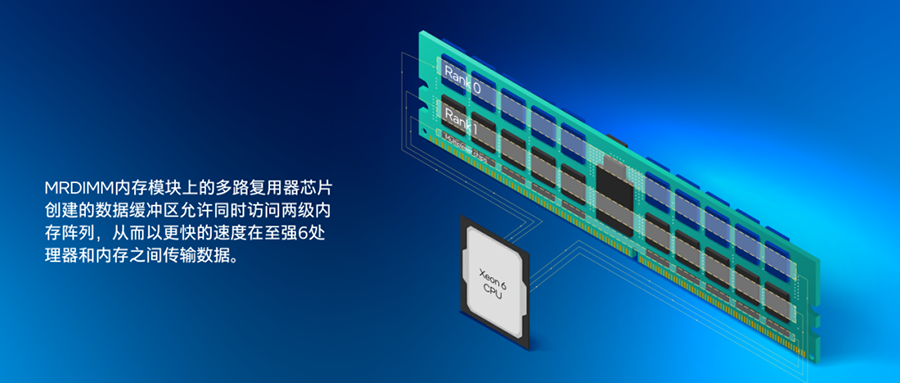

而MRDIMM会让两个阵列同时活跃起来,利用内存模块上的多路复用器芯片创建的数据缓冲区实现128字节在两个内存阵列的同步操作,从而以更快速度在至强6处理器和内存之间传输数据。这个原理看起来并不复杂,但在工程实现时克服了很多障碍,英特尔跟RDIMM厂商一起完成最终的呈现。

在DRAM颗粒速度已经很快的情况下,英特尔增加数据缓冲区来处理128字节的数据传输,并联动控制器,以及满足RAS的需求,来保证数据的完整性和一致性。这不只是简单地把数据分发到两个Rank,而需要在整个工程实现过程中进行大量创新和协作。

对于内存带宽敏感型的应用,企业可利用MRDIMM提供的高带宽去进一步优化。这将涉及到代码级别的改进。

一般RDIMM在频率提高时,其能耗也会相应增加,这同样与内存容量有关。因此,MRDIMM相较于普通RDIMM会有一定的功耗提升,这种提升与带宽和容量基本成正比。

在内存方面,液冷技术已被纳入英特尔的考虑范围,目前讨论的是全冷板液冷方案。例如,使用冷板不仅针对CPU进行散热,而且在大多数主流设计中,包括浪潮信息、新华三、超聚变、联想等公司的产品线,都针对所有关键散热部件进行统一设计。

因此,主流的液冷服务器设计已经考虑了内存部分的散热需求。

MRDIMM使用风冷也是可行的,但随着单颗CPU功耗达到500W,GPU功耗普遍超过700W甚至达到1000W,液冷已经成为数据中心领域解决散热问题的优选。

随着频率提高和带宽增加,成本会有所上升。实际成本需要具体情况具体分析。

三、三大热门内存技术方案各具优势

除了MRDIMM技术外,HBM和CXL同样是当前内存技术领域的热门方向。

因AI需求增长,SK海力士、三星等多家企业在HBM上的投入非常大。英特尔的AI芯片Gaudi也采用了HBM。

HBM通过封装工艺来集成在CPU、GPU或ASIC里,相对来说通用性没那么强,容量基本上都会在96GB以内。由于要封装,它的成本会更高。

而MRDIMM可以支持单插槽800-900GB,基本追平了HBM单插槽带宽的情况。

MRDIMM单条可达256GB,相比HBM,它的容量更大、成本更低。在AI推理或调优场景,当需要大内存容量时,采用MRDIMM既有高性能的表现,同时也可以处理更加通用的场景,针对AI或科学计算的场景更适用。

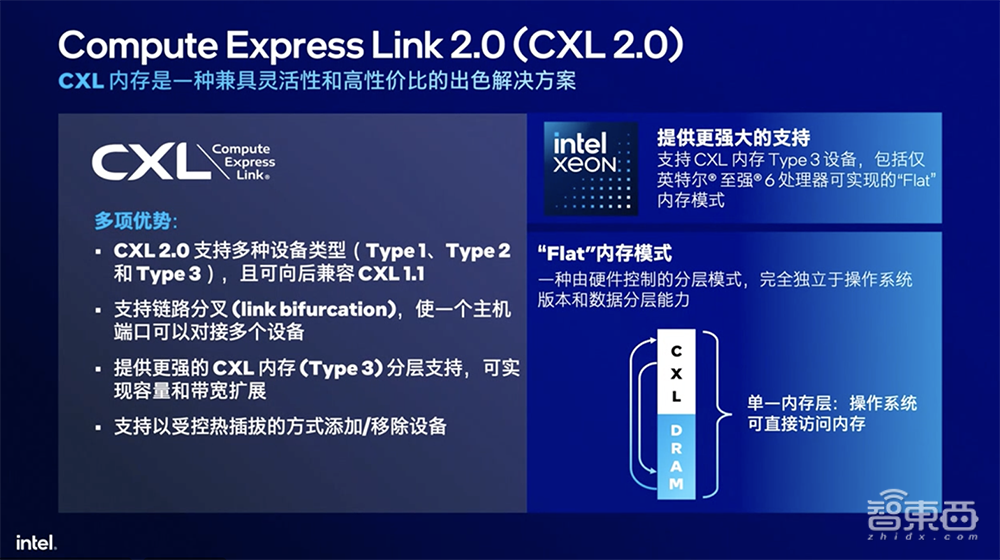

相对于MRDIMM和HBM,CXL是基于PCIe协议来构建的产品,其最大优势不在于极致的带宽和性能,更多为数据中心提供了兼具灵活性和高性价比的解决方案,可以连接相对廉价的内存。

CXL生态正在蓬勃发展中。在远端可以用CXL的内存池,在近端可以用CXL memory expander本机扩展,这样意味着能够用一些价格相对低廉的设备(比如DDR4设备)来支撑业务系统。

经在实际客户处的测试,CXL 2.0在某些经过优化的场景下甚至能达到90%-95%的性能指标。英特尔的核心目标是在满足性能SLA的基础上,提供一个更具性价比的方案。

结语:构建开放生态,推动技术成熟

随着核数的增多、处理能力和主频的提升,相应要打破“内存墙”、突破内存的容量和性能问题,也分别会有不同技术来满足未来数据中心建设的需求。

数据中心对高性能计算和AI应用需求不断增长,推动未来内存技术的发展更加注重性能、能效和可扩展性的平衡。MRDIMM技术后续将朝着更高带宽、更低延迟、更大容量的方向发展,并需解决在技术成熟度、成本问题、生态系统建设等方面的挑战。

该技术仍需要经过市场的进一步验证和成熟度的提升。为了充分发挥其优势,英特尔等公司计划加大研发投入,推动技术创新和生态合作,共同构建一个更加完善、高效的数据中心生态系统。