如何让虚拟人物更加真实地传达情感,一直是AI数字人领域的研究重点。传统的说话头部动画技术虽然能够模拟人物的嘴型和基本表情,但在精细控制和情感表达上仍有局限。

为此,上海交通大学联合网易伏羲提出用于对话人脸生成的高效解耦框架EDTalk,现已开源。相关的论文成果收录于ECCV 2024并获得Oral。其中,上海交通大学计算机系在读博士谭帅为论文一作。

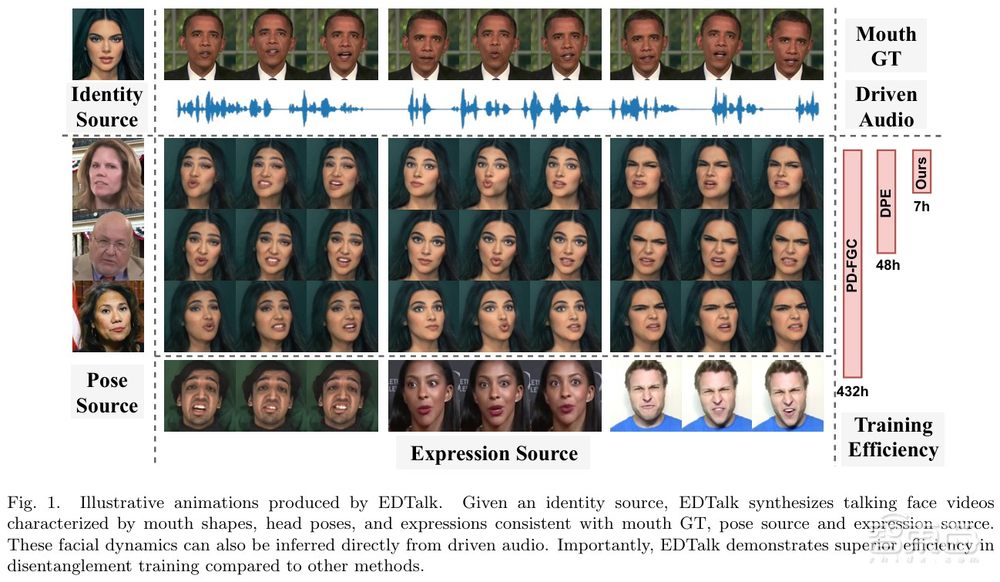

EDTalk能够实现对多种面部动作的分离控制,并适应不同的输入模式,提高对话人脸生成的应用性和娱乐性。它能确保面部特征的解耦空间独立操作,互不干扰;并保持与不同模态输入共享。EDTalk可以根据视频或音频输入,对嘴形、头部姿势和情感表达进行单独操作。具体来说,该框架采用三个轻量级模块将面部动态分解为三个不同的潜在空间,分别代表嘴型、姿势和表情。每个空间都有一组可学习的基,这些基的线性组合定义了特定的动作。

为了确保独立性并加快训练速,该团队强制执行了基数之间的正交性,并设计了一种高效的训练策略,在不依赖外部知识的情况下给每个空间赋予其特定的运动方向。随后将学习到的基存储在相应的库中,从而实现与音频输入共享视觉先验。此外,考虑到每个空间的特性,该团队提出了音频到动作模块,用于音频驱动的对话人脸合成。

12月30日晚7点,智猩猩邀请到论文一作、上海交通大学计算机系在读博士谭帅参与「智猩猩AI新青年讲座」第262讲,主讲《高效解耦的可控对话人脸生成》。

讲者

谭帅,上海交通大学计算机系在读博士

主要研究方向是数字人驱动/Talking head generation/face animation,共发表论文11篇,其中以第一作者身份发表CVPR/ICCV/ECCV/AAAI/MICCAI等会议共6篇。

第 262 讲

主 题

《高效解耦的可控对话人脸生成》

提 纲

1、对话人脸生成技术当前存在的不足

2、高效解耦用于可控对话人脸生成的框架EDTalk

3、分解嘴型-姿势和表情的解耦策略

4、用于生成音频驱动对话人脸的音频动作模块

5、其他相关工作介绍

直 播 信 息

直播时间:12月30日19:00

成果

论文成果1

标题:

《EDTalk: Efficient Disentanglement for Emotional Talking Head Synthesis》

链接:

https://arxiv.org/abs/2403.06363

项目地址:

https://tanshuai0219.github.io/EDTalk/

收录情况:ECCV 2024 Oral

论文成果2

标题:

《EMMN: Emotional Motion Memory Network for Audio-driven Emotional Talking Face Generation》

链接:

https://ieeexplore.ieee.org/document/10378627

收录情况:ICCV 2023 (CCF-A)

论文成果3

标题:

《Say anything with any style》

链接:

https://arxiv.org/abs/2403.06363

收录情况:AAAI 2024 (CCF-A)

论文成果4

标题:

《Style2talker: High-resolution talking head generation with emotion style and art style》

链接:

https://arxiv.org/abs/2403.06365

收录情况:AAAI 2024 (CCF-A)

论文成果5

标题:

《FlowVQTalker: High-Quality Emotional Talking Face Generation through Normalizing Flow and Quantization》

链接:

https://arxiv.org/abs/2403.06363

收录情况:AAAI 2024 (CCF-A)

入群申请

有讲座直播观看需求的朋友,可以添加小助手“米娅”进行报名。已添加过“米娅”的老朋友,可以给“米娅”私信,发送“ANY262”进行报名。对于通过报名的朋友,之后将邀请入群进行观看和交流。