智东西(公众号:zhidxcom)

作者|程茜

编辑|心缘

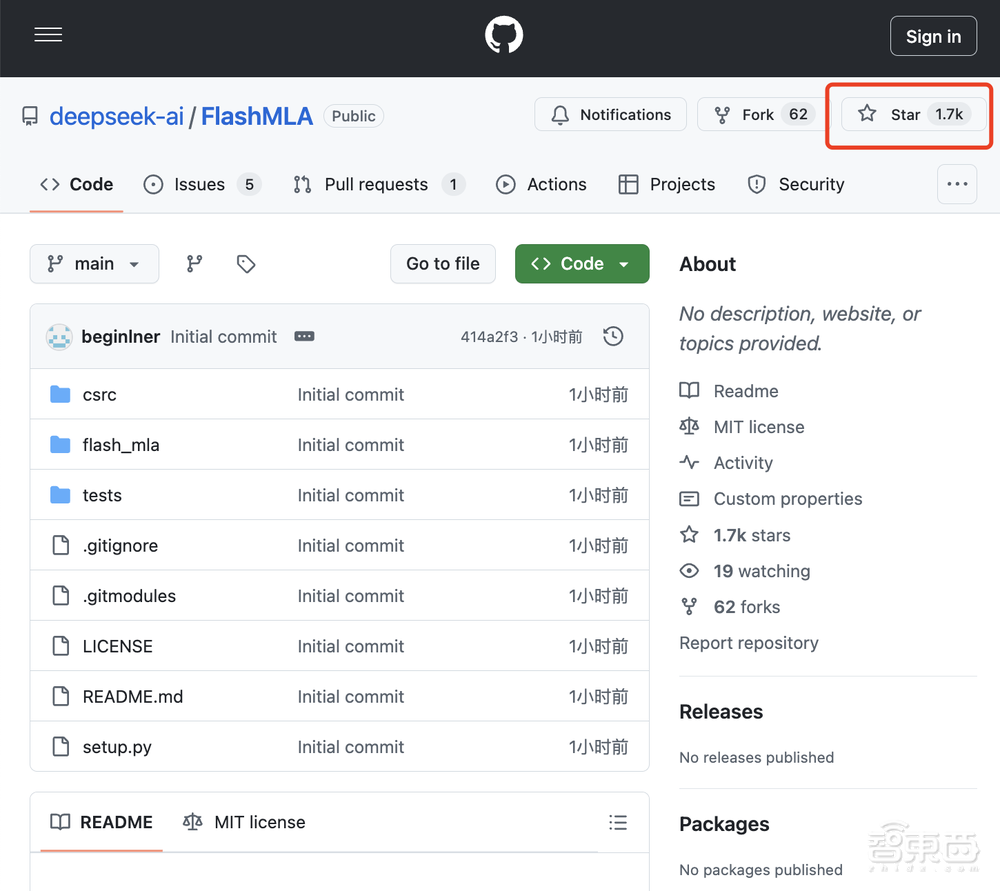

智东西2月24日报道,刚刚,DeepSeek开源周第一天重磅更新来了,开源首个代码库——FlashMLA,发布一小时GitHub Star数冲上1700。

FlashMLA指的是DeepSeek针对Hopper GPU的高效MLA解码内核,针对可变长度序列进行了优化,现已投入生产。目前已发布的内容包括:采用BF16,以及块大小为64的分页kvcache(键值缓存)。

3000 GB/s内存带宽(内存限制性能),支持快速数据访问和传输。

580 TFLOPS计算性能(计算约束性能),为AI工作负载提供高计算吞吐量。

这种优化可以确保FlashMLA在高性能硬件上有效地处理大语言模型和其他AI应用程序的密集计算需求。

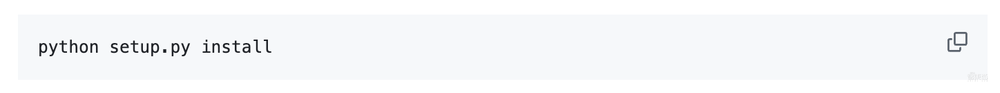

快速启动安装:

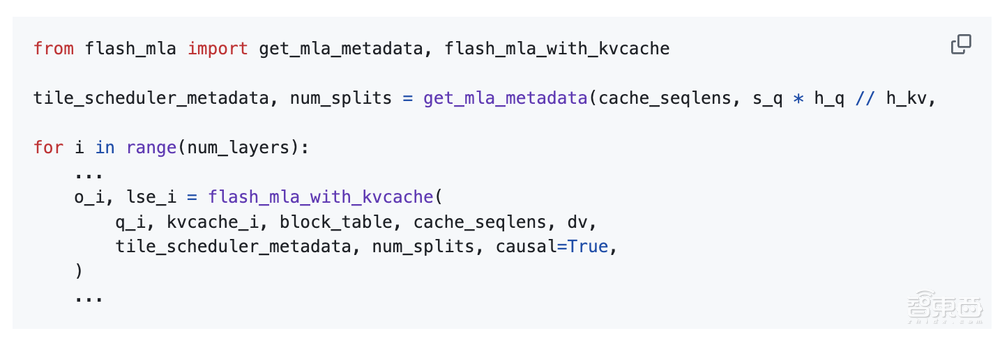

用法:

FlashMLA的使用基准为:Hopper GPU、CUDA 12.3及以上版本、PyTorch 2.0及以上版本。

DeepSeek介绍称,FlashMLA受到FlashAttention 2&3和CUTLASS项目的启发。

其中,FlashAttention是斯坦福联合纽约州立大学在22年6月份提出的一种具有IO感知,且兼具快速、内存高效的新型注意力算法;CUTLASS是由英伟达开发和维护的开源项目,CUTLASS提供了更高级别的灵活性和可配置性,允许用户自定义和优化矩阵运算的细节。

DeepSeek开源FlashMLA的推文发布不到一小时,就已经吸引了超10万人关注,上百条评论。

已有海外开发者第一时间研究起了FlashMLA的代码库,他感叹道:“真是纯粹的工程,太爱了!”

有一位英伟达股民跑到DeepSeek的评论区祈祷,希望DeepSeek能在不影响英伟达股价的前提下,让GPU更为高效。

更多海外网友已经迫不及待,开启了催更模式,有人让DeepSeek抓紧研发语音模式,也有人猜想第五天发布的开源产品会不会是AGI。

GitHub地址:https://github.com/deepseek-ai/FlashMLA

结语:DeepSeek开源周,后四弹蓄势待发

DeepSeek开源周开启,本周首个重磅发布FlashMLA瞬间点燃AI圈的热情。本周后续,DeepSeek还将开源四个代码库,或许会与AI算法优化、模型轻量化、应用场景拓展等相关,涵盖多个关键领域。

期待接下来的四场技术盛宴,向开源者们致敬。