智东西(公众号:zhidxcom)

编译 | 尹非非

编辑 | 云鹏

智东西3月14日消息,近日,日本AI初创公司Sakana AI于社交媒体上声称,其AI生成论文通过首批同行评审。这篇论文由AI Scientist的改进版本AI Scientist-v2生成,通过了ICLR研讨会的双盲审查。

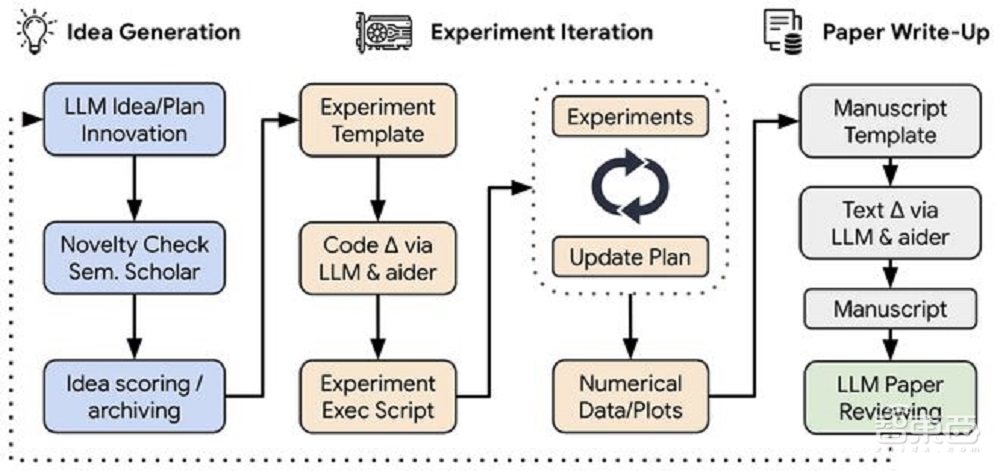

AI Scientist-v2的前身AI Scientist由Sakana AI于去年推出,是世界上第一个用于自动化科学研究和端到端论文生成的的人工智能系统。只要给定初始代码库的研究方向,AI Scientist可以完成构思、文献搜索、实验设计、实验迭代、图表生成、手稿撰写和审查等步骤。

而ICLR则是机器学习和人工智能研究领域的三个顶级会议之一,另外两个会议是NeurIPS和ICML。相比于去年仅仅创作论文,AI Scientist这次将论文交由ICLR研讨会进行同行审核的动作,则说明其向自动化科学研究迈出更深一步的探索。

一、AI研究AI,如何“举一反三”

这篇骗过评审员的论文到底讲了什么呢?

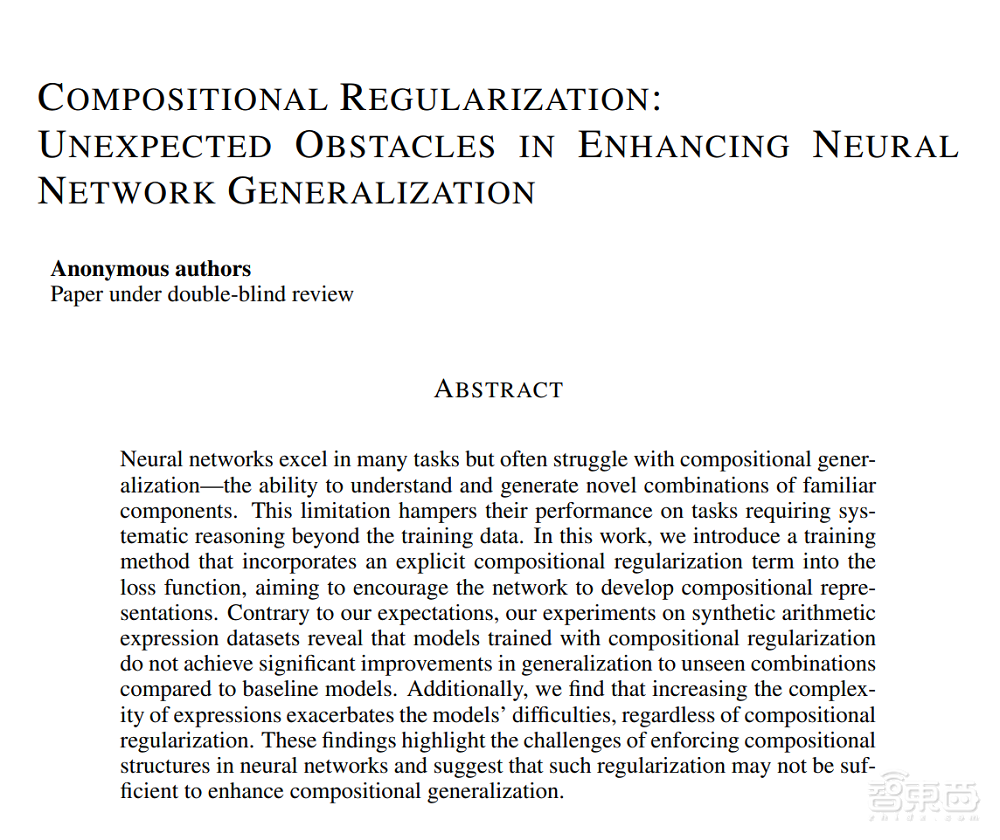

文章的标题为《组合正则化:增强神经网络泛化能力中的意外障碍》,组合泛化(Compositional Generalization)是指模型能够理解和生成由已知组件(如符号、词汇、操作符),并按规则组合而成的新组合的能力,这是人类认知的一个基本方面,通俗来讲就是“举一反三”。

而研究的难点在于,尽管现在的AI模型(比如常用的LSTM神经网络)在许多任务中表现出色,但面对这类需要“举一反三”的任务时,常常遇到困难,这限制了它们在系统性推理任务中的应用。

之前的研究探索了各种方法来增强组合泛化,包括架构修改和训练策略。其中一种有前景的方法是引入正则化项,以鼓励AI学习。正则化项(Regularization Term)是机器学习中一种用于防止模型过拟合的技术,通过在损失函数中添加额外的约束或惩罚项,限制模型参数的复杂度,从而提高模型在未见过数据上的泛化能力。简单来说就是在训练过程中给AI定规矩,有赏有罚。

于是,这篇论文提出了一种通过在训练损失中加入显式的组合正则化项来增强神经网络组合泛化的方法。具体来说就是:

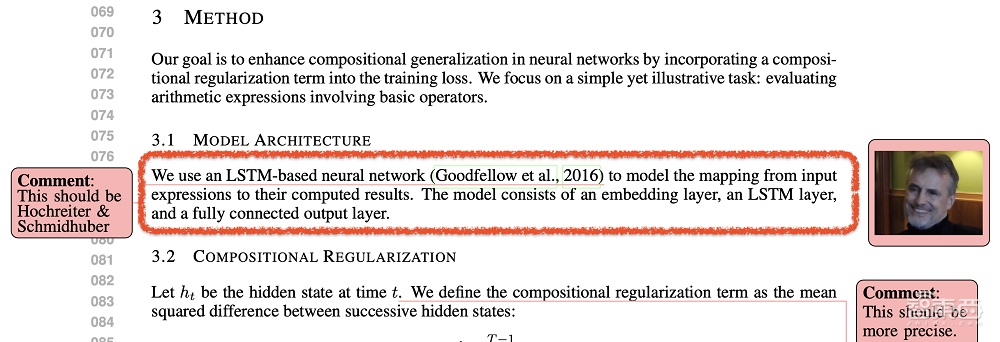

·模型架构:使用基于LSTM的神经网络来建模从输入表达式到计算结果的映射。该模型包括一个嵌入层、一个LSTM层和一个全连接输出层。

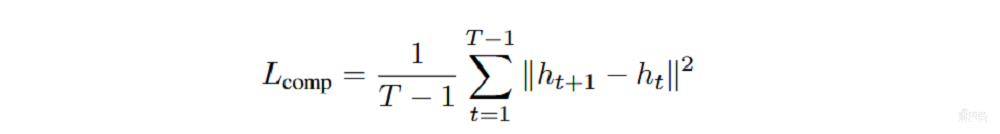

·组合正则化:定义组合正则化项为连续隐藏状态之间的均方差异:

其中,T是输入序列的长度。该正则化项惩罚隐藏状态之间的较大变化,鼓励模型形成加法表示,这是一种简单的组合形式。

·训练目标:总损失是主要损失(预测结果与真实结果之间的均方误差)和组合正则化项的加权和:

其中,λ是超参数,用于调整组合正则化项的权重。

1、实验设计

数据收集:生成包含数字和运算符的算术表达式合成数据集。数据集包括训练集和测试集,测试集中的表达式包含未见过的数字和运算符组合,以及更高复杂度的运算符。

实验设置:

- 模型使用Adam优化器和均方误差损失进行训练,共训练30个epoch。

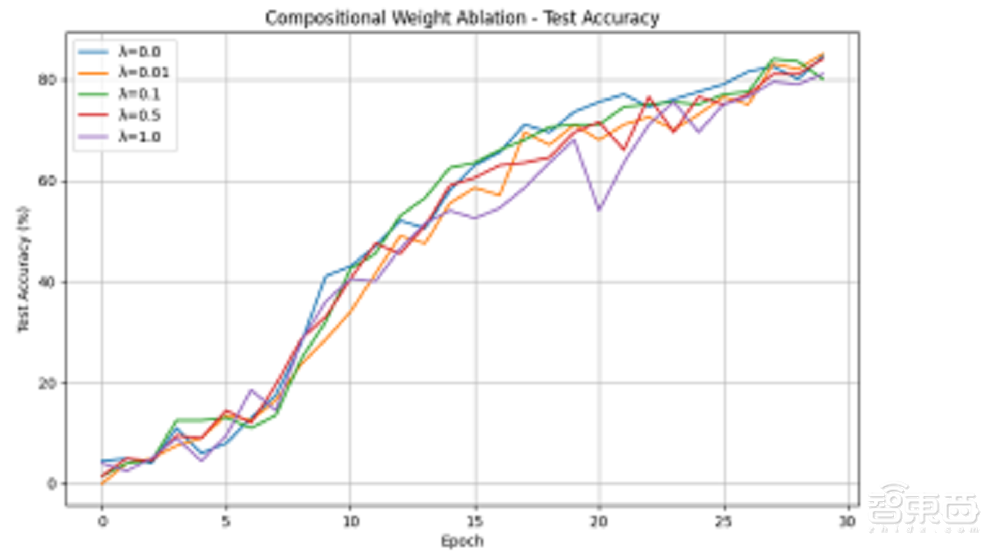

- 组合正则化项的权重λ默认设置为0.1,除非另有说明。

- 使用测试准确率(在容差范围内的正确预测百分比)和组合损失来评估模型性能。

样本选择:通过不同的超参数和运算符复杂度进行多次实验,以评估其对模型性能的影响。

2、结果与分析

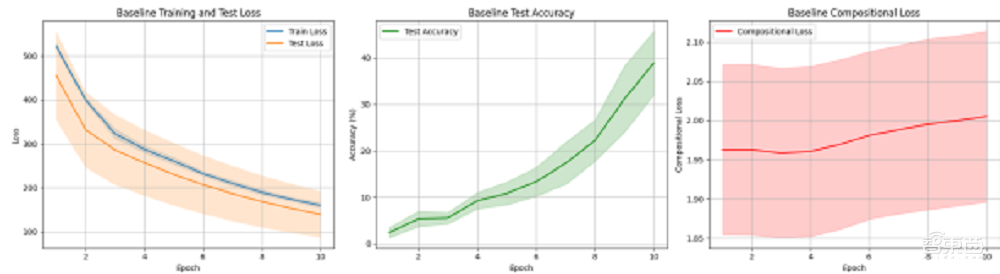

基线性能:基线LSTM模型在没有组合正则化的情况下,测试准确率达到约84%。组合损失在整个训练过程中保持相对稳定,表明模型本身并没有发展出组合表示。

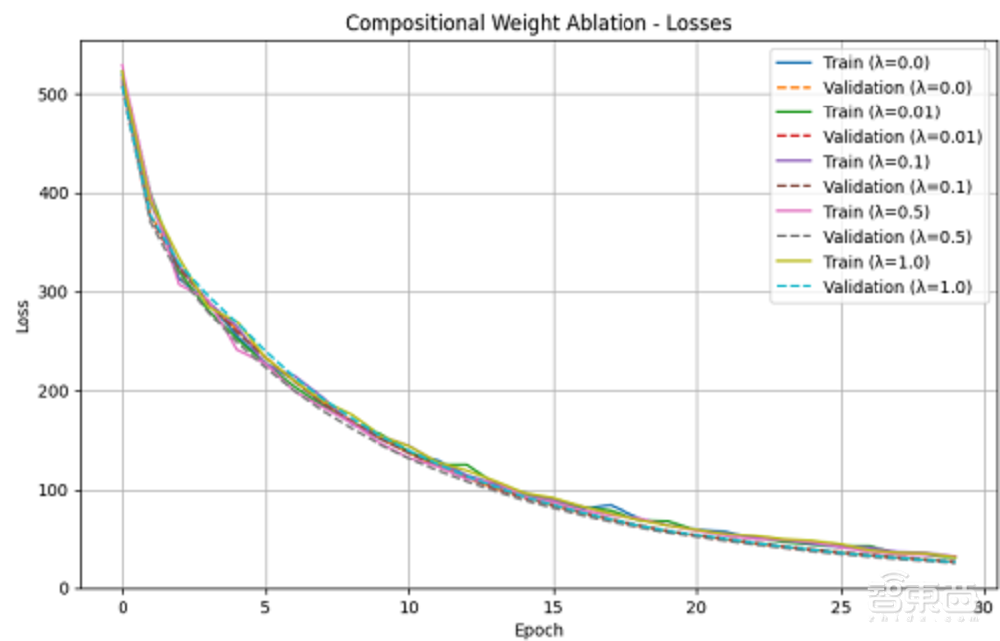

组合正则化的影响:引入组合正则化项后,随着λ值的增加,组合损失减少,但测试准确率并未提高,甚至在某些情况下下降。这表明,尽管组合正则化鼓励了组合表示的学习,但它可能与主要学习目标产生冲突,限制了模型拟合训练数据的能力。

运算符复杂性的影响:随着算术表达式中运算符复杂性的增加,模型的泛化能力显著下降。无论是基线模型还是带有组合正则化的模型,都无法有效处理高复杂度的表达式。

3、总体结论

论文提出了一种通过组合正则化项来增强神经网络组合泛化的方法。实验结果表明:

组合正则化并未带来预期的泛化性能提升,反而在某些情况下阻碍了学习过程。此外,算术表达式复杂性的增加显著加剧了模型的泛化困难,突显了组合正则化在处理复杂组合结构时的局限性。未来建议探索替代的正则化策略,改进组合性的定义,并在更复杂的数据集上进行测试。

这篇论文的亮点或许不在于“成功解决问题”,而在于提出新的问题与矛盾,推动新讨论,即使结果为“负面”,这类研究仍对领域发展至关重要。

总之,AI学组合就像教小孩解奥数题——光靠刷题不行,还得培养逻辑思维和创造力。这次尝试虽然失败了,但为未来的研究指明了方向。

二、同行内部双评审,努力冲顶会

ICLR评审:3篇论文中1篇通过,排名约45%

在这次实验项目中,Sakana与不列颠哥伦比亚大学和牛津大学的研究人员合作,选择AI生成的3篇论文参与ICLR2025研讨会的双盲审查,其中有2篇论文未达到接受标准,1篇论文也就是上文的《组合正则化》的平均得分为6.33,这篇论文在所有提交的作品中排名约为45%。这些分数高于研讨会上许多真人撰写的论文,同时高于平均接受阈值。

具体的分数与阈值关系为:

评分:6:略高于接受阈值

评分:7:好论文,接受

评分:6:略高于接受阈值

内部审查:仍有缺陷,无法通过顶会

除了同行评审,其内部的AI研究人员,也对3篇论文进行自我分析,将之视为提交给ICLR主会的手稿来审查,并为每篇论文撰写了全面的综述,同时添加了内嵌评论。

内嵌评论中提及了一些论文缺陷以及AI常常出现的硬伤,比如文献综述部分存在不准确或不完整的问题;图表部分多出现图表数据不完整、标注不清、阴影区域未解释等问题。此外,论文对于研究方法的描述不够清晰,未充分覆盖组合泛化领域的关键研究(如递归网络、结构感知模型),这可能会导致读者难以理解本文方法的创新性,同时对部分技术细节(如组合正则化的设计动机)缺乏深入解释,有可能影响方法的可复现性。

在实验变量控制方面,论文也未充分说明不同超参数(如嵌入维度、正则化权重)对结果的独立影响,这可能混淆关键结论。在实验结果部分,AI往往发挥诱导作用,导致结论与数据矛盾,例如,注意力机制的实验结果显示基线模型表现更好,但作者未充分讨论这一反直觉现象,反而得出正则化效果更好的结论。

AI Scientist偶尔也会犯令人尴尬的引用错误。例如,它错误地将“基于LSTM的神经网络”归于Goodfellow(2016年),而不是正确的作者Hochreiter和Schmidhuber(1997年)。

除了审查和评论外,AI研究人员们还在初始审查阶段为每篇论文提供了初步评估分数,评估依据NeurIPS和ICLR等顶级ML会议的指南进行。此外,他们还进行了代码审查,以确保AI Scientist-v2所做的实验结果可重复。但论文还是会犯一些初代AI Scientist就已经存在的错误,诸如缺失图表、过多缺失引文和格式问题等。为了提高结果的科学准确性、可重复性和统计严谨性,他们鼓励AI Scientist多次重复每个实验。

最终,研究人员得出结论,3篇论文都没有通过内部审查,并在GitHub仓库中公开了内部人类评审意见,以及这3篇AI生成论文。

总结:伦理与技术——AI科学家的未来

社交媒体上,关于AI科学家的未来,众人莫衷一是。

AI公司Shapes Inc创始人Anushk认为:”AI科学家能对其自身工作进行批判和迭代将是下一个前沿,科学加速即将到来。”

3X创始人Arsen Ibragimov则更关心这次事件对学术界的冲击:“有趣的实验!不过这也引发了许多关于未来学术出版和同行评审流程的问题。我很好奇他们这篇由AI撰写的论文与审稿人关系的透明度如何?”

一名AI领域的研究生Sachit gaudi则分享了ICLR 2025中,由人类撰写的关于组合泛化的论文,并认为:”虽然每个人都既担心又兴奋地关注着由LLM完全生成的论文被ICLR研讨会接收,但LLMs永远无法匹配我的合作者的创造力。”

不论是从研发之初就存在的学术伦理问题,还是本次同行评审通过对学术界造成的冲击,AI Scientist一直是一个充满争议性与创造性的存在。

从全球趋势看,AI生成论文正加速进入学术领域:2023年,Nature在官网发布报道,指出一些研究者使用ChatGPT撰写论文,但并未披露对AI的使用,某些论文在发表后被人发现有明显的AI撰写痕迹,于是被撤稿。Science在2023年禁止AI写作投稿,在2024年才开始解禁。这些事件反映出学术界对AI工具的审慎态度。

但不可否认,AI写作也正在重塑学术评价体系。ICLR 2025允许AI论文参评,或许也标志着评审标准从“人类主导”转向“结果导向”;而月之暗面Kimi“论文工厂”的高效产出模式,更对传统科研周期形成冲击。

学术伦理与技术创新的博弈仍在持续。欧盟将学术AI列为高风险技术、中国禁止AI生成论文用于职称评定,国内各大高校对AI的态度也各有不同,这些监管动向并非否定技术价值,而是强调科学精神的不可替代性。正如Sakana AI创始人所言,AI的目标应是“推动人类繁荣”,而非替代人类思考。未来,或许会出现真正意义上被承认的AI论文,但在此之前,如何界定AI的学术角色、保障科研的原创性与透明度,仍是待解的命题。

来源:Sakana官网,Techcrunch