DeepSeek通过软硬件协同的的全栈优化策略,在有限的硬件资源下实现了极致的性能提升。

比如利用FlashMLA技术针对多头潜在注意力进行优化,能够充分释放GPU算力。此外,DeepSeek还通过底层编程语言PTX直接对硬件资源进行调配,实现了寄存器分配、线程调度的细粒度优化。在软件层面,DeepSeek通过FP8混合精度训练、KV Cache缓存优化、并行计算等技术,进一步提升了系统的整体效率。

DeepSeek的成功,充分证明了软硬件协同优化的巨大潜力,也为AI Infra的未来技术发展提供了新的思考方向和借鉴思路。

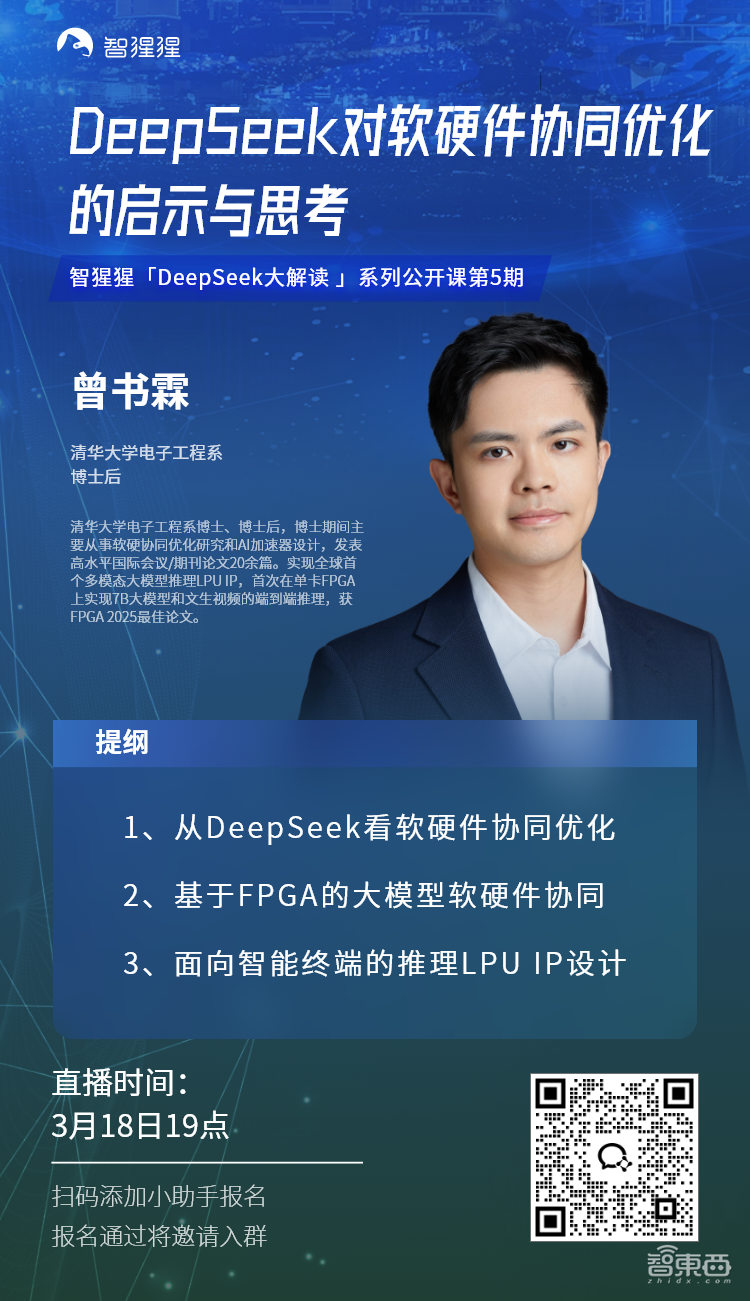

3月18日19点,智猩猩「DeepSeek大解读」系列公开课第5期将开讲,由清华大学电子工程系博士后曾书霖主讲,主题为《DeepSeek对软硬件协同优化的启示与思考》。

曾书霖博士主要从事软硬协同优化研究和AI加速器设计,实现了全球首个多模态大模型推理LPU IP,并首次在单卡FPGA上实现7B大模型和文生视频的端到端推理,获得了FPGA 2025最佳论文。

本次公开课,曾书霖博士首先会分享DeepSeek在软硬件协同优化方面的创新和思考,之后会围绕大语言模型推理 IP FlightLLM、视频生成大模型推理 IP FlightVGM,阐述团队基于FPGA的大模型软硬件协同工作。最后,曾书霖博士还将深入讲解面向智能终端的推理LPU IP设计。

公开课内容

主题:DeepSeek对软硬件协同优化的启示与思考

提纲:

1、从DeepSeek看软硬件协同优化

2、基于FPGA的大模型软硬件协同

3、面向智能终端的推理LPU IP设计

主讲人

曾书霖,清华大学电子工程系博士、博士后,博士期间主要从事软硬协同优化研究和AI加速器设计,发表高水平国际会议/期刊论文20余篇。实现全球首个多模态大模型推理LPU IP,首次在单卡FPGA上实现7B大模型和文生视频的端到端推理,获FPGA 2025最佳论文。

直播时间

3月18日19:00-20:00