智东西(公众号:zhidxcom)

作者 | 王欣逸

编辑 | 程茜

智东西12月17日报道,今天,腾讯混元发布并开源了最新的混元世界模型1.5(Tencent HY WorldPlay),用户输入文字指令或者图片即可创建可交互世界,该模型拥有空间记忆能力,能呈现出前后一致的场景,支持用户在生成的世界里随意移动探索。目前,这一模型可在腾讯混元3D官网申请体验。

这一模型支持生成第一视角和第三视角场景,能生成多种类型的风格化场景,还支持场景触发特定效果,可应用于AI游戏开发、影视制作和虚拟现实(VR)和具身智能训练等领域。从官方给出的效果图来看,仅通过输入“废弃游乐园,生锈的摩天轮,杂草丛生,怀旧忧伤”这一指令,该模型便生成了精度很高、内容丰富的游戏风格场景,空间内风格一致,要素齐全。

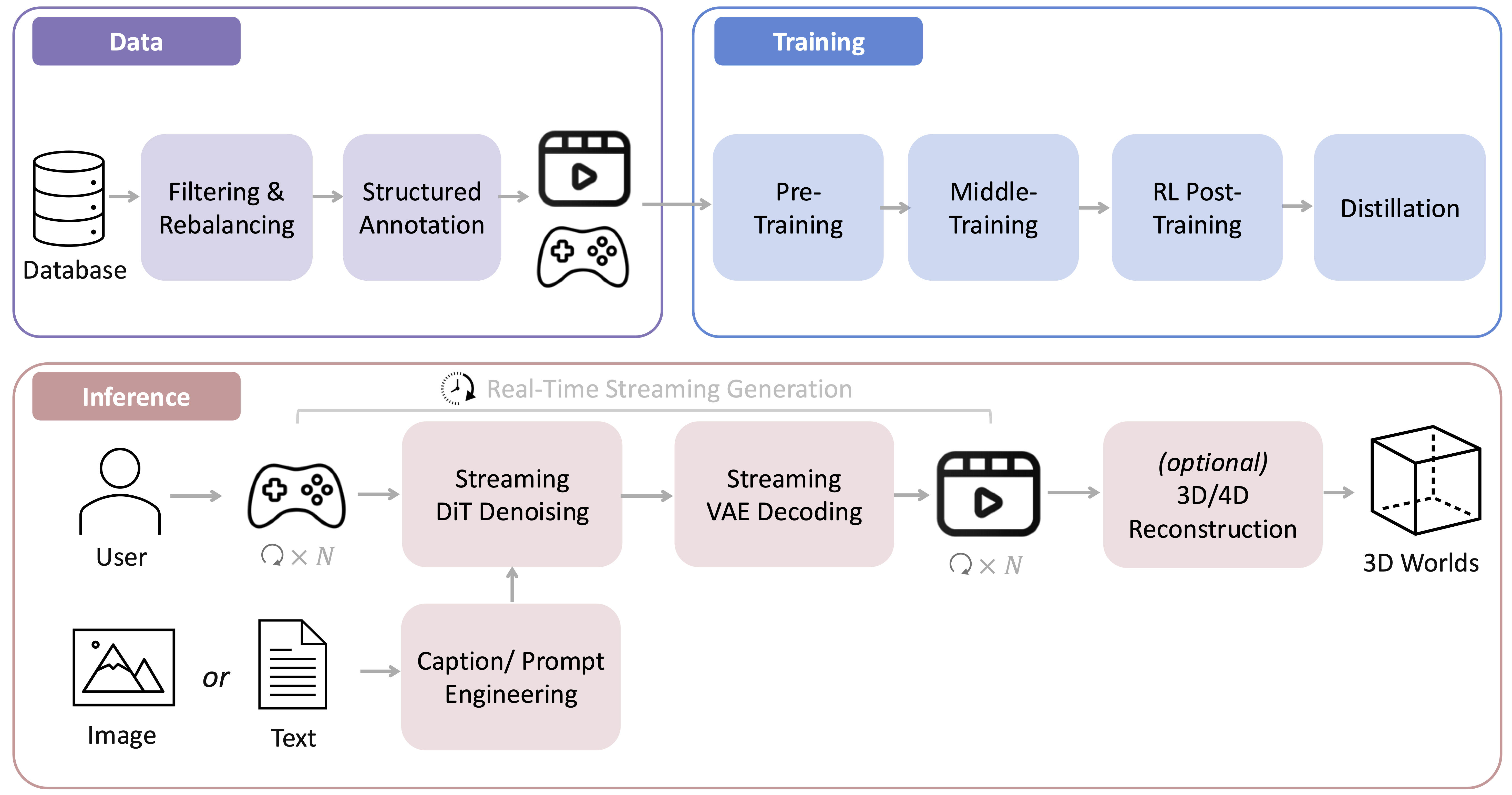

腾讯混元团队称其是业界最系统、最全面的世界模型框架,涵盖数据、训练、流式推理部署等全链路、全环节,还提出了重构记忆力、长上下文蒸馏、基于3D的自回归扩散模型强化学习等算法模块。

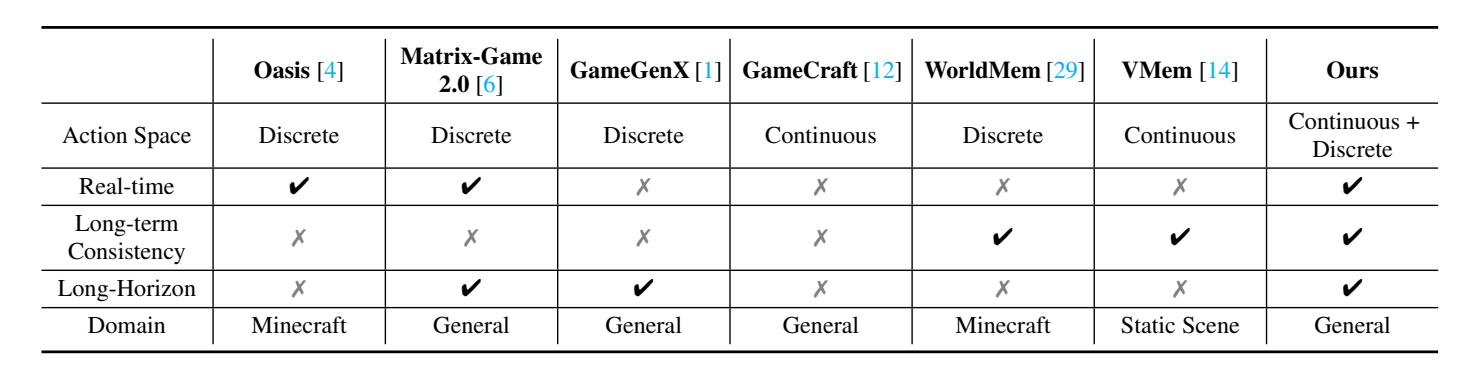

从基准测试的结果来看,混元世界模型1.5在视觉质量和几何一致性指标上超越所有模型,仅在相机控制准确性的旋转指标上略落后于Gen3C和ViewCrafter两个模型。和其他现有模型相比,混元世界模型1.5在实时性、长期一致性和长视野预测等方面存在明显优势。

此前,腾讯混元团队于今年7月发布了混元3D世界模型1.0,这一模型支持文本或单张图片输入生成兼容渲染Pipeline的3D场景;10月,混元发布了世界模型1.1,它支持多视图或视频一键创造3D世界。此次更新则是混元世界模型交互能力的关键一步。相比于上一个版本,混元世界模型1.5的空间记忆检索能力进一步升级,此外,新模型还新增了3D场景重建、场景特定触发事件等功能,而不仅仅止步于生成沉浸式的3D世界。

在线体验网站:https://3d.hunyuan.tencent.com/sceneTo3D?tab=worldplay

GitHub:https://github.com/Tencent-Hunyuan/HY-WorldPlay

Hugging Face:https://huggingface.co/tencent/HY-WorldPlay

一、支持文、图输入,生成多视角、风格化场景视频

混元世界模型1.5支持文字输入指令生成和图片及文字指令输入,可以生成第一视角和第三视角场景。用户可以通过键盘、鼠标或手柄操控该世界里的虚拟相机的移动和转向。

第一视角即为虚拟相机直接呈现出的画面,随着镜头机位的移动,画面随之进行变换。在官方给的案例中,第一视角的场景随着机位的上下左右旋转,画面比较稳定,符合人眼的视觉效果。

第三视角则是在虚拟相机前增加了一个人物,用户通过操控鼠标、键盘等移动人物,画面会随着人物的移动而改变,值得一提的是,官方给出的案例视频非常精细,在跟随人物走动时相机有轻微晃动效果。

混元世界模型1.5支持多种风格化场景,从生成案例来看,其画面稳定性和风格一致性表现不错。

该模型还支持场景触发特定效果,如冒烟、爆炸等。

此外,官方还给出了几个3D重建的案例,包括狭小空间、室内场景和开放室外空间。从生成结果来看,该模型能基于二维图像自动补齐信息,重建出的场景比较规整。

二、多个指标全面碾压现有模型,几何一致性和视觉质量出色

研究人员将基线模型分成两组:一组为无记忆机制的动作控制扩散模型,包括CameraCtrl、SEVA、ViewCrafter、Matrix-Game 2.0、GameCraft;另一组为有记忆机制的模型,包括Gen3C、VMem。

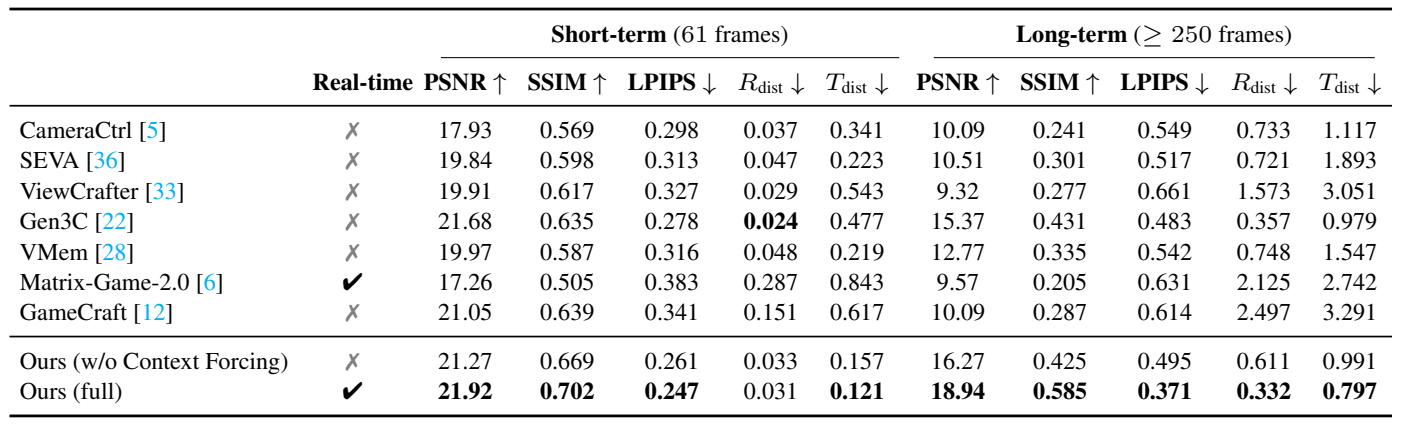

基准测试显示,从短期生成质量来看,混元世界模型1.5在视觉质量(LPIPS、PSNR、SSIM)上表现出色,全面超越CameraCtrl、SEVA等其他模型,在相机控制准确性的旋转距离指标Rdist上,混元世界模型1.5比Gen3C和ViewCrafter稍逊色,但仍处于所有模型的领先地位。

在长期场景中,混元世界模型1.5所有指标均超越所有模型,尤其是在控制准确性上,研究人员指出这是由于其他模型误差累积导致的控制准确性显著下降,这体现了混元世界模型1.5的较高稳定性和一致性特性。

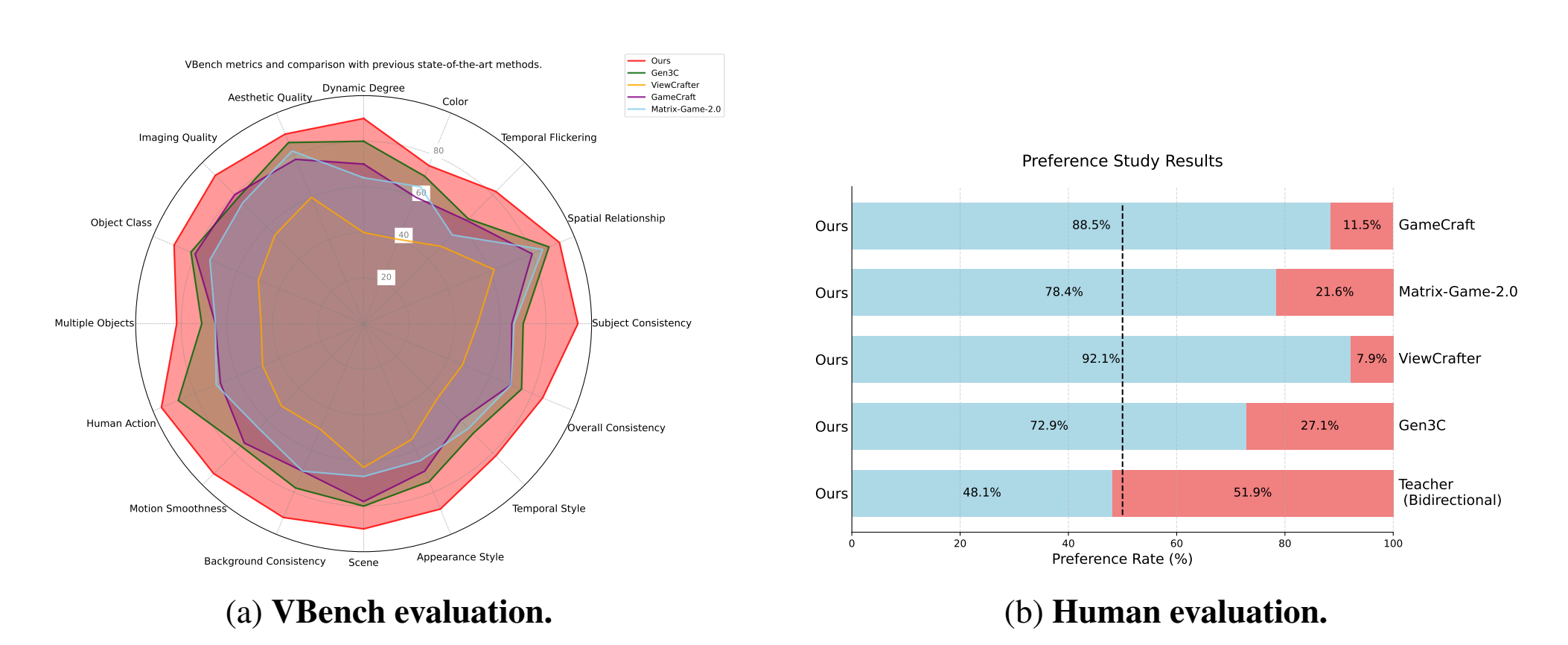

在VBench定量基准测试中和人工评估结果中,上述结果得到了验证。

在长期几何一致性和视觉质量上,研究人员让几个模型一起进行自由探索。混元世界模型1.5在场景泛化方面表现出色,通过重构上下文记忆确保了长期的几何一致性。Gen3C使用了显式的3D缓存,对中间输出的质量高度敏感,深度估计的准确性存在问题,Matrix-Game 2.0和GameCraft由于缺乏专用的记忆机制,无法支持自由探索。

在WorldPlay的强化学习框架WorldCompass的能力上,研究人员还进行了关于有无WorldCompass RL训练阶段的模型在处理复杂动作时的性能比较,结果显示,WorldCompass RL框架在提升模型复杂交互能力起着关键作用,在无RL训练时,处理复杂交互信号时模型表现出了视觉退化,而有RL训练则显著提高了模型的动作跟随精度和视觉保真度。

三、提出全新强化学习框架,能动态重构上下文

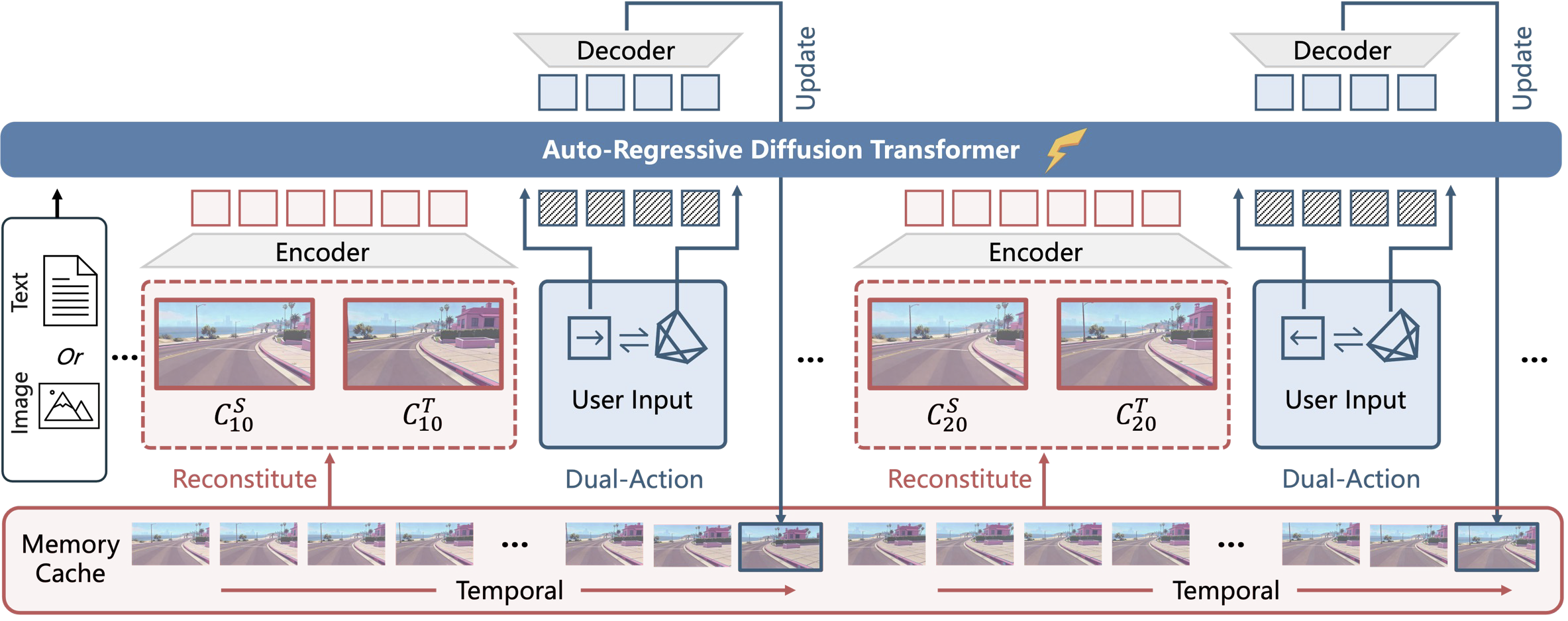

混元世界模型1.5的核心是WorldPlay自回归扩散模型,它克服前代HY-World 1.0依赖冗长的离线生成、缺乏实时交互的局限,实现了高质量、长序列的流畅视频生成,速度可达每秒24帧。

该模型提供了一个系统而完整的实时世界模型训练框架,覆盖模型预训练、持续训练、自回归视频模型强化学习、带记忆力的模型蒸馏的训练全流程。

混元世界模型1.5依赖于一个包含320K视频片段的综合训练数据集。这些数据来自3A游戏、真实世界的3D场景、合成4D数据以及自然动态视频。

世界模型长期以来难以兼顾实时生成与系统内存占用,为此,混元世界模型1.5采取了四项核心设计,有效解决了这一矛盾:

1、双重动作表示法:系统可精准响应用户的键盘与鼠标输入,实现对生成内容的实时控制。

2、重构上下文记忆机制:通过动态重建过往帧信息,并结合时间重构策略,系统能够维持长期的几何一致性,显著缓解了长视频生成中常见的记忆衰减问题。

3、WorldCompost强化学习框架:这一新型后训练框架专门针对长序列自回归视频模型优化,直接提升了动作跟随能力和生成画面的视觉质量。

4、情境强迫蒸馏法:该方法通过对齐教师模型与学生模型之间的记忆上下文,在确保生成速度的同时,保持了模型利用长远历史信息的能力,从而有效抑制误差累积。

基于以上技术,在用户给定一张图片或一段描述世界的文本提示,该模型能够根据用户输入的动作条件,执行下一片段(16个视频帧)预测任务,以生成未来的视频序列。在生成每个片段时,该模型可以动态地从过往片段中重构上下文记忆,以此确保长期的时序一致性与几何一致性。

结语:正探索更复杂的交互和物理世界模拟

混元世界模型1.5较此前版本的1.0模型做出了较大提升,突破了此前实时交互和空间细节的局限,为创建一致且交互式的虚拟世界迈出了关键一步。

腾讯混元又开源一世界模型,这为游戏开发、虚拟现实、数字内容创作等应用场景提供了新的工具与更多的可能性。混元团队称,他们正在探索让模型能够生成更长时间的视频序列,以及支持多智能体交互和复杂的物理世界动态。