智东西(公众号:zhidxcom)

编 | 韦世玮

导语:近年来AI芯片竞赛火热,多样化的应用场景需求也催生出了架构各异的AI芯片,而它们正面临落地的挑战。

智东西9月28日消息,近日,美国媒体VentureBeat对近年来行业在AI芯片竞争中研发的新芯片架构进行解读,其中包括神经拟态芯片、光学计算芯片和Cerebras WSE芯片。

随着社会越来越多领域的问题都试图采用AI技术来解决,因此,一场围绕AI技术的军备竞赛也就此爆发,而其中,就有以更高速度、更低运行功耗,以及支持深度学习等特征的专用硬件——AI芯片。

毫无疑问,AI芯片的芯片体系结构较以往来说,均有着较大的技术突破,它们执行的计算方式也与从前有着许多差异。这次,VentureBeat通过对三种典型AI芯片功能的拆解,来分析它们将在未来几年内催生的各种AI应用程序。

一、神经拟态芯片:中国“天机(Tianjic)”芯片

神经拟态芯片主要用于进行神经拟态计算(Neuromorphic Computing),简单来说,它可通过数字电路,来模拟人类大脑的行为,能够进行计算和自主学习等功能。

神经网络由成千上万个小程序组成,它们负责通过简单的计算来执行复杂的任务,例如检测图像中的对象,或将语音转换为文本,而这些也是深度学习的关键。

但传统计算机并未针对神经网络操作的特征进行优化,相反,它们由一个或几个强大的CPU组成。

相比之下,神经拟态计算机则使用另一种全新的芯片架构——神经拟态芯片,以一种物理的形式来模拟神经网络。

神经拟态芯片由许多物理人工神经元组成,这些神经元直接与其软件的对应部分相对应,使得它们能快速地训练和运行神经网络。

实际上,神经拟态计算的概念在1980年代就已出现。但当时,神经网络的效率十分低下,因此并未广泛地引起人们的关注。

直到近年来,随着技术的发展,以及深度学习和神经网络的兴起,关于神经拟态芯片的研究也再次回到研究人员的关注视野。

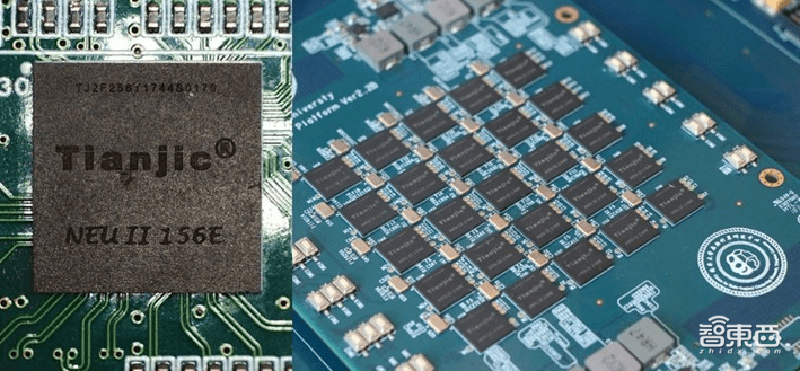

今年7月,中国的一支清华芯片团队研发出了一颗名为“天机(Tianjic)”的神经拟态芯片,它采用28nm制程,由156个FCores组成。同时,其面积为3.8×3.8毫米,包含了大约40000个神经元和1000万个突触,可同时支持机器学习算法和类脑电路。

研究人员曾将该芯片整合到自动驾驶自行车中测试芯片性能,显示其能够实现目标检测、导航和语音识别等功能。

这一研究成果不仅发表在了顶级学术杂志《自然(Nature)》中,也成功登上了杂志封面。而研究人员也在论文中说到:“我们的研究有望通过为更通用的硬件平台铺平道路,来刺激AGI(通用人工智能)的发展。”

尽管目前,并没有直接证据表明神经拟态芯片是创建人工智能的正确途径,但它们肯定会有助于创建更高效的AI硬件。

与此同时,神经拟态计算也引起了各大高科技巨头们的关注。

今年上半年,英特尔推出了一台装有64个Intel Loihi神经拟态芯片的计算机,名为“Pohoiki Beach”,它能够模拟800万个人工神经元。英特尔表示,Loihi的信息处理速度比传统处理器快1000倍,效率最高10000倍。

二、光学AI加速器与“全光学”神经网络

随着技术的发展,神经网络和深度学习计算需要大量的计算资源和电力。

但随之而来的,AI的碳足迹也已成为一个环境问题。同时,神经网络的部署也受到能耗的影响,特别在电力有限的环境中十分受限,例如电池供电设备。

而且,随着摩尔定律发展的持续放缓,传统的电子芯片也正努力跟上AI行业不断增长的需求。

如今,许多公司和研究实验室已转向光学计算领域,以寻找解决AI行业中速度和电力问题的解决方案。

简单地说,光学计算使用光子硬件代替电子硬件,并使用光学信号代替数字电子设备来进行计算。

由于光学计算设备并不会像铜缆那样产生热量,因此其能耗大大降低。光学计算机也特别适用于快速矩阵乘法,而这也是神经网络中的关键操作之一。

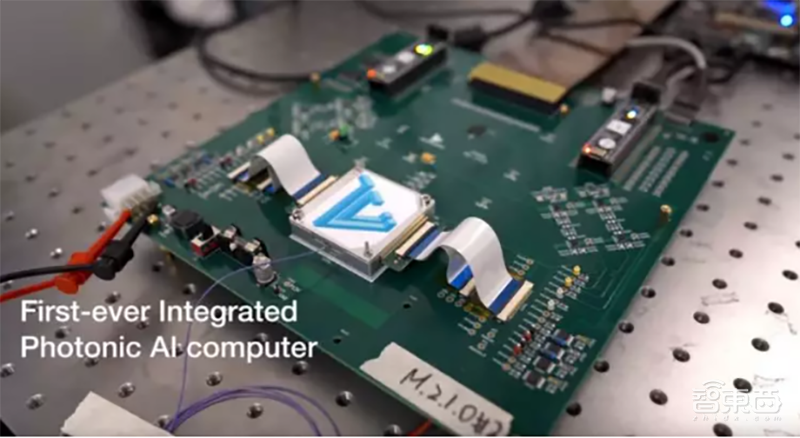

今年上半年,总部位于波士顿的光学AI芯片创企Lightelligence研发了一款光学AI加速器,该光学加速器与当前的电子硬件兼容,并可通过优化一些重型神经网络计算,将AI模型的性能提高一两个数量级。

Lightelligence的工程师表示,光学计算的进步还将降低制造AI芯片的成本。

就在前段时间,香港科技大学研究人员研发了双层全光学神经网络。该全光学神经网络(AONN)使用的线性函数和非线性激活函数,均根据光学实现。同时,它还能扩展到更加复杂的神经网络架构,以完成图像识别等更复杂的任务。

目前,研究人员已经开发了一种概念验证(proof-of-principle)模型,可以模拟具有16个输入和2个输出的完全连接的两层神经网络。

此外,大规模的光学神经网络能以光速和低能耗运行计算密集型应用,包括从图像识别到科学研究领域。

三、有史以来最大规模AI芯片:Cerebras WSE

在研发AI芯片的过程中,还有一种解决方式就是扩大规模。

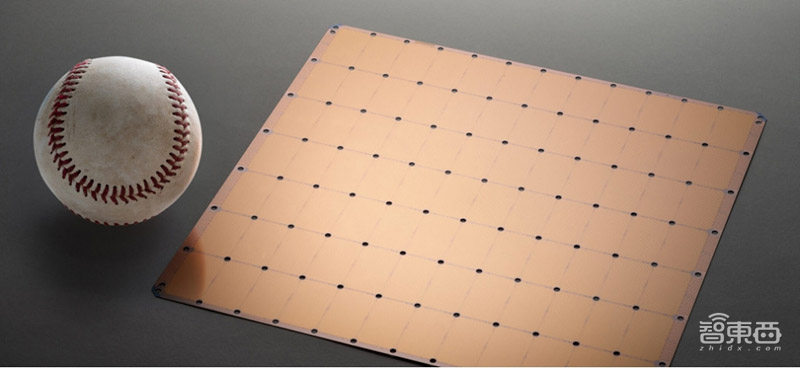

今年8月,美国硅谷的一家AI芯片创企Cerebras Systems推出了有史以来规模最大的AI芯片,名为“Cerebras WSE”。

Cerebras WSE包含1.2万亿个晶体管,其芯片面积为46225平方毫米,比当前市场上最大的英伟达Tesla V100大56倍。

同时,该芯片采用台积电16nm制程,面积每边约22厘米(约8.5英寸),拥有40万个AI优化核心和18 Gigabytes片上内存。

在带宽方面,Cerebras WSE还拥有9 PByte/s内存带宽和100 Pbit/s fabric带宽。

该芯片主要用于深度学习的加速神经网络训练,不仅能加快数据处理速度,还能以更快的速度训练AI模型。同时,与传统的GPU和CPU相比,Cerebras WSE拥有的独特架构还进一步降低了能耗。

当然,该芯片的尺寸也将在一定程度上,影响它在空间受限环境中的使用。因此,它的商用价值在公布后也受到了一定的质疑。

然而,Cerebras最近也与美国能源部的两大实验室达成合作,率先签下商用落地的第一份合同。美国能源部将使用该芯片来加速科学、工程和健康领域的深度学习研究。

结语:AI芯片市场潜力巨大,正面临落地挑战

近年来,AI芯片的风口一度火爆,许多AI芯片创企和研究室拔地而起,针对深度学习训练而研发出的新成果,也一次次地刺激着人们对AI和芯片未来发展认知的神经。

就行业来看,AI芯片的市场潜力十分庞大,一面是云端和边缘段AI芯片的火热,一面是终端AI芯片的转型和爆发,IoT、智能家居、智能手机和自动驾驶汽车等多个甚至碎片化的应用场景等待着它的“哺乳”。

深度学习应用的行业和领域是多样化的,单一架构几乎不可能主导市场。毫无疑问,未来也将涌现出更多突破性的AI芯片技术,给整个社会、行业和人们的生活带来变革性的发展。

现阶段,AI芯片的落地和商用价值也已经进入了大浪淘沙的阶段,未来谁能真正成为赢家?时间将会告诉我们答案。

文章来源:VentureBeat