芯东西(公众号:aichip001)

编译 | 心缘

编辑 | 漠影

芯东西1月7日消息,人工智能(AI)正改变临床诊断、自动驾驶、语音翻译等更多领域,而计算速度和功耗日益成为AI的主要瓶颈。传统电子计算方法逐渐走向性能极限后,近几年,关于用光学芯片加速AI的研究逐渐兴起。

这不,2021年刚开年,顶级科学期刊《Nature》上就在一天之内连发两篇利用光学特性加速AI处理的光子芯片论文。

论文链接:https://doi.org/10.1038/s41586-020-03063-0

其中一篇论文题目为《用于光学神经网络的11 TOPS光子卷积加速器(11 TOPS photonic convolutional accelerator for optical neural networks)》,论文主要作者有Xingyuan Xu、Mengxi Tan等人,来自澳大利亚斯威本科技大学、蒙纳士大学、皇家墨尔本理工大学、香港城市大学、中国科学院等科研院所。

该论文展示了一种通用光学向量卷积加速器,其计算速度可超过10 TOPS(每秒10万亿次运算),能生成足以进行人脸识别的25万个像素的图像卷积。研究人员使用相同硬件运行一个有10个输出神经元的光学卷积神经网络,识别手写数字图像的准确率达88%。

论文链接:https://doi.org/10.1038/s41586-020-03070-1

另一篇论文名为《利用积分光子张量核的并行卷积处理(Parallel convolutional processing using an integrated photonic tensor core)》,论文主要作者有J. Feldmann等人,来自美国匹兹堡大学、德国明斯特大学、英国牛津大学、埃克塞特大学、瑞士洛桑EPFL及苏黎世IBM研究实验室等科研院所。

该论文介绍了一个基于张量核心的计算专用集成光子硬件加速器,通过将相变材料与光子结构结合,运算速度可达每秒数万亿次乘累加运算(每秒1012次MAC运算或每秒tera-MAC运算)。

一、光学频率梳为光子计算带来新机遇

因性能出色,人工神经网络被广泛用于AI处理任务,这些网络使用多层相互连接的人工神经元执行复杂的数学运算,使用大多数计算资源的基本运算称为矩阵矢量乘法。

为了加速人工神经网络计算任务,人们已经进行了各种努力来设计和实现特定的电子计算系统,尤其在专用集成电路、类脑计算和存内计算定制芯片方面已取得相当大的成功。

电子是电子计算中信息的载体,而光子长期以来一直被视为替代选择。

光谱涵盖了广泛的波长范围,因此许多不同波长的光子可以同时进行多路复用(并行传输)和调制(以使其可以携带信息的方式进行更改),而不会相互干扰光信号。信息以光速传播则可以带来最小的时间延迟。

此外,无源传输(不需要输入功率)有助于超低功耗,且相位调制(从而改变了光波的量子力学相位)使得光在频率大于40 GHz时易于调制和检测。

过去几十年,光学通信取得了巨大的成功,但使用光子进行计算仍具有挑战性,尤其是在与最先进的电子处理器相当的规模和性能水平上。

这种困难来自于缺乏合适的并行计算机制、材料来允许人工神经元进行高速非线性(复杂)响应,以及将可扩展光子器件集成到计算硬件中。

幸运的是,过去几年中称为光学频率梳设备的发展为集成光子处理器带来了新的机遇。

光学频率梳是一组具有发射光谱的光源,由成千上万条频率均匀且紧密间隔的清晰光谱线组成。这些设备在光谱学、光学时钟计量学和电信等各个领域都取得巨大的成功,并获得了2005年诺贝尔物理学奖。

光学频率梳可被集成到计算机芯片,并作为用于光子计算的高功率效率的能源。该系统非常适合于通过波长复用进行数据并行处理。

二、单个光子处理器内核算力超10 TOPS

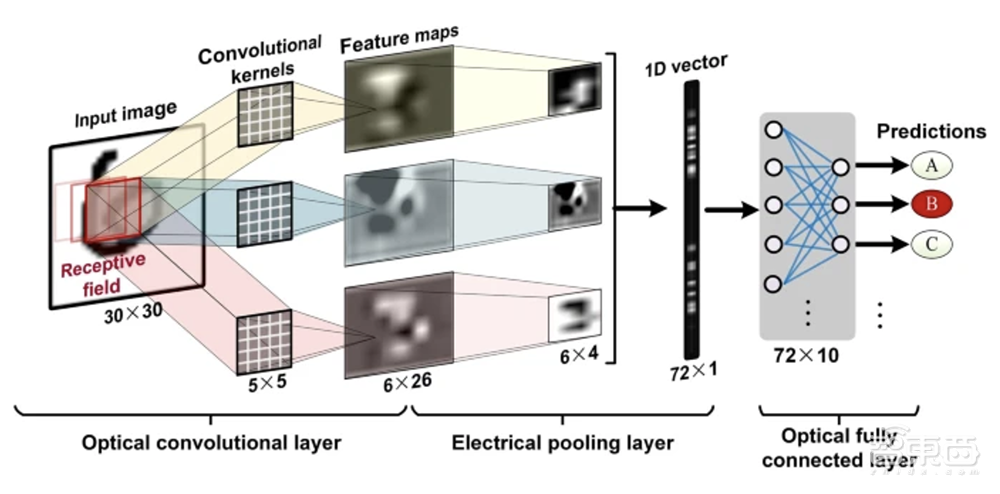

在论文《用于光学神经网络的11 TOPS光子卷积加速器》中,Xu及其同事使用这样的设置来生产通用集成光子处理器。该设备执行一种矩阵-向量乘法,用于图像处理应用的矩阵卷积。

作者采用了一种巧妙的方法来进行卷积。他们首先使用色散(传输光的速度取决于其波长)来为波长复用的光信号产生不同的时间延迟。然后,他们沿着与光的波长相关的维度组合这些信号。

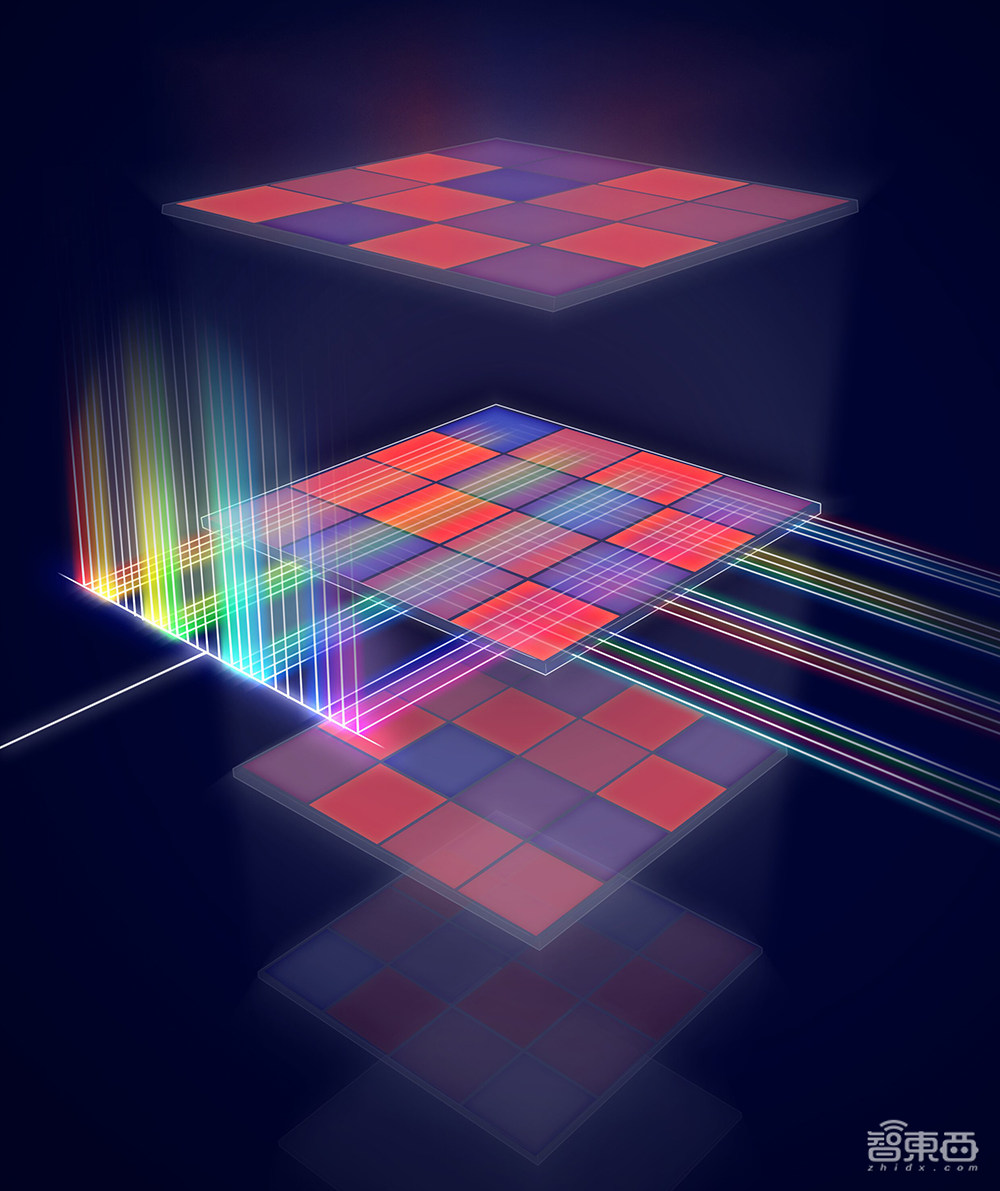

▲光学CNN结构

▲光学CNN结构

通过充分利用大范围的光子波长,Xu等人实现了针对不同卷积运算的并行计算。使用单个处理内核,光子计算速度超过10 TOPS,能在超过14千兆赫的带宽下工作,且仅受数据吞吐量的限制。

这项工作另一个受欢迎的特点是,作者在实际应用中确定了其光子卷积处理器的入口点。特别是,他们建议处理器可以用于混合光电子框架,例如在光纤通信中进行原位计算。

三、将相变材料存储单元与光学频率梳结合

在论文《利用积分光子张量核的并行卷积处理》中,Feldmann和他的同事独立地制造了一个集成光子处理器,通过使用集成张量核心可进行并行卷积处理。

该设备在基于相变材料(可以在非晶相和结晶相之间切换的材料)的存内计算架构中使用光学频率梳。作者通过波长复用对输入数据进行充分的并行处理,并利用相变材料集成单元阵列进行了类似的矩阵-向量乘法运算。

这种高度并行化的框架可以在单个步骤中高速处理整个图像。此外,原则上,在不久的将来,该系统可以使用商业制造程序进行大规模扩展,并将有助于现场机器学习。

▲用于在光照下运行矩阵乘法的处理器示意图(图源:牛津大学)

▲用于在光照下运行矩阵乘法的处理器示意图(图源:牛津大学)

由于卷积过程涉及无源传输,理论上光子处理核心的计算能以光速和低功耗执行。这种方法具有可扩展性和可训练性,对于能源密集型应用非常有价值,如云计算、自动驾驶汽车、实时视频识别等要求较高的应用。

该研究主要作者之一明斯特大学研究生Johannes Feldmann说:“利用光进行信号传输,使处理器能够通过波长多路复用执行并行数据处理,这带来更高的计算密度,并且仅需一个时间步长,就能进行许多矩阵乘法。相比通常在低GHz工作的传统电子设备,光调制速度可以达到50至100GHz范围。”

结语:光子芯片或成未来计算架构可行路径

这些研究结果表明,集成光子技术在需要大量数据的人工智能应用(如自动驾驶、实时视频处理和下一代云计算服务)中具有并行、快速和高效计算硬件的潜力。

鉴于传统电子计算方法面临的挑战,集成光子技术的出现令人兴奋,它正成为实现未来计算架构前所未有性能的一个潜在接班人。

不过,构建实用的光学计算机需要材料科学、光子学、电子学等领域的研究人员之间的广泛跨学科努力和合作。

尽管报道的光子处理器具有较高的单位面积计算能力和潜在的可伸缩性,但是全光学计算规模(光学人工神经元的数量)仍然很小。另外,因为存在固有地吸收光的计算元件,且电信号和光信号经常需要转换,能量效率会受到限制。

另一个研究途径是发展先进的非线性集成光子计算体系结构,而非一维或二维的线性卷积。通过将电子电路和数千或数百万个光子处理器集成到合适的体系结构中,同时利用光子和电子处理器的混合光电框架可能在不久的将来,带给AI硬件革命性的变化。这些硬件将在通信、数据中心操作和云计算等领域具有重要的应用。

如想了解更多光子AI芯片发展脉络及产业现状,可阅读《一篇论文引发的光子AI芯片革命!这次真想要了摩尔定律的命》一文。

来源:Nature、TechXplore